Wie wir wissen, fehlen LLMs wie Gemini unternehmensspezifische Informationen. Aber diese neuesten Informationen sind über PDFs, Textdateien usw. verfügbar. Wenn wir nun unser LLM mit diesen Quellen verbinden können, können wir eine viel bessere Anwendung erstellen.

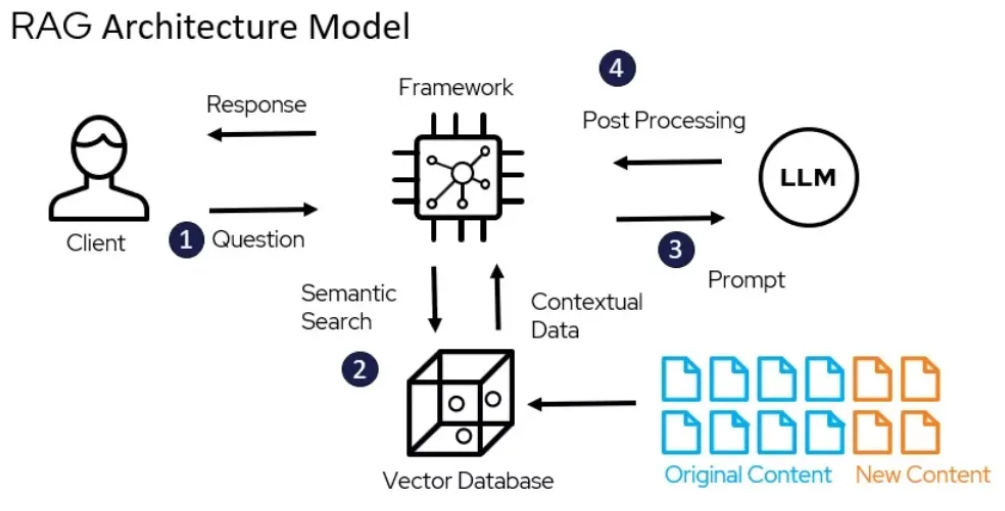

Mithilfe des LangChain-Frameworks habe ich ein Retrieval Augmented Generation (RAG)-System erstellt, das die Leistungsfähigkeit von LLM wie Gemini 1.5 Pro nutzen kann, um Fragen zum „Leave No Context Behind“-Papier zu beantworten, das am 10. April 2024 von Google veröffentlicht wurde. In diesem Prozess extern Daten (z. B. das „Leave No Context Behind“-Papier) werden abgerufen und dann während des Generierungsschritts an das LLM übergeben.

Das Papier finden Sie hier.

Die vollständige Code-Implementierung finden Sie hier.