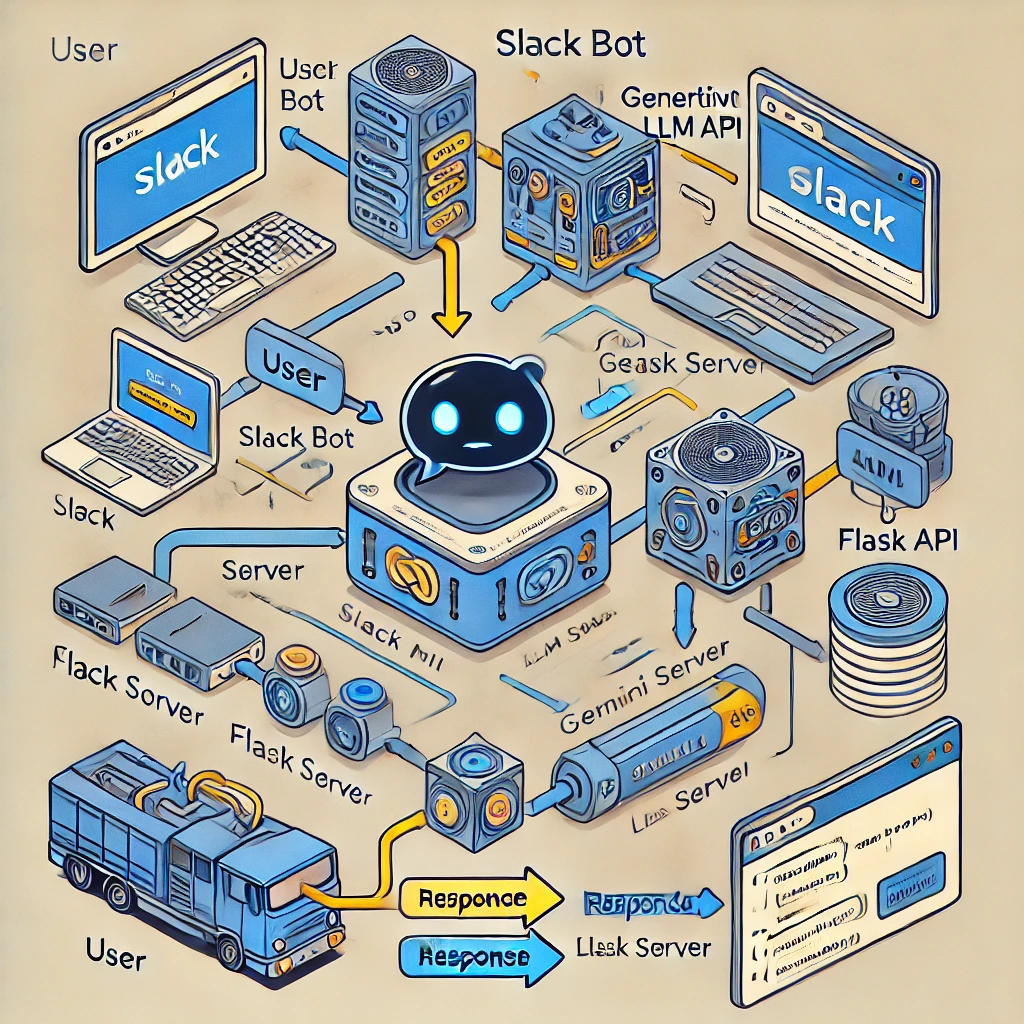

Dieses Projekt zeigt, wie man einen Slack-Bot mit einem auf dem Large Language Model (LLM) basierenden Chatbot unter Verwendung des Gemini-Modells von Google integriert. Die Integration ermöglicht eine intelligente und kontextbezogene Kommunikation direkt innerhalb von Slack.

Der Slack-Bot wird mit Python und Flask erstellt und ist in einen LLM-basierten Chatbot integriert, der das Gemini-Modell nutzt. Dieses Setup ermöglicht es dem Bot, Benutzereingaben in Slack-Kanälen zu verarbeiten und basierend auf den neuesten Data-Engineering-Informationen intelligent zu reagieren.

Verwendete Bibliotheken: slack_sdk, slack_bolt Funktionalität: Der Bot wartet auf app_mention-Ereignisse, die ausgelöst werden, wenn jemand den Bot in einem Slack-Kanal erwähnt. Konfiguration: Tokens und Geheimnisse werden mithilfe von Umgebungsvariablen sicher aus einer .env-Datei geladen

Flask App: The Flask app handles incoming HTTP requests from Slack.

Event Processing: Slack events are processed through Flask using SlackRequestHandler from the slack_bolt.adapter.flask module.

Gemini Model: The Gemini model, provided by Google's Generative AI platform, processes and responds to queries.

Python Package: The google.generativeai package is used to interact with the Gemini model, allowing for prompt-based queries.

Configuration: Tokens are securely loaded from a .env file using environment variables for geminiai api.

ngrok-Nutzung: ngrok stellt eine öffentliche URL bereit, die Anfragen an die lokale Flask-Anwendung weiterleitet und es Slack ermöglicht, mit dem Bot zu kommunizieren. Setup-Befehl: ngrok http 6060 wird verwendet, um die Flask-App dem Internet zugänglich zu machen.

Durch die Integration entsteht ein Slack-Bot, der in der Lage ist, erweiterte Datenanalysen durchzuführen und intelligent auf Benutzeranfragen in Slack zu reagieren.