Homemade GPT

1.0.0

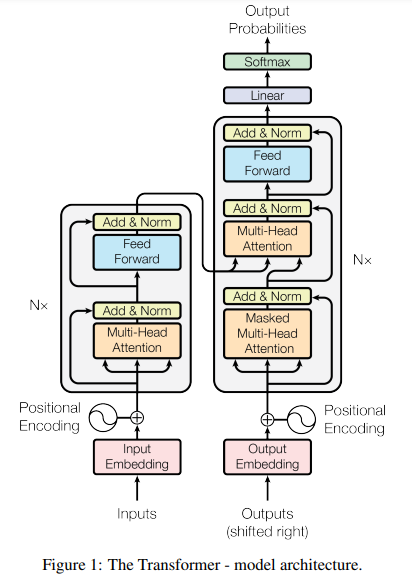

Dieses Repository enthält eine Python-Implementierung des Decoder-Teils der Transformer-Architektur, die im wegweisenden Artikel „Attention is all you need“ vorgestellt wurde. Abbildung 1 zeigt die vollständige Transformer-Architektur mit dem Encoder-Block links und dem Decoder-Block rechts.

Das Modell wird mithilfe des Alpaca-Eingabeaufforderungsstils auf den Alpaca-Anweisungsdatensatz abgestimmt.