Bewerteter Ranking-Bewerter

Der Rated Ranking Evaluator (RRE) ist ein Tool zur Bewertung der Suchqualität, das, wie der Name schon sagt, die Qualität der Ergebnisse einer Suchinfrastruktur bewertet.

Links

- Bewertung der Suchqualität: eine Entwicklerperspektive

- RRE im Haystack EU, London, 2018

- RRE auf der Fosdem 2019

- Rated Ranking Evaluator (RRE) Praktische Relevanztests @Chorus, 2021

- Rated Ranking Evaluator Enterprise: die nächste Generation kostenloser Tools zur Bewertung der Suchqualität, Padua, 2021

- Das Projekt-Wiki finden Sie unter https://github.com/SeasLtd/rated-ranking-evaluator/wiki

- RRE-User-Mailingliste: https://groups.google.com/g/rre-user

Derzeit werden Apache Solr und Elasticsearch unterstützt (siehe Dokumentation für unterstützte Versionen).

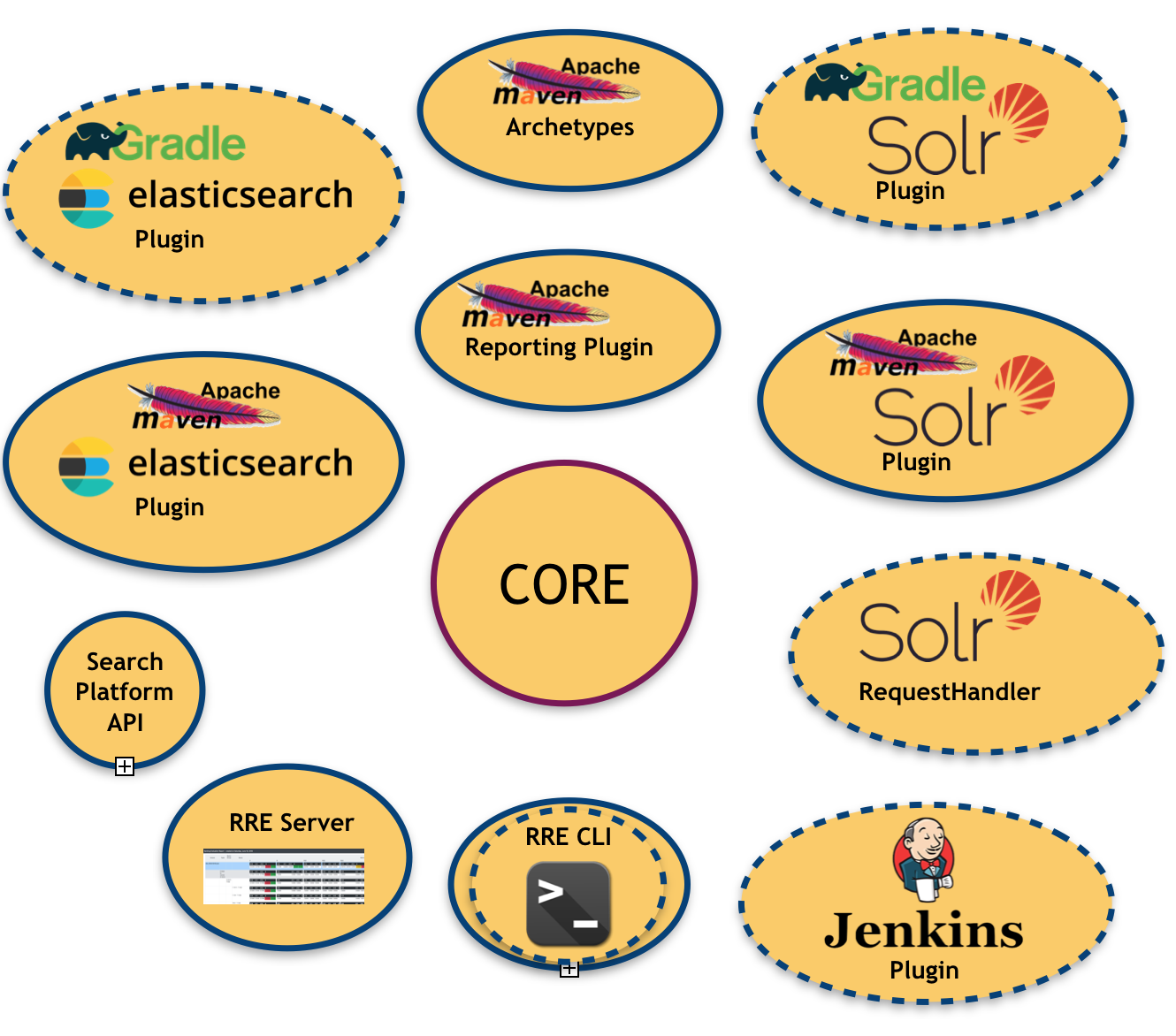

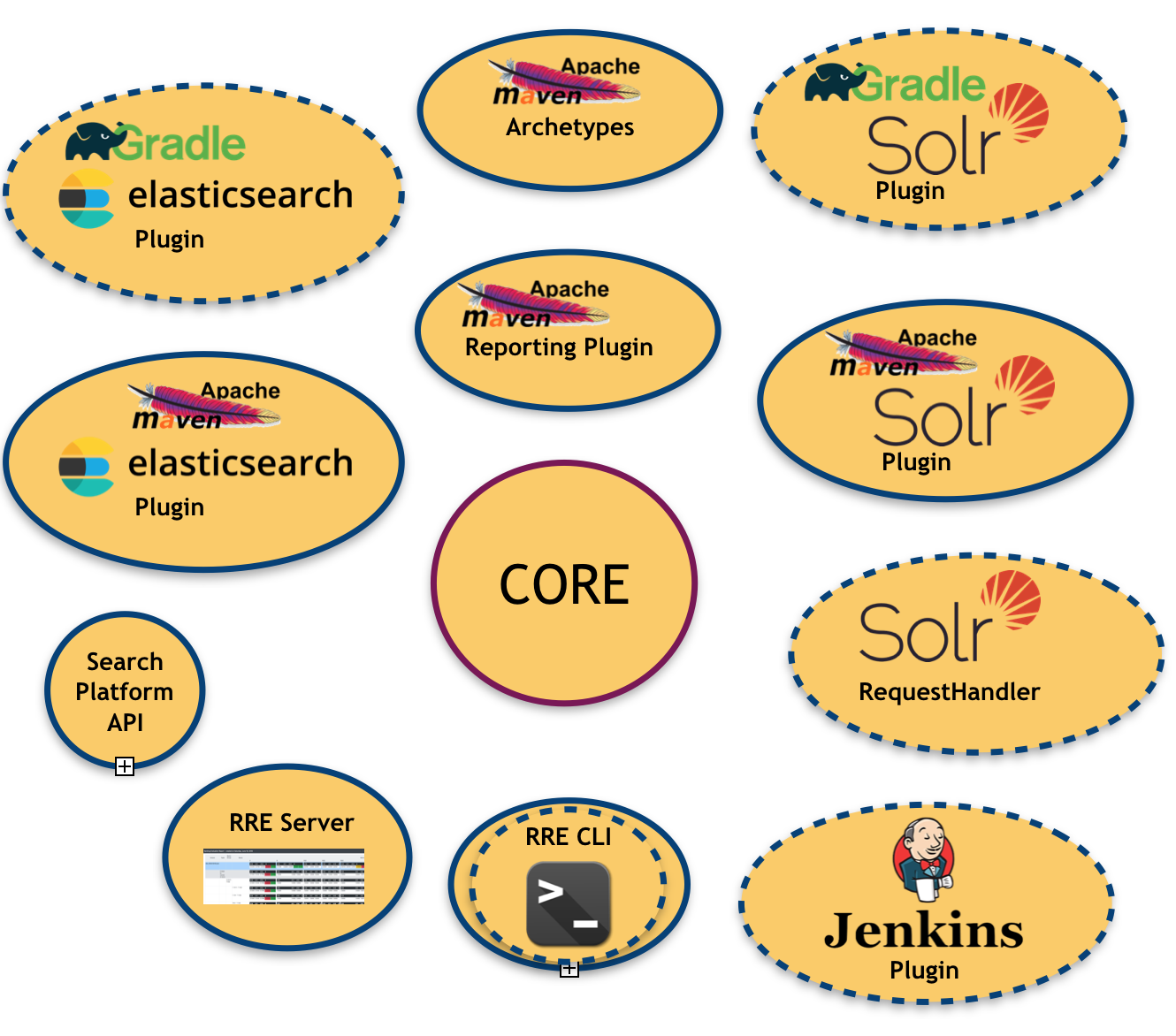

Das folgende Bild veranschaulicht das RRE-Ökosystem:

Wie Sie sehen können, sind viele Module bereits vorhanden und geplant (die mit der gestrichelten Umrandung).

- ein Kern , das ist die Zentralbibliothek, die für die Erstellung der Auswertungsergebnisse verantwortlich ist

- eine Suchplattform-API : zum Abstrahieren (und Binden) der zugrunde liegenden Suchplattform

- eine Reihe von Bindungen für die Suchplattform : Wie oben erwähnt, stehen uns derzeit zwei Bindungen zur Verfügung (Apache Solr und Elasticsearch).

- ein Apache Maven-Plugin für jede verfügbare Suchplattformbindung: Dies ermöglicht die Injektion von RRE in ein Maven-basiertes Build-System

- ein Apache Maven-Berichts-Plugin : zum Erstellen von Bewertungsberichten in einem für Menschen lesbaren Format (z. B. PDF, Excel), nützlich für die Zielgruppe technisch nicht versierte Benutzer

- ein RRE-Server : ein einfaches webbasiertes Bedienfeld, in dem die Bewertungsergebnisse nach jedem Build-Zyklus in Echtzeit aktualisiert werden.

Das gesamte System wurde als Framework aufgebaut, in dem Metriken konfiguriert/aktiviert und sogar eingebunden werden können (diese Option erfordert natürlich etwas Entwicklung). Die Metriken, die Teil der aktuellen RRE-Version sind, sind:

- Präzision : der Anteil der abgerufenen Dokumente, die relevant sind.

- Rückruf : der Anteil der relevanten Dokumente, die abgerufen werden.

- Präzision bei 1 : Diese Metrik gibt an, ob das erste Top-Ergebnis in der Liste relevant ist oder nicht.

- Präzision bei 2 : wie oben, es werden jedoch die ersten beiden Ergebnisse berücksichtigt.

- Präzision bei 3 : wie oben, jedoch werden die ersten drei Ergebnisse berücksichtigt.

- Präzision bei 10 : Diese Metrik misst die Anzahl relevanter Ergebnisse in den Top-10-Suchergebnissen.

- Reziproker Rang : Dies ist die multiplikative Umkehrung des Rangs der ersten „richtigen“ Antwort: 1 für den ersten Platz, 1/2 für den zweiten Platz, 1/3 für den dritten Platz und so weiter.

- Erwarteter reziproker Rang (ERR) Eine Erweiterung des reziproken Rangs mit abgestufter Relevanz. Sie misst die erwartete reziproke Zeitspanne, die der Benutzer benötigt, um ein relevantes Dokument zu finden.

- Durchschnittliche Präzision : die Fläche unter der Präzisions-Erinnerungskurve.

- NDCG bei 10 : Normalisierter diskontierter kumulativer Gewinn bei 10; siehe: https://en.wikipedia.org/w/index.php?title=Discounted_cumulative_gain§ion=4#Normalized_DCG

- F-Maß : Es misst die Effektivität des Abrufs in Bezug auf einen Benutzer, der dem Abruf β-mal so viel Bedeutung beimisst wie der Präzision. RRE bietet die drei beliebtesten F-Measure-Instanzen: F0.5, F1 und F2

Zusätzlich zu diesen „Blatt“-Metriken, die auf Abfrageebene berechnet werden, bietet RRE ein umfangreiches verschachteltes Datenmodell, bei dem dieselbe Metrik auf mehreren Ebenen aggregiert werden kann. Beispielsweise werden Abfragen in Abfragegruppen und Abfragegruppen in Themen gruppiert. Das bedeutet, dass dieselben oben aufgeführten Metriken auch auf höheren Ebenen verfügbar sind, wenn das arithmetische Mittel als Aggregationskriterium verwendet wird. Infolgedessen stellt RRE auch die folgenden Kennzahlen bereit:

- Mittlere durchschnittliche Genauigkeit : der Mittelwert der auf Abfrageebene berechneten durchschnittlichen Genauigkeiten.

- Mittlerer reziproker Rang : der Durchschnitt der auf Abfrageebene berechneten reziproken Ränge.

- alle anderen oben aufgeführten Metriken aggregiert nach ihrem arithmetischen Mittel.

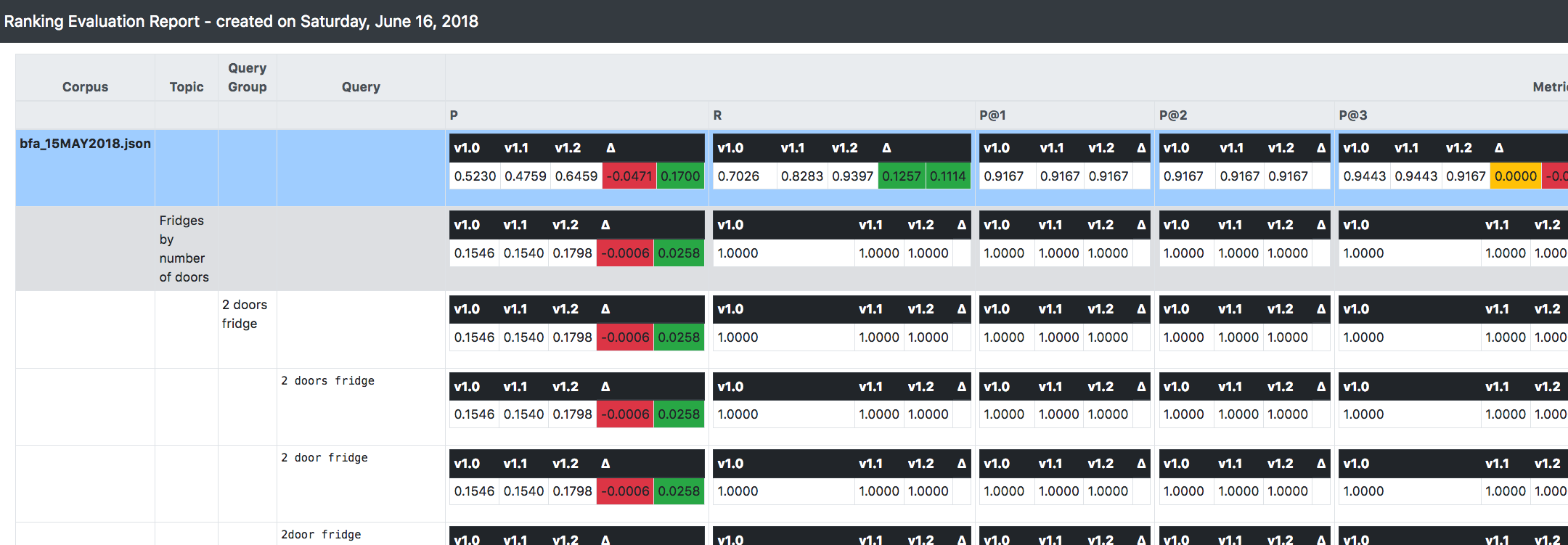

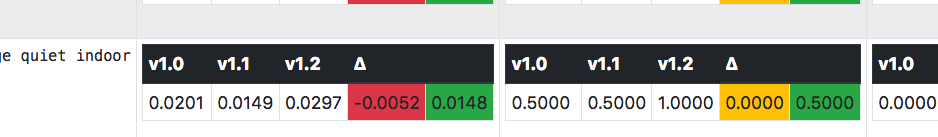

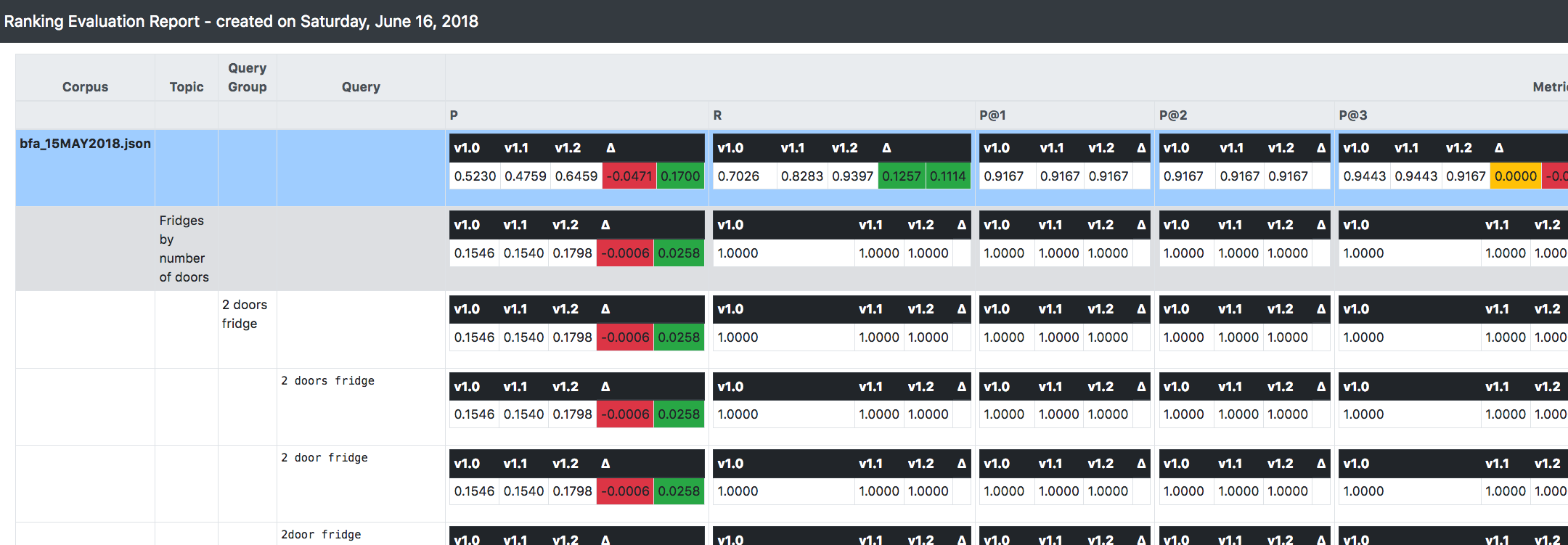

Eines der wichtigsten Dinge, die Sie im obigen Screenshot sehen können, ist, dass RRE in der Lage ist, den Überblick über mehrere Versionen des zu evaluierenden Systems zu behalten (und Vergleiche anzustellen).

Es fördert einen inkrementellen/iterativen/unveränderlichen Ansatz bei der Entwicklung und Weiterentwicklung eines Suchsystems: Angenommen, Sie beginnen mit Version 1.0 und nehmen eine relevante Änderung an Ihrer Konfiguration vor, anstatt diese Version zu ändern, ist es besser, sie zu klonen und anzuwenden Änderungen an der neuen Version (nennen wir sie 1.1).

Auf diese Weise berechnet RRE beim Systemaufbau alles, was oben erklärt wurde (d. h. die Metriken), für jede verfügbare Version.

Darüber hinaus wird das Delta/der Trend zwischen nachfolgenden Versionen angezeigt, sodass Sie sofort die allgemeine Richtung erkennen können, in die sich das System im Hinblick auf Relevanzverbesserungen bewegt.