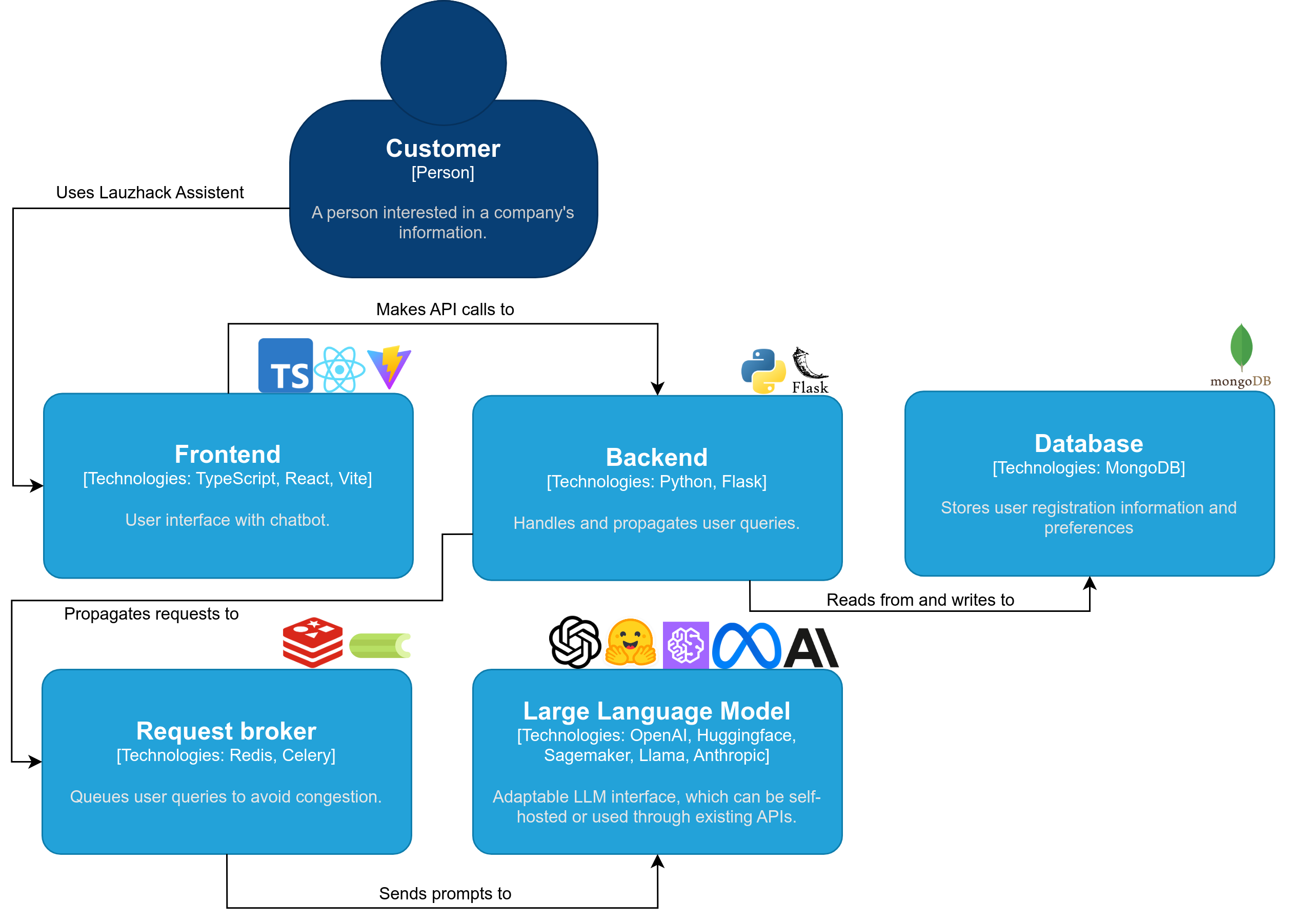

lauzcom assistant ist eine interaktive und benutzerfreundliche Lösung für den nahtlosen Zugriff auf wichtige Swisscom-Daten. Durch die Integration leistungsstarker GPT- Modelle können Kunden ganz einfach Fragen zu öffentlichen Swisscom-Daten stellen und erhalten schnell präzise Antworten.

Verabschieden Sie sich von zeitraubenden manuellen Suchen und lassen Sie lauzcom assistant Ihre Kundeninteraktionen revolutionieren.

Das lauzcom assistant -Projekt wird erstellt von:

Demovideo

Notiz

Stellen Sie sicher, dass Docker installiert ist

Führen Sie unter macOS oder Linux Folgendes aus:

./setup.shEs installiert alle Abhängigkeiten und ermöglicht Ihnen, ein Modell lokal herunterzuladen oder OpenAI zu verwenden. LauzHack Assistant läuft jetzt unter http://localhost:5173.

Andernfalls befolgen Sie diese Schritte:

Laden Sie dieses Repository herunter und öffnen Sie es mit git clone [email protected]:cern-lauzhack-2023/Lauzcom-Assistant.git .

Erstellen Sie eine .env Datei in Ihrem Stammverzeichnis und setzen Sie die env-Variable API_KEY mit Ihrem OpenAI-API-Schlüssel und VITE_API_STREAMING auf true oder false, je nachdem, ob Sie Streaming-Antworten wünschen oder nicht.

API_KEY= < YourOpenAIKey >

VITE_API_STREAMING=trueSiehe optionale Umgebungsvariablen in den Dateien /.env-template und /application/.env_sample.

Führen Sie ./run-with-docker-compose.sh aus.

LauzHack Assistant läuft jetzt unter http://localhost:5173.

Zum Anhalten drücken Sie Ctrl + C

Für die Entwicklung werden nur zwei Container aus docker-compose.yaml verwendet (durch Löschung aller Dienste außer Redis und Mongo). Siehe Datei docker-compose-dev.yaml.

Laufen:

docker compose -f docker-compose-dev.yaml build

docker compose -f docker-compose-dev.yaml up -dNotiz

Stellen Sie sicher, dass Python 3.10 oder 3.11 installiert ist.

.env Datei im Ordner /application vor..env mit Ihrem OpenAI-API-Token für die Felder API_KEY und EMBEDDINGS_KEY . (Schauen Sie sich application/core/settings.py an, wenn Sie weitere Konfigurationsoptionen sehen möchten.)

(optional) Erstellen Sie eine virtuelle Python-Umgebung: Befolgen Sie die offizielle Python-Dokumentation für virtuelle Umgebungen.

a) Unter Linux und macOS:

python -m venv venv

. venv/bin/activateb) Unter Windows:

python -m venv venv

venv/Scripts/activateAbhängigkeiten für das Backend installieren:

pip install -r application/requirements.txtflask --app application/app.py run --host=0.0.0.0 --port=7091Die Backend-API läuft jetzt unter http://localhost:7091.

celery -A application.app.celery worker -l INFONotiz

Stellen Sie sicher, dass Sie über die Node-Version 16 oder höher verfügen.

husky und vite (ignorieren, falls bereits installiert). npm install husky -g

npm install vite -gnpm install --include=devnpm run devDas Frontend läuft jetzt unter http://localhost:5173.

Die Quellcodelizenz ist MIT, wie in der LICENSE-Datei beschrieben.

Gebaut mit ? ? LangChain