tokviz /

├── assets/

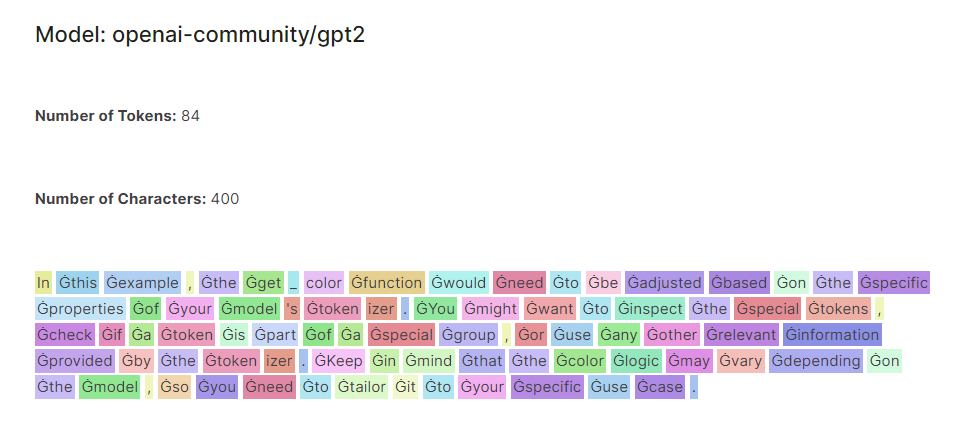

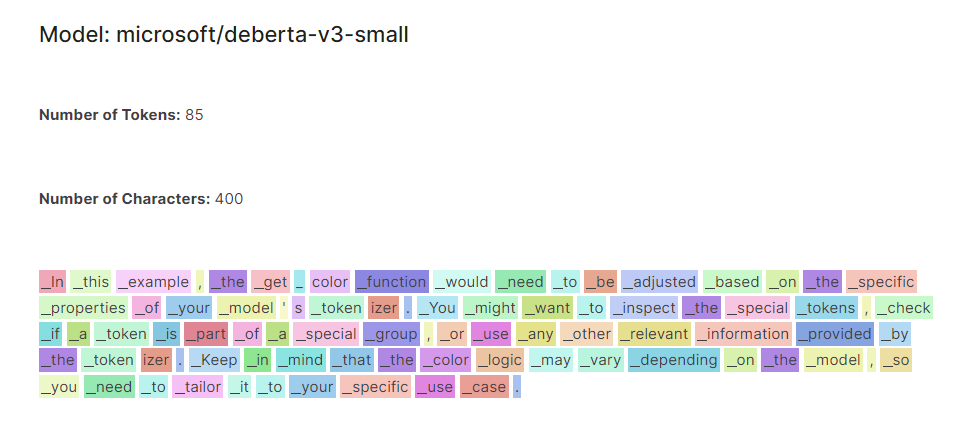

│ ├── example-deberta-v3-small.png

│ └── example-gpt2.png

├── tokviz /

│ ├── __init__.py

│ └── visualization.py

├── README.md

├── LICENSE

├── setup.py

└── pyproject.toml

tokviz ist eine Python-Bibliothek zur Visualisierung von Tokenisierungsmustern in verschiedenen Sprachmodellen. Diese Bibliothek bietet Forschern, Datenwissenschaftlern und NLP-Enthusiasten eine umfassende Plattform, um Einblicke in die Verarbeitung und Tokenisierung von Text durch verschiedene Sprachmodelle zu gewinnen.

Modellvergleich: Mit dem Visualizer können Benutzer Tokenisierungsmuster in mehreren Sprachmodellen vergleichen, einschließlich beliebter Modelle wie GPT-2, DistilGPT-2 und DeBERTa-v3-small. Durch die Anzeige farbcodierter Token nebeneinander können Benutzer Unterschiede und Ähnlichkeiten im Tokenisierungsverhalten leicht erkennen.

Flexible Eingabe: Benutzer können einen beliebigen Text ihrer Wahl eingeben, was eine dynamische Erkundung von Tokenisierungsmustern über verschiedene Texteingaben hinweg ermöglicht. Unabhängig davon, ob kurze Sätze, Absätze oder ganze Dokumente analysiert werden, passt sich der Visualizer für eine umfassende Analyse an die Eingaben des Benutzers an.

Farbcodierte Visualisierung: Token sind basierend auf ihren Eigenschaften und ihrem Index farbcodiert und bieten so eine visuell intuitive Darstellung von Tokenisierungsmustern. Dies ermöglicht es Benutzern, einzelne Token und Muster im Text schnell zu identifizieren, was eine tiefergehende Analyse und Interpretation erleichtert.

Sie können tokviz über pip installieren:

pip install tokviz from tokviz import token_visualizer

# Define input text

text = "In this example, the get_color function would need to be adjusted based on the specific properties of your model's tokenizer.

You might want to inspect the special tokens, check if a token is part of a special group,

or use any other relevant information provided by the tokenizer.

Keep in mind that the color logic may vary depending on the model,

so you need to tailor it to your specific use case."

# Compare tokenization across different language models

token_visualizer ( text , models = [ 'microsoft/deberta-v3-small' , 'openai-community/gpt2' ])Dadurch werden Tokenisierungsmuster für den Eingabetext mithilfe der angegebenen Sprachmodelle visualisiert. Sie können eine Liste von Modellnamen oder Bezeichnern an den Models-Parameter übergeben. Standardmäßig wird die Tokenisierung mit dem GPT-2-Modell verglichen.

Diese Bibliothek basiert auf dem Notebook LLM Tokenizer Visualizer