Fantastische Audit-Algorithmen

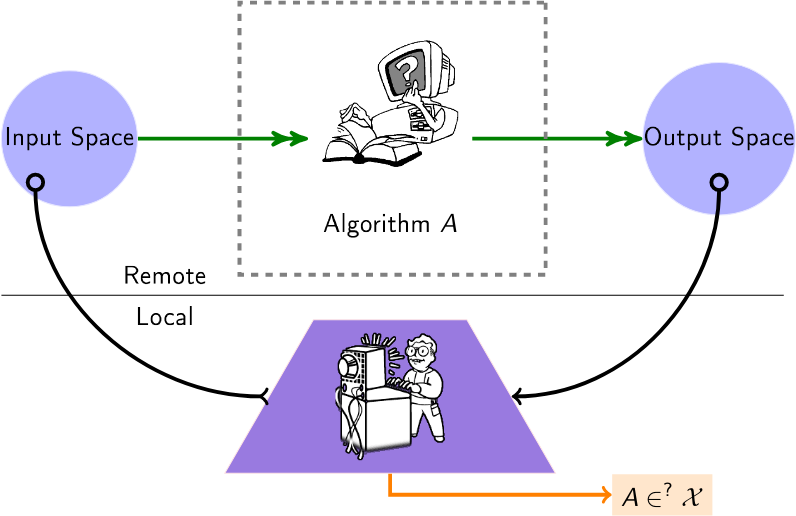

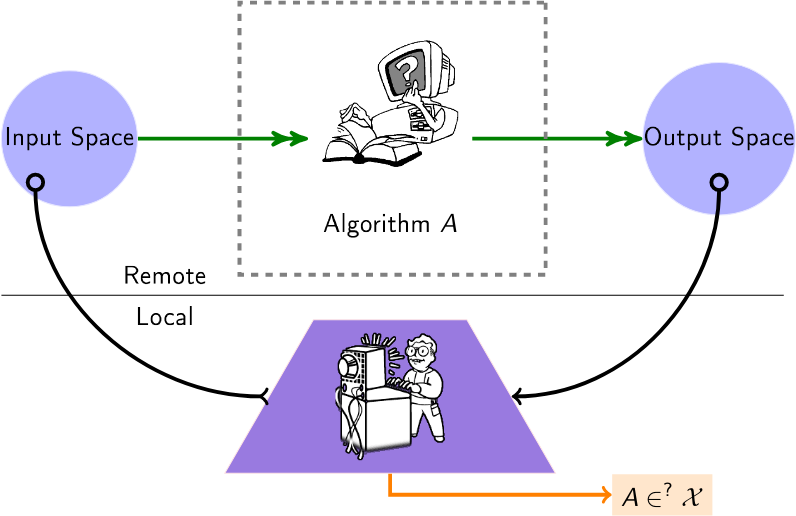

Eine kuratierte Liste von Algorithmen zur Prüfung von Black-Box-Algorithmen. Heutzutage werden viele Algorithmen (Empfehlung, Bewertung, Klassifizierung) bei Drittanbietern betrieben, ohne dass Benutzer oder Institutionen Einblick in die Art und Weise haben, wie sie mit ihren Daten umgehen. Die Prüfalgorithmen in dieser Liste gelten daher für dieses Setup, das als „Black-Box“-Setup bezeichnet wird und bei dem ein Prüfer einen Einblick in diese Remote-Algorithmen erhalten möchte.

Ein Benutzer fragt einen Remote-Algorithmus ab (z. B. über verfügbare APIs), um Informationen über diesen Algorithmus abzuleiten.

Inhalt

- Papiere

- Verwandte Veranstaltungen (Konferenzen/Workshops)

Papiere

2024

- Die Prüfung lokaler Erklärungen ist schwierig – (NeurIPS) Gibt die (unerschwingliche) Abfragekomplexität der Prüfung von Erklärungen an.

- LLMs halluzinieren auch Graphen: eine strukturelle Perspektive – (komplexe Netzwerke) Fragt LLMs nach bekannten Graphen ab und untersucht topologische Halluzinationen. Schlägt einen strukturellen Halluzinationsrang vor.

- Fairness Auditing with Multi-Agent Collaboration – (ECAI) Berücksichtigt die Zusammenarbeit mehrerer Agenten, wobei jeder dieselbe Plattform für unterschiedliche Aufgaben prüft.

- Kartierung des Bereichs der Algorithmenprüfung: Eine systematische Literaturrecherche zur Identifizierung von Forschungstrends, sprachlichen und geografischen Disparitäten – (Arxiv) Systematische Überprüfung von Studien zur Algorithmenprüfung und Identifizierung von Trends in ihren methodischen Ansätzen.

- FairProof: Vertrauliche und zertifizierbare Fairness für neuronale Netze – (Arxiv) schlägt ein alternatives Paradigma zur traditionellen Prüfung unter Verwendung kryptografischer Tools wie Zero-Knowledge Proofs vor; bietet ein System namens FairProof zur Überprüfung der Fairness kleiner neuronaler Netze.

- Sind einige KI-Modelle bei Manipulation schwieriger zu prüfen? - (SATML) Setzt die Schwierigkeit von Black-Box-Audits mit der Kapazität der Zielmodelle in Beziehung, wobei die Rademacher-Komplexität verwendet wird.

- Verbesserte Mitgliedschaftsinferenzangriffe gegen Sprachklassifizierungsmodelle – (ICLR) Stellt ein Framework für die Ausführung von Mitgliedschaftsinferenzangriffen gegen Klassifikatoren im Prüfmodus vor.

- Auditing Fairness by Betting – (Neurips) [Code] Sequentielle Methoden, die die kontinuierliche Überwachung eingehender Daten von einem Black-Box-Klassifikator oder Regressor ermöglichen.

2023

- Datenschutzprüfung mit einem (1) Trainingslauf – (NeurIPS – beste Arbeit) Ein Schema zur Prüfung differenziell privater maschineller Lernsysteme mit einem einzigen Trainingslauf.

- Prüfung der Fairness bei Unwissenheit durch kontrafaktisches Denken – (Informationsverarbeitung und -management) Zeigt, wie man aufdeckt, ob ein Black-Box-Modell, das den Vorschriften entspricht, immer noch voreingenommen ist oder nicht.

- XAudit: Ein theoretischer Blick auf die Prüfung mit Erläuterungen – (Arxiv) Formalisiert die Rolle von Erklärungen bei der Prüfung und untersucht, ob und wie Modellerklärungen bei Prüfungen hilfreich sein können.

- Mit den Sprachmodellen Schritt halten: Robustheits-Bias-Zusammenspiel in NLI-Daten und -Modellen – (Arxiv) schlägt eine Möglichkeit vor, die Haltbarkeit von Prüfdatensätzen durch die Verwendung von Sprachmodellen selbst zu verlängern; stellt außerdem Probleme mit den aktuellen Bias-Prüfungsmetriken fest und schlägt Alternativen vor – diese Alternativen verdeutlichen, dass die Sprödigkeit des Modells oberflächlich betrachtet die vorherigen Bias-Scores erhöht hat.

- Online-Fairness-Auditing durch iterative Verfeinerung – (KDD) Bietet einen adaptiven Prozess, der die Schlussfolgerung probabilistischer Garantien im Zusammenhang mit der Schätzung von Fairness-Metriken automatisiert.

- Stehlen der Dekodierungsalgorithmen von Sprachmodellen – (CCS) Stehlen Sie den Typ und die Hyperparameter der Dekodierungsalgorithmen eines LLM.

- Modellierung von Kaninchenlöchern auf YouTube – (SNAM) Modelliert die Einfangdynamik von Benutzern in Kaninchenlöchern auf YouTube und liefert ein Maß für dieses Gehäuse.

- Prüfung des Empfehlungsalgorithmus von YouTube auf Fehlinformationsfilterblasen – (Transaktionen auf Empfehlungssystemen) Was nötig ist, um „die Blase zum Platzen zu bringen“, dh die Blasenhülle von Empfehlungen rückgängig zu machen.

- Prüfung des Geschäftsrankings und der Bewertungsempfehlungen von Yelp durch die Linse der Fairness – (Arxiv) Prüft die Fairness des Unternehmensrankings und der Bewertungsempfehlungssysteme von Yelp mit demografischer Parität, Sichtbarkeit und statistischen Tests wie quantillinearer und logistischer Regression.

- Confidential-PROFITT: Confidential PROof of Fair Training of Trees – (ICLR) Schlägt Lernalgorithmen für faire Entscheidungsbäume zusammen mit Zero-Knowledge-Proof-Protokollen vor, um einen Fairness-Nachweis auf dem geprüften Server zu erhalten.

- SCALE-UP: Eine effiziente Black-Box-Hintertürerkennung auf Eingabeebene durch Analyse der Konsistenz skalierter Vorhersagen – (ICLR) Berücksichtigt die Hintertürerkennung unter der Black-Box-Einstellung in Machine Learning as a Service (MLaaS)-Anwendungen.

2022

- Two-Face: Adversarial Audit of Commercial Face Recognition Systems – (ICWSM) Führt ein kontradiktorisches Audit an mehreren System-APIs und Datensätzen durch und macht dabei eine Reihe besorgniserregender Beobachtungen.

- Suchmaschinen-Audits ausweiten: Praktische Erkenntnisse für die Algorithmenprüfung – (Journal of Information Science) (Code) Überprüft mehrere Suchmaschinen mithilfe von simuliertem Surfverhalten mit virtuellen Agenten.

- Eine Prise Kalk: Auf dem Weg zu architekturunabhängigen Modellabständen – (ICLR) Misst den Abstand zwischen zwei entfernten Modellen mithilfe von LIME.

- Active Fairness Auditing – (ICML) Studien zu abfragebasierten Prüfalgorithmen, die die demografische Parität von ML-Modellen auf abfrageeffiziente Weise schätzen können.

- Schauen Sie sich die Varianz an! Effiziente Black-Box-Erklärungen mit Sobol-basierter Sensitivitätsanalyse – (NeurIPS) Sobol-Indizes bieten eine effiziente Möglichkeit, Wechselwirkungen höherer Ordnung zwischen Bildregionen und deren Beiträge zur Vorhersage eines (Black-Box-)Neuronalen Netzwerks durch die Linse der Varianz zu erfassen.

- Ihre Echos werden gehört: Tracking, Profiling und Anzeigenausrichtung im Amazon Smart Speaker-Ökosystem – (arxiv) Lässt eine Verbindung zwischen dem Amazon Echo-System und dem Anzeigenausrichtungsalgorithmus schließen.

2021

- Wenn der Schiedsrichter auch ein Mitspieler ist: Verzerrung bei Handelsmarken-Produktempfehlungen auf E-Commerce-Marktplätzen – (FAccT) Erhalten Amazon-Handelsmarkenprodukte einen unfairen Anteil an Empfehlungen und sind daher gegenüber Produkten von Drittanbietern im Vorteil?

- Alltagsalgorithmus-Auditing: Die Macht alltäglicher Benutzer bei der Aufdeckung schädlicher algorithmischer Verhaltensweisen verstehen – (CHI) plädiert für „alltägliches algorithmisches Auditing“ durch Benutzer.

- Prüfung von Black-Box-Vorhersagemodellen auf Einhaltung der Datenminimierung – (NeurIPS) Misst den Grad der Datenminimierung, der vom Vorhersagemodell unter Verwendung einer begrenzten Anzahl von Abfragen erfüllt wird.

- Den Rekord zum Shadow-Banning klarer stellen – (INFOCOM) (Code) Berücksichtigt die Möglichkeit des Shadow-Bannings in Twitter (dh den Moderations-Blackbox-Algorithmus) und misst die Wahrscheinlichkeit mehrerer Hypothesen.

- Extrahieren von Trainingsdaten aus großen Sprachmodellen – (USENIX-Sicherheit) Extrahieren Sie wörtliche Textsequenzen aus den Trainingsdaten des GPT-2-Modells.

- FairLens: Prüfung von Black-Box-Systemen zur klinischen Entscheidungsunterstützung – (Informationsverarbeitung und -management) Stellt eine Pipeline zur Erkennung und Erklärung potenzieller Fairnessprobleme im klinischen DSS vor, indem verschiedene Messgrößen für die Klassifizierungsdisparität mit mehreren Labels verglichen werden.

- Prüfung algorithmischer Verzerrungen auf Twitter – (WebSci).

- Ausführung des Bayes-Algorithmus: Schätzung berechenbarer Eigenschaften von Black-Box-Funktionen unter Verwendung gegenseitiger Information – (ICML) Ein budgetbeschränktes Bayes-Optimierungsverfahren zum Extrahieren von Eigenschaften aus einem Black-Box-Algorithmus.

2020

- Black-Box-Ripper: Kopieren von Black-Box-Modellen mithilfe generativer evolutionärer Algorithmen – (NeurIPS) Repliziert die Funktionalität eines neuronalen Black-Box-Modells, jedoch ohne Begrenzung der Anzahl der Abfragen (über ein Lehrer/Schüler-Schema und eine evolutionäre Suche). .

- Prüfung von Radikalisierungspfaden auf - (FAT*) Untersucht die Erreichbarkeit radikaler Kanäle voneinander, indem Random Walks auf statischen Kanalempfehlungen verwendet werden.

- Adversarial Model Extraction on Graph Neural Networks – (AAAI-Workshop zu Deep Learning on Graphs: Methodologies and Applications) stellt die GNN-Modellextraktion vor und stellt einen vorläufigen Ansatz dafür vor.

- Remote Explainability stellt sich dem Bouncer-Problem – (Nature Machine Intelligence Band 2, Seiten 529–539) (Code) Zeigt die Unmöglichkeit (mit einer Anfrage) oder die Schwierigkeit, Lügen in den Erklärungen einer Remote-KI-Entscheidung zu erkennen.

- GeoDA: ein geometrisches Framework für gegnerische Black-Box-Angriffe – (CVPR) (Code) Erstellt gegnerische Beispiele, um Modelle zu täuschen, in einem reinen Blackbox-Setup (keine Farbverläufe, nur abgeleitete Klasse).

- Das Nachahmungsspiel: Algorithmusauswahl durch Ausnutzung des Black-Box-Empfehlers – (Netys) (Code) Parametrisieren Sie einen lokalen Empfehlungsalgorithmus, indem Sie die Entscheidung eines entfernten und besser trainierten Algorithmus nachahmen.

- Prüfung von Nachrichtenkurationssystemen: Eine Fallstudie zur Untersuchung der algorithmischen und redaktionellen Logik in Apple News – (ICWSM) Prüfungsstudie von Apple News als soziotechnischem Nachrichtenkurationssystem (Abschnitt „Trendgeschichten“).

- Prüfungsalgorithmen: Über gewonnene Erkenntnisse und die Risiken der Datenminimierung – (AIES) Eine praktische Prüfung für eine von Telefónica entwickelte Empfehlungs-App zum Wohlbefinden (hauptsächlich auf Voreingenommenheit).

- Extrahieren von Trainingsdaten aus großen Sprachmodellen – (arxiv) Führt einen Trainingsdatenextraktionsangriff durch, um einzelne Trainingsbeispiele durch Abfragen des Sprachmodells wiederherzustellen.

2019

- Adversarial Frontier Stitching für Remote Neural Network Watermarking – (Neural Computing and Applications) (Alternative Implementierung) Überprüfen Sie, ob ein Remote-Machine-Learning-Modell „durchgesickert“ ist: Extrahieren Sie über Standard-API-Anfragen an ein Remote-Modell ein Null-Modell (oder nicht). Bit-Wasserzeichen, das eingefügt wurde, um wertvolle Modelle (z. B. große tiefe neuronale Netze) mit einem Wasserzeichen zu versehen.

- Knockoff-Netze: Diebstahl der Funktionalität von Black-Box-Modellen – (CVPR) Fragen Sie, inwieweit ein Gegner die Funktionalität solcher „Opfer“-Modelle stehlen kann, die ausschließlich auf Blackbox-Interaktionen basieren: Bild rein, Vorhersagen raus.

- Öffnen der Black Box: Prüfung des Google-Top-Story-Algorithmus – (Flairs-32) Prüfung des Google-Top-Story-Panels, das Einblicke in seine algorithmischen Entscheidungen zur Auswahl und Einstufung von Nachrichtenverlegern bietet

- Gezielte Black-Box-Umgehungsangriffe effektiv und effizient gestalten – (arXiv) Untersucht, wie ein Gegner sein Abfragebudget optimal für gezielte Umgehungsangriffe gegen tiefe neuronale Netze nutzen kann.

- Online-Lernen zur Messung der Anreizkompatibilität in Anzeigenauktionen – (WWW) Misst die Anreizkompatibilitätsmechanismen (IC) (Regret) von Black-Box-Auktionsplattformen.

- TamperNN: Efficient Tampering Detection of Deployed Neural Nets – (ISSRE) Algorithmen zur Erstellung von Eingaben, die Manipulationen an einem ferngesteuerten Klassifikatormodell erkennen können.

- Angriffe zur Modellextraktion neuronaler Netzwerke in Edge-Geräten durch Abhören architektonischer Hinweise – (arxiv) Durch die Erfassung von Speicherzugriffsereignissen aus Bus-Snooping, Identifizierung der Schichtsequenz durch das LSTM-CTC-Modell, Verbindung der Schichttopologie gemäß dem Speicherzugriffsmuster und Schätzung der Schichtdimension unten Datenvolumenbeschränkungen zeigen, dass man eine ähnliche Netzwerkarchitektur wie den Ausgangspunkt des Angriffs genau wiederherstellen kann

- Diebstahl von Wissen aus geschützten tiefen neuronalen Netzen mithilfe von Composite Unlabeled Data – (ICNN) Zusammengesetzte Methode, mit der ein Black-Box-Modell angegriffen und das Wissen daraus extrahiert werden kann, selbst wenn es seine Softmax-Ausgabe vollständig verbirgt.

- Neural Network Inversion in Adversarial Setting via Background Knowledge Alignment – (CCS) Modellinversionsansatz in der Adversarial Setting basierend auf dem Training eines Inversionsmodells, das als Umkehrung des ursprünglichen Modells fungiert. Auch wenn die ursprünglichen Trainingsdaten nicht vollständig bekannt sind, ist eine genaue Inversion dennoch möglich, indem das Inversionsmodell anhand von Hilfsproben trainiert wird, die aus einer allgemeineren Datenverteilung stammen.

2018

- Kontrafaktische Erklärungen, ohne die Black Box zu öffnen: Automatisierte Entscheidungen und die DSGVO – (Harvard Journal of Law & Technology) Um eine Entscheidung zu x zu erklären, suchen Sie eine kontrafaktische Erklärung: den nächstgelegenen Punkt zu x, der die Entscheidung ändert.

- Distill-and-Compare: Prüfung von Black-Box-Modellen mithilfe der transparenten Modelldestillation – (AIES) Behandelt Black-Box-Modelle als Lehrer und trainiert transparente Schülermodelle, um die von Black-Box-Modellen zugewiesenen Risikobewertungen nachzuahmen.

- Auf dem Weg zum Reverse-Engineering neuronaler Black-Box-Netzwerke – (ICLR) (Code) Leiten Sie innere Hyperparameter (z. B. Anzahl der Schichten, nichtlinearer Aktivierungstyp) eines entfernten neuronalen Netzwerkmodells ab, indem Sie dessen Antwortmuster auf bestimmte Eingaben analysieren.

- Datengesteuerte explorative Angriffe auf Black-Box-Klassifikatoren in gegnerischen Domänen – (Neurocomputing) Reverse Engineering von Remote-Klassifikatormodellen (z. B. zur Umgehung eines CAPTCHA-Tests).

- xGEMs: Generieren von Beispielen zur Erklärung von Black-Box-Modellen – (arXiv) Sucht nach Verzerrungen im Black-Box-Modell, indem ein unbeaufsichtigtes implizites generatives Modell trainiert wird. Anschließend wird das Verhalten des Black-Box-Modells quantitativ zusammengefasst, indem Datenproben entlang der Datenmannigfaltigkeit gestört werden.

- Lernen von Netzwerken aus Random-Walk-basierten Knotenähnlichkeiten – (NIPS) Umkehrdiagramme durch Beobachtung einiger Random-Walk-Pendelzeiten.

- Identifizieren der Machine-Learning-Familie anhand von Black-Box-Modellen – (CAEPIA) Bestimmt, welche Art von Machine-Learning-Modell hinter den zurückgegebenen Vorhersagen steckt.

- Diebstahl neuronaler Netze über Timing-Seitenkanäle – (arXiv) Diebstahl/Annäherung eines Modells durch Timing-Angriffe mithilfe von Abfragen.

- Copycat CNN: Diebstahl von Wissen durch Überreden von Geständnissen mit zufälligen, nicht gekennzeichneten Daten – (IJCNN) (Code) Diebstahl von Wissen über Black-Box-Modelle (CNNs) durch Abfragen mit zufälligen natürlichen Bildern (ImageNet und Microsoft-COCO).

- Prüfung der Personalisierung und Zusammensetzung politisch relevanter Suchmaschinen-Ergebnisseiten – (WWW) Eine Chrome-Erweiterung zur Befragung von Teilnehmern und zum Sammeln der Suchmaschinen-Ergebnisseiten (SERPs) und Autovervollständigungsvorschlägen zur Untersuchung der Personalisierung und Zusammensetzung.

2017

- Uncovering Influence Cookbooks: Reverse Engineering the Topological Impact in Peer Ranking Services (CSCW) Ziel ist es, herauszufinden, welche Zentralitätsmetriken in einem Peer-Ranking-Dienst verwendet werden.

- Das topologische Gesicht der Empfehlung: Modelle und Anwendung zur Bias-Erkennung – (Komplexe Netzwerke) Schlägt ein Framework zur Bias-Erkennung für Artikel vor, die Benutzern empfohlen werden.

- Mitgliedschaftsinferenzangriffe gegen Modelle für maschinelles Lernen – (Symposium zu Sicherheit und Datenschutz) Bestimmen Sie anhand eines Modells für maschinelles Lernen und eines Datensatzes, ob dieser Datensatz als Teil des Trainingsdatensatzes des Modells verwendet wurde oder nicht.

- Praktische Black-Box-Angriffe gegen maschinelles Lernen – (Asia CCS) Verstehen Sie, wie anfällig ein Remote-Dienst für gegnerische Klassifizierungsangriffe ist.

2016

- Algorithmische Transparenz durch quantitativen Eingabeeinfluss: Theorie und Experimente mit lernenden Systemen – (IEEE S&P) Bewerten Sie den individuellen, gemeinsamen und marginalen Einfluss von Merkmalen auf ein Modell mithilfe von Shapley-Werten.

- Prüfung von Black-Box-Modellen auf indirekten Einfluss – (ICDM) Bewerten Sie den Einfluss einer Variablen auf ein Black-Box-Modell, indem Sie sie „geschickt“ aus dem Datensatz entfernen und die Genauigkeitslücke betrachten

- Iterative orthogonale Feature-Projektion zur Diagnose von Bias in Black-Box-Modellen – (FATML-Workshop) Führt Feature-Ranking durch, um Black-Box-Modelle zu analysieren

- Bias in Online-Marktplätzen für Freiberufler: Beweise von TaskRabbit – (dat-Workshop) Misst den Rang des Suchalgorithmus von TaskRabbit.

- Stehlen von Modellen für maschinelles Lernen über Vorhersage-APIs – (Usenix Security) (Code) Ziel ist es, Modelle für maschinelles Lernen zu extrahieren, die von Remote-Diensten verwendet werden.

- „Warum sollte ich Ihnen vertrauen?“ Erklären der Vorhersagen jedes Klassifikators – (arXiv) (Code) Erklärt ein Blackbox-Klassifikatormodell durch Stichprobenziehung um Dateninstanzen.

- Zurück in Schwarz: Auf dem Weg zur formalen Black-Box-Analyse von Desinfektionsmitteln und Filtern – (Sicherheit und Datenschutz) Black-Box-Analyse von Desinfektionsmitteln und Filtern.

- Algorithmische Transparenz durch quantitativen Input-Einfluss: Theorie und Experimente mit lernenden Systemen – (Sicherheit und Datenschutz) Führt Maßnahmen ein, die den Grad des Einflusses von Eingaben auf die Ausgaben des beobachteten Systems erfassen.

- Eine empirische Analyse der algorithmischen Preisgestaltung auf dem Amazon Marketplace – (WWW) (Code) Entwickelt eine Methodik zur Erkennung algorithmischer Preisgestaltung und nutzt diese empirisch, um deren Verbreitung und Verhalten auf dem Amazon Marketplace zu analysieren.

2015

- Zertifizieren und Entfernen unterschiedlicher Auswirkungen – (SIGKDD) schlägt SVM-basierte Methoden zur Zertifizierung der Abwesenheit von Verzerrungen und Methoden zur Entfernung von Verzerrungen aus einem Datensatz vor.

- Ein Blick unter die Haube von Uber – (IMC) Informieren Sie sich über die Implementierungsdetails des Uber-Algorithmus für steigende Preise.

2014

- Ein Blick in die Blackbox: Erkunden von Klassifikatoren durch Randomisierung – (Data Mining and Knowledge Discovery Journal) (Code) Findet Gruppen von Features, die permutiert werden können, ohne die Ausgabebezeichnung der vorhergesagten Stichproben zu ändern

- XRay: Verbesserung der Transparenz des Webs durch differenzielle Korrelation – (USENIX Security) Prüft, welche Benutzerprofildaten für die Ausrichtung auf eine bestimmte Anzeige, Empfehlung oder einen bestimmten Preis verwendet wurden.

2013

- Messung der Personalisierung der Websuche – (WWW) Entwickelt eine Methodik zur Messung der Personalisierung in Websuchergebnissen.

- Auditing: Aktives Lernen mit ergebnisabhängigen Abfragekosten – (NIPS) Lernt von einem binären Klassifikator, der nur für negative Labels zahlt.

2012

- Abfragestrategien zur Umgehung konvex-induzierender Klassifikatoren – (JMLR) Umgehungsmethoden für konvexe Klassifikatoren. Berücksichtigt die Komplexität der Umgehung.

2008

- Privacy Oracle: ein System zum Auffinden von Anwendungslecks mit Black-Box-Differentialtests (CCS) Privacy Oracle: ein System, das die Lecks persönlicher Daten von Anwendungen bei Übertragungen an Remoteserver aufdeckt.

2005

- Adversarial Learning – (KDD) Reverse Engineering entfernter linearer Klassifikatoren unter Verwendung von Mitgliedschaftsabfragen.

Verwandte Veranstaltungen

2024

- 1. Internationale Konferenz zu Wirtschaftsprüfung und künstlicher Intelligenz

- Regulierbarer ML-Workshop (RegML'24)

2023

- Unterstützung des Benutzerengagements beim Testen, Prüfen und Anfechten von KI (CSCW User AI Auditing)

- Workshop zu algorithmischen Audits von Algorithmen (WAAA)

- Regulierbarer ML-Workshop (RegML'23)