Offensive KI-Zusammenstellung

Eine kuratierte Liste nützlicher Ressourcen zum Thema Offensive AI.

? Inhalt?

- Missbrauch

- ? Kontroverses maschinelles Lernen?

- ⚡Angriffe⚡

- Extraktion

- ️ Einschränkungen ️

- ?️ Abwehraktionen ?️

- ? Nützliche Links?

- ⬅️ Inversion (oder Inferenz) ⬅️

- ?️ Abwehraktionen ?️

- ? Nützliche Links?

- ? Vergiftung?

- ? Hintertüren?

- ?️ Abwehraktionen ?️

- ? Nützliche Links?

- ?♂️ Ausweichen ?♂️

- ?️ Abwehraktionen ?️

- ? Nützliche Links?

- Werkzeuge

- ? Verwenden ?

- ♂️ Pentesting ♂️

- ? Schadsoftware?

- ?️ OSINT ?️

- ? Phishing?

- ?? Generative KI ??

- ? Audio?

- Werkzeuge

- Anwendungen

- ? Erkennung?

- ? Bild ?

- Werkzeuge

- Anwendungen

- ? Erkennung?

- ? Video?

- Werkzeuge

- Anwendungen

- ? Erkennung?

- ? Text?

- Werkzeuge

- ? Erkennung?

- Anwendungen

- Sonstiges

- Umfragen

- ? Mitwirkende?

- ©️ Lizenz ©️

Missbrauch

Ausnutzung der Schwachstellen von KI-Modellen.

? Kontroverses maschinelles Lernen?

Adversarial Machine Learning ist dafür verantwortlich, ihre Schwächen zu bewerten und Gegenmaßnahmen bereitzustellen.

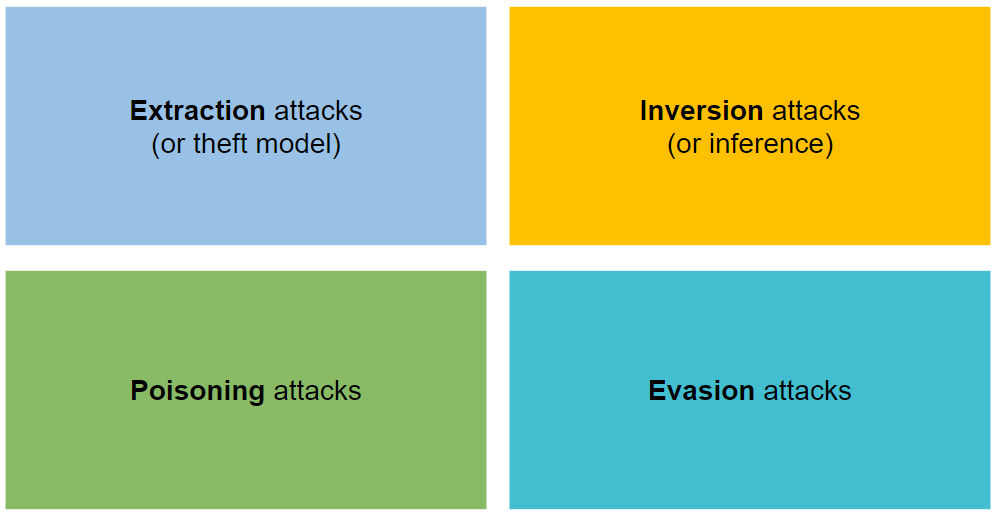

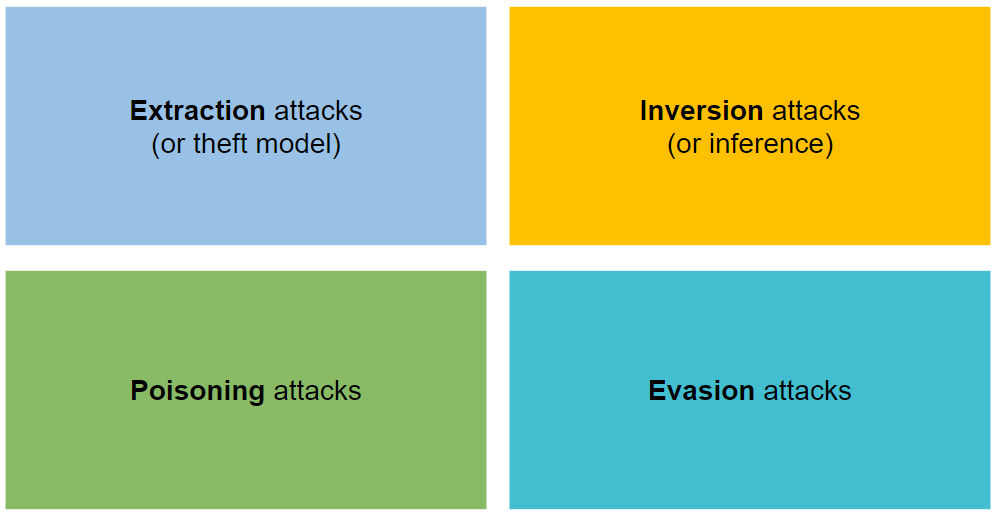

⚡Angriffe⚡

Es ist in vier Arten von Angriffen unterteilt: Extraktion, Inversion, Vergiftung und Ausweichen.

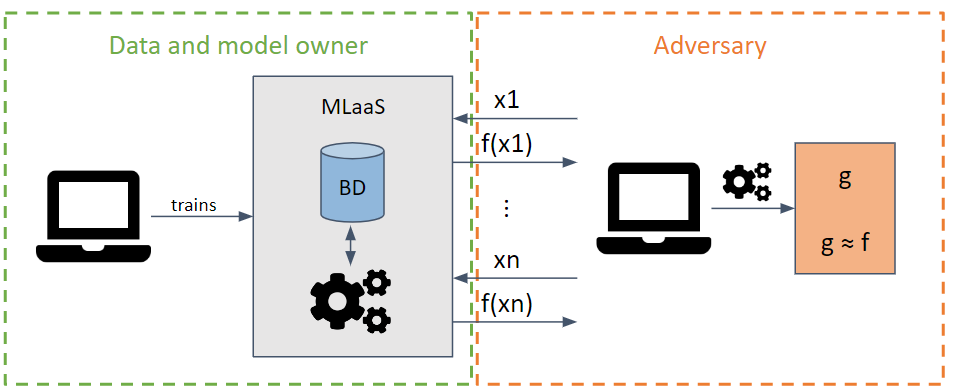

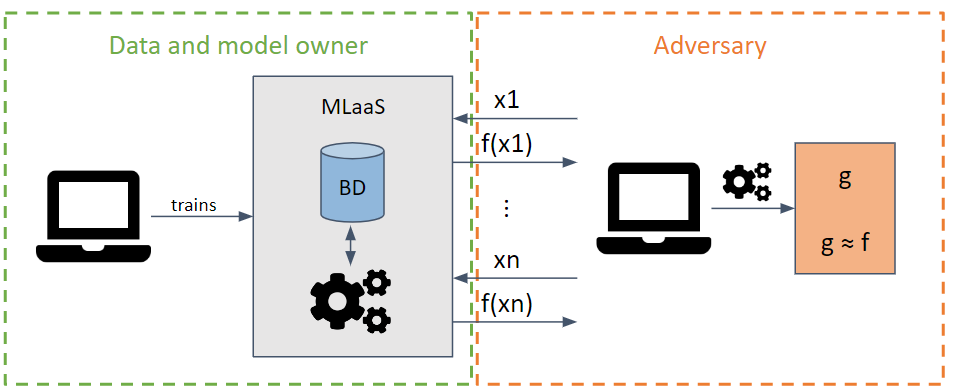

Extraktion

Es versucht, die Parameter und Hyperparameter eines Modells zu stehlen, indem es Anfragen stellt, die die Extraktion von Informationen maximieren.

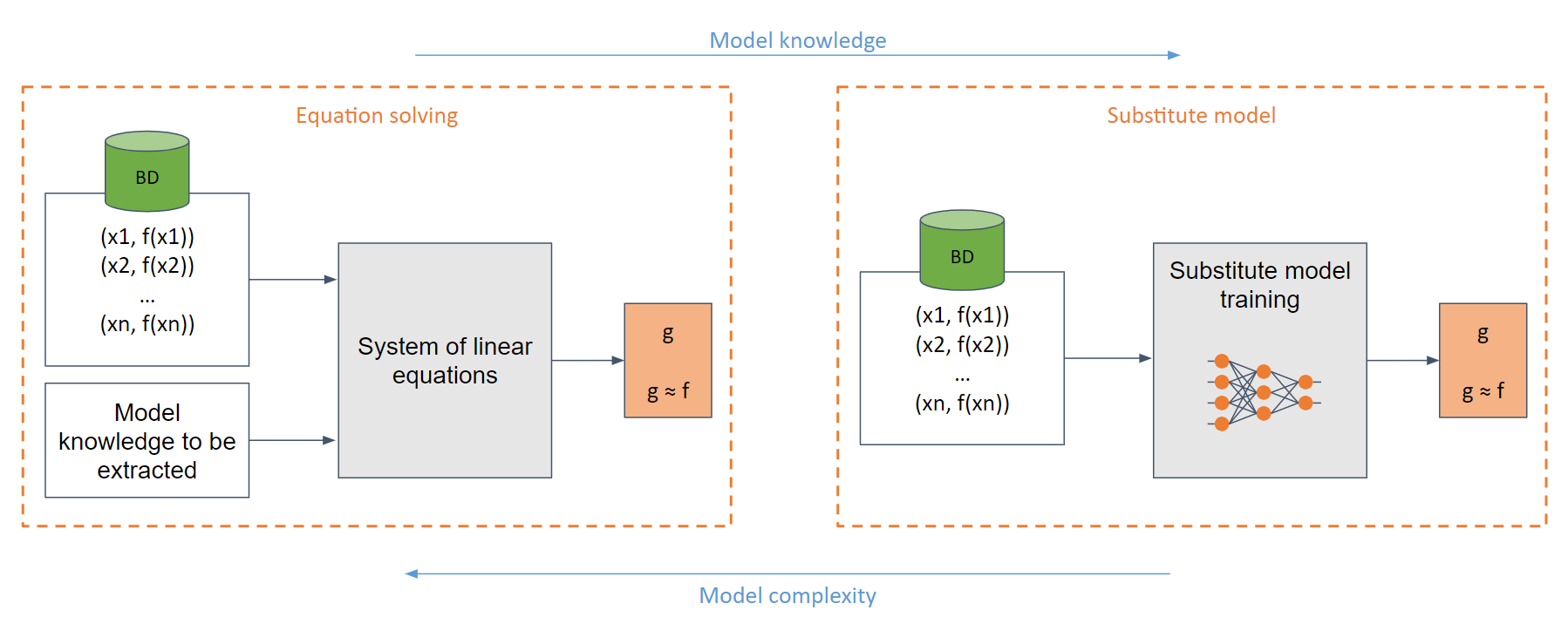

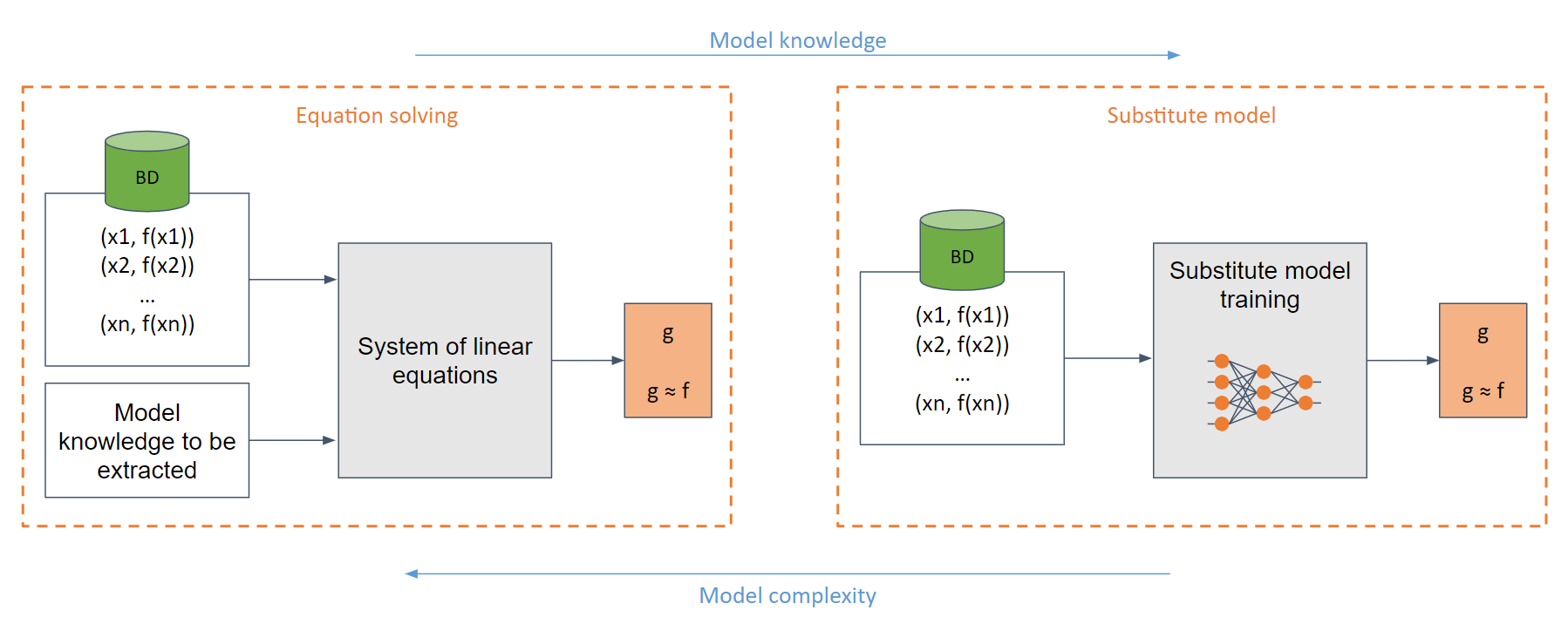

Je nach Kenntnis des Gegnermodells können White-Box- und Black-Box-Angriffe durchgeführt werden.

Im einfachsten White-Box-Fall (wenn der Gegner das Modell vollständig kennt, z. B. eine Sigmoidfunktion) kann man ein System linearer Gleichungen erstellen, das leicht gelöst werden kann.

Im generischen Fall, bei unzureichender Kenntnis des Modells, wird das Ersatzmodell verwendet. Dieses Modell wird anhand der an das Originalmodell gestellten Anforderungen trainiert, um die gleiche Funktionalität wie das Original nachzuahmen.

️ Einschränkungen ️

Das Training eines Ersatzmodells entspricht (in vielen Fällen) dem Training eines Modells von Grund auf.

Sehr rechenintensiv.

Die Anzahl der Anfragen, bevor der Gegner erkannt wird, ist begrenzt.

?️ Abwehraktionen ?️

Rundung der Ausgabewerte.

Nutzung differenzierter Privatsphäre.

Einsatz von Ensembles.

Einsatz spezifischer Abwehrmaßnahmen

- Spezifische Architekturen

- PRADA

- Adaptive Fehlinformation

- ...

? Nützliche Links?

- Diebstahl von Modellen für maschinelles Lernen über Vorhersage-APIs

- Diebstahl von Hyperparametern beim maschinellen Lernen

- Knockoff-Netze: Diebstahl der Funktionalität von Black-Box-Modellen

- Modellextraktionswarnung im MLaaS-Paradigma

- Copycat CNN: Diebstahl von Wissen durch Überzeugen von Geständnissen mit zufälligen, nicht gekennzeichneten Daten

- Prediction Poisoning: Auf dem Weg zur Abwehr von DNN-Modelldiebstahlangriffen

- Diebstahl neuronaler Netze über Timing-Seitenkanäle

- Modelldiebstahlangriffe auf induktive graphische neuronale Netze

- Hochpräzise und hochauflösende Extraktion neuronaler Netze

- Das Vergiften von Web-Scale-Trainingsdatensätzen ist praktisch

- Polynomiale kryptanalytische Extraktion neuronaler Netzwerkmodelle

- Prompt-spezifische Vergiftungsangriffe auf generative Text-zu-Bild-Modelle

- Fantastische Datenvergiftung und Backdoor-Angriffe: Eine kuratierte Liste von Artikeln und Ressourcen im Zusammenhang mit Datenvergiftung, Backdoor-Angriffen und Abwehrmaßnahmen dagegen.

- BackdoorBox: Eine Open-Source-Python-Toolbox für Backdoor-Angriffe und -Verteidigung.

- Diebstahl eines Teils eines Produktionssprachenmodells

- Hard-Label-Kryptanalytische Extraktion neuronaler Netzwerkmodelle

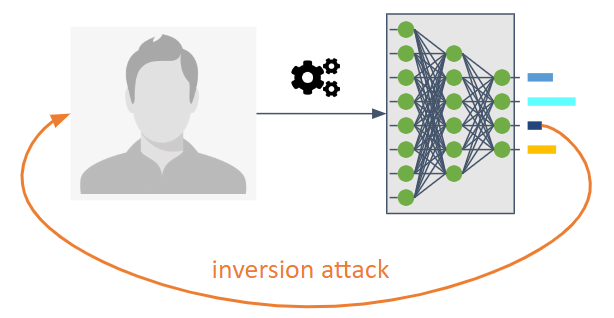

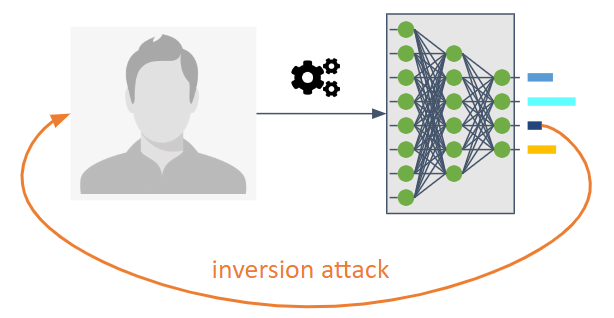

⬅️ Inversion (oder Inferenz) ⬅️

Sie sollen den Informationsfluss eines maschinellen Lernmodells umkehren.

Sie ermöglichen es einem Gegner, das Modell zu kennen, das nicht ausdrücklich zur Weitergabe gedacht war.

Sie ermöglichen es uns, die Trainingsdaten oder -informationen als statistische Eigenschaften des Modells zu kennen.

Drei Arten sind möglich:

Membership Inference Attack (MIA) : Ein Gegner versucht herauszufinden, ob eine Stichprobe im Rahmen des Trainings verwendet wurde.

Property Inference Attack (PIA) : Ein Angreifer zielt darauf ab, statistische Eigenschaften zu extrahieren, die während der Trainingsphase nicht explizit als Merkmale codiert wurden.

Rekonstruktion : Ein Gegner versucht, eine oder mehrere Proben aus dem Trainingssatz und/oder ihren entsprechenden Bezeichnungen zu rekonstruieren. Auch Inversion genannt.

?️ Abwehraktionen ?️

Verwendung fortschrittlicher Kryptographie. Zu den Gegenmaßnahmen gehören differenzielle Privatsphäre, homomorphe Kryptographie und sichere Mehrparteienberechnung.

Verwendung von Regularisierungstechniken wie Dropout aufgrund des Zusammenhangs zwischen Übertraining und Privatsphäre.

Die Modellkomprimierung wurde als Abwehr gegen Rekonstruktionsangriffe vorgeschlagen.

? Nützliche Links?

- Mitgliedschaftsinferenzangriffe auf Modelle des maschinellen Lernens

- Modellinversionsangriffe, die Vertrauensinformationen und grundlegende Gegenmaßnahmen ausnutzen

- Modelle des maschinellen Lernens, die sich zu viel merken

- ML-Leaks: Modell- und datenunabhängige Mitgliedschaftsinferenz-Angriffe und Abwehrmaßnahmen für Modelle des maschinellen Lernens

- Deep Models unter dem GAN: Informationslecks durch kollaboratives Deep Learning

- LOGAN: Mitgliedschaftsinferenzangriffe gegen generative Modelle

- Überanpassung, Robustheit und bösartige Algorithmen: Eine Studie über mögliche Ursachen für Datenschutzrisiken beim maschinellen Lernen

- Umfassende Datenschutzanalyse von Deep Learning: Eigenständiges und föderiertes Lernen unter passiven und aktiven White-Box-Inferenzangriffen

- Inferenzangriffe gegen kollaboratives Lernen

- The Secret Sharer: Bewertung und Test unbeabsichtigter Speicherung in neuronalen Netzen

- Auf dem Weg zur Wissenschaft von Sicherheit und Datenschutz beim maschinellen Lernen

- MemGuard: Abwehr von Black-Box-Mitgliedschaftsinferenzangriffen mithilfe kontradiktorischer Beispiele

- Extrahieren von Trainingsdaten aus großen Sprachmodellen

- Eigenschaftsinferenzangriffe auf vollständig verbundene neuronale Netze unter Verwendung permutationsinvarianter Darstellungen

- Extrahieren von Trainingsdaten aus Diffusionsmodellen

- Hochauflösende Bildrekonstruktion mit latenten Diffusionsmodellen der menschlichen Gehirnaktivität

- Diebstahl und Umgehung von Malware-Klassifizierern und Antivirenprogrammen bei geringen Fehlalarmbedingungen

- Realistische Angriffe zur Präsentation von Fingerabdrücken basierend auf einem kontradiktorischen Ansatz

- Aktive gegnerische Tests: Steigerung des Vertrauens in die Bewertung der gegnerischen Robustheit.

- GPT-Jailbreak-Status: Updates zum Status des Jailbreaking des OpenAI GPT-Sprachmodells.

- Beschleunigungen in der Größenordnung für die LLM-Mitgliedschaftsinferenz

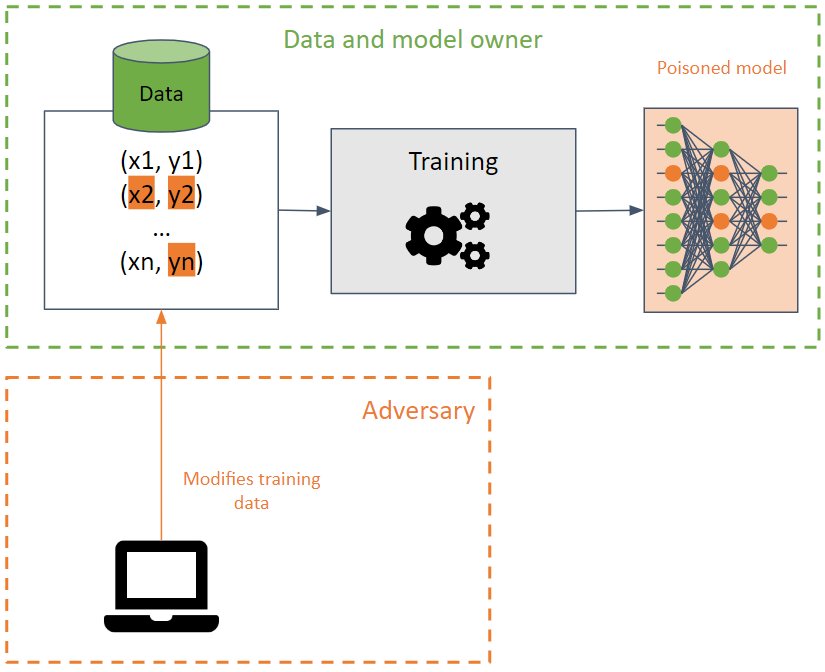

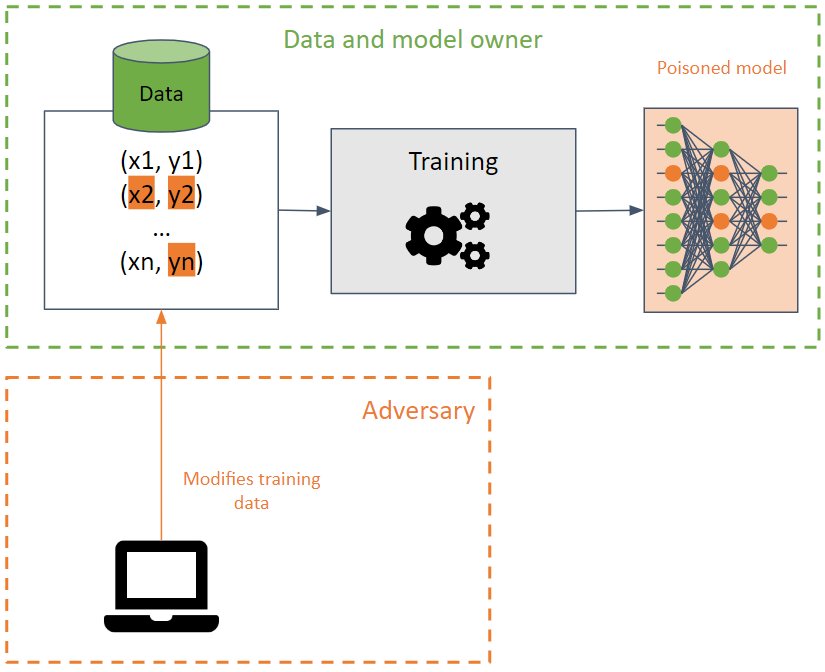

? Vergiftung?

Sie zielen darauf ab, den Trainingssatz zu verfälschen, indem sie dazu führen, dass ein maschinelles Lernmodell seine Genauigkeit verringert.

Dieser Angriff ist schwer zu erkennen, wenn er auf die Trainingsdaten angewendet wird, da sich der Angriff auf verschiedene Modelle ausbreiten kann, die dieselben Trainingsdaten verwenden.

Der Gegner versucht, die Verfügbarkeit des Modells zu zerstören, indem er die Entscheidungsgrenze ändert und dadurch falsche Vorhersagen erzeugt oder eine Hintertür in einem Modell erstellt. Im letzteren Fall verhält sich das Modell in den meisten Fällen korrekt (gibt die gewünschten Vorhersagen zurück), mit Ausnahme bestimmter Eingaben, die speziell vom Gegner erstellt wurden und unerwünschte Ergebnisse liefern. Der Gegner kann die Ergebnisse der Vorhersagen manipulieren und zukünftige Angriffe starten.

? Hintertüren?

BadNets sind die einfachste Art von Hintertür in einem maschinellen Lernmodell. Darüber hinaus können BadNets in einem Modell erhalten bleiben, auch wenn sie für eine andere Aufgabe als das ursprüngliche Modell erneut umtrainiert werden (Transferlernen).

Es ist wichtig zu beachten, dass öffentliche vorab trainierte Modelle Hintertüren enthalten können .

?️ Abwehraktionen ?️

Erkennung vergifteter Daten und Einsatz von Datenbereinigung.

Robuste Trainingsmethoden.

Spezifische Abwehrmaßnahmen.

- Neural Cleanse: Identifizierung und Abwehr von Backdoor-Angriffen in neuronalen Netzen

- STRIP: Eine Verteidigung gegen Trojaner-Angriffe auf tiefe neuronale Netze

- Erkennen von Backdoor-Angriffen auf tiefe neuronale Netze durch Aktivierungsclustering

- ABS: Scannen neuronaler Netze nach Hintertüren durch künstliche Hirnstimulation

- DeepInspect: Ein Black-Box-Trojaner-Erkennungs- und -Minderungs-Framework für tiefe neuronale Netze

- Verteidigung neuronaler Hintertüren durch generative Verteilungsmodellierung

- Eine umfassende Umfrage zu Backdoor-Angriffen und ihren Abwehrmaßnahmen in Gesichtserkennungssystemen

- DataElixir: Bereinigen vergifteter Datensätze zur Eindämmung von Backdoor-Angriffen über Diffusionsmodelle

? Nützliche Links?

- Vergiftungsangriffe gegen Support-Vektor-Maschinen

- Gezielte Backdoor-Angriffe auf Deep-Learning-Systeme mittels Data Poisoning

- Trojaner-Angriff auf neuronale Netze

- Fine-Pruning: Abwehr von Backdoor-Angriffen auf tiefe neuronale Netze

- Giftfrösche! Gezielte Clean-Label-Poisoning-Angriffe auf neuronale Netze

- Spektrale Signaturen bei Backdoor-Angriffen

- Latente Backdoor-Angriffe auf tiefe neuronale Netze

- Regula Sub-rosa: Latente Backdoor-Angriffe auf tiefe neuronale Netze

- Hintertürangriffe mit versteckten Auslösern

- Übertragbare Clean-Label-Vergiftungsangriffe auf tiefe neuronale Netze

- TABOR: Ein hochpräziser Ansatz zur Inspektion und Wiederherstellung von Trojaner-Hintertüren in KI-Systemen

- Auf dem Weg zur Vergiftung von Deep-Learning-Algorithmen durch Backgradientenoptimierung

- Wann scheitert maschinelles Lernen? Allgemeine Übertragbarkeit für Flucht- und Vergiftungsangriffe

- Zertifizierte Verteidigung gegen Datenvergiftungsangriffe

- Eingabebewusster dynamischer Backdoor-Angriff

- Wie man föderiertes Lernen hinter die Tür setzt

- Einbau nicht erkennbarer Hintertüren in Modelle für maschinelles Lernen

- Täuschen Sie die KI!: Hacker können Hintertüren nutzen, um Trainingsdaten zu verfälschen und ein KI-Modell dazu zu bringen, Bilder falsch zu klassifizieren. Erfahren Sie, wie IBM-Forscher erkennen können, wann Daten manipuliert wurden, und dann erraten können, welche Hintertüren in diesen Datensätzen verborgen sind. Können Sie die Hintertür erraten?

- Backdoor Toolbox: Eine kompakte Toolbox für Backdoor-Angriffe und -Verteidigungen.

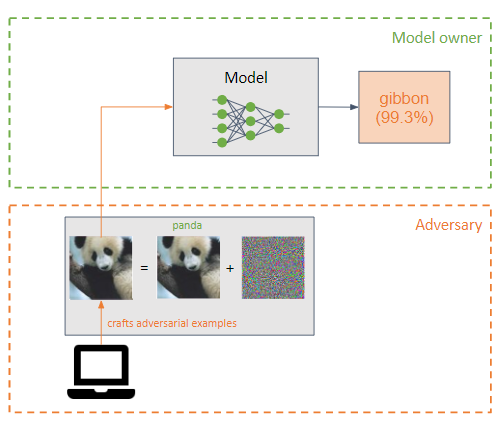

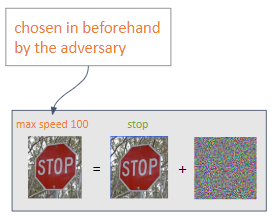

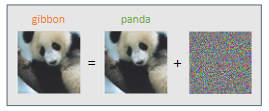

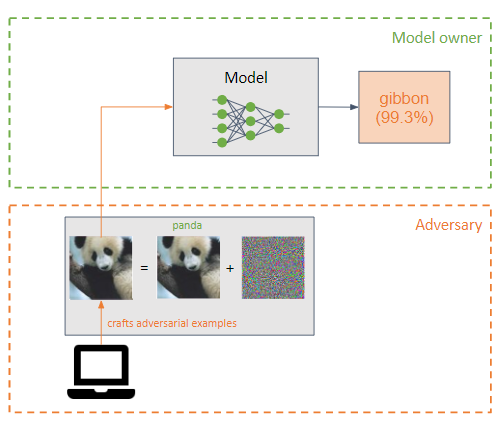

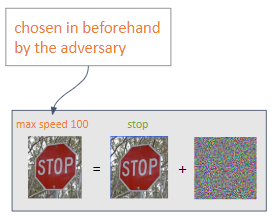

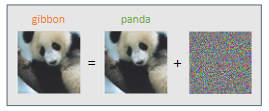

?♂️ Ausweichen ?♂️

Ein Gegner fügt der Eingabe eines maschinellen Lernmodells eine kleine Störung (in Form von Rauschen) hinzu, um eine falsche Klassifizierung zu bewirken (Beispielgegner).

Sie ähneln Poisoning-Angriffen, ihr Hauptunterschied besteht jedoch darin, dass Evasion-Angriffe versuchen, die Schwächen des Modells in der Inferenzphase auszunutzen.

Das Ziel des Gegners besteht darin, dass die Beispiele des Gegners für einen Menschen nicht wahrnehmbar sind.

Abhängig von der vom Gegner gewünschten Leistung können zwei Arten von Angriffen ausgeführt werden:

Gezielt : Der Gegner möchte eine Vorhersage seiner Wahl erhalten.

Ungezielt : Der Gegner beabsichtigt, eine Fehlklassifizierung zu erreichen.

Die häufigsten Angriffe sind White-Box-Angriffe :

- L-BFGS

- FGSM

- BIM

- JSMA

- Carlini & Wagner (C&W)

- NewtonFool

- EAD

- UAP

?️ Abwehraktionen ?️

Gegnerisches Training, das darin besteht, während des Trainings gegnerische Beispiele zu erstellen, damit das Modell Merkmale der gegnerischen Beispiele lernen kann, wodurch das Modell robuster gegenüber dieser Art von Angriff wird.

Transformationen an Eingaben.

Gradientenmaskierung/Regulierung. Nicht sehr effektiv.

Schwache Abwehrkräfte.

Sofortige Injektionsabwehr: Jede praktische und vorgeschlagene Verteidigung gegen sofortige Injektion.

Lakera PINT Benchmark: Der Prompt Injection Test (PINT) Benchmark bietet eine neutrale Möglichkeit, die Leistung eines Prompt-Injection-Erkennungssystems wie Lakera Guard zu bewerten, ohne sich auf bekannte öffentliche Datensätze zu verlassen, die diese Tools zur Optimierung der Bewertungsleistung verwenden können.

Devil's Inference: Eine Methode zur kontradiktorischen Bewertung des Phi-3-Instruct-Modells durch Beobachtung der Aufmerksamkeitsverteilung über seine Köpfe hinweg, wenn es bestimmten Eingaben ausgesetzt wird. Dieser Ansatz veranlasst das Modell, die „Denkweise des Teufels“ zu übernehmen, was es ihm ermöglicht, Ergebnisse gewalttätiger Natur zu erzeugen.

? Nützliche Links?

- Praktische Black-Box-Angriffe gegen maschinelles Lernen

- Die Grenzen des Deep Learning in kontradiktorischen Umgebungen

- Auf dem Weg zur Bewertung der Robustheit neuronaler Netze

- Destillation als Abwehr gegen gegnerische Störungen gegen tiefe neuronale Netze

- Widersprüchliche Beispiele in der physischen Welt

- Ensemble-Gegnertraining: Angriffe und Verteidigung

- Auf dem Weg zu Deep-Learning-Modellen, die gegen gegnerische Angriffe resistent sind

- Faszinierende Eigenschaften neuronaler Netze

- Widersprüchliche Beispiele erklären und nutzen

- Eintauchen in übertragbare gegnerische Beispiele und Black-Box-Angriffe

- Konfrontatives maschinelles Lernen im großen Maßstab

- Black-Box-Angriffe mit begrenzten Abfragen und Informationen

- Feature Squeezing: Erkennung gegnerischer Beispiele in tiefen neuronalen Netzen

- Entscheidungsbasierte gegnerische Angriffe: Zuverlässige Angriffe auf Black-Box-Modelle für maschinelles Lernen

- Gegnerische Angriffe mit Schwung verstärken

- Der Raum übertragbarer kontradiktorischer Beispiele

- Gegen kontroverse Bilder mithilfe von Eingabetransformationen vorgehen

- Defense-GAN: Schutz von Klassifikatoren vor gegnerischen Angriffen mithilfe generativer Modelle

- Synthese robuster gegnerischer Beispiele

- Milderung gegnerischer Effekte durch Randomisierung

- Zur Erkennung gegnerischer Störungen

- Gegnerischer Patch

- PixelDefend: Nutzung generativer Modelle, um gegnerische Beispiele zu verstehen und sich gegen sie zu verteidigen

- Ein-Pixel-Angriff zur Täuschung tiefer neuronaler Netze

- Effiziente Verteidigung gegen gegnerische Angriffe

- Robuste Angriffe auf die physische Welt auf die visuelle Deep-Learning-Klassifizierung

- Gegnerische Störungen gegen tiefe neuronale Netze zur Malware-Klassifizierung

- 3D-Angriffe jenseits der Punktwolke

- Gegnerische Störungen täuschen Deepfake-Detektoren

- Gegnerische Deepfakes: Bewertung der Anfälligkeit von Deepfake-Detektoren gegenüber gegnerischen Beispielen

- Ein Überblick über Schwachstellen sprachgesteuerter Systeme

- FastWordBug: Eine schnelle Methode zum Generieren von gegnerischem Text gegen NLP-Anwendungen

- Phantom des ADAS: Schutz fortschrittlicher Fahrerassistenzsysteme vor sekundenschnellen Phantomangriffen

- llm-Angriffe: Universelle und übertragbare Angriffe auf ausgerichtete Sprachmodelle.

- Angriffe auf KI-Modelle: Prompt Injection vs. Supply Chain Poisoning

- Prompt-Injection-Angriff auf LLM-integrierte Anwendungen

- Garak: LLM-Schwachstellenscanner.

- Einfache kontradiktorische Transformationen in PyTorch

- ChatGPT-Plugins: Datenexfiltration über Bilder und Cross-Plugin-Anfragefälschung

- Image-Hijacks: Gegnerische Images können generative Modelle zur Laufzeit steuern

- Mehrfachangriffe: Viele Bilder + der gleiche gegnerische Angriff → viele Zielbezeichnungen

- AKTIV: Auf dem Weg zu einer hochgradig übertragbaren physischen 3D-Tarnung für ein universelles und robustes Ausweichen vor Fahrzeugen

- LLM Red Teaming GPTSs: Prompt-Leaking, API-Leaking, Dokumenten-Leaking

- Von Menschen produzierbare gegnerische Beispiele

- Mehrsprachige Jailbreak-Herausforderungen in großen Sprachmodellen

- Missbrauch von Tools in großen Sprachmodellen mit visuellen kontradiktorischen Beispielen

- AutoDAN: Interpretierbare, auf Gradienten basierende gegnerische Angriffe auf große Sprachmodelle

- Multimodale Injektion: (Ab)Verwendung von Bildern und Tönen zur indirekten Befehlsinjektion in multimodalen LLMs.

- JailbreakingLLMs: Jailbreaking großer Black-Box-Sprachmodelle in zwanzig Abfragen.

- Baum der Angriffe: Automatisches Jailbreaking von Black-Box-LLMs

- GPTs: Durchgesickerte Eingabeaufforderungen von GPTs.

- KI-Exploits: Eine Sammlung realer KI/ML-Exploits für verantwortungsbewusst offengelegte Schwachstellen.

- LLM-Agenten können Websites autonom hacken

- Cloudflare kündigt Firewall für KI an

- PromptInject: Framework, das Eingabeaufforderungen modular zusammenstellt, um eine quantitative Analyse der Robustheit von LLMs gegenüber gegnerischen Eingabeaufforderungsangriffen bereitzustellen.

- LLM Red Teaming: Kontroverse, Programmier- und sprachliche Ansätze VS ChatGPT, Claude, Mistral, Grok, LLAMA und Gemini

- Die Befehlshierarchie: Schulung von LLMs zur Priorisierung privilegierter Anweisungen

- Prompt-Injection/JailBreaking eines Banking-LLM-Agenten (GPT-4, Langchain)

- GitHub Copilot Chat: Von der sofortigen Injektion zur Datenexfiltration

- Kontroverse Beispiele sind in Diffusionsmodell-Mannigfaltigkeiten falsch ausgerichtet

- Bild-zu-Text-Logik-Jailbreak: Ihre Fantasie kann Ihnen bei allem helfen

- Mitigating Skeleton Key, eine neue Art generativer KI-Jailbreak-Technik

- Bildverschleierungs-Benchmark: Dieses Repository enthält den Code zur Bewertung von Modellen für den Bildverschleierungs-Benchmark, der erstmals in „Benchmarking Robustness to Adversarial Image Obfuscations“ vorgestellt wurde.

- Jailbreaking großer Sprachmodelle mit symbolischer Mathematik

Werkzeuge

| Name | Typ | Unterstützte Algorithmen | Unterstützte Angriffstypen | Angriff/Verteidigung | Unterstützte Frameworks | Popularität |

|---|

| Cleverhans | Bild | Tiefes Lernen | Ausweichen | Angriff | Tensorflow, Keras, JAX | |

| Narrenbox | Bild | Tiefes Lernen | Ausweichen | Angriff | Tensorflow, PyTorch, JAX | |

| KUNST | Jeder Typ (Bild, tabellarische Daten, Audio,...) | Deep Learning, SVM, LR usw. | Beliebig (Extraktion, Schlussfolgerung, Vergiftung, Umgehung) | Beide | Tensorflow, Keras, Pytorch, Scikit Learn | |

| TextAttack | Text | Tiefes Lernen | Ausweichen | Angriff | Keras, HuggingFace | |

| Advertorch | Bild | Tiefes Lernen | Ausweichen | Beide | --- | |

| AdvBox | Bild | Tiefes Lernen | Ausweichen | Beide | PyTorch, Tensorflow, MxNet | |

| DeepRobust | Bild, Grafik | Tiefes Lernen | Ausweichen | Beide | PyTorch | |

| Gegenfit | Beliebig | Beliebig | Ausweichen | Angriff | --- | |

| Widersprüchliche Audiobeispiele | Audio | DeepSpeech | Ausweichen | Angriff | --- | |

KUNST

Die Adversarial Robustness Toolbox, abgekürzt ART, ist eine Open-Source-Bibliothek für Adversarial Machine Learning zum Testen der Robustheit von Modellen für maschinelles Lernen.

Es wurde in Python entwickelt und implementiert Extraktions-, Inversions-, Vergiftungs- und Ausweichangriffe sowie Abwehrmaßnahmen.

ART unterstützt die beliebtesten Frameworks: Tensorflow, Keras, PyTorch, MxNet und ScikitLearn und viele andere.

Es ist nicht auf die Verwendung von Modellen beschränkt, die Bilder als Eingabe verwenden, sondern unterstützt auch andere Datentypen, wie Audio, Video, Tabellendaten usw.

Workshop zum Erlernen von Adversarial Machine Learning mit ART ??

Cleverhans

Cleverhans ist eine Bibliothek zur Durchführung von Umgehungsangriffen und zum Testen der Robustheit eines Deep-Learning-Modells an Bildmodellen.

Es wurde in Python entwickelt und lässt sich in die Frameworks Tensorflow, Torch und JAX integrieren.

Es implementiert zahlreiche Angriffe wie unter anderem L-BFGS, FGSM, JSMA, C&W.

? Verwenden ?

KI wird verwendet, um bösartige Aufgaben auszuführen und klassische Angriffe zu verstärken.

♂️ Pentesting ♂️

- GyoiThon: Penetrationstest-Tool der nächsten Generation, Tool zum Sammeln von Informationen für Webserver.

- Deep Exploit: Vollautomatisches Penetrationstest-Tool mit Deep Reinforcement Learning.

- AutoPentest-DRL: Automatisierte Penetrationstests mit Deep Reinforcement Learning.

- DeepGenerator: Generieren Sie mithilfe genetischer Algorithmen und generativer gegnerischer Netzwerke vollautomatisch Injektionscodes für die Bewertung von Webanwendungen.

- Eyeballer: Eyeballer ist für groß angelegte Netzwerkpenetrationstests gedacht, bei denen Sie „interessante“ Ziele aus einer großen Anzahl webbasierter Hosts finden müssen.

- Nebula: KI-gestützter ethischer Hacking-Assistent.

- Teams von LLM-Agenten können Zero-Day-Schwachstellen ausnutzen

- Einblicke und aktuelle Lücken in Open-Source-LLM-Schwachstellenscannern: Eine vergleichende Analyse

? Schadsoftware?

- DeepLocker: Verstecken gezielter Angriffe mit KI-Schlossering, von IBM Labs auf BH.

- Ein Überblick über die in Malware verwendete künstliche Intelligenz: Eine kuratierte Liste von KI-Malware-Ressourcen.

- DeepObfusCode: Quellcode-Verschleierung durch Sequenz-zu-Sequenz-Netzwerke.

- AutoCAT: Reinforcement Learning zur automatisierten Untersuchung von Cache-Timing-Angriffen.

- KI-BASIERTES BOTNET: Ein spieltheoretischer Ansatz für die KI-basierte Abwehr von Botnet-Angriffen.

- SECML_Malware: Python-Bibliothek zum Erstellen gegnerischer Angriffe gegen Windows-Malware-Detektoren.

- Transcendent-Release: Verwendung der konformen Bewertung zur Erkennung von Konzeptabweichungen, die sich auf die Malware-Erkennung auswirken.

?️ OSINT ?️

- SNAP_R: Generieren Sie automatisch Spear-Phishing-Beiträge in sozialen Medien.

- SpyScrap: SpyScrap kombiniert Gesichtserkennungsmethoden, um die Ergebnisse zu filtern, und nutzt die Verarbeitung natürlicher Sprache, um wichtige Entitäten von der Website abzurufen, auf die der Benutzer gelangt.

? Phishing?

- DeepDGA: Implementierung von DeepDGA: Adversarially-Tuned Domain Generation and Detection.

? Bedrohungsintelligenz?

- Von Sandstränden zu Villen: Ermöglichung der automatischen Cyberangriffskonstruktion über den gesamten Lebenszyklus mit LLM

? Seitenkanäle?

- SCAAML: Seitenkanalangriffe mit Unterstützung durch maschinelles Lernen.

?? Generative KI ??

? Audio?

Werkzeuge

- Deep-Voice-Conversion: Tiefe neuronale Netze für die Sprachkonvertierung (Sprachstilübertragung) in Tensorflow.

- tacotron: Eine TensorFlow-Implementierung der Tacotron-Sprachsynthese von Google mit vorab trainiertem Modell (inoffiziell).

- Echtzeit-Stimmenklonen: Klonen Sie eine Stimme in 5 Sekunden, um beliebige Sprache in Echtzeit zu erzeugen.

- mimic2: Text-to-Speech-Engine basierend auf der Tacotron-Architektur, ursprünglich implementiert von Keith Ito.

- Neural-Voice-Cloning-with-Few-Samples: Implementierung des Neural-Voice-Cloning-with-Few-Samples Forschungspapier von Baidu.

- Vall-E: Eine inoffizielle PyTorch-Implementierung des Audio-LM VALL-E.

- Sprachwechsler: Echtzeit-Sprachwechsler.

- Retrieval-based-Voice-Conversion-WebUI: Ein benutzerfreundliches Sprachkonvertierungs-Framework basierend auf VITS.

- Audiocraft: Audiocraft ist eine Bibliothek zur Audioverarbeitung und -generierung mit Deep Learning. Es verfügt über den hochmodernen EnCodec-Audiokompressor/Tokenizer sowie MusicGen, einen einfachen und steuerbaren Musikgenerierungs-LM mit Text- und Melodieaufbereitung.

- VALL-EX: Eine Open-Source-Implementierung des Zero-Shot-TTS-Modells VALL-E X von Microsoft.

- OpenVoice: Sofortiges Klonen von Stimmen durch MyShell.

- MeloTTS: Hochwertige mehrsprachige Text-to-Speech-Bibliothek von MyShell.ai. Unterstützt Englisch, Spanisch, Französisch, Chinesisch, Japanisch und Koreanisch.

- VoiceCraft: Zero-Shot-Sprachbearbeitung und Text-to-Speech in freier Wildbahn.

- Parler-TTS: Inferenz- und Trainingsbibliothek für hochwertige TTS-Modelle.

- ChatTTS: Ein generatives Sprachmodell für den täglichen Dialog.

Anwendungen

- Lip2Wav: Erzeugen Sie hochwertige Sprache nur aus Lippenbewegungen.

- AudioLDM: Text-to-Audio-Generierung mit latenten Diffusionsmodellen

- deepvoice3_pytorch: PyTorch-Implementierung von auf Faltungs-Neuronalen Netzen basierenden Text-zu-Sprache-Synthesemodellen.

- ? Riffusion: Stabile Diffusion für Echtzeit-Musikgenerierung.

- whisper.cpp: Port des Whisper-Modells von OpenAI in C/C++.

- TTS: ? – ein Deep-Learning-Toolkit für Text-to-Speech, praxiserprobt in Forschung und Produktion.

- YourTTS: Auf dem Weg zu Zero-Shot Multi-Speaker TTS und Zero-Shot Voice Conversion für alle.

- TorToiSe: Ein mehrsprachiges TTS-System, das mit Schwerpunkt auf Qualität trainiert wurde.

- DiffSinger: Gesangsstimmensynthese über Shallow Diffusion Mechanism (SVS & TTS).

- WaveNet-Vocoder: Implementierung des WaveNet-Vocoders, der qualitativ hochwertige Rohsprachproben erzeugen kann, die auf sprachlichen oder akustischen Merkmalen basieren.

- Deepvoice3_pytorch: PyTorch-Implementierung von auf Faltungs-Neuronalen Netzen basierenden Text-zu-Sprache-Synthesemodellen.

- eSpeak NG Text-to-Speech: eSpeak NG ist ein Open-Source-Sprachsynthesizer, der mehr als hundert Sprachen und Akzente unterstützt.

- RealChar: Erstellen, anpassen und sprechen Sie mit Ihrem KI-Charakter/Begleiter in Echtzeit (alles in einer Codebasis!). Führen Sie mit LLM OpenAI GPT3.5/4, Anthropic Claude2, Chroma Vector DB, Whisper Speech2Text und ElevenLabs Text2Speech eine natürliche, nahtlose Konversation mit KI überall (mobil, im Web und auf dem Terminal).

- Klonen neuronaler Stimmen mit ein paar Samples

- NAUTILUS: Ein vielseitiges System zum Klonen von Stimmen

- Fließend in einer Fremdsprache sprechen lernen: Mehrsprachige Sprachsynthese und sprachübergreifendes Stimmenklonen

- Wenn das Gute zum Bösen wird: Tastendruck-Inferenz mit Smartwatch

- KeyListener: Tastenanschläge auf der QWERTY-Tastatur des Touchscreens durch akustische Signale ableiten

- Diese Stimme existiert nicht: Über Sprachsynthese, Audio-Deepfakes und deren Erkennung

- AudioSep: Trennen Sie alles, was Sie beschreiben.

- Stable-Audio-Tools: Generative Modelle für die bedingte Audiogenerierung.

- GPT-SoVITS-WebUI: 1-Minuten-Sprachdaten können auch zum Trainieren eines guten TTS-Modells verwendet werden! (Einige Stimmen-Klonen).

- Hybrid-Net: Trennung von Audioquellen in Echtzeit, Generieren von Liedtexten, Akkorden und Beats.

- CosyVoice: Mehrsprachiges Modell zur Generierung großer Stimmen, das Full-Stack-Funktionen für Inferenz, Training und Bereitstellung bietet.

- EasyVolcap: Beschleunigung der neuronalen volumetrischen Videoforschung.

? Erkennung?

- Fake-Voice-Detection: Verwendung der zeitlichen Faltung zur Erkennung von Audio-Deepfakes.

- Ein robustes Sprach-Spoofing-Erkennungssystem mit neuartigen CLS-LBP-Funktionen und LSTM

- Voice-Spoofing-Detektor: Ein einheitliches Anti-Spoofing-Framework

- Absicherung sprachgesteuerter Schnittstellen vor gefälschten (geklonten) Audio-Angriffen

- DeepSonar: Auf dem Weg zu einer effektiven und robusten Erkennung KI-synthetisierter gefälschter Stimmen

- KI mit KI bekämpfen: Fake-Speech-Erkennung mittels Deep Learning

- Ein Überblick über moderne Methoden zur Erkennung von Audio-Deepfakes: Herausforderungen und zukünftige Richtungen

? Bild ?

Werkzeuge

- StyleGAN: StyleGAN – Offizielle TensorFlow-Implementierung.

- StyleGAN2: StyleGAN2 – Offizielle TensorFlow-Implementierung.

- stylegan2-ada-pytorch: StyleGAN2-ADA – Offizielle PyTorch-Implementierung.

- StyleGAN-nada: CLIP-gesteuerte Domänenanpassung von Bildgeneratoren.

- StyleGAN3: Offizielle PyTorch-Implementierung von StyleGAN3.

- Imaginaire: Imaginaire ist eine Pytorch-Bibliothek, die die optimierte Implementierung mehrerer bei NVIDIA entwickelter Bild- und Videosynthesemethoden enthält.

- ffhq-dataset: Flickr-Faces-HQ-Datensatz (FFHQ).

- DALLE2-pytorch: Implementierung von DALL-E 2, dem aktualisierten neuronalen Netzwerk für die Text-zu-Bild-Synthese von OpenAI, in Pytorch.

- ImaginAIry: Von der KI imaginierte Bilder. Pythonische Erzeugung stabiler Diffusionsbilder.

- Lama Cleaner: Bild-Inpainting-Tool, unterstützt durch SOTA AI Model. Entfernen Sie alle unerwünschten Objekte, Defekte oder Personen aus Ihren Bildern oder löschen und ersetzen Sie alles auf Ihren Bildern (angetrieben durch stabile Diffusion).

- Invertible-Image-Rescaling: Dies ist die PyTorch-Implementierung von Paper: Invertible Image-Rescaling.

- DifFace: Wiederherstellung des blinden Gesichts mit diffuser Fehlerkontraktion (PyTorch).

- CodeFormer: Auf dem Weg zu einer robusten Wiederherstellung blinder Gesichter mit dem Codebook Lookup Transformer.

- Benutzerdefinierte Diffusion: Multikonzept-Anpassung der Text-zu-Bild-Diffusion.

- Diffusoren: ? Diffusoren: Modernste Diffusionsmodelle für die Bild- und Audioerzeugung in PyTorch.

- Stabile Diffusion: Hochauflösende Bildsynthese mit latenten Diffusionsmodellen.

- InvokeAI: InvokeAI ist eine führende Kreativ-Engine für Stable Diffusion-Modelle, die Profis, Künstler und Enthusiasten in die Lage versetzt, visuelle Medien mithilfe der neuesten KI-gesteuerten Technologien zu generieren und zu erstellen. Die Lösung bietet eine branchenführende WebUI, unterstützt die Terminalnutzung über eine CLI und dient als Grundlage für mehrere kommerzielle Produkte.

- Stable Diffusion-Web-Benutzeroberfläche: Stable Diffusion-Web-Benutzeroberfläche.

- Stable Diffusion Infinity: Outpainting mit Stable Diffusion auf einer unendlichen Leinwand.

- Schnelle stabile Diffusion: Fast-Stable-Diffusion + DreamBooth.

- GET3D: Ein generatives Modell hochwertiger 3D-Texturformen, die aus Bildern gelernt wurden.

- Fantastische KI-Kunst-Bildsynthese: Eine Liste großartiger Tools, Ideen, Prompt-Engineering-Tools, Kooperationen, Modelle und Helfer für den Prompt-Designer, der mit AIArt und Bildsynthese spielt. Deckt Dalle2, MidJourney, StableDiffusion und Open-Source-Tools ab.

- Stabile Diffusion: Ein latentes Text-zu-Bild-Diffusionsmodell.

- Wetterdiffusion: Code für „Wiederherstellung der Sicht bei widrigen Wetterbedingungen mit fleckenbasierten Rauschunterdrückungs-Diffusionsmodellen“.

- DF-GAN: Eine einfache und effektive Basis für die Text-zu-Bild-Synthese.

- Dall-E Playground: Ein Spielplatz zum Generieren von Bildern aus beliebigen Textaufforderungen mithilfe von Stable Diffusion (früher: Verwendung von DALL-E Mini).

- MM-CelebA-HQ-Dataset: Ein umfangreicher Gesichtsbilddatensatz, der die Text-zu-Bild-Generierung, textgesteuerte Bildbearbeitung, Skizze-zu-Bild-Generierung, GANs für die Gesichtsgenerierung und -bearbeitung, Bildunterschrift und VQA ermöglicht.

- Deep Daze: Einfaches Befehlszeilentool für die Text-zu-Bild-Generierung mit OpenAIs CLIP und Siren (Implicit Neural Representation Network).

- StyleMapGAN: Nutzung der räumlichen Dimensionen von Latent in GAN für die Bildbearbeitung in Echtzeit.

- Kandinsky-2: Mehrsprachiges Text-2-Bild-Latent-Diffusionsmodell.

- DragGAN: Interaktive punktbasierte Manipulation der generativen Bildvielfalt.

- Segment Anything: Das Repository bietet Code zum Ausführen von Inferenzen mit dem SegmentAnything Model (SAM), Links zum Herunterladen der trainierten Modellprüfpunkte und Beispielnotizbücher, die zeigen, wie das Modell verwendet wird.

- Segment Anything 2: Das Repository bietet Code zum Ausführen von Inferenzen mit dem Meta Segment Anything Model 2 (SAM 2), Links zum Herunterladen der trainierten Modellprüfpunkte und Beispielnotizbücher, die zeigen, wie das Modell verwendet wird.

- MobileSAM: Dies ist der offizielle Code für das MobileSAM-Projekt, das SAM für mobile Anwendungen und darüber hinaus leicht macht!

- FastSAM: Alles schnell segmentieren

- Infinigen: Unendliche fotorealistische Welten mit prozeduraler Generierung.

- DALL·E 3

- StreamDiffusion: Eine Lösung auf Pipeline-Ebene für die interaktive Generierung in Echtzeit.

- AnyDoor: Zero-Shot-Bildanpassung auf Objektebene.

- DiT: Skalierbare Diffusionsmodelle mit Transformatoren.

- BrushNet: Ein Plug-and-Play-Bild-Inpainting-Modell mit zerlegter Dual-Branch-Diffusion.

- OOTDiffusion: Ausstattung fusionsbasierter latenter Diffusion für kontrollierbares virtuelles Anprobieren.

- VAR: Offizieller Impl. von „Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction“.

- Imagine Flash: Beschleunigung von Emu-Diffusionsmodellen durch Rückwärtsdestillation

Anwendungen

- ArtLine: Ein auf Deep Learning basierendes Projekt zur Erstellung von Strichzeichnungen.

- Depix: Stellt Passwörter aus verpixelten Screenshots wieder her.

- Alte Fotos wieder zum Leben erwecken: Restaurierung alter Fotos (offizielle PyTorch-Implementierung).

- Umschreiben: Interaktives Tool zum direkten Bearbeiten der Regeln eines GAN, um Szenen mit hinzugefügten, entfernten oder geänderten Objekten zu synthetisieren. Ändern Sie StyleGANv2, um extravagante Augenbrauen oder Pferde mit Hüten zu erstellen.

- Fawkes: Tool zum Schutz der Privatsphäre gegen Gesichtserkennungssysteme.

- Pulse: Selbstüberwachtes Foto-Upsampling durch latente Weltraumforschung generativer Modelle.

- HiDT: Offizielles Repository für den Artikel „High-Resolution Daytime Translation Without Domain Labels“.

- 3D-Foto-Inpainting: 3D-Fotografie mit kontextbezogenem, geschichtetem Tiefen-Inpainting.

- SteganoGAN: SteganoGAN ist ein Tool zum Erstellen steganografischer Bilder mithilfe von kontradiktorischem Training.

- Stylegan-T: Erschließung der Leistungsfähigkeit von GANs für eine schnelle Text-zu-Bild-Synthese in großem Maßstab.

- MegaPortraits: One-Shot-Megapixel-Neuralkopf-Avatare.

- eg3d: Effiziente geometriebewusste generative gegnerische 3D-Netzwerke.

- TediGAN: Pytorch-Implementierung für TediGAN: Textgesteuerte Generierung und Manipulation verschiedener Gesichtsbilder.

- DALLE-pytorch: Implementierung/Replikation von DALL-E, dem Text-to-Image-Transformator von OpenAI, in Pytorch.

- StyleNeRF: Dies ist die Open-Source-Implementierung des ICLR2022-Papiers „StyleNeRF: A Style-based 3D-Aware Generator for High-resolution Image Synthesis“.

- DeepSVG: Offizieller Code für den Artikel „DeepSVG: A Hierarchical Generative Network for Vector Graphics Animation“. Enthält eine PyTorch-Bibliothek für Deep Learning mit SVG-Daten.

- NUWA: Eine einheitliche 3D-Transformer-Pipeline für die visuelle Synthese.

- Image-Super-Resolution-via-Iterative-Refinement: Inoffizielle Implementierung von Image Super-Resolution via Iterative Refinement durch Pytorch.

- Lama: ? LaMa Image Inpainting, auflösungsrobustes Inpainting großer Masken mit Fourier-Faltungen.

- Person_reID_baseline_pytorch: Pytorch ReID: Eine kleine, benutzerfreundliche, starke Pytorch-Implementierung der Basislinie zur Neuidentifizierung von Objekten.

- instruct-pix2pix: PyTorch-Implementierung von InstructPix2Pix, einem anweisungsbasierten Bildbearbeitungsmodell.

- GFPGAN: Ziel von GFPGAN ist die Entwicklung praktischer Algorithmen für die Gesichtswiederherstellung in der realen Welt.

- DeepVecFont: Synthese hochwertiger Vektorschriftarten durch Dual-Modality-Lernen.

- Stargan v2 Tensorflow: Offizielle Tensorflow-Implementierung.

- StyleGAN2-Destillation: Die gepaarte Bild-zu-Bild-Übersetzung, die auf von StyleGAN2 generierten synthetischen Daten trainiert wird, übertrifft bestehende Ansätze zur Bildmanipulation.

- Extrahieren von Trainingsdaten aus Diffusionsmodellen

- Mann-E – Mann-E (persisch: مانی) ist ein Kunstgeneratormodell, das auf den Gewichtungen von Stable Diffusion 1.5 und Daten aus künstlerischem Material basiert, das auf Pinterest verfügbar ist

- Durchgehend trainierte CNN-Encoder-Decoder-Netzwerke für die Bildsteganographie

- Grounded-Segment-Anything: Verbindung von Grounding DINO mit Segment Anything & Stable Diffusion & Tag2Text & BLIP & Whisper & ChatBot – Automatische Erkennung, Segmentierung und Generierung von allem mit Bild-, Text- und Audioeingaben.

- AnimateDiff: Animieren Sie Ihre personalisierten Text-zu-Bild-Diffusionsmodelle ohne spezifische Abstimmung.

- BasicSR: Open-Source-Toolbox zur Bild- und Videowiederherstellung für Superauflösung, Rauschunterdrückung, Unschärfe usw. Derzeit umfasst es EDSR, RCAN, SRResNet, SRGAN, ESRGAN, EDVR, BasicVSR, SwinIR, ECBSR usw. Unterstützt auch StyleGAN2 und DFDNet. [](https://github.com/XPixelGroup/ BasicSR)

- Real-ESRGAN: Ziel von Real-ESRGAN ist die Entwicklung praktischer Algorithmen für die allgemeine Bild-/Videowiederherstellung.

- ESRGAN: Erweitertes SRGAN. Champion PIRM Challenge zur perzeptuellen Superauflösung.

- MixNMatch: Multifaktorielle Entflechtung und Kodierung für die bedingte Bilderzeugung.

- Clarity-Upscaler: Neu konzipierte Bild-Upscaling für jedermann.

- Ein-Schritt-Diffusion mit Verteilungsanpassungsdestillation

- Unsichtbarer Stich: Erzeugen Sie glatte 3D -Szenen mit Tiefenlackierung.

- SSR: Einzelansicht-3D-Szene-Rekonstruktion mit Form und Textur mit hoher Quellenstärke.

- Invsr: Belästigte Bild-Superauflösung durch Diffusionsinversion.

? Erkennung?

- Stylegan3-Detector: Stylegan3 Synthetische Bilddetektion.

- Stylegan2-projektierende Images: Projekte auf latente Raum mit Stylegan2 projizieren.

- Faldetektor: Erkennung von Photoshopped -Gesichtern durch Scripting Photoshop.

? Video?

Werkzeuge

- DeepFacelab: DeepFacelab ist die führende Software zum Erstellen von Deepfakes.

- Faceswap: DeepFakes -Software für alle.

- DOT: Das DeepFake Offensive Toolkit.

- SIMSWAP: Ein willkürliches Gesichtswappungs-Framework für Bilder und Videos mit einem einzigen trainierten Modell!

- Faceswap-Gan: Ein Denoising AutoCoder + kontroverse Verluste und Aufmerksamkeitsmechanismen für den Gesichtswechsel.

- Celeb DeepFakeForensics: Ein groß angelegter herausfordernder Datensatz für DeepFake-Forensik.

- VGen: Ein ganzheitliches Ökosystem der Videogenerierung für die Videogenerierung auf Diffusionsmodellen.

- Musev: Infinite Length und High Fidelity Virtual Human Video Generation mit visuell konditioniertem parallelen Denoising.

- Glee: General Object Foundation -Modell für Bilder und Videos im Maßstab.

- T-Rex: Auf dem Weg zur generischen Objekterkennung per Textvisual-Eingabeaufforderung.

- Dynamicrafter: Animieren von Bildern mit Open-Domain mit Videodiffusionspriors.

- Mora: Eher wie Sora für die Generalistin -Videogeneration.

Anwendungen

- Face2face-Demo: PIX2Pix-Demo, die aus den Gesichtsmarken des Gesichts lernt und dies in ein Gesicht übersetzt.

- Faceswap-Deepfake-Pytorch: FaCESWAP mit Pytorch oder Deepfake mit Pytorch.

- Point-E: Punktwolkendiffusion für die 3D-Modellsynthese.

- EGVSR: Effiziente und generische Video-Superauflösung.

- Stit: Stitch It In Time: GaN-basierte Gesichtsbearbeitung von echten Videos.

- Hintergrundmattingv2: Echtzeit hochauflösendes Hintergrundmatting.

- MODNET: Eine trimap-freie Porträt-Mattinglösung in Echtzeit.

- Hintergrundmatting: Hintergrundmatting: Die Welt ist Ihr grüner Bildschirm.

- Modell erster Ordnung: Dieses Repository enthält den Quellcode für das Papier -Bewegungsmodell für die erste Ordnung für die Bildanimation.

- Artikulierte Animation: Dieses Repository enthält den Quellcode für die CVPR'2021 -Papierbewegungsdarstellungen für artikulierte Animation.

- Echtzeit -Personentfernung: Entfernen von Menschen aus komplexen Hintergründen in Echtzeit mit TensorFlow.js im Webbrowser.

- ADAIN-Stil: willkürlicher Stiltransfer in Echtzeit mit adaptiver Instanznormalisierung.

- Rahmeninterpolation: Rahmeninterpolation für große Bewegungen.

- Awesome-Image-Farbbildung: Eine Sammlung von Bildfolben mit tiefem Lernbasis und Video-Farbkolorisierungsarbeiten.

- Sadtalker: Lernen realistische 3D-Bewegungskoeffizienten für stilisierte audiogesteuerte Einzelbild-sprechende Gesichtsanimation.

- Roop: One-Click-Deepfake (Gesichtsaustausch).

- StableVideo: Textgetriebene konsequenzbewusste Diffusionsvideobearbeitung.

- Magicedit: Hochfidelität zeitlich kohärente Videobearbeitung.

- Rerender_a_video: null-shot-textgesteuerte Video-zu-Video-Übersetzung.

- Dreameditor: Textgetriebene 3D-Szene bearbeiten mit neuronalen Feldern.

- Dreameditor: Echtzeit 4D View-Synthese bei 4K-Auflösung.

- Animateanyone: Konsistente und kontrollierbare Bild-zu-Video-Synthese für die Charakteranimation.

- Moore-Animateanyone: Dieses Repository reproduziert Animateanyone.

- Audio2photoreal: Von Audio bis fotorealer Ausführungsform: Menschen in Gesprächen synthetisieren.

- MagicVideo-V2: Multi-Stufe High-ästhetische Videogenerierung

- LWM: Ein allgemeines multimodales autoregressives Modell mit großer Kontext. Es wird auf einem großen Datensatz mit verschiedenen langen Videos und Büchern mit Ringtention geschult und kann Sprache, Bild, Videoverständnis und -generation ausführen.

- Aniportrait: Audiogetriebene Synthese der fotorealistischen Porträtanimation.

- Champ: Steuerbare und konsistente menschliche Bildanimation mit parametrischer 3D -Anleitung.

- Streamv2v: Streaming von Video-zu-Video-Übersetzung mit Feature-Banken.

- Deep-Live-CAM: Echtzeit-Gesichts-Swap und One-Click-Video DeepFake mit nur einem einzigen Bild.

- Sapiens: Grundlage für menschliche Sehmodelle.

? Erkennung?

- FaceForensics ++: FaceForenensics -Datensatz.

- DeepFake-Detektion: In Richtung DeepFake-Erkennung, die tatsächlich funktioniert.

- fakevideoforensics: Deep Fakes -Videos erkennen.

- DeepFake-Detektion: Das Pytorch-Implemention der Deepfake-Erkennung basierend auf FaceForensics ++.

- SEQDEEPFAKE: Pytorch -Code für seqdeepfake: Erkennung und Wiederherstellung der sequentiellen Deepfake -Manipulation.

- PCL-I2G: Inoffizielle Implementierung: Lernen selbstkonsistenz zur Deepfake-Erkennung.

- DFDC DeepFake Challenge: Eine preisgewinnende Lösung für die DFDC Challenge.

- Poi-Forensik: Audio-visuelle Person der Interessen-Interessen-Deepfake-Erkennung.

- Standardisierung der Erkennung von DeepFakes: Warum Experten sagen, dass es wichtig ist

- Möchten Sie ein Deepfake erkennen? Suchen Sie nach den Sternen in ihren Augen

? Text?

Werkzeuge

- GLM-130B: Ein offenes zweisprachiges vorgebildetes Modell.

- LongFodeChatexternalSources: GPT-3-Chatbot mit Langzeitgedächtnis und externen Quellen.

- Skizze: AI-Code-Schreibassistent, der den Dateninhalt versteht.

- Langchain: ⚡ Gebäudeanwendungen mit LLMs durch Kompositionsfähigkeit ⚡.

- CHATGPT WRAPPER: API für die Interaktion mit Chatgpt mit Python und von Shell.

- OpenAI-Python: Die OpenAI-Python-Bibliothek bietet einen bequemen Zugang zur OpenAI-API aus Bewerbungen in der Python-Sprache.

- Beto: Spanische Version des Bert -Modells.

- GPT-Code-Clippy: GPT-Code-Clippy (GPT-CC) ist eine Open-Source-Version von Github Copilot, einem Sprachmodell-basierend auf GPT-3, genannt GPT-CODEX.

- GPT NEO: Eine Implementierung des Modells Parallele Modelle des Modells GPT-2 und GPT-3 im Stil der Mesh-Tensorflow-Bibliothek.

- STRG: Konditionales Transformatorsprachmodell für die steuerbare Generation.

- Lama: Inferenzcode für Lama -Modelle.

- LAMA22

- Lama Guard 3

- UL2 20B: Ein einheitlicher Open -Source -Lerner der Sprache

- BIRGPT: Eine Burp Suite-Erweiterung, die OpenAIs GPT integriert, um einen zusätzlichen passiven Scan zur Entdeckung von stark maßgeschneiderten Schwachstellen durchzuführen, und ermöglicht die Ausführung der verkehrsbasierten Analyse jeglicher Art.

- OLLAMA: Steigen Sie mit Lama 2 und anderen großen Sprachmodellen vor Ort auf.

- SneakyPrompt: Jailbreak-Text-to-Image-Generativmodelle.

- Copilot-for Security: Eine generative Sicherheitslösung von KI-angetrieben, die die Effizienz und Fähigkeiten von Verteidigern erhöht, um die Sicherheitsergebnisse bei Maschinengeschwindigkeit und -skala zu verbessern und gleichzeitig den verantwortungsvollen AI-Prinzipien zu entsprechen.

- LM Studio: Lokale LLMs entdecken, herunterladen und ausführen

- BYSPASS GPT: KI-Text in menschlichen Inhalt konvertieren

- MGM: Das Framework unterstützt eine Reihe dichter und MOE großer Sprachmodelle (LLMs) von 2B bis 34B mit Bildverständnis, Argumentation und Generation gleichzeitig.

- Secret LLAMA: Voll private LLM -Chatbot, das ausschließlich mit einem Browser ohne Server ausgeführt wird. Unterstützt Mistral und Lama 3.

- LLAMA3: Die offizielle Meta Lama 3 Github Site.

? Erkennung?

- Erkennen von gefälschtem Text: Riesensprachmodell -Testraum.

- Grover: Code für die Verteidigung gegen neuronale gefälschte Nachrichten.

- Rebuff.AI: Einheitlicher Injektionsdetektor.

- Neuer KI-Klassifizierer für die Anzeige von KI-geschriebenen Text

- Entdecken Sie die 4 magischen Methoden zum Erkennen von AI-generierten Text (einschließlich ChatGPT)

- Gptzero

- KI -Inhaltsdetektor (Beta)

- Ein Wasserzeichen für große Sprachmodelle

- Kann AI-generierter Text zuverlässig erkannt werden?

- GPT-Detektoren sind gegen nicht einheimische englische Schriftsteller voreingenommen

- Zu Chatgpt oder nicht zu Chatgpt: Das ist die Frage!

- Können Linguisten zwischen Chatgpt/KI und menschlichem Schreiben unterscheiden ?: Eine Studie über Forschungsethik und akademisches Publizieren

- Chatgpt ist Bullshit

Anwendungen

- Handschreiber: Handschrift erzeugt eine benutzerdefinierte Schriftart basierend auf Ihrem Handschrift -Beispiel.

- GPT Sandbox: Ziel dieses Projekts ist es, dass Benutzer coole Webdemos mit der neu veröffentlichten OpenAI GPT-3-API mit nur wenigen Python-Zeilen erstellen können.

- PASSGAN: Ein Deep -Learning -Ansatz für das Erraten von Passwort.

- GPT -Index: GPT -Index ist ein Projekt, das aus einer Reihe von Datenstrukturen besteht, die die Verwendung großer externer Wissensbasis mit LLMs erleichtern.

- Nanogpt: Das einfachste und schnellste Repository für Trainings-/Fülle mittelgroße GPTs.

- WhatsApp-GPT

- Chatgpt Chrome -Erweiterung: Eine Chatgpt -Chrome -Erweiterung. Integriert ChatGPT in jedes Textfeld im Internet.

- UNILM: groß angelegte selbstüberwachende Vorausbildung über Aufgaben, Sprachen und Modalitäten.

- Mingpt: Eine minimale Pytorch-Neuauflagen des OpenAI-GPT-Trainings (Generative Pretrained Transformator).

- Codegeex: Ein offenes mehrsprachiges Codegenerierungsmodell.

- OpenAI -Kochbuch: Beispiele und Anleitungen zur Verwendung der OpenAI -API.

- ? Fantastische Chatgpt -Eingabeaufforderungen: Dieses Repo enthält Chatgpt -Eingabeaufforderung, um Chatgpt besser zu verwenden.

- Alice: Chatgpt -Zugriff auf ein echtes Terminal.

- Überprüfung des Sicherheitscode mit ChatGPT

- Schreiben Benutzer mit AI -Assistenten unsicherer Code?

- Umgang mit den Spam -Filtern von Google Mail mit ChatGPT

- Wiederkehrender Gans -Passwort -Cracker für IoT -Kennwortsicherheitsverbesserung

- PentESTGPT: Ein GPT-ausgearbeitetes Penetrationstest-Tool.

- GPT -Forscher: GPT -basierter autonomer Agent, der eine umfassende Forschung zu einem bestimmten Thema durchführt.

- GPT -Ingenieur: Geben Sie an, was Sie erstellen sollen, die KI fordert die Klärung und baut sie dann auf.

- LOCALPILOT: Verwenden Sie Github Copilot lokal auf Ihrem MacBook mit One-Click!

- [WORMGPT]) (https://thehackernews.com/2023/07/WORMGPT-NEW-AI-TOOL-ALWOWS.HTML): Neues KI-Tool ermöglicht es Cybercriminalen, anspruchsvolle Cyber-Angriffe zu starten

- Poisongpt: Wie wir einen lobotomisierten LLM auf Umarmung versteckten, um gefälschte Nachrichten zu verbreiten

- PASSGPT: Kennwortmodellierung und (geführte) Generation mit großen Sprachmodellen

- Deeppass - Passwörter mit tiefem Lernen finden

- GPTFUZZ: RED-Teaming Großsprachenmodelle mit automatisch generierten Jailbreak-Eingabeaufforderungen.

- Open Interpreter: OpenAIs Code -Dolmetscher in Ihrem Terminal, das lokal ausgeführt wird.

- Eureka: Belohnungsdesign auf Menschenebene durch Codierung großer Sprachmodelle.

- MetaClip: entmystifizierende Clipdaten.

- LLM OSINT: Proof-of-Concept-Methode zur Verwendung von LLMs zum Sammeln von Informationen aus dem Internet und dann eine Aufgabe mit diesen Informationen.

- Hackingbuddygpt: LLMS X Pentesting.

- Chatgpt-Jailbreaks: Offizieller Jailbreak für Chatgpt (GPT-3.5). Senden Sie zu Beginn des Gesprächs eine lange Nachricht mit ChatGPT, um offensiv, unethisch, aggressiv und menschlich auf Englisch und Italienisch zu antworten.

- MAGIKA: Dateiinhaltstypen mit tiefem Lernen erkennen.

- Jan: Eine Open -Source -Alternative zu Chatgpt, die auf Ihrem Computer 100% offline ausführt.

- Librechat: Enhanced Chatgpt Clone: Features OpenAI, Assistants API, Azure, Groq, GPT-4 Vision, Mistral, Bing, Anthropic, OpenRouter, Vertex AI, Gemini, AI-Modellschalter, Nachrichtensuche, Langchain, Dall-E-3, Chatgpt Plugins, OpenAI-Funktionen, sicheres Multi-User-System, Voreinstellungen, vollständig offene Source für Selbsthosting.

- Lumina-T2X: Ein einheitliches Framework für Text für jede Modalitätserzeugung.

Sonstiges

- Awesome GPT + Security: Eine kuratierte Liste großartiger Sicherheitstools, experimenteller Fall oder andere interessante Dinge mit LLM oder GPT.

- Fantastisches Verstärkungslernen für die Cybersicherheit: Eine kuratierte Liste von Ressourcen, die sich der Verstärkungslernen für die Cybersicherheit widmen.

- Fantastisches maschinelles Lernen für Cybersicherheit: Eine kuratierte Liste von erstaunlich fantastischen Tools und Ressourcen im Zusammenhang mit der Verwendung von maschinellem Lernen für Cybersicherheit.

- Umarmende Gesichtsdiffusionsmodelle Kurs: Materialien für den Kurs für umarmende Gesichtsdiffusionsmodelle.

- Awesome-AI-Sicherheit: Eine kuratierte Liste der KI-Sicherheitsressourcen.

- ML für Hacker: Code, das das Buch "Machine Learning for Hackern" begleitet.

- Achful KI: Die schreckliche KI ist eine kuratierte Liste, um die aktuellen gruseligen Verwendungen der KI zu verfolgen - in der Hoffnung, das Bewusstsein zu schärfen.

- NIST AI Risk Management Framework Playbook

- SOK: Erklärbares maschinelles Lernen für Computersicherheitsanwendungen

- Wer bewertet die Evaluatoren? Über automatische Metriken zur Bewertung der AI-basierten Offensivcodegeneratoren

- Schwachstellenpriorisierung: Ein offensiver Sicherheitsansatz

- MITRE ATLAS ™ (Konvershe-Bedrohungslandschaft für künstliche Intelligenzsysteme)

- Eine Umfrage zum Verstärkungslernen von Sicherheit mit Anwendung auf autonomes Fahren

- So vermeiden Sie Fallstricke für maschinelles Lernen: Ein Leitfaden für akademische Forscher

- Eine kuratierte Liste der AI -Sicherheits- und Datenschutzveranstaltungen

- NIST AI 100-2 E2023: Konverselles maschinelles Lernen. Eine Taxonomie und Terminologie von Angriffen und Minderungen.

- ?? Roottecon 2023 - InteligiNcia Künstliche Ofsiva - ¿Cómo Podemos Estar Preparados?

- Sicherheit von AI -Systemen: Grundlagen - kontroveres Deep -Lernen

- Über die Schutzmaßnahmen hinaus: Erforschung der Sicherheitsrisiken von ChatGPT

- Die AI -Angriffsoberfläche Karte v1.0

- Auf der unmöglichen Sicherheit großer KI -Modelle

- Frontier AI -Verordnung: Verwaltung neu auftretender Risiken für die öffentliche Sicherheit

- Mehrschichtgerüst für gute Cybersicherheitspraktiken für KI

- Einführung des sicheren KI -Frameworks von Google

- Owasp top 10 für llm

- Awesome LLM Security: Eine Kuration von großartigen Tools, Dokumenten und Projekten zur LLM -Sicherheit.

- Ein Rahmen, um LLMs in Unternehmen sicher zu verwenden. Teil 1: Überblick über Risiken. Teil 2: Risiko verwalten. Teil 3: Sicherung von Chatgpt und Github Copilot.

- Eine Studie über Robustheit und Zuverlässigkeit der Erzeugung des Models der großartigen Modellcode

- Identifizierung von AI-generierten Bildern mit Synthid

- Auditing großer Sprachmodelle: Ein dreischichtiger Ansatz

- Lösung der Schlacht von Kurz- und langfristigem KI -Risiko

- Betrugsgpta: Der Bösewicht Avatar von Chatgpt

- KI -Risiken - Schneier auf Sicherheit

- Verwendung von LLMs für illegale Zwecke: Bedrohungen, Präventionsmaßnahmen und Schwachstellen

- AI-Rotteaming ist keine One-Stop-Lösung für KI-Schäden: Empfehlungen zur Verwendung von Rotteams für die AI-Rechenschaftspflicht

- Eine Taxonomie der Vertrauenswürdigkeit für künstliche Intelligenz

- Verwaltung von KI -Risiken in einer Zeit schneller Fortschritte

- Google - Wirken Sie sich auf unser Engagement für eine sichere KI ein

- Offensives ML Playbook

- Entmystifizierende generative KI? Notizen eines Sicherheitsforschers

- Genai-Security-Adventures: Eine Open-Source-Initiative zum Teilen von Notizen, Präsentationen und einer vielfältigen Sammlung von Experimenten, die in Jupyter-Notizbüchern vorgestellt werden, die Ihnen dabei helfen, die wesentlichen Konzepte hinter Großsprachenmodellen zu erfassen und die faszinierende Abschnitte von Sicherheit und Natur zu erforschen Sprachverarbeitung.

- AI Safety Camp verbindet Sie mit einer Forschung, die dazu führt, dass Sie an einem Projekt zusammenarbeiten - um festzustellen, wo Ihre Arbeit dazu beitragen kann, dass die zukünftige KI sicher ist.

- Richtlinien für die sichere Entwicklung des KI -Systems

- Ansatz zur künstlichen Intelligenz und Cybersicherheit. Best Practice Report

- Stanford sicher, sicher und vertrauenswürdiger AI EO 14110 Tracker

- Awesome ML Security: Eine kuratierte Liste der Sicherheitserlernungssicherheit, Anleitung, Tools und vieles mehr.

- AIs vorhersehbarer Weg: 7 Dinge, die von AI über 2024+ erwartet werden müssen

- Künstliche Intelligenz und Cybersicherheit (auf Spanisch?)

- Mahnwache: Erkennen Sie schnelle Injektionen, Jailbreaks und andere potenziell riskante Großsprachenmodelleingaben (LLM).

- Generative KI -Modelle - Chancen und Risiken für Industrie und Behörden

- Bereitstellung von KI -Systemen sicher. Best Practices für die Bereitstellung sicherer und belastbarer KI -Systeme

- NIST AI 600-1: Risikomanagement Rahmen für künstliche Intelligenz: generative künstliche Intelligenzprofil

- ?? ANSSI: Empfehlungen de Sécurité pour un système d'Ia générative (Sicherheitsempfehlungen für ein generatives KI -System)

- Pyrit: Das Python-Risiko-Identifizierungsinstrument für generative KI (Pyrit) ist ein Open-Access-Automatisierungsrahmen, um Sicherheitsexperten und maschinelles Lerningenieuren zu stärken, um proaktiv Risiken in ihren generativen KI-Systemen zu finden.

- OWASP-Agentic-AI: Arbeiten, um die OWASP Top 10 für Agentic AI (AI Agent Security) zu erstellen.

- In Richtung garantierter sicherer KI: Ein Rahmen zur Gewährleistung von robusten und zuverlässigen KI -Systemen

- Definieren von echten KI -Risiken

- Sicherer Ansatz zur generativen KI

- Großsprachenmodelle in Cybersicherheit

- Hey, das ist mein Modell! Einführung in Chain & Hash, eine LLM -Fingerabdrucktechnik

- Generative KI-Missbrauch: Eine Taxonomie von Taktiken und Erkenntnissen aus realen Daten

- KI -Risiko -Repository

- Wiederholung von AI Red-Teaming

- Deutsch-französische Empfehlungen für den Einsatz von AI-Programmierassistenten

- Skalierbares Wasserzeichen zur Identifizierung großer Sprachmodellausgaben

Umfragen

- Die Gefahr einer Offensiv -KI für Organisationen

- Künstliche Intelligenz in der Cyber -Domäne: Straftat und Verteidigung

- Eine Umfrage zu kontroversen Angriffen und Verteidigung

- Gegentliches Deep Learning: Eine Umfrage zu kontroversen Angriffen und Verteidigungsmechanismen zur Bildklassifizierung

- Eine Übersicht über Datenschutzangriffe im maschinellen Lernen

- Auf dem Weg zu Sicherheitsbedrohungen von Deep -Lern -Systemen: Eine Umfrage

- Eine Umfrage zu Sicherheitsbedrohungen und Defensivtechniken des maschinellen Lernens: Eine datengetriebene Ansicht

- Sok: Sicherheit und Privatsphäre im maschinellen Lernen

- Erwidertes maschinelles Lernen: Der Anstieg der AI-fähigen Kriminalität und seine Rolle bei der Ausweichen des Spam-Filters

- Bedrohungen, Schwachstellen und Kontrollen von Systemen für maschinelles Lernen: Eine Umfrage und Taxonomie

- Gegentliche Angriffe und Verteidigung: Eine Umfrage

- Sicherheitsangelegenheiten: Eine Umfrage zum kontroversen maschinellen Lernen

- Eine Umfrage zu kontroversen Angriffen für die Malwareanalyse

- Gegentes maschinelles Lernen in der Bildklassifizierung: Eine Umfrage zur Perspektive des Verteidigers

- Eine Übersicht über robustes kontroverses Training in der Mustererkennung: Grundlegende, Theorie und Methoden

- Privatsphäre in Großsprachmodellen: Angriffe, Verteidigung und zukünftige Anweisungen

? Betreuer?

Miguel Hernández |

José Ignacio Escricano |

© euen Lizenz © euen

- Creative Commons Attribution-Share gleich 4.0 International