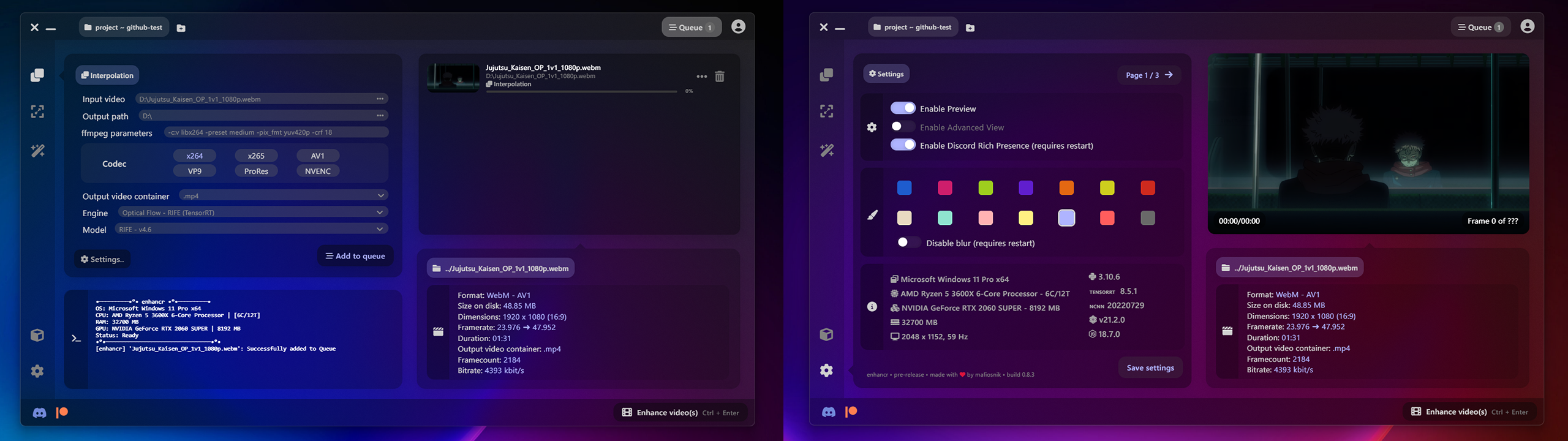

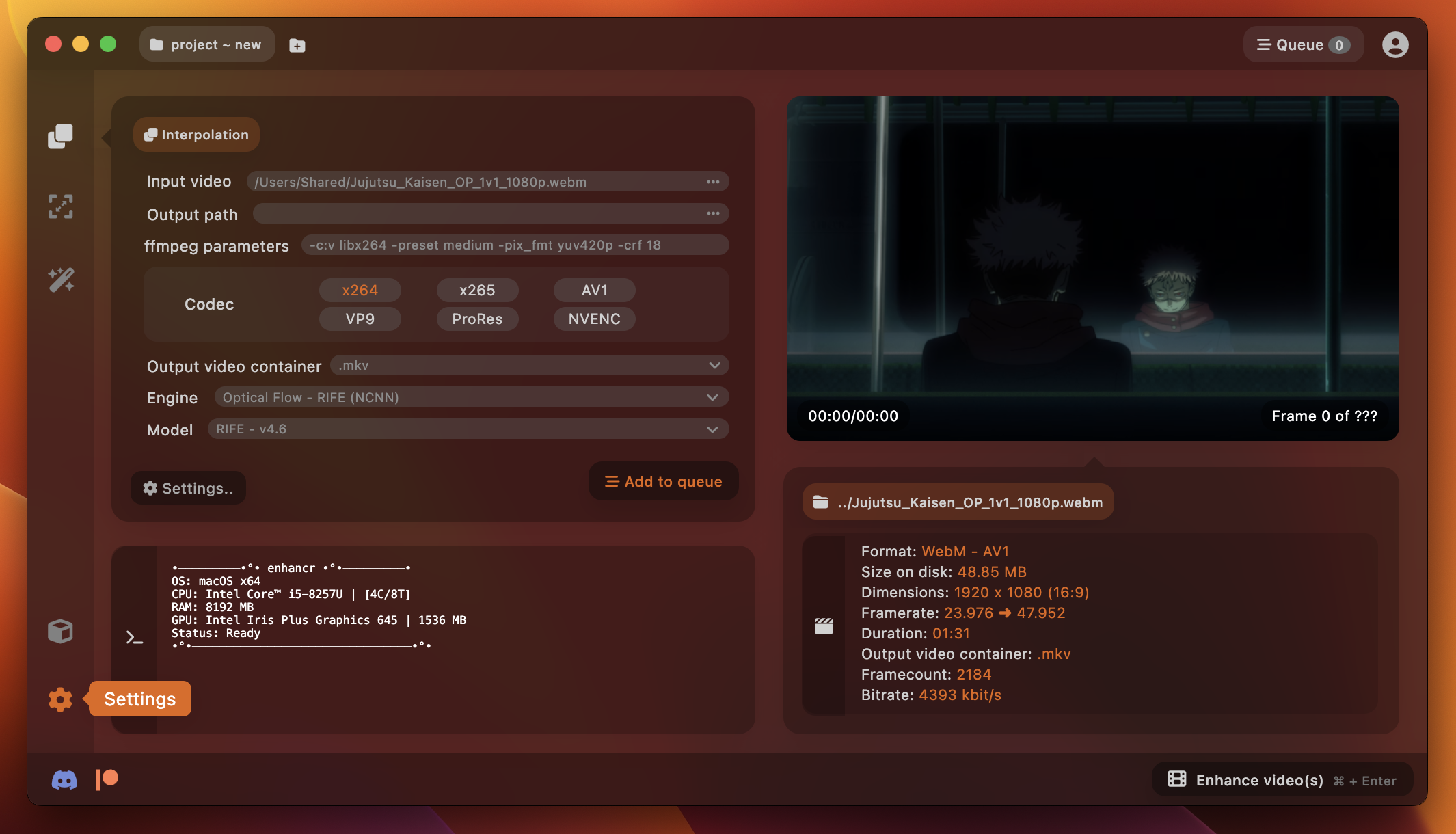

enhancr ist eine elegante und benutzerfreundliche GUI für Video-Frame-Interpolation und Video-Upscaling, die künstliche Intelligenz nutzt – erstellt mit node.js und Electron . Es wurde entwickelt , um das Benutzererlebnis für alle zu verbessern, die an der Verbesserung von Videomaterial mithilfe künstlicher Intelligenz interessiert sind. Die GUI wurde entwickelt, um ein atemberaubendes Erlebnis zu bieten, das auf modernsten Technologien basiert, ohne sich im Gegensatz zu anderen Alternativen klobig und veraltet zu fühlen .

Es verfügt über eine blitzschnelle TensorRT- Inferenz von NVIDIA, die KI-Prozesse erheblich beschleunigen kann. Vorgefertigt, ohne dass Docker oder WSL (Windows Subsystem für Linux) installiert werden müssen – und NCNN- Inferenz von Tencent, die leichtgewichtig ist und auf NVIDIA , AMD und sogar Apple Silicon läuft – im Gegensatz zum Mammut einer Inferenz, die PyTorch ist Läuft nur auf NVIDIA-GPUs .

Gibt es in Release 0.9.9 eine kostenlose Version? https://dl.enhancr.app/setup/enhancr-setup-free-0.9.9.exe

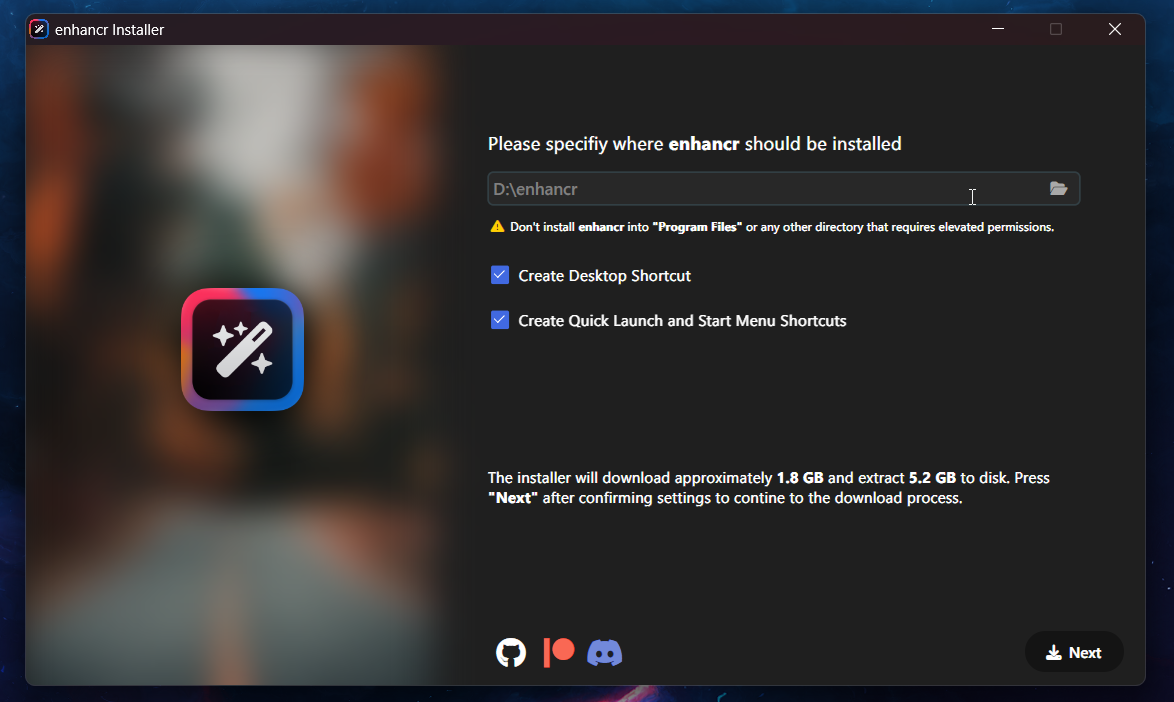

Um sicherzustellen, dass Sie über die aktuellste Version der Software und alle erforderlichen Abhängigkeiten verfügen, empfehlen wir, das Installationsprogramm von Patreon herunterzuladen. Bitte beachten Sie, dass über dieses Repository keine Builds und eine einbettbare Python-Umgebung für die Pro -Version bereitgestellt werden.

RIFE (NCNN) – megvii-research/ ECCV2022-RIFE – powered by styler00dollar/ VapourSynth-RIFE-NCNN-Vulkan

RIFE (TensorRT) – megvii-research/ ECCV2022-RIFE – powered by AmusementClub/ vs-mlrt & styler00dollar/ VSGAN-tensorrt-docker

GMFSS – Union (PyTorch/TensorRT) – 98mxr/ GMFSS_Union – unterstützt von HolyWu/ vs-gmfss_union

GMFSS – Fortuna (PyTorch/TensorRT) – 98mxr/ GMFSS_Fortuna – unterstützt von HolyWu/ vs-gmfss_fortuna

CAIN (NCNN) – myungsub/ CAIN – powered by mafiosnik/ vsynth-cain-NCNN-vulkan (unveröffentlicht)

CAIN (DirectML) – myungsub/ CAIN – powered by AmusementClub/ vs-mlrt

CAIN (TensorRT) – myungsub/ CAIN – bereitgestellt von HubertSotnowski/ cain-TensorRT

ShuffleCUGAN (NCNN) – styler00dollar/ VSGAN-tensorrt-docker – powered by AmusementClub/ vs-mlrt

ShuffleCUGAN (TensorRT) – styler00dollar/ VSGAN-tensorrt-docker – powered by AmusementClub/ vs-mlrt

RealESRGAN (NCNN) – xinntao/ Real-ESRGAN – powered by AmusementClub/ vs-mlrt

RealESRGAN (DirectML) – xinntao/ Real-ESRGAN – powered by AmusementClub/ vs-mlrt

RealESRGAN (TensorRT) – xinntao/ Real-ESRGAN – powered by AmusementClub/ vs-mlrt

RealCUGAN (TensorRT) – bilibili/ ailab/Real-CUGAN – powered by AmusementClub/ vs-mlrt

SwinIR (TensorRT) – JingyunLiang/ SwinIR – powered by mafiosnik777/ SwinIR-TensorRT (unveröffentlicht)

DPIR (DirectML) – cszn/ DPIR – bereitgestellt von AmusementClub/ vs-mlrt

DPIR (TensorRT) – cszn/ DPIR – unterstützt von AmusementClub/ vs-mlrt

SCUNet (TensorRT) – cszn/ SCUNet – powered by mafiosnik777/ SCUNet-TensorRT (unveröffentlicht)

Randbemerkung: Ab TensorRT 8.6 wurde die Unterstützung für Kepler und Maxwell der 2. Generation (Serie 900 und darunter) eingestellt. Sie benötigen mindestens eine Pascal-GPU (Serie 1000 und höher) und CUDA 12.0 + Treiberversion >= 525.xx, um Inferenz mit TensorRT auszuführen.

Die GUI wurde unter Berücksichtigung der plattformübergreifenden Kompatibilität erstellt und ist mit beiden Betriebssystemen kompatibel. Derzeit liegt unser Hauptaugenmerk darauf, eine stabile und voll funktionsfähige Lösung für Windows-Benutzer sicherzustellen. Mit dem Update 1.0 wird jedoch auch Unterstützung für Linux und macOS verfügbar sein.

Auch die Unterstützung von Apple Silicon ist geplant, Allerdings habe ich derzeit nur ein Intel Macbook Pro zum Testen zur Verfügung Ich werde mir rechtzeitig zur Veröffentlichung von Version 1.0 eine Apple Silicon-Instanz auf Amazon AWS besorgen, um dies zu implementieren.

Eingabegröße: 1920 x 1080 bei 2x

| RTX 2060S 1 | RTX 3070 2 | RTX A4000 3 | RTX 3090 Ti 4 | RTX 4090 5 | |

|---|---|---|---|---|---|

| RIFE / rife-v4.6 (NCNN) | 53,78 fps | 64,08 fps | 80,56 fps | 86,24 fps | 136,13 fps |

| RIFE / rife-v4.6 (TensorRT) | 70,34 fps | 94,63 fps | 86,47 fps | 122,68 fps | 170,91 fps |

| CAIN / cvp-v6 (NCNN) | 9,42 fps | 10,56 fps | 13,42 fps | 17,36 fps | 44,87 fps |

| CAIN / cvp-v6 (TensorRT) | 45,41 fps | 63,84 fps | 81,23 fps | 112,87 fps | 183,46 fps |

| GMFSS / Up (PyTorch) | - | - | 4,32 fps | - | 16,35 fps |

| GMFSS / Union (PyTorch) | - | - | 3,68 fps | - | 13,93 fps |

| GMFSS / Union (TensorRT) | - | - | 6,79 fps | - | - |

| RealESRGAN / animevideov3 (TensorRT) | 7,64 fps | 9,10 fps | 8,49 fps | 18,66 fps | 38,67 fps |

| RealCUGAN (TensorRT) | - | - | 5,96 fps | - | - |

| SwinIR (PyTorch) | - | - | 0,43 fps | - | - |

| DPIR / Denoise (TensorRT) | 4,38 fps | 6,45 fps | 5,39 fps | 11,64 fps | 27,41 fps |

1 Ryzen 5 3600X – Gainward RTX 2060 Super @ Stock

2 Ryzen 7 3800X – Gigabyte RTX 3070 Eagle OC @ Stock

3 Ryzen 5 3600X – PNY RTX A4000 @ Stock

4 i9 12900KF – ASUS RTX 3090 Ti Strix OC bei ~2220 MHz

5 Ryzen 9 5950X – ASUS RTX 4090 Strix OC – bei ~3100 MHz mit Kurve zur Erzielung maximaler Leistung

Dieser Abschnitt wurde in das Wiki verschoben: https://github.com/mafiosnik777/enhancr/wiki

Erfahren Sie mehr darüber, wie Sie enhancr optimal nutzen oder wie Sie verschiedene Probleme beheben können.

TensorRT ist eine hochoptimierte KI-Inferenzlaufzeit für NVIDIA-GPUs. Es verwendet Benchmarking, um den optimalen Kernel für Ihre spezifische GPU zu finden, und es gibt einen zusätzlichen Schritt, um eine Engine auf der Maschine zu erstellen, auf der Sie die KI ausführen möchten. Allerdings ist die resultierende Leistung in der Regel auch viel besser als bei jeder PyTorch- oder NCNN-Implementierung.

NCNN ist ein leistungsstarkes Inferenz-Computing-Framework für neuronale Netze, das für mobile Plattformen optimiert ist. NCNN hat keine Abhängigkeiten von Dritten. Es ist plattformübergreifend und läuft auf den meisten großen Plattformen schneller als alle bekannten Open-Source-Frameworks. Es unterstützt NVIDIA, AMD, Intel Graphics und sogar Apple Silicon. NCNN wird derzeit in vielen Tencent-Anwendungen wie QQ, Qzone, WeChat, Pitu usw. verwendet.

Ich wäre Ihnen dankbar, wenn Sie Ihre Unterstützung für dieses Projekt durch einen Beitrag auf Patreon oder durch eine Spende auf PayPal zeigen könnten. Ihre Unterstützung wird dazu beitragen, die Entwicklung zu beschleunigen und weitere Updates für das Projekt bereitzustellen. Darüber hinaus können Sie, wenn Sie über die entsprechenden Fähigkeiten verfügen, auch einen Beitrag leisten, indem Sie eine Pull-Anfrage öffnen. Unabhängig davon, für welche Form der Unterstützung Sie sich entscheiden, seien Sie sich darüber im Klaren, dass diese sehr geschätzt wird.

Ich arbeite kontinuierlich an der Verbesserung der Codebasis, einschließlich der Behebung etwaiger Inkonsistenzen, die aus Zeitgründen entstanden sein könnten. Es werden regelmäßig Updates veröffentlicht, darunter neue Funktionen, Fehlerbehebungen und die Integration neuer Technologien und Modelle, sobald diese verfügbar sind. Vielen Dank für Ihr Verständnis und Ihre Unterstützung.

Unser Player ist für das OSC auf mpv und ModernX angewiesen.

Vielen Dank an HubertSontowski und styler00dollar für die Unterstützung bei der Implementierung von CAIN.

Um mit der Community zu interagieren, Ihre Ergebnisse zu teilen oder Hilfe bei Problemen zu erhalten, besuchen Sie unseren Discord. Dort werden auch Vorschauen auf kommende Versionen gezeigt.