Dies ist der Code für das Papier

Evaluierung tiefer neuronaler Netze für Verkehrszeichenerkennungssysteme

Álvaro Arcos-García, Juan Antonio Álvarez-García, Luis M. Soria-Morillo

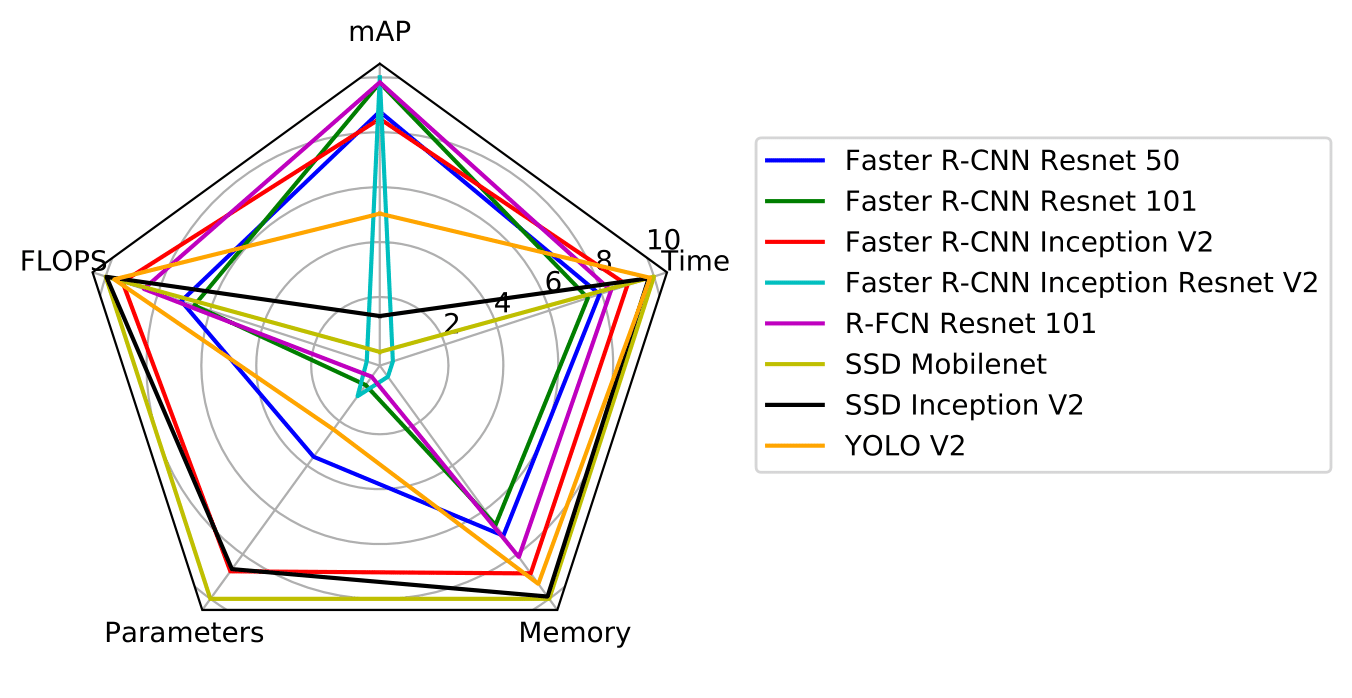

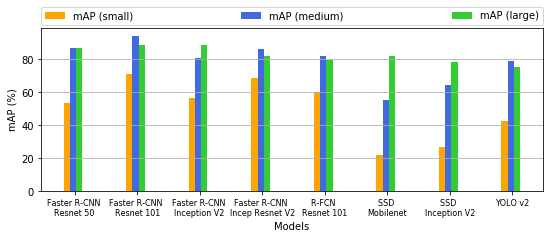

Das Papier befasst sich mit dem Problem der Verkehrszeichenerkennung und analysiert den Stand der Technik mehrerer Objekterkennungssysteme (Faster R-CNN, R-FCN, SSD und YOLO V2) in Kombination mit verschiedenen Merkmalsextraktoren (Resnet V1 50, Resnet V1 101, Inception V2, Inception Resnet V2, Mobilenet V1 und Darknet-19). Unser Ziel ist es, die Eigenschaften dieser Objekterkennungsmodelle zu untersuchen, die durch Transferlernen modifiziert und speziell an die Problemdomäne der Verkehrszeichenerkennung angepasst werden. Insbesondere werden verschiedene öffentlich verfügbare Objekterkennungsmodelle, die vorab auf dem COCO-Datensatz von Microsoft trainiert wurden, auf den deutschen Benchmark-Datensatz zur Verkehrszeichenerkennung abgestimmt. Die Bewertung und der Vergleich dieser Modelle umfassen Schlüsselmetriken wie die mittlere durchschnittliche Präzision (mAP), die Speicherzuweisung, die Laufzeit, die Anzahl der Gleitkommaoperationen, die Anzahl der Parameter des Modells und die Auswirkung der Bildgrößen von Verkehrszeichen.

Wir bieten:

Wenn Sie diesen Code für Ihre Recherche nützlich finden, geben Sie bitte Folgendes an:

"Evaluation of deep neural networks for traffic sign detection systems."

Álvaro Arcos-García, Juan A. Álvarez-García, Luis M. Soria-Morillo. Neurocomputing 316 (2018) 332-344.

[Link][bibtex]

Dieses Projekt ist in Tensorflow implementiert und basiert auf zwei Repositories: Tensorflow Object Detection API und Darkflow.

Sie können TFRecords des GTSDB-Datensatzes von Google Drive herunterladen. Entpacken Sie es in den Ordner gtsdb_data . Sie können vorab trainierte Modelle von Google Drive herunterladen. Entpacken Sie sie in den models .

Unsere Ergebnisse zeigen, dass Faster R-CNN Inception Resnet V2 den besten mAP erzielt, während R-FCN Resnet 101 den besten Kompromiss zwischen Genauigkeit und Ausführungszeit erzielt. YOLO V2 und SSD Mobilenet verdienen eine besondere Erwähnung, da Ersterer wettbewerbsfähige Genauigkeitsergebnisse erzielt und der zweitschnellste Detektor ist, während Letzterer das schnellste und leichteste Modell im Hinblick auf den Speicherverbrauch ist, was ihn zu einer optimalen Wahl für den Einsatz in macht mobile und eingebettete Geräte.

| Modell | Karte | Parameter | Flops | speicher_mb | total_exec_millis | accelerator_exec_millis | cpu_exec_millis |

|---|---|---|---|---|---|---|---|

| Schnelleres R-CNN Resnet 50 | 91,52 | 43337242 | 533575386662 | 5256.454615 | 104.0363553 | 75.93395395 | 28.10240132 |

| Schnelleres R-CNN Resnet 101 | 95.08 | 62381593 | 625779295782 | 6134.705805 | 123.2729175 | 90.33714433 | 32.9357732 |

| Schnelleres R-CNN Inception V2 | 90,62 | 12891249 | 120621363525 | 2175.206857 | 58.53338971 | 38.76813971 | 19.76525 |

| Schnelleres R-CNN Inception Resnet V2 | 95,77 | 59412281 | 1837544257834 | 18250.446008 | 442.2206796 | 366.1586796 | 76062 |

| R-FCN Resnet 101 | 95,15 | 64594585 | 269898731281 | 3509.75153 | 85.45207971 | 52.40321739 | 33.04886232 |

| SSD Mobilenet | 61,64 | 5572809 | 2300721483 | 94.696119 | 15.14525 | 4.021267857 | 11.12398214 |

| SSD Inception V2 | 66.10 | 13474849 | 7594247747 | 284.512918 | 23.74428378 | 9.393405405 | 14.35087838 |

| YOLO V2 | 78,83 | 50588958 | 62780021160 | 1318.108256 | 21.4810122 | 18.13923171 | 3.341780488 |

| Modell | klein | Medium | groß |

|---|---|---|---|

| Schnelleres R-CNN Resnet 50 | 53,57 | 86,95 | 86,72 |

| Schnelleres R-CNN Resnet 101 | 70,89 | 94,17 | 88,87 |

| Schnelleres R-CNN Inception V2 | 56,72 | 81.02 | 88,53 |

| Schnelleres R-CNN Inception Resnet V2 | 68,60 | 86,62 | 82.10 |

| R-FCN Resnet 101 | 60,37 | 82.03 | 79,56 |

| SSD Mobilenet | 22.13 | 55,32 | 82.06 |

| SSD Inception V2 | 26,85 | 64,71 | 78,76 |

| YOLO V2 | 42,93 | 78,99 | 75,67 |

Wir stellen ein Jupyter-Notebook mit Anweisungen zur Verfügung, um unsere vorab trainierten Modelle auf neuen Bildern auszuführen.

Die zum Trainieren unserer Modelle erforderlichen Konfigurationsdateien sind in jeder ZIP-Datei enthalten, die Sie im Abschnitt „Vorab trainierte Modelle“ herunterladen können. Am Basisquellcode von Tensorflow und Darkflow wurden nur minimale Änderungen vorgenommen, sodass Sie unsere Ergebnisse mit den letzten Versionen der oben genannten Repositorys reproduzieren können sollten. Um beispielsweise ein SDD-Mobilenet-Modell zu trainieren, können Sie die folgenden Befehlszeilen ausführen:

cd ~ /tensorflow/models/research

python3 object_detection/train.py --logtostderr --pipeline_config_path models/ssd_mobilenet_v1/ssd_mobilenet_v1_gtsdb3.config --train_dir models/ssd_mobilenet_v1/train/Wir stellen ein Jupyter-Notizbuch mit Anweisungen zur Auswertung der mit unseren vorab trainierten Modellen erzielten Ergebnisse zur Verfügung.

Der Quellcode dieses Projekts basiert hauptsächlich auf der Tensorflow Object Detection API und Darkflow.