[Projekt] [Papier] [Demo] [Verwandte Arbeit: A2RL (für automatisches Zuschneiden von Bildern)] [Colab]

Offizielle Chainer-Implementierung von GP-GAN: Auf dem Weg zu einer realistischen hochauflösenden Bildmischung

| Quelle | Ziel | Maske | zusammengesetzt | vermischt |

|---|---|---|---|---|

|  |  |  |  |

Die Implementierung von GP-GAN durch den Autor, dem hochauflösenden Bildmischungsalgorithmus, beschrieben in:

„GP-GAN: Auf dem Weg zu einer realistischen hochauflösenden Bildmischung“

Huikai Wu, Shuai Zheng, Junge Zhang, Kaiqi Huang

Bei gegebener Maske kann unser Algorithmus das Quellbild und das Zielbild mischen und so ein hochauflösendes und realistisches Mischbild erzeugen. Unser Algorithmus basiert auf tiefen generativen Modellen von Wasserstein GAN.

Kontakt: Hui-Kai Wu ([email protected])

@article{wu2017gp,

title = {GP-GAN: Towards Realistic High-Resolution Image Blending},

author = {Wu, Huikai and Zheng, Shuai and Zhang, Junge and Huang, Kaiqi},

journal = {ACMMM},

year = {2019}

}

Der Code wurde mit python==3.5 und chainer==6.3.0 auf Ubuntu 16.04 LTS getestet.

Laden Sie den Code von GitHub herunter:

git clone https://github.com/wuhuikai/GP-GAN.git

cd GP-GANInstallieren Sie die Anforderungen:

pip install -r requirements/test/requirements.txt Laden Sie das vorab trainierte Modell blending_gan.npz oder unsupervised_blending_gan.npz von Google Drive herunter und legen Sie es dann im Ordner models ab.

Führen Sie das Skript für blending_gan.npz aus:

python run_gp_gan.py --src_image images/test_images/src.jpg --dst_image images/test_images/dst.jpg --mask_image images/test_images/mask.png --blended_image images/test_images/result.png Oder führen Sie das Skript für unsupervised_blending_gan.npz aus:

python run_gp_gan.py --src_image images/test_images/src.jpg --dst_image images/test_images/dst.jpg --mask_image images/test_images/mask.png --blended_image images/test_images/result.png --supervised False Geben Sie python run_gp_gan.py --help ein, um eine vollständige Liste der Argumente zu erhalten.

Laden Sie hier den Datensatz „Transient Attributes“ herunter.

Schneiden Sie die Bilder in jedem Unterordner zu:

python crop_aligned_images.py --data_root [Path for imageAlignedLD in Transient Attributes Dataset]Train Blending GAN:

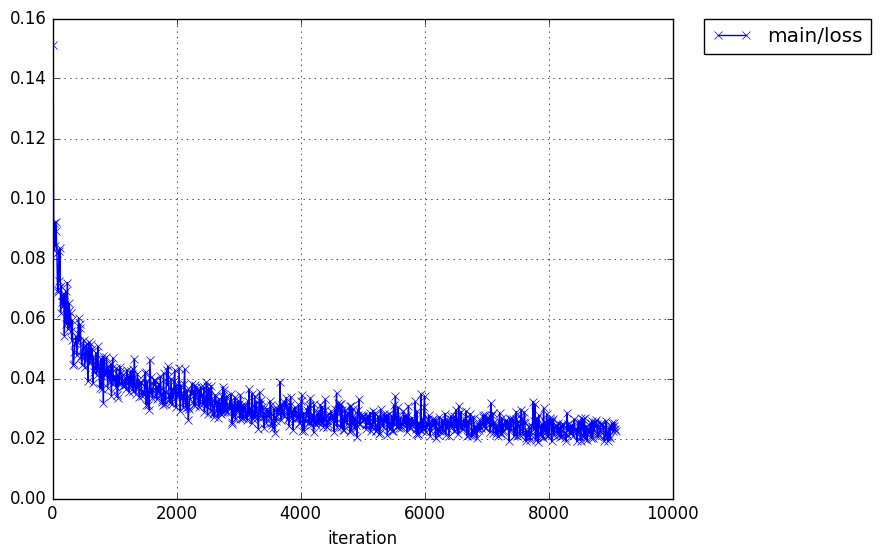

python train_blending_gan.py --data_root [Path for cropped aligned images of Transient Attributes Dataset]Trainingskurve

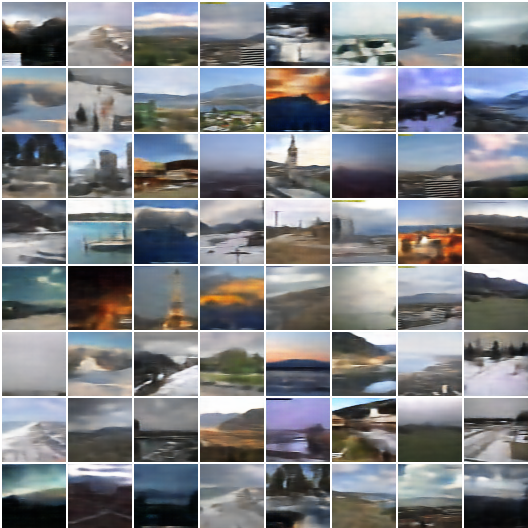

Visuelles Ergebnis

| Trainingsset | Validierungssatz |

|---|---|

|  |

Anforderungen

pip install git+git://github.com/mila-udem/fuel.git@stableLaden Sie den HDF5-Datensatz natürlicher Außenbilder herunter: ourdoor_64.hdf5 (1,4G), der 150.000 Landschaftsbilder aus dem MIT Places-Datensatz enthält.

Trainieren Sie unbeaufsichtigtes Blending GAN:

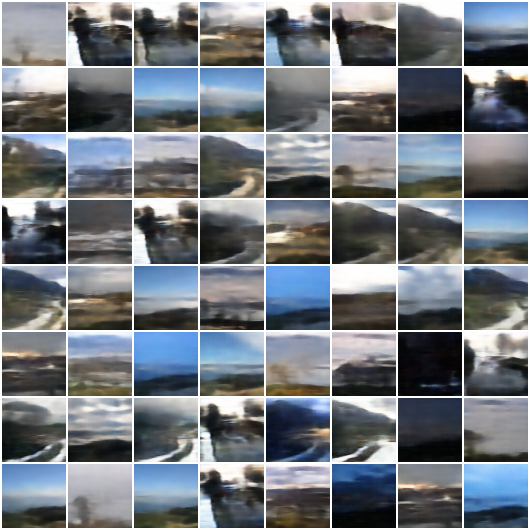

python train_wasserstein_gan.py --data_root [Path for outdoor_64.hdf5] Trainingskurve

Proben nach dem Training

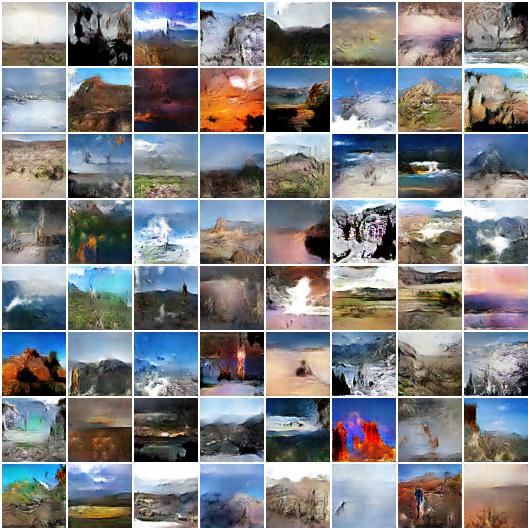

| Maske | Kopieren und Einfügen | Modifiziertes Poisson | Multi-Splines | Überwachtes GP-GAN | Unbeaufsichtigtes GP-GAN |

|---|---|---|---|---|---|

|  |  |  |  |  |

|  |  |  |  |  |

|  |  |  |  |  |

|  |  |  |  |  |

|  |  |  |  |  |