Ressourcen an der Schnittstelle von KI UND Kunst. Hauptsächlich Tools und Tutorials, aber auch einige inspirierende Menschen und Orte!

Eine umfassendere Ressource zu allgemeineren kreativen Codierungstools (die Sie möglicherweise mit den hier aufgeführten Tools verwenden möchten) finden Sie unter terkelg/awesome-creative-coding oder thatcreativecode.page. Ressourcen zu KI und Deep Learning im Allgemeinen finden Sie unter ChristosChristofidis/awesome-deep-learning und https://github.com/dair-ai.

Inhalt

- Lernen

- Kurse

- Videos

- Bücher

- Tutorials und Blogs

- Aufsätze/Methoden

- Diffusionsmodelle (und Text-zu-Bild)

- Neuronale Strahlungsfelder (und NeRF-ähnliche Dinge)

- 3D- und Punktwolken

- Bedingungslose Bildsynthese

- Bedingte Bildsynthese (und inverse Probleme)

- GAN-Inversion (und Bearbeitung)

- Latente Rauminterpretation

- Bildmattierung

- Werkzeuge

- Kreatives ML

- Tiefes Lernen

- Laufzeiten/Bereitstellung

- Text-zu-Bild

- Kreative Codierung

- Stabile Verbreitung

- Datensätze

- Produkte/Apps

- Künstler

- Institutionen/Orte

- Verwandte Listen

Fettgedruckte Einträge kennzeichnen meine Lieblingsressource(n) für diesen Abschnitt/Unterabschnitt (wenn ich eine einzelne Ressource auswählen MÜSSTE ). Darüber hinaus ist jeder Unterabschnitt normalerweise nach der Spezifität des Inhalts geordnet (die allgemeinsten Abschnitte werden zuerst aufgeführt).

Lernen

Kurse

Allgemeines Deep Learning

- Praktisches Deep Learning für Programmierer (fast.ai)

- Deep Learning (NYU)

- Einführung in Deep Learning (CMU)

- ️ Deep Learning für Computer Vision (UMich)

- Deep Learning für Computer Vision (Stanford CS231n)

- Verarbeitung natürlicher Sprache mit Deep Learning (Stanford CS224n)

Tiefe generative Modellierung

- Tiefe generative Modelle (Stanford)

- Deep Unsupervised Learning (UC Berkeley)

- Differenzierbare Inferenz und generative Modelle (Toronto)

- ️ Lernbasierte Bildsynthese (CMU)

- Erlernen der diskreten latenten Struktur (Toronto)

- Von Deep-Learning-Grundlagen zur stabilen Verbreitung (fast.ai)

Kreatives Codieren und neue Medien

- ️ Deep Learning für Kunst, Ästhetik und Kreativität (MIT)

- Maschinelles Lernen für das Web (ITP/NYU)

- Kunst und maschinelles Lernen (CMU)

- Neue Medieninstallation: Kunst, die lernt (CMU)

- Einführung in Computational Media (ITP/NYU)

Videos

- ️ Die KI, die jedes gewünschte Bild erstellt, erklärt (Vox)

- Ich habe ein neuronales Netzwerk erstellt und versucht, ihm das Erkennen von Kritzeleien beizubringen (Sebastian Lague)

- Neuronale Netzwerkserie (3Blue1Brown)

- Anfängerleitfaden zum maschinellen Lernen in JavaScript (Coding Train)

- Zwei-Minuten-Aufträge

Bücher

- ️ Tauchen Sie ein in Deep Learning (Zhang, Lipton, Li und Smola)

- Deep Learning (Goodfellow, Bengio und Courville)

- Computer Vision: Algorithmen und Anwendungen (Szeliski)

- Prozedurale Inhaltsgenerierung in Spielen (Shaker, Togelius und Nelson)

- Generatives Design (Benedikt Groß)

Tutorials und Blogs

Tiefes Lernen

- ️ VQGAN-CLIP: Generierung und Bearbeitung von Open-Domain-Bildern mit natürlicher Sprachführung (Crowson und Biderman)

- Tutorial zu tiefen generativen Modellen (IJCAI-ECAI 2018)

- Tutorial zu GANs (CVPR 2018)

- Lil'Log (Lilian Weng)

- Destillieren [in der Pause]

Generative Kunst

- ️ Generative Kunst mit einfacher Mathematik schaffen

- Buch der Shader: Generative Designs

- Mike Bostock: Visualisierung von Algorithmen (mit Eyeo-Vortrag)

- Generative Beispiele in der Verarbeitung

- Generative Musik

Aufsätze/Methoden

Diffusionsmodelle (und Text-zu-Bild)

- SDEdit: Guided Image Synthesis and Editing with Stochastic Differential Equations: Artikel vor Stable Diffusion, der eine Methode zur Bildsynthese und -bearbeitung mit diffusionsbasierten Modellen beschreibt.

- GLIDE: Auf dem Weg zur fotorealistischen Bilderzeugung und -bearbeitung mit textgesteuerten Diffusionsmodellen

- Hochauflösende Bildsynthese mit latenten Diffusionsmodellen: Originalarbeit, die die stabile Diffusion einführte und alles begann.

- Bildbearbeitung von Eingabeaufforderung zu Eingabeaufforderung mit Queraufmerksamkeitskontrolle: Bearbeiten Sie stabile Diffusionsausgaben, indem Sie die ursprüngliche Eingabeaufforderung bearbeiten.

- Ein Bild ist ein Wort wert: Personalisierung der Text-zu-Bild-Generierung mithilfe von Textinversion: Ähnlich wie Prompt-to-Prompt, erfordert jedoch stattdessen ein Eingabebild und eine Textbeschreibung. Ein bisschen wie Style Transfer ... aber mit stabiler Diffusion.

- DreamBooth: Feinabstimmung von Text-zu-Bild-Diffusionsmodellen für die subjektgesteuerte Generierung: Ähnlich wie die textuelle Inversion, konzentriert sich jedoch auf die Manipulation subjektbasierter Bilder (z. B. dieses Ding/diese Person/usw., aber unter Wasser ).

- Neuartige Ansichtssynthese mit Diffusionsmodellen

- AudioGen: Textgesteuerte Audiogenerierung

- Make-A-Video: Text-zu-Video-Generierung ohne Text-Video-Daten

- Imagic: Textbasierte Realbildbearbeitung mit Diffusionsmodellen

- MDM: Human Motion Diffusion Model

- Soft Diffusion: Score Matching für allgemeine Korruption

- Multi-Konzept-Anpassung der Text-zu-Bild-Diffusion: Wie DreamBooth, aber in der Lage, mehrere Konzepte zu synthetisieren.

- eDiff-I: Text-zu-Bild-Diffusionsmodelle mit einem Ensemble von Experten-Denoisern

- Aufklärung des Designraums diffusionsbasierter generativer Modelle (EDM)

- Bewältigung des Trilemmas des generativen Lernens mit rauschunterdrückenden Diffusions-GANs

- Imagen Video: Hochauflösende Videogenerierung mit Diffusionsmodellen

Neuronale Strahlungsfelder (und NeRF-ähnliche Dinge)

- Structure-from-Motion Revisited: frühere Arbeiten zur Sparse-Modellierung (immer noch erforderlich/nützlich für NeRF)

- Pixelweise Ansichtsauswahl für unstrukturiertes Multi-View-Stereo: frühere Arbeiten zur dichten Modellierung (NeRF ersetzt dies gewissermaßen)

- DeepSDF: Erlernen kontinuierlicher vorzeichenbehafteter Distanzfunktionen zur Formdarstellung

- Verzögertes neuronales Rendering: Bildsynthese unter Verwendung neuronaler Texturen

- Neuronale Volumina: Dynamische renderbare Volumina aus Bildern lernen

- ️ NeRF: Darstellung von Szenen als neuronale Strahlungsfelder für die Ansichtssynthese : Der Artikel, mit dem alles begann ...

- Neuronale Strahlungsfelder für uneingeschränkte Fotosammlungen: NeRF in freier Wildbahn (Alternative zu MVS)

- Nerfies: Verformbare neuronale Strahlungsfelder: Fotorealistisches NeRF aus gelegentlichen Fotos und Videos in der Wildnis (wie von einem Mobiltelefon)

- Mip-NeRF: Eine Multiskalendarstellung für Anti-Aliasing-Neural-Radiance-Felder: NeRF... aber BESSER, SCHNELLER, HÄRTER, STÄRKER

- Tiefenüberwachtes NeRF: Weniger Ansichten und schnelleres Training kostenlos: Trainieren Sie NeRF-Modelle schneller mit weniger Bildern, indem Sie Tiefeninformationen nutzen

- Sofortige neuronale Grafikprimitive mit einer Hash-Kodierung mit mehreren Auflösungen: Caching für NeRF-Training, um es wirklich SCHNELL zu machen

- Grundlegendes zur reinen CLIP-Anleitung für Voxel-Grid-NeRF-Modelle: Text-zu-3D mit CLIP

- NeRF-SLAM: Dichtes monokulares SLAM in Echtzeit mit neuronalen Strahlungsfeldern: NeRF für Roboter (und Autos)

- nerf2nerf: Paarweise Registrierung neuronaler Strahlungsfelder: vortrainiertes NeRF

- Derjenige, in dem sie 3D-Menschen und -Umgebungen in Fernsehsendungen rekonstruierten

- ClimateNeRF: Physikalisch-basiertes neuronales Rendering für die Synthese extremer Klimabedingungen

- Realistische One-Shot-Mesh-basierte Kopf-Avatare

- Neuronale Punktkatakaustik für die neuartige Synthese von Reflexionen

- 3D-Momente aus nahezu doppelten Fotos

- NeRDi: Single-View-NeRF-Synthese mit sprachgesteuerter Diffusion als allgemeine Bildpriorität

3D- und Punktwolken

- DreamFusion: Text-zu-3D mit 2D-Diffusion (Google)

- ULIP: Erlernen einer einheitlichen Darstellung von Sprache, Bild und Punktwolke für das 3D-Verständnis (Salesforce)

- Extrahieren dreieckiger 3D-Modelle, Materialien und Beleuchtung aus Bildern (NVIDIA)

- GET3D: Ein generatives Modell hochwertiger 3D-Texturformen, die aus Bildern gelernt wurden (NVIDIA)

- 3D-Neuronale Felderzeugung mittels Triplane-Diffusion

- ? MagicPony: Erlernen artikulierter 3D-Tiere in freier Wildbahn

- ObjectStitch: Generatives Objekt-Compositing (Adobe)

- LADIS: Sprachentflechtung für die 3D-Formbearbeitung (Snap)

- Rodin: Ein generatives Modell zum Formen digitaler 3D-Avatare mithilfe von Diffusion (Microsoft)

- SDFusion: Multimodale 3D-Formvervollständigung, -Rekonstruktion und -Generierung (Snap)

- DiffRF: Rendering-gesteuerte 3D-Strahlungsfelddiffusion (Meta)

- Neuartige Ansichtssynthese mit Diffusionsmodellen (Google)

- ️ Magic3D: Erstellung hochauflösender Text-zu-3D-Inhalte (NVIDIA)

Bedingungslose Bildsynthese

- Sampling generativer Netzwerke

- Neuronales diskretes Repräsentationslernen (VQVAE)

- Progressives Wachstum von GANs für verbesserte Qualität, Stabilität und Variation

- Eine stilbasierte Generatorarchitektur für generative gegnerische Netzwerke (StyleGAN)

- ️ Analyse und Verbesserung der Bildqualität von StyleGAN (StyleGAN2)

- Training generativer gegnerischer Netzwerke mit begrenzten Daten (StyleGAN2-ADA)

- Aliasfreie generative gegnerische Netzwerke (StyleGAN3)

- Generieren vielfältiger High-Fidelity-Bilder mit VQ-VAE-2

- Zähmungstransformatoren für die hochauflösende Bildsynthese (VQGAN)

- Diffusionsmodelle schlagen GANs bei der Bildsynthese

- StyleNAT: Jedem Kopf eine neue Perspektive geben

- StyleGAN-XL: Skalierung von StyleGAN auf große, unterschiedliche Datensätze

Bedingte Bildsynthese (und inverse Probleme)

- Bild-zu-Bild-Übersetzung mit bedingten gegnerischen Netzen (pix2pix)

- Ungepaarte Bild-zu-Bild-Übersetzung mithilfe von Cycle-Consistent Adversarial Networks (CycleGAN)

- Hochauflösende Bildsynthese und semantische Manipulation mit bedingten GANs (pix2pixHD)

- Semantische Bearbeitung von Szenen durch Hinzufügen, Manipulieren oder Löschen von Objekten (SESAME)

- Semantische Bildsynthese mit räumlich-adaptiver Normalisierung (SPADE)

- Für die semantische Bildsynthese (OASIS) benötigen Sie nur eine kontradiktorische Überwachung.

- Codierung mit Stil: ein StyleGAN-Encoder für die Bild-zu-Bild-Übersetzung

- Multimodale bedingte Bildsynthese mit Product-of-Experts-GANs

- Palette: Bild-zu-Bild-Diffusionsmodelle

- Skizzengesteuerte Text-zu-Bild-Diffusionsmodelle

- HRDA: Kontextbewusste hochauflösende domänenadaptive semantische Segmentierung

- PiPa: Pixel- und Patch-weises selbstüberwachtes Lernen für domänenadaptive semantische Segmentierung

- MIC: Maskierte Bildkonsistenz für kontextverstärkte Domänenanpassung

- Eine Vorschulung ist alles, was Sie für die Bild-zu-Bild-Übersetzung (PITI) benötigen.

GAN-Inversion (und Bearbeitung)

- Generative visuelle Manipulation am Natural Image Manifold (iGAN)

- In-Domain-GAN-Inversion für die Bearbeitung realer Bilder

- Image2StyleGAN: Wie bette ich Bilder in den latenten StyleGAN-Raum ein?

- Entwerfen eines Encoders für die StyleGAN-Bildmanipulation

- Entscheidendes Tuning für die latenzbasierte Bearbeitung realer Bilder

- ️ HyperStyle: StyleGAN-Inversion mit HyperNetworks für die echte Bildbearbeitung

- StyleCLIP: Textgesteuerte Manipulation von StyleGAN-Bildern

- High-Fidelity-GAN-Inversion für die Bearbeitung von Bildattributen

- Austausch des Autoencoders gegen Deep Image Manipulation

- Skizzieren Sie Ihr eigenes GAN

- Geometrische Regeln eines GAN neu schreiben

- Kostenfreie GANs für die interaktive Bildsynthese und -bearbeitung

- Das dritte Mal ist der Reiz? Bild- und Videobearbeitung mit StyleGAN3

Latente Rauminterpretation

- ️ Entdecken interpretierbarer GAN-Steuerelemente (GANspace)

- Interpretation des latenten Raums von GANs für die semantische Gesichtsbearbeitung

- GAN-Dissektion: Generative gegnerische Netzwerke visualisieren und verstehen

- Unbeaufsichtigte Extraktion von StyleGAN-Bearbeitungsanweisungen (CLIP2StyleGAN)

- Sehen, was ein GAN nicht generieren kann

Bildmattierung

- Tiefe Bildmattierung

- Hintergrundmattierung: Die Welt ist Ihr Greenscreen

- Robustes Video-Matting

- Semantische Bildmattierung

- Privatsphäre-wahrende Porträtmatte

- Tiefe automatische natürliche Bildmattierung

- MatteFormer

- MODNet: Echtzeit-Trimap-freie Porträtmattierung mittels objektiver Zerlegung

- ️ Robuste menschliche Mattierung durch semantische Führung

Werkzeuge

Generative Modellierung

- NVIDIA Imaginaire: 2D-Bildsynthesebibliothek

- NVIDIA Omniverse: Die Plattform zum Erstellen und Betreiben von Metaverse-Anwendungen

- mmgeneration

- Modelverse: Inhaltsbasierte Suche nach tiefgreifenden generativen Modellen

- PaddleGAN

Kreatives ML

- Tensorflow.js

- ml5.js

- MediaPipe

- ️ Magenta

- Wekinator

- ofxAddons

Deep-Learning-Frameworks

- ️ PyTorch

- Keras

- Tensorflow

- ? Transformatoren

- ? Diffusoren

- JAX

- dlib

- Darknet

Laufzeiten/Bereitstellung

- FFCV: eine optimierte Datenpipeline zur Beschleunigung des ML-Trainings

- ONNX-Laufzeit

- DeepSpeed (Training, Inferenz, Komprimierung)

- TensorRT

- Tensorflow Lite

- TorchScript

- TorchServe

- AITemplate

Text-zu-Bild

- ️ Stabile Diffusion

- Bild

- DALLE 2

- VQGAN+CLIP

- Parti

- Muse: Text-zu-Bild-Generierung über maskierte generative Transformatoren: Effizienter als Diffusions- oder autoregressive Text-zu-Bild-Modelle mit maskierter Bildmodellierung mit Transformatoren

Stabile Diffusion (SD)

- Dream Studio: Offizieller Cloud-gehosteter Stabilitäts-KI-Dienst.

- ️ Stable Diffusion Web UI : Eine benutzerfreundliche UI für SD mit zusätzlichen Funktionen, um gängige Arbeitsabläufe zu vereinfachen.

- AI-Rendering (Blender): Rendern Sie Szenen in Blender mithilfe einer Textaufforderung.

- Dream Textures (Blender): Plugin zum Rendern von Texturen, Referenzbildern und Hintergründen mit SD.

- lexica.art - SD-Eingabeaufforderungssuche.

- koi (Krita): SD-Plugin für Krita zur img2img-Generierung.

- Alpaka (Photoshop): Photoshop-Plugin (Beta).

- Plugin von Christian Cantrell (Photoshop): Ein weiteres Photoshop-Plugin.

- Stable Diffusion Studio: Animationsorientiertes Frontend für SD.

- DeepSpeed-MII: Inferenz mit geringer Latenz und hohem Durchsatz für eine Vielzahl (über 20.000) Modelle/Aufgaben, einschließlich SD.

Neuronale Strahlungsfelder

- COLMAP

- ️ Nerfstudio

- NVlabs/instant-ngp

- NerfAcc

Kreative Codierung

Rahmenwerke

- ️ Verarbeitung (Java) und p5.js (Javascript)

- openFrameworks (C++)

- Cinder (C++)

- nannou (Rost)

Visuelle Programmiersprachen

- vvvv

- ️ TouchDesigner

- Max/MSP/Jitter

- Reine Daten

Datensätze

Permissiv lizenziert/Open Access

- LAION-Datensätze: Verschiedene sehr große Bild-Text-Paar-Datensätze (die insbesondere zum Trainieren der Open-Source-Modelle für stabile Diffusion verwendet werden).

- LAION-Gesicht

- Unsplash-Bilder

- Pixabay

- Pexels

- Open Images: Open Images ist ein Datensatz von ca. 9 Millionen Bildern, der mit Beschriftungen auf Bildebene, Objektbegrenzungsrahmen, Objektsegmentierungsmasken, visuellen Beziehungen und lokalisierten Erzählungen versehen ist:

- Mozilla Common Voice: 17.127 validierte Stunden transkribierter Sprache in 104 Sprachen. Darüber hinaus enthalten viele der aufgezeichneten Stunden im Datensatz auch demografische Metadaten wie Alter, Geschlecht und Akzent, die dazu beitragen können, die Genauigkeit von Spracherkennungs-Engines zu verbessern.

- Flickr Commons: Flickr Commons ist eine einzigartige Sammlung historischer Fotografien von über 100 Kulturinstitutionen aus der ganzen Welt, alle ohne bekannte Urheberrechtsbeschränkungen.

- Internet Archive: Internet Archive ist eine gemeinnützige Bibliothek mit Millionen kostenloser Bücher, Filme, Software, Musik, Websites und mehr.

- Wikimedia Commons: eine Sammlung von 106.323.506 frei nutzbaren Mediendateien, zu denen jeder beitragen kann.

- Prelinger-Archiv

- Open-Content-Programm der Getty Library: Freie Bereitstellung von Bildern aus den Sammlungen von Getty für Studium, Lehre und Vergnügen.

- Smithsonian Open Access

- Public Domain Review: Konzentriert sich auf Werke, die jetzt gemeinfrei sind, die riesigen Gemeingüter an nicht urheberrechtlich geschütztem Material, das jeder ohne Einschränkungen genießen, teilen und darauf aufbauen kann.

- Kongressbibliothek

- Bibliothek zum Erbe der biologischen Vielfalt

- Der Met Open Access

- Die National Gallery of Art Open Access

- Art Institute of Chicago Open Access

- Public Domain-Sammlungen der NY Public Library

- Museum für Kunst und Gewerbe Hamburg Steintorplatz

- FairFace

- Konzeptionelle Bildunterschriften

- Schnell, zeichne!

- Bilder öffnen

- Visuelle Beantwortung von Fragen

- TensorFlow-Blumen

- Stanford Online Products-Datensatz

- DeepMind 3D-Formen

- PASS: Ein ImageNet-Ersatz für selbstüberwachtes Vortraining ohne Menschen, das für ein qualitativ hochwertiges Vortraining verwendet werden kann und gleichzeitig Datenschutzbedenken deutlich reduziert.

Gesichter/Personen (eingeschränkte Lizenzen)

- Beschriftete Gesichter in freier Wildbahn (LFW)

- CelebA

- LFWA+

- CelebAMask-HQ

- CelebA-Parodie

- UTKGesicht

- SSHQ: Ganzkörper 1024 x 512 Pixel

Andere

Produkte/Apps

- Kunstzüchter

- Mitten auf der Reise

- DALLE 2 (OpenAI)

- Runway – KI-gestützter Videoeditor.

- Facet AI – KI-gestützter Bildeditor.

- Adobe Sensei – KI-gestützte Funktionen für die Creative Cloud-Suite.

- NVIDIA AI-Demos

- ClipDrop und cleanup.pictures

Künstler

Eine nicht erschöpfende Liste von Menschen, die interessante Dinge an der Schnittstelle von Kunst, ML und Design tun.

- Memo Akten

- Neuronale Bricolage (Helena Sarin)

- Sofia Crespo

- Lauren McCarthy

- Philipp Schmitt

- Anna Ridler

- Tom White

- Ivona Tau

- Trevor Paglen

- Sasha Stiles

- Mario Klingemann

- Tega-Gehirn

- Mimi Onuoha

- Allison Parrish

- Caroline Sinders

- Robbie Barrat

- Kyle McDonald

- Golan Levin

Institutionen/Orte

- STUDIO für kreative Anfragen

- ITP @ NYU

- Gray Area Foundation for the Arts

- Stabilitäts-KI (Eleuther, LAION, et al.)

- Goldsmiths @ University of London

- UCLA Design Media Arts

- Berkeley Center für neue Medien

- Google Artists und maschinelle Intelligenz

- Google Creative Lab

- Das Labor am Google Cultural Institute

- Sony CSL (Tokio und Paris)

Verwandte Listen und Sammlungen

- Maschinelles Lernen für die Kunst

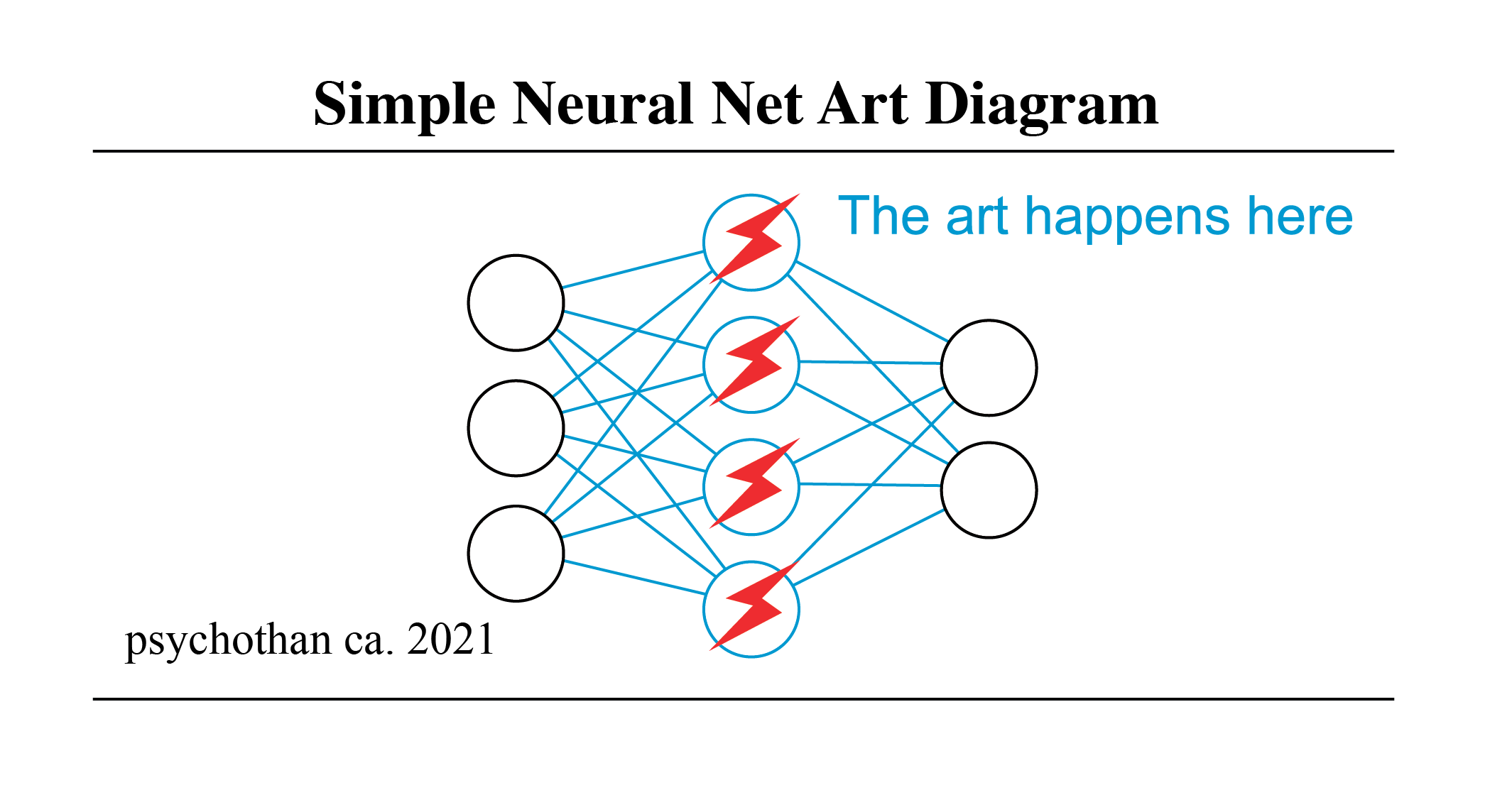

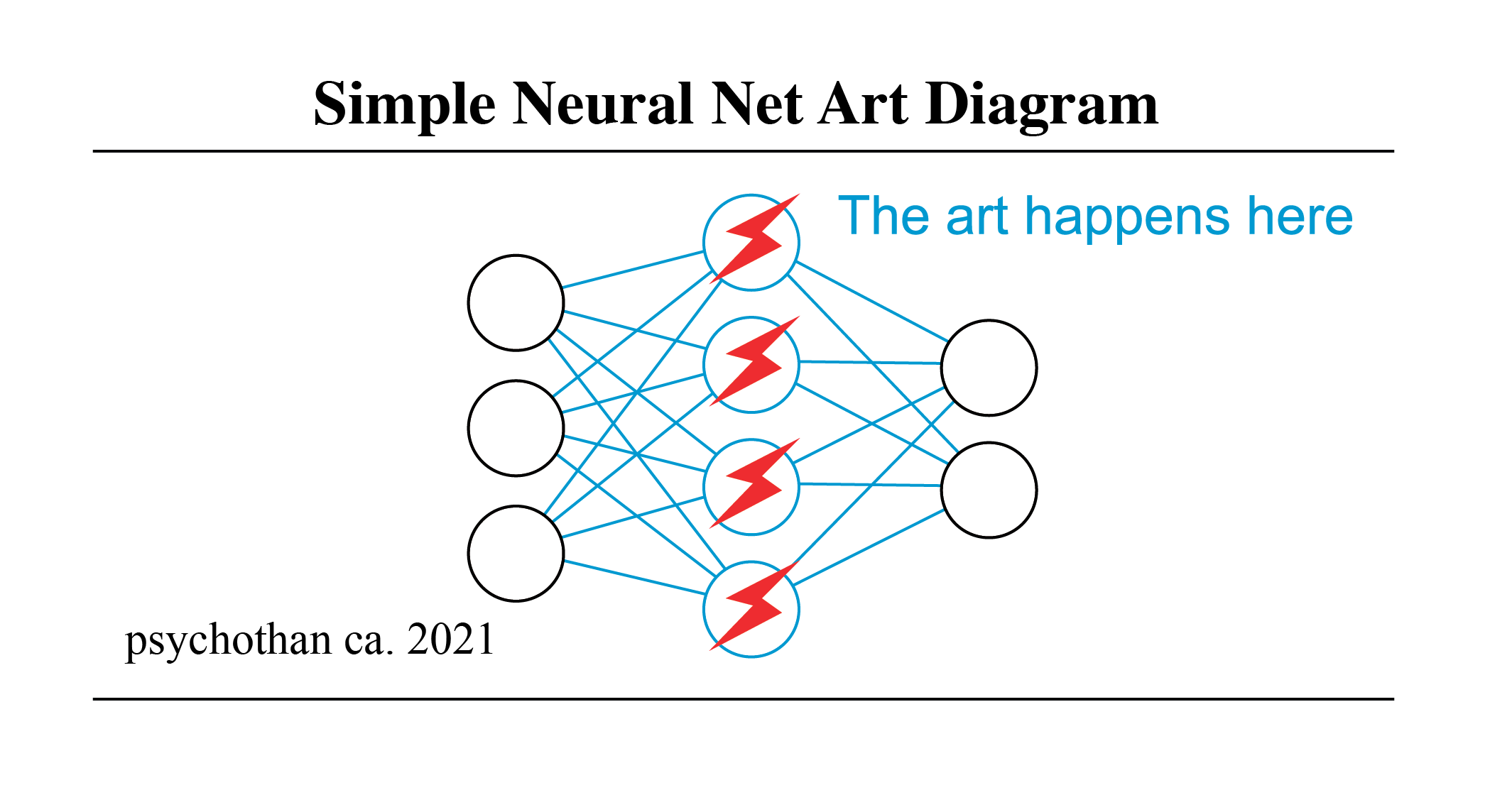

- Tools und Ressourcen für KI-Kunst (pharmapsychotisch) – Große Liste von Google Colab-Notizbüchern für generative Text-zu-Bild-Techniken sowie allgemeine Tools und Ressourcen.

- Awesome Generative Deep Art – Eine kuratierte Liste von Generative Deep Art/Generative AI-Projekten, Tools, Kunstwerken und Modellen

Mitwirken

Beiträge sind willkommen! Lesen Sie zunächst die Beitragsrichtlinien.