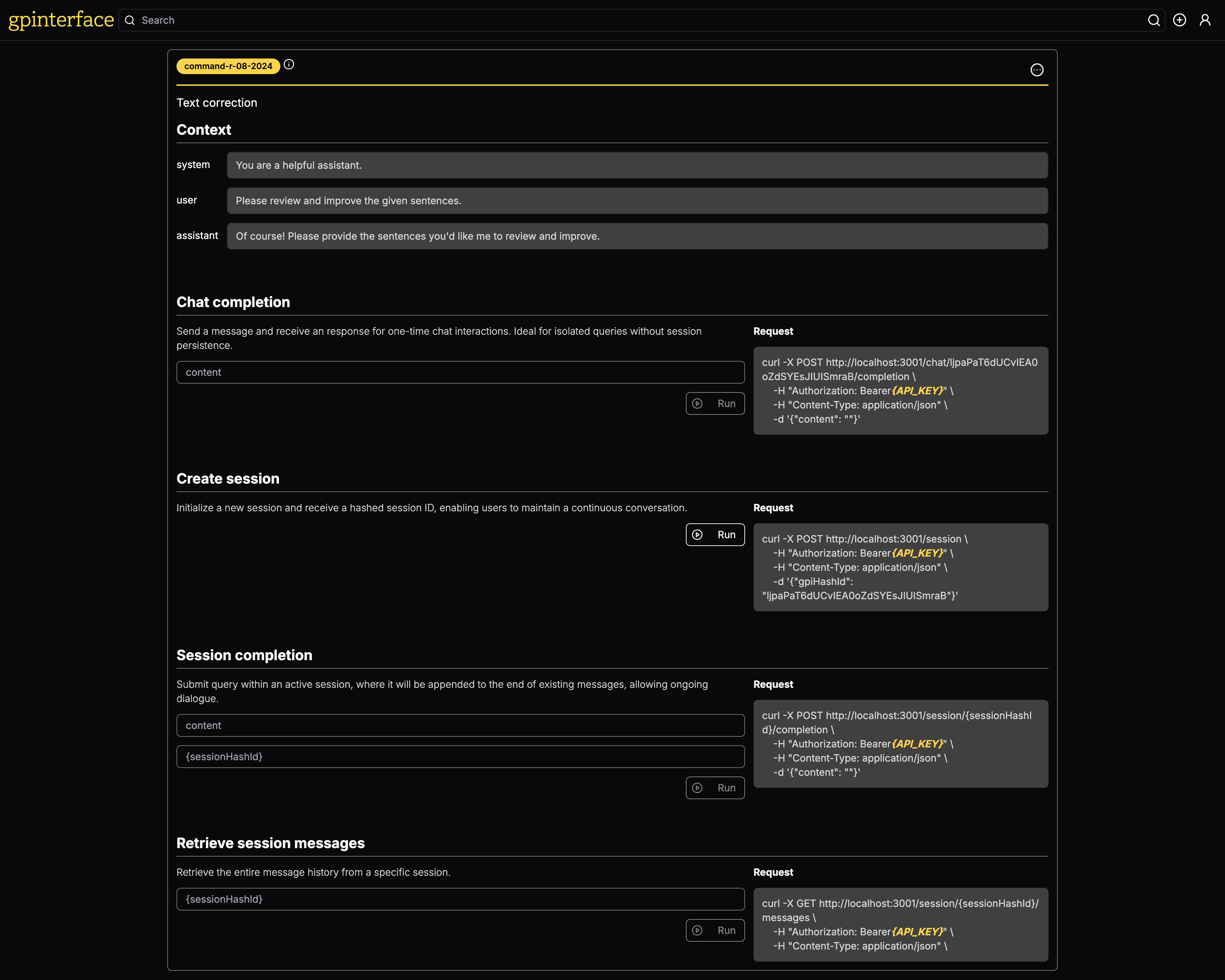

Mit gpinterface können Sie einfach API für Ihre Eingabeaufforderungen erstellen.

Eine Live -Demo ist unter gpinterface.com erhältlich.

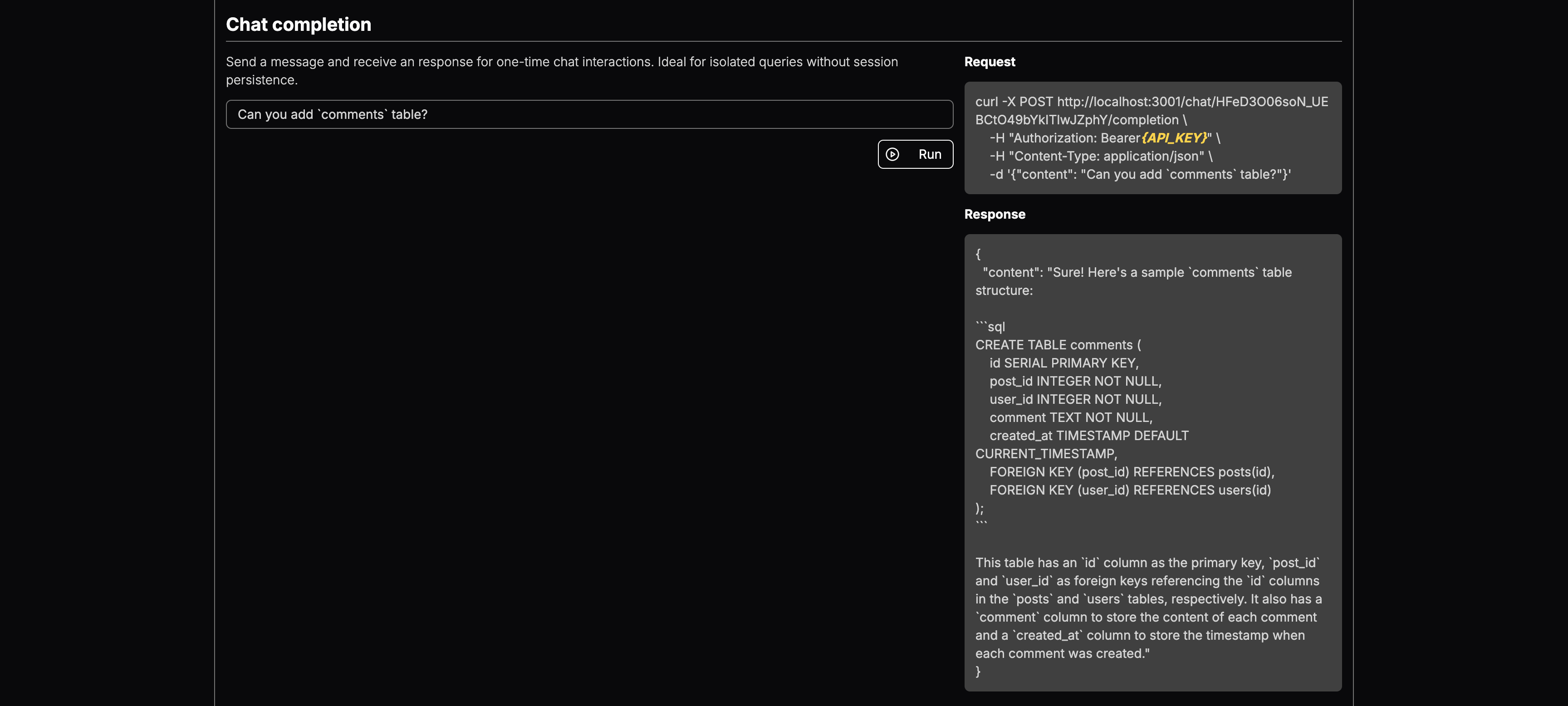

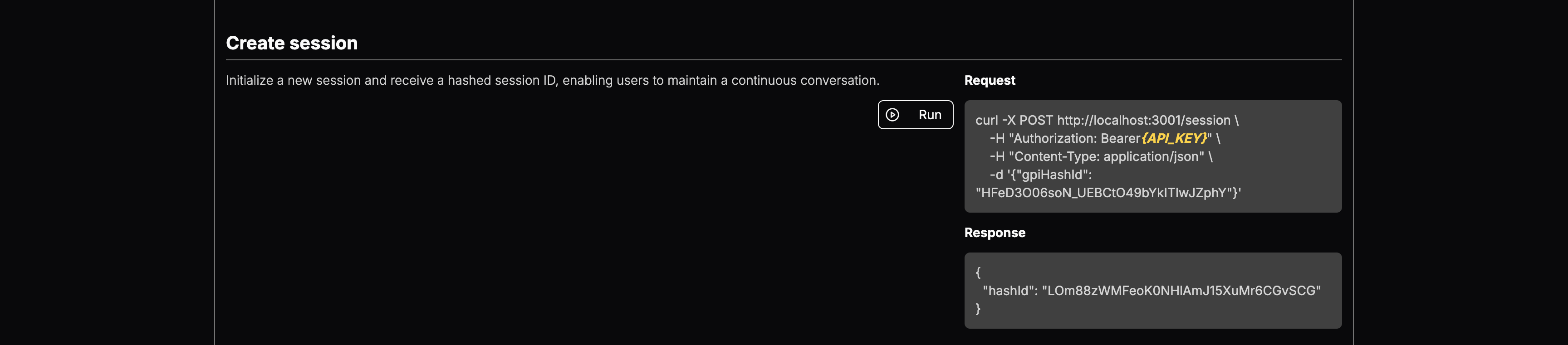

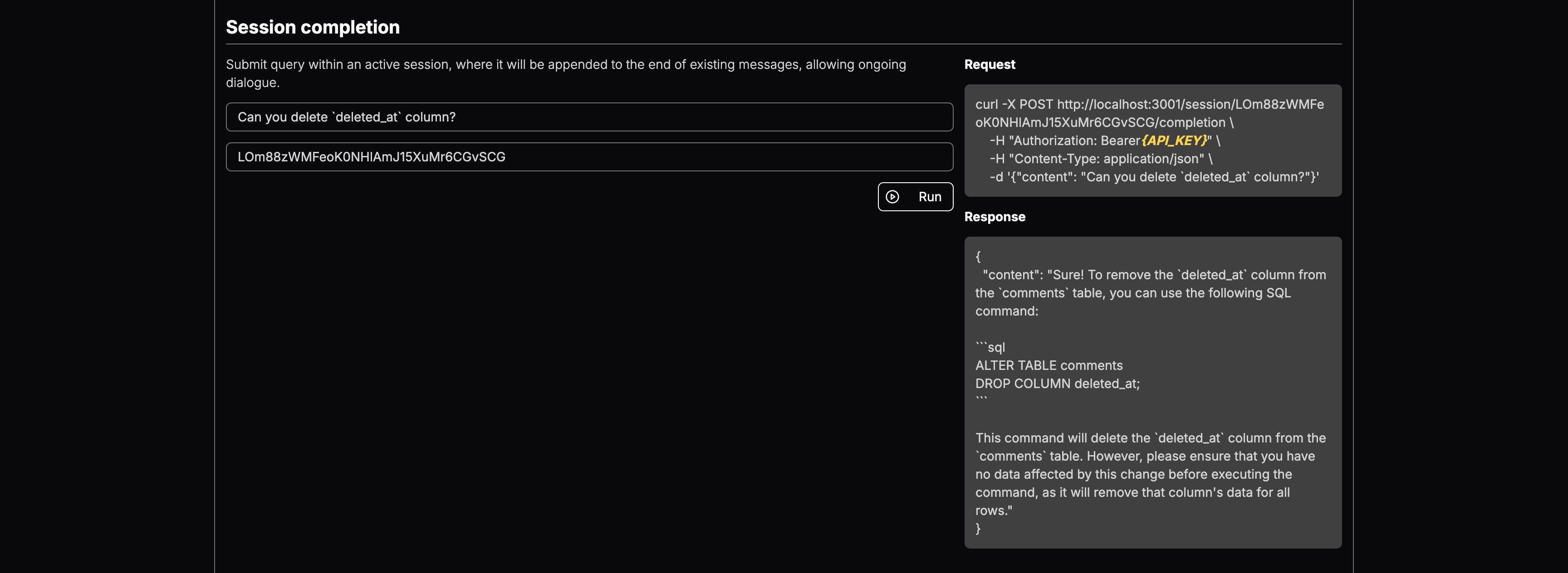

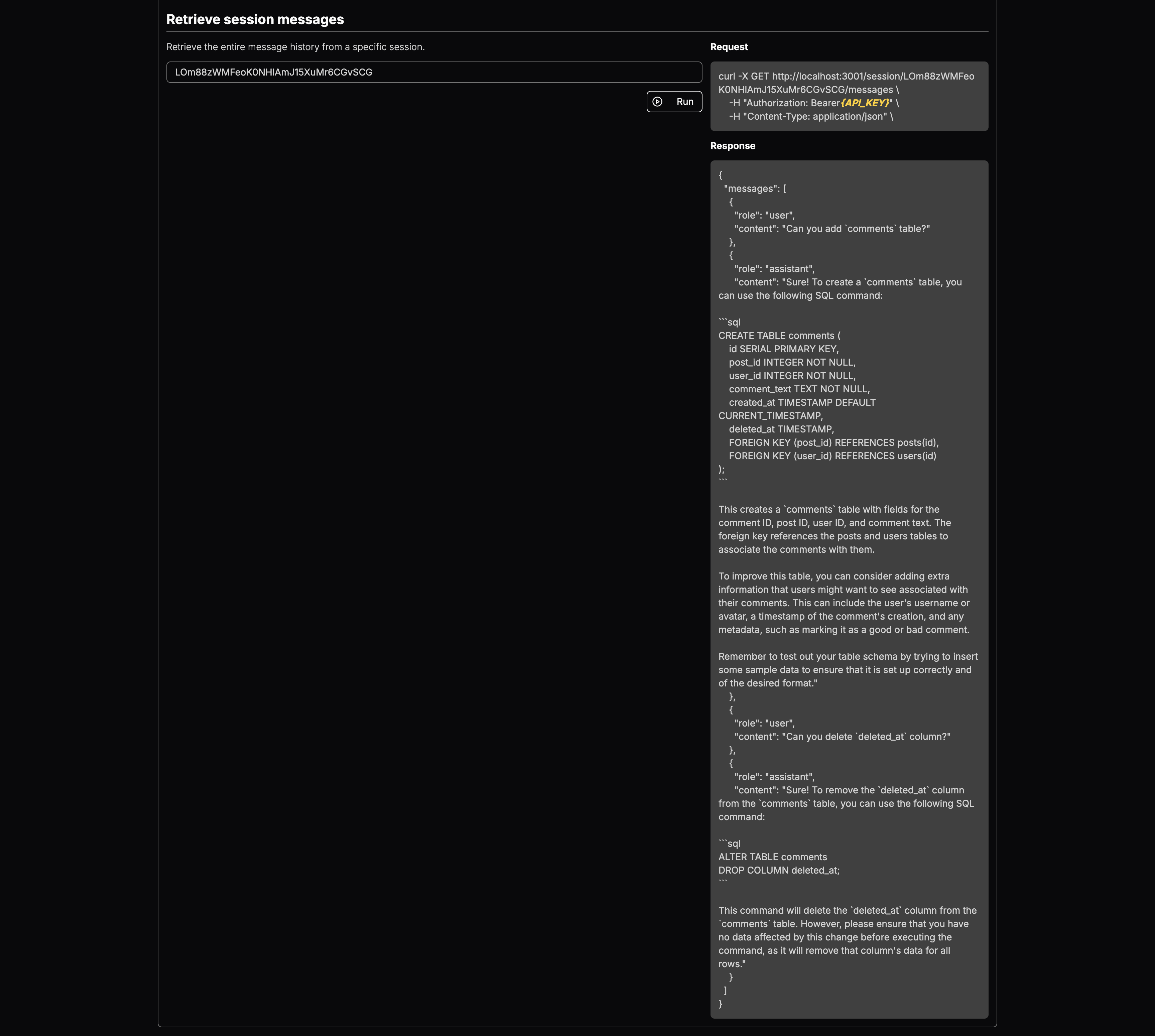

Hier sind einige spezifische Beispiele dafür, was gpinterface kann:

Sie können das LLM -Modell auswählen und Kontext hinzufügen. Nach der Bereitstellung erhalten Sie Endpunkte für:

Es ist ein leistungsstarkes Tool, das das Testen und die Bereitstellung von generativen Eingabeaufforderungen über mehrere große Sprachmodelle (LLMs) hinweg rationalisiert. Mit einer benutzerfreundlichen Weboberfläche ermöglicht gpinterface eine schnelle Konfiguration und Experimente.

gpinterface unterstützt derzeit eine Vielzahl führender großer Sprachmodelle, darunter:

Mit dieser vielfältigen Unterstützung können Sie das beste Modell für Ihre spezifischen Anforderungen und Anforderungen auswählen.

Sehen Sie Ihr Lieblingsmodell nicht? Fühlen Sie sich frei, PR zu öffnen oder kontaktieren Sie mich!

Die Anwendung benötigt eine PostgreSQL -Datenbank. Starten Sie die Datenbank mit Docker:

cd backend

docker-compose up -dDas Backend nutzt Prisma, um das Datenbankschema und Migrationen zu verwalten. Führen Sie die folgenden Befehle bei der Datenbankinitialisierung aus:

npm run prisma:migrateFühren Sie die folgenden Befehle aus:

npx ts-node prisma/seedBackend

Das Backend erfordert, dass die folgenden Umgebungsvariablen festgelegt werden:

CLIENT_URL= " http://localhost:3003 "

DATABASE_URL= " postgresql://postgres:[email protected]:5432/postgres " # can be replaced with your DB endpoint

AI21_API_KEY= " YOUR_AI21_API_KEY "

ANTHROPIC_API_KEY= " YOUR_ANTHROPIC_API_KEY "

COHERE_API_KEY= " YOUR_COHERE_API_KEY "

GOOGLE_API_KEY= " YOUR_GOOGLE_API_KEY "

MISTRAL_API_KEY= " YOUR_MISTRAL_API_KEY "

OPENAI_API_KEY= " YOUR_OPENAI_API_KEY "

AWS_ACCESS_KEY_ID= " AWS_ACCESS_KEY " # you need Llama model access in AWS Bedrock

AWS_SECRET_ACCESS_KEY= " AWS_SECRET_KEY " # you need Llama model access in AWS Bedrock

JWT_SECRET= " SECURE_RANDOM_STRING "

COOKIE_SECRET= " SECURE_RANDOM_STRING "

NODE_ENV= " development " # for development logging Stellen Sie sicher, dass diese Variablen in einer .env -Datei im Backend -Verzeichnis eingestellt sind, bevor Sie die Anwendung starten.

Frontend

Die Frontend -Anwendung erfordert die folgenden Umgebungsvariablen:

NEXT_PUBLIC_API_ENDPOINT= " http://localhost:3000 "

NEXT_PUBLIC_CHAT_ENDPOINT= " http://localhost:3001 "

NEXT_PUBLIC_HOSTNAME= " http://localhost:3003 "

NEXT_PUBLIC_GOOGLE_OAUTH_CLIENT_KEY= " "Diese sollten so konfiguriert werden, dass sie den Endpunkten entsprechen, an denen die Backend -Dienste verfügbar sind, und sicherstellen, dass der Frontend mit dem Backend ordnungsgemäß kommunizieren kann.

Um die Anwendungskomponenten für Entwicklungszwecke separat auszuführen:

Backend laufen

cd backend && npm run devFrontend laufen

cd frontend && npm run devBefolgen Sie diese Schritte nacheinander, um alle Komponenten für die Bereitstellung der Produktion zu erstellen

cd shared

npm run build

cd ../backend

npm run build

cd ../frontend

npm run buildUm den Server zu starten

Backend laufen

cd backend && npm run startChat -Server ausführen (API -Server)

cd backend && npm run start:chatFrontend laufen

cd frontend && npm run start