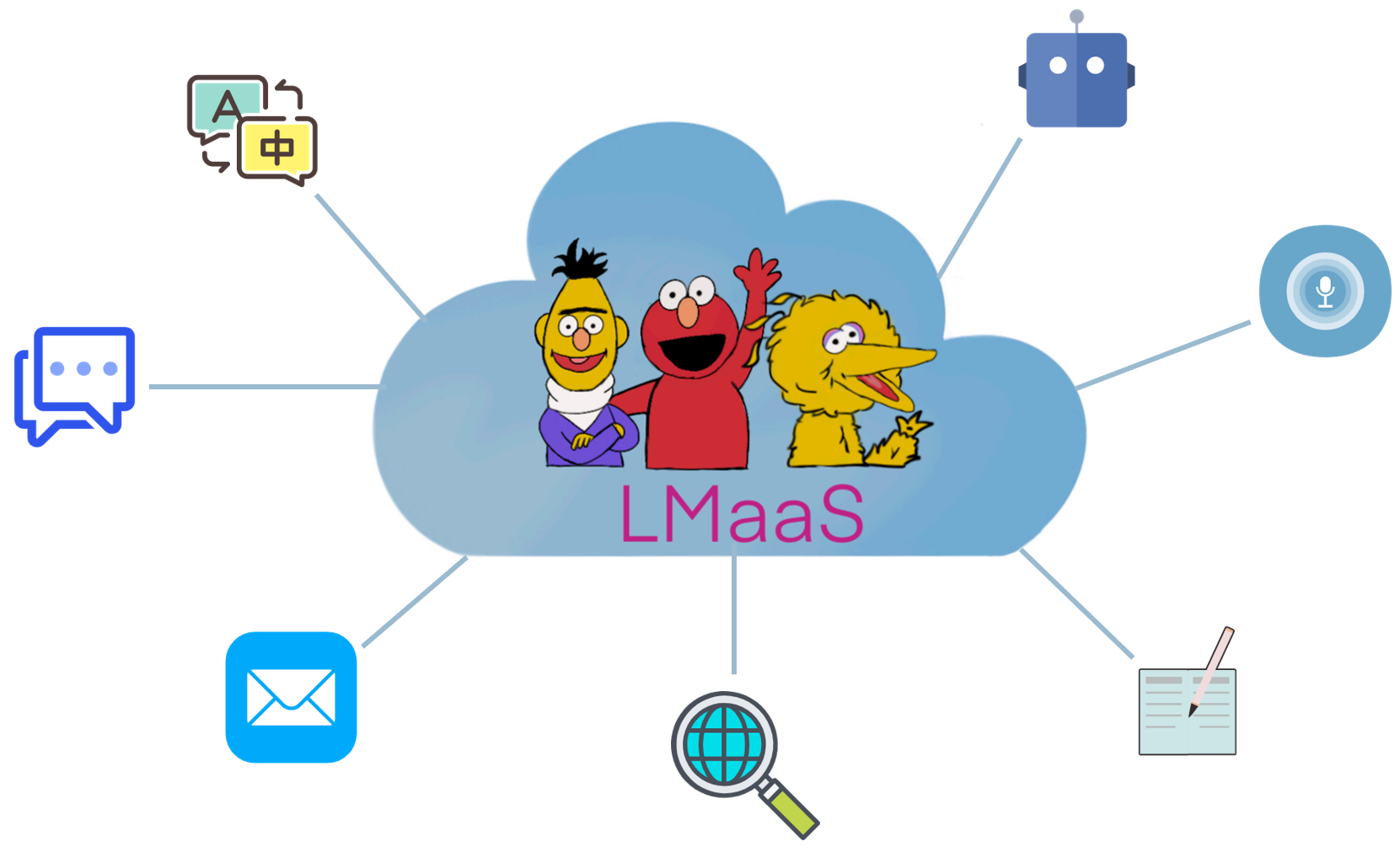

Dies ist eine kuratierte Liste von "Sprachmodell-as-a-Service (LMAAS)" -Papieren, die hauptsächlich von Tianxiang Sun gepflegt werden. Wir ermutigen die NLP -Forscher, die an diesem Thema interessiert sind, nachdrücklich, die Pull -Anfrage zum Hinzufügen oder Aktualisieren der Papiere zu stellen (siehe Beitrag). Sehen Sie sich dieses Repository für die neuesten Updates an!

Aus kommerziellen Gründen und teuren Tuningkosten werden vorgeborene Großsprachenmodelle (LLMs) wie GPT-3 normalerweise als Service anstelle von Open Sourcing-Modellgewichten veröffentlicht. Wir nennen dieses Szenario " Sprachmodell-as-a-Service (LMAAS) " (der Begriff wird ursprünglich in unserem ICML'2022-Papier verwendet). In einem solchen Szenario können Benutzer über ihre Inferenz -APIs auf die leistungsstarken LLMs zugreifen. Der Dienst von LLMs hat viele Anwendungsfälle betrieben (siehe GPT-3-Demo). Im Gegensatz zur Feinabstimmung ermöglicht LMAAs einem einzigen Allzweck-LLM viele Differenzaufgaben und ist daher sehr einsatzeffizient. Die Anpassung von LLMs an Aufgaben ohne Zugriff auf ihre Parameter und Gradienten ist jedoch eine Herausforderung. Um LLMs zu einem breiteren Publikum zugute kommen, sammeln wir Papiere, die in dieses Szenario passen, um zukünftige Forschung zu ermöglichen.

Welche Papiere passen in das Szenario von LMAAs? Wir betrachten hauptsächlich Papiere, die LLMs an nachgeschaltete Aufgaben anpassen, ohne auf die Modellparameter und die Gradienten zuzugreifen. Obwohl fein abgestimmte LLMs auch nach der Bereitstellung Dienste sein können, sind sie beschränkt, eine einzige Aufgabe für das begrenzte Publikum zu lösen. In unserem Umfang bevorzugen wir es vor, Allzweckmodelle für eine Vielzahl von Benutzern zu bedienen.

In der vorhandenen Literatur gibt es mehrere Forschungslinien, die in LMAAs passen:

Die Grenze zwischen Texteingabeaufforderung und Kontextlernen ist etwas verschwommen. In diesem Repo enthält die Kategorie der Textaufforderung Papiere, die keine beschrifteten Muster verwenden, während die Kategorie "In-Kontext" aus Papieren besteht, die beschriftete Muster in die Eingabeaufforderungen enthalten.

HINWEIS: Ein zugehöriges (und teilweise überlappendes) Thema ist ein prompt-basiertes Lernen , das darauf abzielt, nachgelagerte Aufgaben mithilfe von Allzweck-LLMs durch Konvertieren von Eingaben und Ausgabe mit einer Vorlage bzw. Verbalizer zu lösen. Die meisten Arbeiten im prompt-basierten Lernen erfordern jedoch den Zugriff auf Modellparameter und Gradienten und passen daher nicht in unseren Bereich. Für prompte basierte Lernpapiere, die nicht für LMAAs geeignet sind, empfehlen wir, zu einer anderen fantastischen Papierliste beizutragen: ProportionPaper.

Im Vergleich zu feinabstimmungsspezifischen LLMs hat LMAAS die folgenden Vorteile:

Die Abkürzung der Arbeit.

Das Hauptmerkmal der Arbeit.

Die wichtigste experimentelle Einstellung der Arbeit.

Sprachmodelle als Wissensbasis? EMNLP 2019

Fabio Petroni, Tim Rocktäschel, Patrick Lewis, Anton Bakhtin, Yuxiang Wu, Alexander H. Miller, Sebastian Riedel . [PDF] [Code]

Wie können wir wissen, was Sprachmodelle wissen? TaCl 2020

Zhengbao Jiang, Frank F. Xu, Jun Araki, Graham Neuubig . [PDF] [Code]

Sprachmodelle sind nur wenige Lernende. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Anpassung von Sprachmodellen für das Lernen von Zero-Shot-Lernen durch Meta-Einstellung in Datensatz- und Eingabeaufforderungskollektionen . Ergebnisse von EMNLP 2021

Ruiqi Zhong, Kristy Lee, Zheng Zhang, Dan Klein . [PDF] [Code]

Finetuned-Sprachmodelle sind Null-Shot-Lernende . ICLR 2022

Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan du, Andrew M. Dai, Quoc V. Le . [PDF] [Code]

Multitasking, das zum Training gefordert wurde, ermöglicht die Verallgemeinerung von Aufgaben in der Null-Shot-Aufgabe . ICLR 2022

Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, Arnaud Stiegler, Teven Le Scao, Arun Raja, Manan Dey, M Sauli BARI, Canwen Xu, Urmish Thakker, Shanya, Shanya Sharya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya, Shanya Sharma, SHARYA, SHANYA, Eliza Szczechla, Taewoon Kim, Gunjan Chhablani, Nihal Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neeraj, Jos Rozen, Abheesht Sharma , Andrea Santilli, Thibault Fevry, Jason Alan Fries, Ryan Teehan, Tali Bers, Stella Biderman, Leo Gao, Thomas Wolf, Alexander M. Rush . [PDF] [Code]

Trainingssprachmodelle, um Anweisungen mit menschlichem Feedback zu befolgen . Preprint 2022.3

Long Ouyang, Jeff Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell, Peter Welinder, Paul Christiano, Jan Leike, Ryan Lowe . [PDF] [Code]

Großsprachige Modelle sind Null-Shot-Vernunft . Preprint 2022.6

Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, Yusuke Iwasawa . [PDF] [Code]

Zero-Shot-Video Frage, die über gefrorene bidirektionale Sprachmodelle beantwortet werden . Preprint 2022.6

Antoine Yang, Antoine Miech, Josef Sivic, Ivan Laptev, Cordelia Schmid . [PDF] [Code]

Sprachmodelle sind allgemeine Schnittstellen . Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming MA, Furu Wei . [PDF] [Code]

Eingabeaufforderung auf Repository-Ebene für große Sprachmodelle von Code. Preprint 2022.6

Disha Shrivastava, Hugo Larochelle, Daniel Tarlow [PDF] [Code], 2022.6

Vorherige Eingabeaufforderung ignorieren: Angriffstechniken für Sprachmodelle. Best Papier Award @ Neurips ML Safety Workshop 2022.

Fábio Perez, Ian Ribeiro [PDF] [Projekt], 2022.11

Sprachmodelle sind nur wenige Lernende. Neurips 2020

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei . [PDF]

Kalibrieren Sie vor der Verwendung: Verbesserung der Leistung von Sprachmodellen wenige Schüsse . ICML 2021

Tony Z. Zhao, Eric Wallace, Shi Feng, Dan Klein, Sameer Singh . [PDF] [Code]

Eine Erklärung des In-Kontext-Lernens als implizite Bayes'sche Inferenz . ICLR 2022

Sang Michael Xie, Aditi Raghunathan, Percy Liang, Tengyu MA . [PDF] [Code]

Kette von Denkweisen, die dazu führen, dass sie in großer Sprachmodellen Begründung ausgelöst haben . Preprint 2022.1

Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Brian Ichter, Fei Xia, Ed Chi, Quoc Le, Denny Zhou . [PDF]

Durch die Verallgemeinerung der Kreuzung über natürliche Sprache Crowdsourcing-Anweisungen . ACL 2022

Swaroop Mishra, Daniel Khashabi, Chitta Baral, Hannaneh Hajishirzi . [PDF] [Code]

Fantastisch geordnete Eingabeaufforderungen und wo man sie findet: Überwindung einiger Empfindlichkeit der Auftragsanordnung . ACL 2022

Yao Lu, Max Bartolo, Alastair Moore, Sebastian Riede, Pontus Stenetorp . [PDF]

Lautes Kanal-Sprachmodell Aufforderung zur Einstufung für wenige Schuss-Textklassifizierung . ACL 2022

Sewon Min, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [Code]

Meta-Learning über Sprachmodell In-Context-Abstimmung . ACL 2022

Yanda Chen, Ruiqi Zhong, Sheng Zha, George Karypis, er . [PDF] [Code]

Was macht gute In-Kontext-Beispiele für GPT-3? Deelio@ACL 2022

Jiachang Liu, Dinghan Shen, Yizhe Zhang, Bill Dolan, Lawrence Carin, Weizhu Chen . [PDF]

Lernen, Eingabeaufforderungen für das Lernen in Kontext abzurufen . NAACl 2022

Ohad Rubin, Jonathan Herzig, Jonathan Berant . [PDF] [Code]

Metaicl: Lernen im Kontext lernen . NAACl 2022

Sewon Min, Mike Lewis, Luke Zettlemoyer, Hannaneh Hajishirzi . [PDF] [Code]

Verbesserung des Kontextes mit wenigen Schüssen durch selbst überprüfte Training . NAACl 2022

Mingda Chen, Jingfei du, Ramakanth Pasunuru, Todor Mihaylov, Srini Iyer, Veselin Stoyanov, Zornitsa Kozareva . [PDF]

Selbst erzeugter Lernen in Kontext: Nutzung automatisch-adressiver Sprachmodelle als Demonstrationsgenerator . LPLM@NAACL 2022

Hyuhng Joon Kim, Hyunsoo Cho, Junyeob Kim, Taeuk Kim, Kang Min Yoo, Sang-Goo Lee . [PDF]

Überdenken Sie die Rolle von Demonstrationen: Was macht das Lernen im Kontext zum Lernen? Preprint 2022.2

Sewon Min, Xinxi Lyu, Ari Holtzman, Mikel Artetxe, Mike Lewis, Hannaneh Hajishirzi, Luke Zettlemoyer . [PDF] [Code]

In-Kontext-Lernen für wenige Schüsse-Dialogzustandsverfolgung. Preprint 2022.3

Yushi Hu, Chia-Hsuan Lee, Tianbao Xie, Tao Yu, Noah A. Smith, Mari Ostendorf . [PDF] [Code]

Selbstkonsistenz verbessert die Kette des Denkens in Sprachmodellen . Preprint 2022.3

Xuezhi Wang, Jason Wei, Dale Schuurmans, Quoc Le, Ed Chi, Denny Zhou . [PDF]

Star: Autodidaktischer Gründer Bootstrapping-Argumentation mit Argumentation . Preprint 2022.3

Eric Zelikman, Yuhuai Wu, Noah D. Goodman . [PDF]

Benchmarking-Verallgemeinerung über In-Kontext-Anweisungen bei mehr als 1.600 Sprachaufgaben . Preprint 2022.4

Yizhong Wang, Swaroop Mishra, Pegah Alipoormolabashi, Yeganeh Kordi, Amirreza Mirzaei, Anjana Arunkumar, Arjun Ashok, Arut Selvan Dhanasekaran, Atharva Naik, David Stap, Eshaan -Pathak, Giannis Hannis Hannis, Karamanolakis, Haihian, Giannis, Karamanolakis, Haihian, Giannis, Karamanolakis, Haihian, Ishan. Ishani Mondal, Jacob Anderson, Kirby Kuznia, Krima Doshi, Maitreya Patel, Kuntal Kumar Pal, Mehrad Moradshahi, Mihir Parmar, Mirali Purohit, Neeraj Varshney, Phani Rohitha Kaza, Pulkit Verma, Ravsehaj Singh Puri, Rushang Karia, Shailaja Keyur Sampat, Savan Doshi, Siddhartha Mishra, Sujan Reddy, Sumanta Patro, Tanay Dixit, Xudong Shen, Chitta Baral, Yejin Choi, Noah A. Smith, Hannaneh Hajishirzi, Daniel Khashabi . [PDF] [Code]

Können Sprachmodelle aus Erklärungen im Kontext lernen? . Preprint 2022.4

Andrew K. Lampinen, Ishita Dasgupta, Stephanie Cy Chan, Kory Matthewson, Michael Henry Tessler, Antonia Creswell, James L. McClelland, Jane X. Wang, Felix Hill . [PDF]

BOCKE-WHRUH-Etiketten sind wichtig: Ein tieferer Blick auf Input-Label-Demonstrationen . Preprint 2022.5

Junyeob Kim, Hyuhng Joon Kim, Hyunsoo Cho, Hwiyeol Jo, Sang-woo Lee, Sang-Goo Lee, Kang Min Yoo, Taeuk Kim . [PDF]

Die Unzuverlässigkeit von Erklärungen in wenigen Schüssen im Kontextlernen . Preprint 2022.5

Xi ye, Greg Durrett . [PDF]

Die am wenigsten zu meistversteigende Erscheinung ermöglicht komplexe Argumentation in Großsprachenmodellen . Preprint 2022.5

Denny Zhou, Nathanael Schärli, Le Hou, Jason Wei, Nathan Scales, Xuezhi Wang, Dale Schuurmans, Olivier Bousquet, Quoc Le, Ed Chi . [PDF]

Maieutische Aufforderung: Logisch konsequentes Denken mit rekursiven Erklärungen . Preprint 2022.5

Jaehun Jung, Lianhui Qin, Sean Welleck, Faeze Brahman, Chandra Bhagavatula, Ronan Le Bras, Yejin Choi . [PDF]

Über den Vormarsch der Sprachmodelle zu besseren Dennzeichen . Preprint 2022.6

Yifei Li, Zeqi Lin, Shizhuo Zhang, Qiang Fu, Bei Chen, Jian-Guang Lou, Weishu Chen . [PDF] [Code]

Aufstrebende Fähigkeiten großer Sprachmodelle . Preprint 2022.6

Jason Wei, Yi Tay, Rishi Bommasani, Colin Raffel, Barret Zoph, Sebastian Borgeaud, Dani Yogatama, Maarten Bosma, Denny Zhou, Donald Metzler, Ed H. Chi, Tatsunori Hashimoto, Oriol Vyals, Percy Liand, Jeff Dean, William Fedus . [PDF]

Sprachmodelle sind allgemeine Schnittstellen . Preprint 2022.6

Yaru Hao, Haoyu Song, Li Dong, Shaohan Huang, Zewen Chi, Wenhui Wang, Shuming MA, Furu Wei . [PDF] [Code]

Was können Transformatoren im Kontext lernen? Eine Fallstudie einfacher Funktionsklassen . Preprint 2022.8

Shivam Garg, Dimitris Tsipras, Percy Liang, Gregory Valiant . [PDF] [Code]

Lernen durch Destillationskontext . Preprint 2022.9

Charlie Snell, Dan Klein, Ruiqi Zhong . [PDF]

Bindende Sprachmodelle in symbolischen Sprachen . Preprint 2022.10

Zhoujun Cheng*, Tianbao Xie*, Peng Shi, Chengzu Li, Rahul Nadkarni, Yushi Hu, Caiming Xiong, Dragomir Radev, Mari Ostendorf, Luke Zettlemoyer, Noah A. Smith, Tao Yu . [PDF] [Code] [Website]

Beibehaltung der Lernfähigkeit der In-Kontext in großer Sprachmodell-Feinabstimmungen . Preprint 2022.11

Yihan Wang, Si Si, Daliang Li, Michal Lukasik, Felix Yu, Cho-Jui Hsieh, Inderjit S Dhillon, Sanjiv Kumar . [PDF]

Unterrichten von algorithmischem Denken durch das Lernen in Kontext . Preprint 2022.11

Hattie Zhou, Azade Nova, Hugo Larochelle, Aaron Courville, Behnam Neyshabur, Hanie Sedghi . [PDF]

Welchen Lernalgorithmus lernt das Kontext? Untersuchungen mit linearen Modellen . Preprint 2022.11

Ekin Akyürk, Dale Schuurmans, Jacob Andreas, Tengyu MA, Denny Zhou . [PDF]

Black-Box-Abstimmung für Sprachmodell-AS-A-Service . ICML 2022

Tianxiang Sun, Yunfan Shao, Hong Qian, Xuanjing Huang, Xipeng Qiu. [PDF] [Code]

Black-Box-Eingabeaufforderung für vorgebliebene Sprachmodelle . TMLR 2023.2

Shizhe Diao, Xuechun Li, Yong Lin, Zhichao Huang, Tong Zhang . [PDF]

Griffe: Gradientenfrei, bearbeitungsbasierte Befehlsuche nach Aufforderung nach großsprachigen Modellen . Preprint 2022.3

Archiki Prasad, Peter Hase, Xiang Zhou, Mohit Bansal . [PDF] [Code]

Wenige Schüsse Aufforderung zur steuerbaren Reaktionsgenerierung . Preprint 2022.6

Hsuan Su, Pohan Chi, Shih-Cheng Huang, Chung Ho Lam, Saurav Sahay, Shang-Tse Chen, Hung-yi Lee . [PDF]

BBTV2: Auf dem Weg zu einer gradientenfreien Zukunft mit großen Sprachmodellen . EMNLP 2022

Tianxiang Sun, Zhengfu He, Hong Qian, Yunhua Zhou, Xuanjing Huang, Xipeng Qiu . [PDF] [Code]

RLPROMPT: Optimieren diskreter Textaufforderungen mit Verstärkungslernen . EMNLP 2022

Mingkai Deng, Jianyu Wang, Cheng-Ping Hsieh, Yihan Wang, Han Guo, Tianmin Shu, Meng Song, Eric P. Xing, Zhiting Hu . [PDF] [Code]

Clip-Tuning: In Richtung desivatfreies, schnelles Lernens mit einer Mischung aus Belohnungen . Ergebnisse von EMNLP 2022

Yekun Chai, Shuohuan Wang, Yu Sun, Hao Tian, Hua Wu, Haifeng Wang . [PDF]

Tempera: Tester-Zeit-Eingabeaufforderung über Verstärkungslernen . Preprint 2022.11

Tianjun Zhang, Xuezhi Wang, Denny Zhou, Dale Schuurmans, Joseph E. Gonzalez. [PDF] [Code]

Promptboosting: Black-Box-Textklassifizierung mit zehn Vorwärtskarten . Preprint 2022.12

Bairu Hou, Joe O'Connor, Jacob Andreas, Shiyu Chang, Yang Zhang . [PDF]

Multitasking-Vorverschleppung der modularen Aufforderung für chinesisches Lernen von Wenig-Shot-Lernen . ACL 2023

Tianxiang Sun, Zhengfu He, Qin Zhu, Xipeng Qiu, Xuanjing Huang . [PDF]

Wenn Gradientenabstieg auf dieivatfreie Optimierung trifft: eine Übereinstimmung im Black-Box-Szenario . ACL 2023

Chengcheng Han, Liqing Cui, Renyu Zhu, Jianing Wang, Nuo Chen, Qiushi Sun, Xiang Li, Ming Gao . [PDF]

Machen Sie ein prompt basiertes Black-Box-Tuning farbenfroh: Steigern Sie die Verallgemeinerung der Modell aus drei orthogonalen Perspektiven . LEC-Coling 2024

Qiushi Sun, Chengcheng Han, Nuo Chen, Renyu Zhu, Jingyang Gong, Xiang Li, Ming Gao . [PDF]

Zu stimmen oder nicht zu stimmen? Anpassung vorgelöster Darstellungen an verschiedene Aufgaben . Repl4nlp@acl 2019

Matthew E. Peters, Sebastian Ruder, Noah A. Smith . [PDF]

Können Erklärungen nützlich sein, um Black Box -Modelle zu kalibrieren? ACL 2022

Xi ye, Greg Durrett . [PDF] [Code]

CO-Training verbessert das sofortige Lernen für große Sprachmodelle . ICML 2022

Hunter Lang, Monica Agrawal, Yoon Kim, David Sontag . [PDF]

Y-Tuning: Ein effizientes Tuning-Paradigma für groß angelegte vorgebrachte Modelle durch Lernen von Etikettenrepräsentationen . Preprint 2022.2

Yitao Liu, Chenxin an, Xipeng Qiu . [PDF]

LST: Leiter-Nebenabstimmung für Parameter und Speicher-Effizienter Transferlernen . Neurips 2022

Yi-Lin Sung, Jaemin Cho, Mohit Bansal . [PDF] [Code]

Decoder -Tuning: Effizientes Sprachverständnis als Dekodierung . Preprint 2022.12

Ganqu Cui, Wentao Li, Ning Ding, Longao Huang, Zhiyuan Liu, Maosong Sun. [PDF]

Generieren von Datensätzen mit vorbereiteten Sprachmodellen . EMNLP 2021

Timo Schick, Hinrich Schütze . [PDF] [Code]

GPT3MIX: Nutzung großer Sprachmodelle für die Textvergrößerung . Ergebnisse von EMNLP 2021

Kang Min Yoo, Dongju Park, Jaewook Kang, Sang-woo Lee, Woomyeong Park . [PDF] [Code]

Erzeugte Kenntnisse, die für vernünftige Argumentation veranlasst werden . ACL 2022

Jiachen Liu, Alisa Liu, Ximing Lu, Sean Welleck, Peter West, Ronan Le Bras, Yejin Choi, Hannaneh Hajishirzi . [PDF] [Code]

Nulogen: Effizientes Null-Shot-Lernen über Datensatzgenerierung . EMNLP 2022

Jiachen Ye, Jiahui Gao, Qintong Li, Hang Xu, Jiangtao Feng, Zhiyong Wu, Tao Yu, Lingpeng Kong . [PDF] [Code]

Nulogen+: selbst geführte hochwertige Datenerzeugung im effizienten Null-Shot-Lernen . Preprint 2022.2

Jiahui Gao, Renjie Pi, Yong Lin, Hang Xu, Jiachen Ye, Zhiyong Wu, Xiaodan Liang, Zhenguo Li, Lingpeng Kong . [PDF]

Augesc: Dialoger Augmentation mit großen Sprachmodellen für emotionale Unterstützungsgespräche . Ergebnisse der ACL 2023

Chujie Zheng, Safhand Sabour, Jiaxin Wen, Zheng Zhang, Minlie Huang . [PDF]

Generieren von Trainingsdaten mit Sprachmodellen: Auf dem Weg zum Sprachverständnis von Zero-Shot . Neurips 2022

Yu Meng, Jiaxin Huang, Yu Zhang, Jiawei Han [PDF] [Code]

? Zunächst einmal danke, dass Sie sich die Zeit genommen haben, um einen Beitrag zu leisten! ?

Schritte zum Beitrag:

PaperNumber oben auf der Seite entsprechend und senden Sie Ihre Pull -Anfrage. Wir empfehlen, eine sehr kurze Erklärung zu geben, warum Sie glauben, dass ein Papier hinzugefügt oder geändert werden sollte.Mach dir keine Sorgen, wenn du etwas falsch stimmst, werden wir sie für Sie reparieren. Tragen Sie einfach bei und bewerben Sie Ihre großartige Arbeit hier!

Zusätzlich zu den folgenden Mitwirkenden, die Pull -Anfragen eingereicht haben, möchten wir auch Ohad Rubin und Kang Min Yoo für die Empfehlung von Papieren danken.