Chatten Sie mit Ihren Unternehmensdaten mit LLM

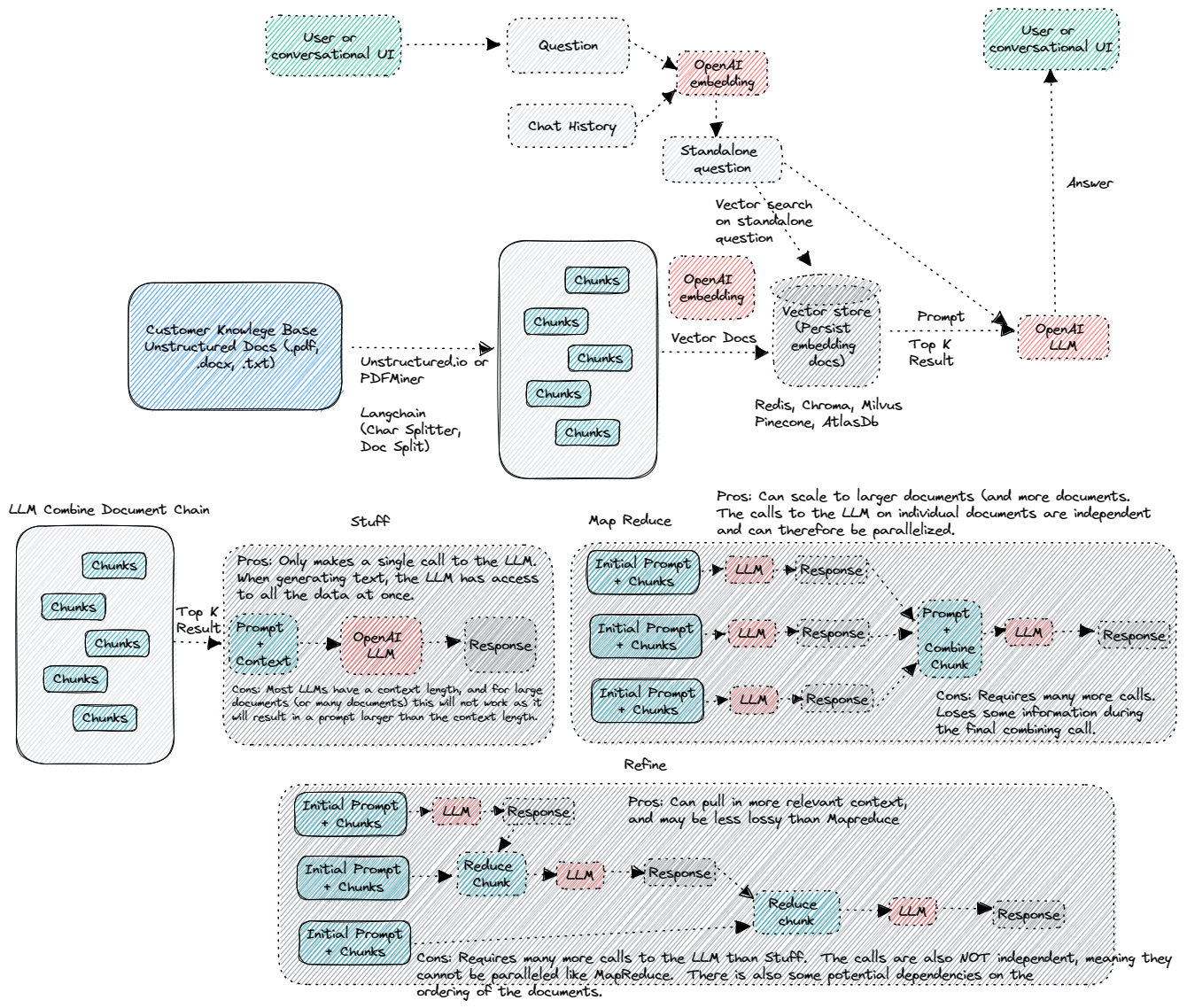

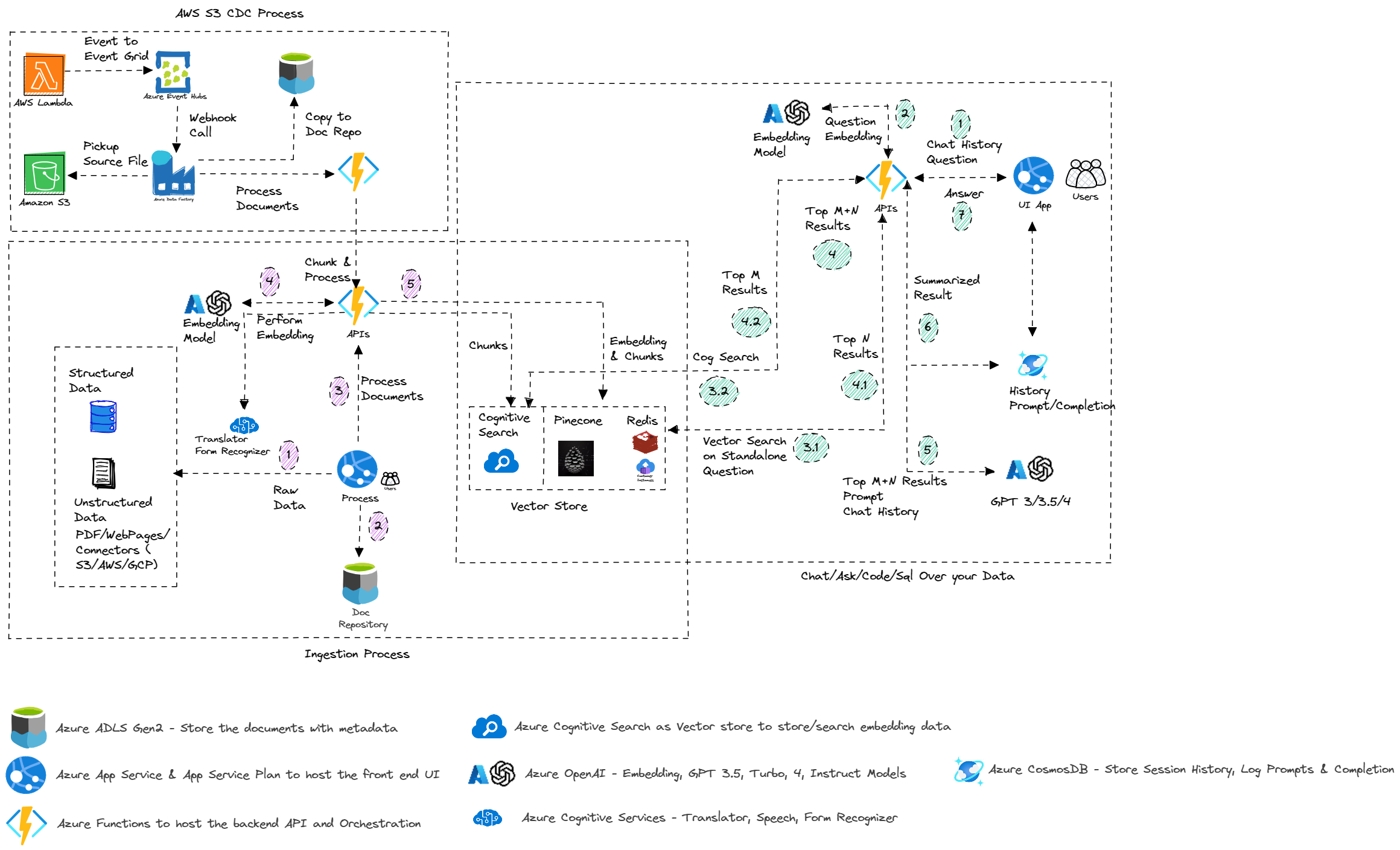

Dieses Beispiel zeigt einige Ansätze zum Erstellen von ChatGPT-ähnlichen Erfahrungen über Ihre eigenen Daten. Es verwendet den Azure OpenAI-Service, um auf das ChatGPT-Modell (GPT-35-Turbo und GPT3) und den Vektorspeicher (Pinecone, Redis und andere) oder die kognitive Suche nach Datenindexierung und -abruf zuzugreifen.

Das Repo bietet eine Möglichkeit, Ihre eigenen Daten hochzuladen, damit es bereit ist, das Ende zu beenden.

Aktualisierungen

- 30.03.2024 - Umgestattet, um Chat-, Chat -Stream-, QNA-, Upload- und Administratorfunktionen zu halten. Alle anderen werden in das eigene Repo verlegt.

- 10.03.2024 - Verschieben

- 09.03.2024 - Erste Version fortschrittlicher RAG -Techniken und multi -modales Lag -Muster

- 28.02.2024 - Entfernte SEC -Analysefunktionen und es wird in das eigene Repo bei SEC verschoben

- 28.01.2024 - Entfernen Sie Pitchbook -Funktionen, während sie in PIB in das eigene Repo verlegt werden

- 19.01.2024 - Aktualisierte das Python -Paket & OpenAI> 1.0. Änderungen an allen Python -API für Bruchänderungen, die in Openai und Langchain eingeführt wurden.

- 10/12/2023 - Erste Version des autonomen Promptflows. Die Unterstützung der Pinecone -Indizes, aber die Unterstützung für kognitive Suche und Redis wird in Kürze aktualisiert.

- 29.09.2023 - Evaluieren Sie den Einlauf hinzu. Eingehend in Azure ML erstellte Eingabeauffluss kann an Ihren vorhandenen Lauf beigefügt werden, um den folgenden Bewertungsprozess zu bewerten:

- BODNETHEME-Der Bewertungsfluss für die Bewertung der Frage und eine Bodness bewertet die Erweiterungssysteme für Fragen und Antworten, indem die hochmodernen Großsprachmodelle (LLM) zur Messung der Qualität und Sicherheit Ihrer Antworten eingesetzt werden. Die Verwendung von GPT-3.5 als Sprachmodell zur Unterstützung von Messungen zielt darauf ab, eine hohe Übereinstimmung mit menschlichen Bewertungen im Vergleich zu herkömmlichen mathematischen Messungen zu erreichen. gpt_groundness (gegen den Kontext): misst, wie geerdet die vorhergesagten Antworten des Modells gegen den Kontext sind. Auch wenn die Antworten von LLM zutreffen, wenn nicht über den Kontext überprüfbar, werden solche Antworten als unbegründet angesehen.

- ADA-Ähnlichkeit-Der Evaluierungsfluss von Q & A ADA_Imilarity bewertet das Q & A Abruf Augmented Generation Systems, indem die hochmodernen großsprachigen Modelle (LLM) zur Messung der Qualität und Sicherheit Ihrer Antworten eingesetzt werden. Die Verwendung von GPT-3.5 als Sprachmodell zur Unterstützung von Messungen zielt darauf ab, eine hohe Übereinstimmung mit menschlichen Bewertungen im Vergleich zu herkömmlichen mathematischen Messungen zu erreichen. Mit dem ADA-Ähnlichkeitsbewertungsfluss können Sie Ihr Modell mit der LLM-assistierten ADA-Ähnlichkeitsmetri-ADA_SIMILARITY bewerten und bewerten. ada_similarity ist ein Wert im Bereich [0, 1].

- Kohärenz-Der Q & A-Kohärenzbewertungsfluss bewertet die Q & A-Abruf-Augmented-Generierungssysteme, indem die hochmodernen Großsprachmodelle (LLM) zur Messung der Qualität und Sicherheit Ihrer Antworten eingesetzt werden. Die Verwendung von GPT-3.5 als Sprachmodell zur Unterstützung von Messungen zielt darauf ab, eine hohe Übereinstimmung mit menschlichen Bewertungen im Vergleich zu herkömmlichen mathematischen Messungen zu erreichen. Mit dem Kohärenzbewertungsfluss können Sie Ihr Modell mit der LLM-unterstützten Kohärenzmetrik bewerten und bewerten. GPT_COHERENZ: Misst die Qualität aller Sätze in der vorhergesagten Antwort eines Modells und wie sie auf natürliche Weise zusammenpassen. Die Kohärenz wird auf einer Skala von 1 bis 5 bewertet, wobei 1 das schlechteste und 5 ist.

- Ähnlichkeit-Der Bewertungsfluss der Frage und A-Ähnlichkeit bewertet die Q & A-Abruf-Augmented-Generierungssysteme, indem die hochmodernen Großsprachmodelle (LLM) eingesetzt werden, um die Qualität und Sicherheit Ihrer Antworten zu messen. Die Verwendung von GPT-3.5 als Sprachmodell zur Unterstützung von Messungen zielt darauf ab, eine hohe Übereinstimmung mit menschlichen Bewertungen im Vergleich zu herkömmlichen mathematischen Messungen zu erreichen. Mit dem Ähnlichkeitsbewertungsfluss können Sie Ihr Modell mit der LLM-unterstützten Ähnlichkeitsmetrik bewerten und bewerten. GPT_SIMILARITY: Misst die Ähnlichkeit zwischen von Benutzer bereitgestellten Grundwahrheitsantworten und der vorhersagten Antwort. Die Ähnlichkeit wird auf einer Skala von 1 bis 5 bewertet, wobei 1 das schlechteste und 5 ist.

- F1-Score-Der Q & A F1-Score-Bewertungsfluss bewertet die Q & A-Abruf-Augmented-Generationssysteme anhand der F1-Score anhand der Wortzahlen in der vorhergesagten Antwort und der Grundwahrheit. Mit dem F1-Score-Bewertungsfluss können Sie die F1-Score-Metrik unter Verwendung der Anzahl gemeinsamer Token zwischen der normalisierten Version der Grundwahrheit und der vorhergesagten Antwort bestimmen. F1-Score: Berechnen Sie den F1-Score basierend auf den Token in der vorhergesagten Antwort und der Grundwahrheit. F1-Score ist ein Wert im Bereich [0, 1]. Die Metrik der Bodenigkeit wird auf einer Skala von 1 bis 5 bewertet, wobei 1 der schlimmste und 5 ist.

- 22.09.2023 - Fügte Eingabeaufforderung für SQLASK hinzu. Stellen Sie sicher, dass die Konfigurationswerte für

PFSQLASK_URL und PFSQLASK_KEY zum bereitgestellten Endpunkt hinzugefügt werden, um die Funktion zu aktivieren. Stellen Sie außerdem sicher, dass die Konfigurationswerte für SynapseName , SynapsePool , SynapseUser und SynapsePassword zur entaoai -Eingabeaufforderung -Verbindung hinzugefügt werden. Verschiebter Löschen der Sitzungsfunktion für Chatgpt auf die Administratorseite. - 20.09.2023 - Die Konfiguration hinzugefügt, damit Endbenutzer den Suchtyp für den kognitiven Suchvektorspeicherindex (Hybrid, Ähnlichkeit/Vektor und Hybrid -Neurang) ändern können, basierend auf den von uns geteilten Best Practices. Qna, Chat und sofortiger Fluss werden geändert. QNA und CHAT implementieren die kundenspezifische Vektorspeicherimplementierung von Langchain und einen sofortigen Fluss mit den Helferfunktionen. Das Problem mit QNA/CHAT/promptflow behoben, das keine Nachuntersuchungen generiert.

- 18.09.2023 - Refactored SQL NLP, um Langchain -Datenbankagent/Kette nicht zu verwenden und stattdessen benutzerdefinierte Eingabeaufforderungen zu verwenden.

- 15.09.2023 - Das Azure -Suchpaket auf 11.4.0b9 und Langchain zur neuesten Version geändert. In der Fähigkeit zur Durchführung der Bewertung des Promitflows sowohl für QNA als auch für Chat wurden hinzugefügt. Bert PDF- und Evaluierungsdaten können verwendet werden, um Stapel und Bewertung im promptierten Fluss durchzuführen. Das Beispiel -Notizbuch, das den Flow- und E2E -Prozess zeigt, ist verfügbar. Mit Bert Chat -Ordner können Sie den E2E -Eingabeaufwand, den Stapellauf und die Bewertung in Form eines Notebooks testen.

- 03.09.2023 - API für den Chat mit dem Eingabeauflauf hinzugefügt. Ermöglichen Sie Endbenutzer, zwischen Azurefunktionen als API (

ApiType -Konfiguration in der Web-App) auszuwählen, oder verwenden Sie den Endpunkt des Eingabeauflaufs. - 02.09.2023 - API zur Beantwortung der Frage mit dem Eingabeauflauf hinzugefügt. Ermöglichen Sie Endbenutzer, zwischen Azurefunktionen als API (

ApiType -Konfiguration in der Web-App) auszuwählen, oder verwenden Sie den Endpunkt des Eingabeauflaufs. - 8/31/2023 - Beispiel für LLMOPs mit einem Eingabeauffluss hinzugefügt. Das Repo fügt die Flexibilität hinzu, um das einkenntnisgebrauchte Modell als Alternative zu aktuellen Azure -Funktionen zu verwenden.

- 20.08.2023 - Unterstützung für die Markdown -Dateien (als ZIP -Datei) und den Chunk_Size = 1 von Azure OpenAmbedding entfernt.

- 8/11/2023 - Das Problem mit der Streaming -Chat -Funktion behoben.

- 8/10/2023 - Brechungsänderungen - Alle Code neu gestaltet, um

OpenAiEndPoint -Konfigurationswert anstelle von OpenAiService zu verwenden. Es soll die Best Practices unterstützen, da sie über das Azure -API -Management in Enterprise -Protokollierung umrissen werden. Ihr OpenAiEndPoint wenn die Verwendung von API -Gateway -URL und der OpenAiKey das Produkt/unbegrenzte Schlüssel ist. Wenn Sie APIM nicht verwenden, müssen Sie den Schlüssel nicht ändern, aber sicherstellen, dass OpenAiEndPoint eine voll qualifizierte URL Ihrer AOAI -Bereitstellung ist. OpenAiService wird nicht mehr verwendet. Änderungen wirkten sich auf die Funktionsweise des Chats in der Stream -Funktion aus, daher sind sie vorerst deaktiviert und werden nach dem getesteten und behobenen Fall aktiviert. - 09.08.2023 - Funktionsfunktion in der Chatgpt -Schnittstelle als Kontrollkästchen hinzugefügt. Die Probe zeigt die Fähigkeit, Funktionen aufzurufen. Derzeit werden Wetter API, Stock API und Bing -Suche unterstützt. Das Funktionsaufruf ist in der Vorschau und wird nur von "API-Version" von "2023-07-01-Preview" unterstützt. Stellen Sie daher sicher, dass Sie die vorhandene Bereitstellung aktualisieren, um diese Version zu verwenden. Details zum Aufrufen von Funktionen. Für die vorhandene Bereitstellung fügen Sie

WeatherEndPoint , WeatherHost , StockEndPoint , StockHost und RapidApiKey -Konfiguration zur Azure -Funktions -App hinzu. - 8/5/2023 - Chat -Schnittstelle mit der Option "Stream" hinzugefügt. Mit dieser Funktion können Sie die Konversation an den Kunden streamen. Sie müssen

OpenAiChat , OpenAiChat16k , OpenAiEmbedding , OpenAiEndPoint , OpenAiKey , OpenAiApiKey , OpenAiService , OpenAiVersion , PineconeEnv , PineconeIndex , PineconeKey , RedisAddress , RedisPassword , RedisPort -Eigenschaft in einem Azure -App -Service (Webappe) (Webappe) für das vorhandene Deaktivieren hinzufügen. - 30.07.2023 - Unbenutzten Code entfernt - Zusammenfassung und Chat

- 28.07.2023 - Entfernen Sie die Nutzung des Davinci -Modells. Vorerst die Verwendung von allen Funktionen außer Workshop entfernt. Die Funktionalität des Zusammenfassungsfunktionen basiert auf dem Feedback, damit der Benutzer die Eingabeaufforderung und die vordefinierten Themen angeben können, um sie zusammenzufassen.

- 26.07.2023 - Entfernen Sie den OpenAI -Spielplatz aus Entwickler -Tools als erweiterte Funktionen, die im Chatgpt -Abschnitt verfügbar sind.

- 25.07.2023 - Fügen Sie die Registerkarte für die Chat -Funktionen hinzu, um die ChatGPT -Funktion direkt aus dem Modell anstelle von "Chat on Data" zu unterstützen. Sie müssen die Eigenschaft

CHATGPT_URL im Azure App -Dienst (WebApp) hinzufügen, um die Funktion außerhalb der Bereitstellung der neuen Azure -Funktion zu aktivieren. - 23.07.2023 - Der Rest der Funktion für die PIB -UI und die erste Version des Generierens des PowerPoint -Decks als Ausgabe wurde hinzugefügt. Für eine neue Funktion, die hinzugefügt wurde, stellen Sie der WebApp -Konfiguration

FMPKEY -Variable hinzu. - 20.07.2023 - Feature hinzugefügt, um mit PIB -Daten zu sprechen (SEC -Anmeldungen und Ertragsaufruf -Transkript). Da

PIBCHAT_URL neue Azure -Funktion bereitgestellt wird - 18.07.2023 - Umgesteckt den PIB -Code, um einige der Leistungsprobleme und Fehler zu lösen.

- 17.07.2023 - Entfernen der GPT3 -Chat -Schnittstelle mit "Davinci" -Modellen.

- 16.07.2023 - Erstversion der PIB -UI (derzeit unterstützt 5 Schritte - Unternehmensprofil, Aufruf -Transkripte, Pressemitteilungen, SEC -Anmeldungen und -bewertungen/Empfehlungen). Sie benötigen Zugriff auf kostenpflichtiges Abonnement (FMP oder ändern Sie basierend auf dem, worauf Ihr Unternehmen Zugriff hat). Um mit FMP zu verwenden, müssen Sie

FmpKey in Azure -Funktionen hinzufügen. Aufgrund der kreisförmigen Abhängigkeit müssen Sie SecDocPersistUrl und SecExtractionUrl manuell in Azurefunktionen manuell hinzufügen. - 14.07.2023 - Fügen Sie Unterstützung für GPT3.5 16K -Modell und die Fähigkeit zum Dokument> 4000 Token mit> 500 Überlappung hinzu. Für das ChunkSize> 4000 wird es sowohl für QNA- als auch für die Chat -Funktionalität standardmäßig 16k Token. Identitätsanbieter zur Anwendung und Authentifizierung für QNA und Chat -Schnittstelle hinzugefügt. Für GPT3.5 16K -Modell müssen Sie die

OpenAiChat16k -Eigenschaft in der Azure -Funktions -App hinzufügen. - 13.07.2023 - Ermöglichen Sie dem Endbenutzer, die Konfiguration von Chunkize und Chunverlap auszuwählen. Erste Version der übergeordneten Eingabeaufforderung Vorlage.

- 7/11/2023 - Funktionales PIB -Copilot in Form des Notizbuchs.

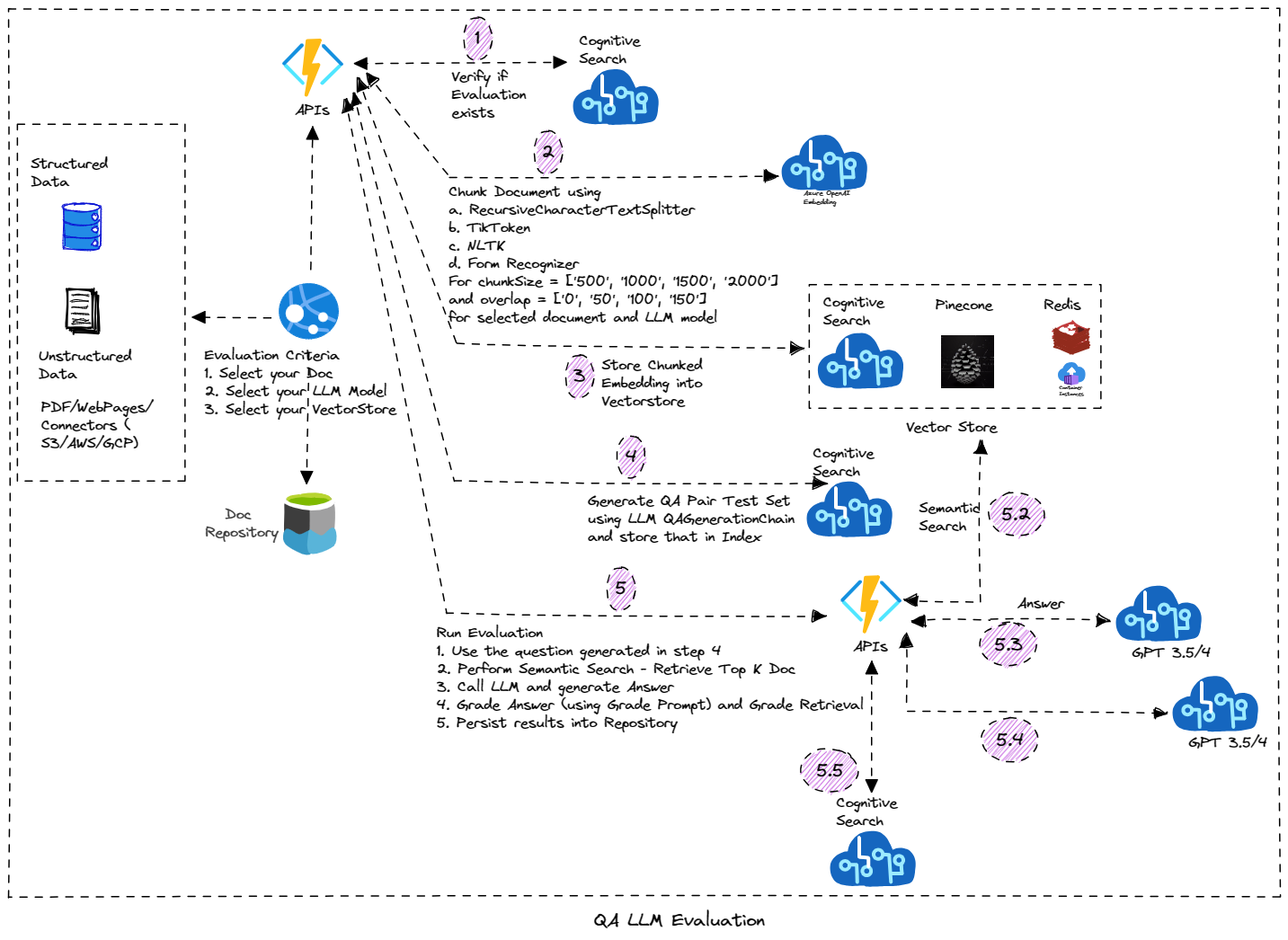

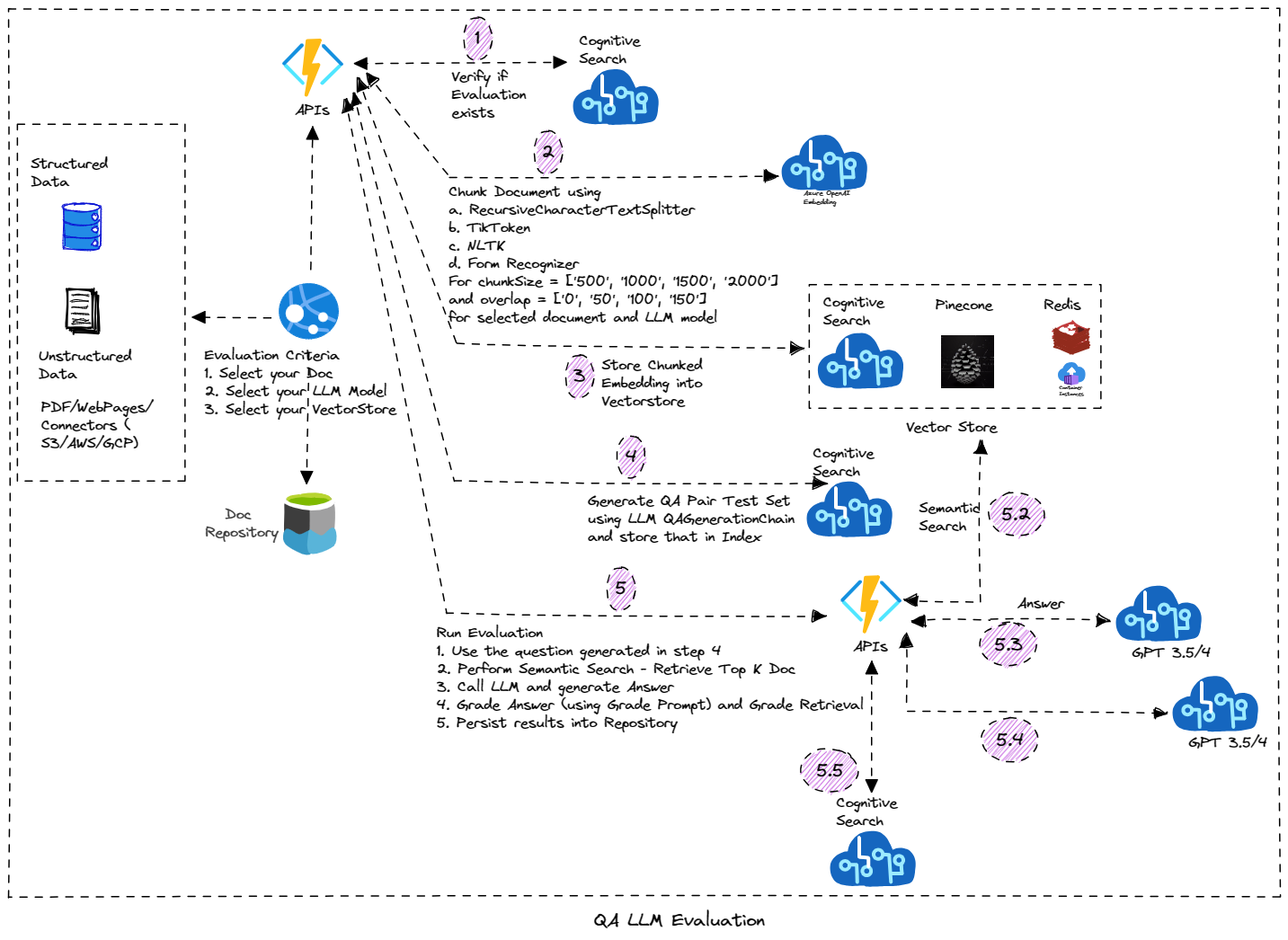

- 7/8/2023 - Die Funktion wurde hinzugefügt, um die Sitzung für ChatGPT umzubenennen. Außerdem wurde die Benutzeroberfläche für das Evaluator -Tool hinzugefügt. Diese Funktion konzentriert sich auf die Durchführung der LLM -basierten Bewertung auf Ihrem Dokument. Es generiert automatisch den Testdatensatz (mit Frage und Antworten) und die Bewertung dieses Dokuments unter Verwendung verschiedener Parameter aus und generiert die Bewertungsergebnisse. Es basiert auf Azure -dauerhaften Funktionen und wird unter Verwendung des Funktionskettenmusters implementiert. Sie müssen

BLOB_EVALUATOR_CONTAINER_NAME (sicherstellen, dass der gleiche Container -Name in Speicherkonto erstellt wird) und RUNEVALUATION_URL (URL der dauerhaften Funktionsbereitstellung) in der Azure -Web -App für die vorhandene Bereitstellung und wenn Sie die Evaluator -Funktion verwenden möchten. In der Azure Function -Bereitstellung addieren Sie AzureWebJobsFeatureFlags (Value Enable WorkerIndexing) und OpenAiEvaluatorContainer -Einstellungen. - 7/5/2023 - Die Funktion wurde hinzugefügt, um die Sitzung zu löschen. Diese Funktion erfordert die Feature, die sich in der Vorschau befindet, und Sie müssen dies auf dem CosmosDB -Konto in Ihrem Abonnement aktivieren. Einfacher Try/Catch -Block hinzugefügt, falls Sie den CosmosDB nicht aktiviert/bereitgestellt haben, um die ChatGPT -Implementierung fortzusetzen.

- 7/4/2023 - Erste Version des Speicherns "Sitzungen" für GPT3.5/CHATGPT -Schnittstelle. Sitzung und Nachrichten werden aus CosmosDB gespeichert/abgerufen. Stellen Sie sicher, dass Sie CosmosDB -Dienst vorbereitet haben, oder erstellen Sie eine neue (für die vorhandene Bereitstellung). Sie müssen

CosmosEndpoint , CosmosKey , CosmosDatabase und CosmosContainer -Einstellungen in Azure -Funktions -App- und Web -App hinzufügen. - 25.06.2023 - Notizbuch mit der Bewertung der Antwortqualität auf systematische Weise (Autogenerierung Fragen und Bewertungskette), unterstützende LLM -QA -Einstellungen (Chunk -Größe, Überlappung, Einbettungstechnik). Weitere Informationen finden Sie im Evaluator -Notizbuch.

- 18.06.2023 - Fügen Sie die Administratorseite hinzu, die das Wissensbasismanagement unterstützt.

- 17.06.2023 - Die Schaltfläche "Fragenliste" hinzugefügt, um eine Fragen zu stellen, um die Liste aller Fragen anzuzeigen, die sich in der Wissensbasis befinden. Nach drei Eigenschaften

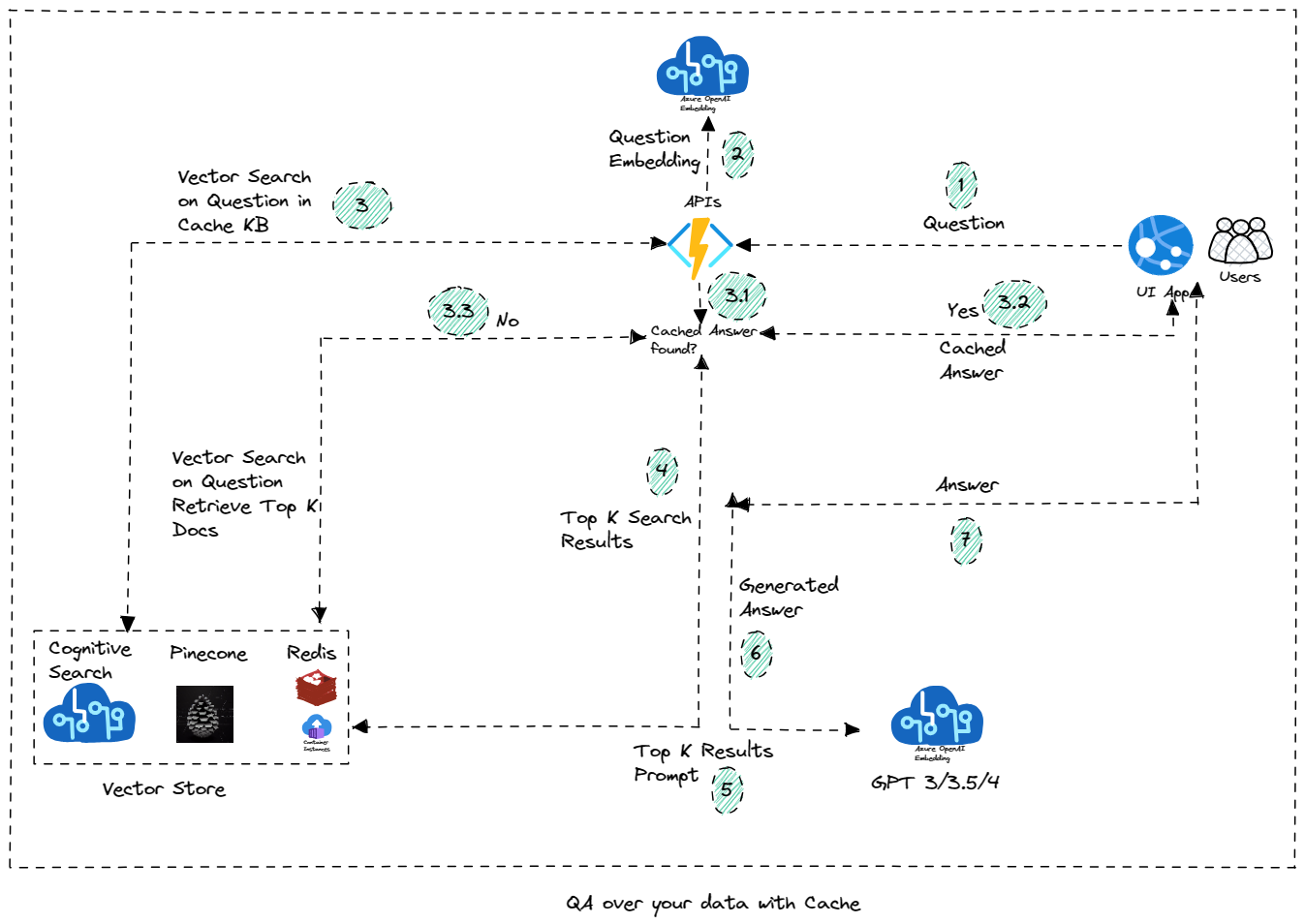

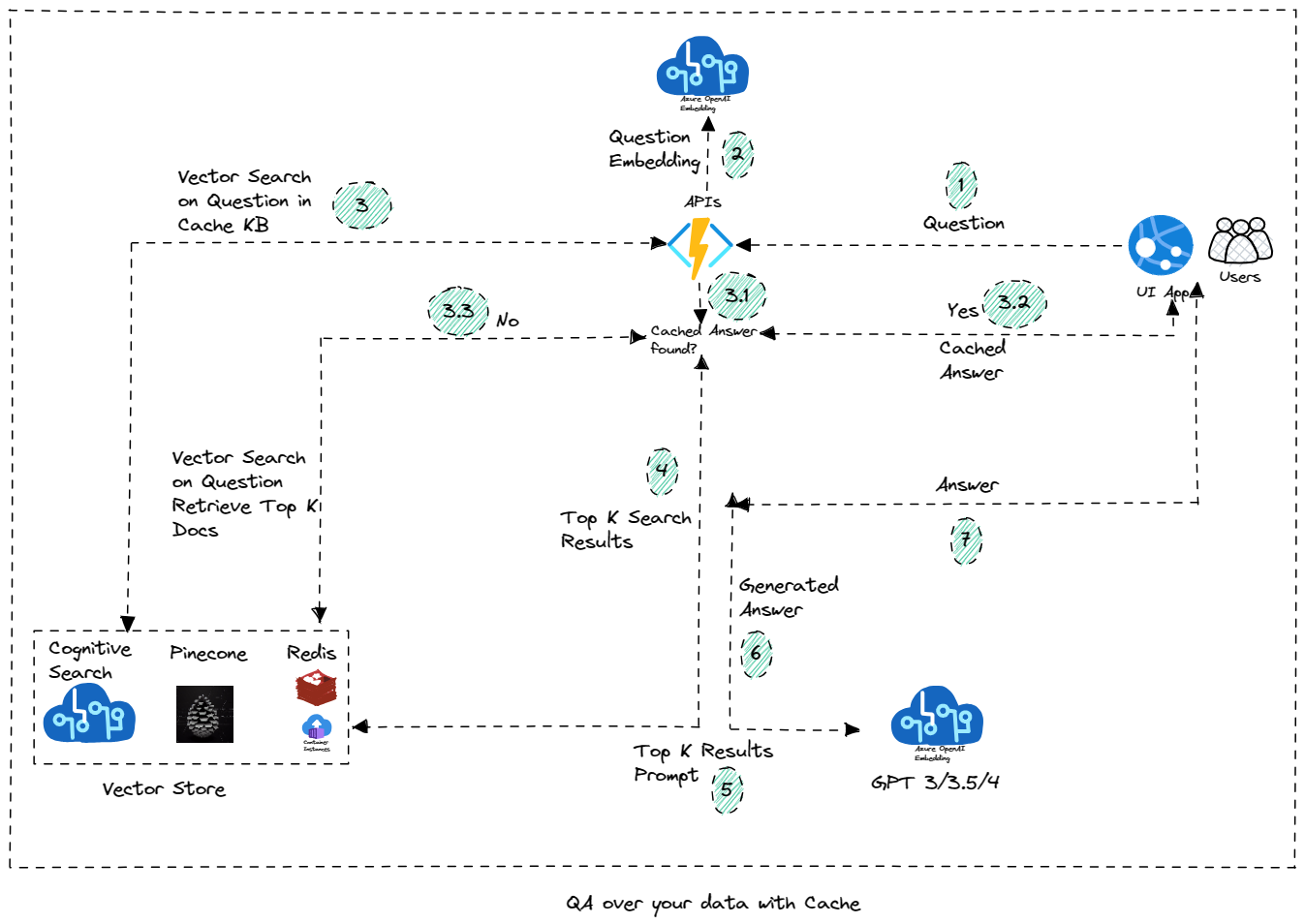

SEARCHSERVICE , SEARCHKEY und KBINDEXNAME (Standardwert von AOAIKB) müssen dem Azure App -Dienst hinzugefügt werden, um die Schaltfläche "Fragenliste" zu aktivieren. - 16.06.2023 - Fügen Sie die Funktion hinzu, um die azure -kognitive Suche als Vektorspeicher zum Speichern der zwischengespeicherten Wissensbasis zu verwenden. Die Fragen, die nicht in KB sind, werden an das LLM -Modell gesendet, um die Antwort über OAI zu finden, oder sie wird aus dem zwischengespeicherten Datenspeicher zurückgeführt. Neue Eigenschaft

KbIndexName muss zur Azure -Funktions -App hinzugefügt werden. Das Notizbuch wurde hinzugefügt, um die Funktion als Teil des Workshops zu testen. TODO: Fügen Sie die Funktion hinzu, um die Frage von der Chat -Schnittstelle zu KB hinzuzufügen (und es auf Sitzung basieren). Eine weitere Funktion zur "Regenerierung" -Tots von LLM (anstelle von zwischengespeicherter Antwort) wird in Kürze hinzugefügt. - 07.06.2023 - Fügen Sie den OpenAI -Spielplatz in Entwickler -Tools und die erste Version des Erstellens des Copilot hinzu (im Moment mit Notebook, wird jedoch schließlich als Copilot -Funktion verschoben). Fügen Sie das Skript, Aufzeichnung und Beispiel für Echtzeit-Sprachanalyse-Nutzungsfall hinzu. Weitere bald hinzugefügt werden.

- 27.05.2023 - Fügen Sie Workshop -Inhalte in Form der Notizbücher hinzu, die genutzt werden können, um die Szenarien zu lernen/auszuführen. Sie finden die Notizbücher im Workshop -Ordner. Details zu Workshop -Inhalten finden Sie hier.

- 26.05.2023 - Fügen Sie die Summarisierungsfunktion hinzu, um das Dokument entweder mit Dingen, MapReduce oder Frecing Summarization zusammenzufassen. Um diese Funktion (zur vorhandenen Bereitstellung) zu verwenden, stellen Sie sicher, dass Sie die Konfiguration

OpenAiSummaryContainer zur Funktions -App und der Konfiguration BLOB_SUMMARY_CONTAINER_NAME zum Azure -App -Dienst hinzufügen (Stellen Sie sicher, dass der Wert, den Sie eingeben, mit dem Containernamen im Azure -Speicher und den Sie den Container erstellt haben). Sie müssen auch die Konfiguration PROCESSSUMMARY_URL zum Azure -App -Dienst hinzufügen (stellen Sie sicher, dass der von Ihnen eingegebene Wert mit der URL der Azure -Funktion übereinstimmt). - 25.05.2023 - Fügen Sie eine Funktion hinzu, um CSV -Dateien und CSV -Agenten hochzuladen, um Fragen in den tabellarischen Daten zu beantworten/zu chatten. Smart Agent unterstützt auch die Beantwortung von Fragen zu CSV -Daten.

- 22.05.2023 - Erste Version von "Smart Agent", mit der Sie mit allen in der Lösung hochgeladenen Dokumenten sprechen können. Sie können auch mit dem SQL -Datenbankszenario sprechen. Wenn weitere Funktionen hinzugefügt werden, baut Agent weiter darauf auf (beispielsweise mit CSV/Excel- oder Tabellendaten).

- 21.05.2023 - Abschnitt Entwickler -Tools hinzufügen - Experimentelle Codekonvertierung und formulierende Guru.

- 17.05.2023 - Ändern Sie die Edgar -Quelle in den kognitiven Suchvektorspeicher anstelle von Redis.

- 15.05.2023 - Fügen Sie die Option zur Verwendung "Kognitiver Suche" als Vektorspeicher zum Speichern des Index hinzu. Azure Cognitive Search bietet reine Vektorsuche und hybrides Abruf sowie ein ausgeklügeltes Wiederholungssystem, das von Bing in einer einzigen integrierten Lösung betrieben wird. Melden Sie sich an. Unterstützen Sie das Hochladen von Wortdokumenten.

- 5/10/2023 - Fügen Sie die Optionen hinzu, wie das Dokumenten unterteilt werden soll. Wenn Sie den Formularerkenner verwenden möchten, stellen Sie sicher, dass die Formularerkennungsressource erstellt wird und die entsprechenden Anwendungseinstellungen

FormRecognizerKey und FormRecognizerEndPoint konfiguriert sind. - 5/07/2023 - Option zur Auswahl von Azure Openai oder OpenAI verfügbar. Für OpenAI stellen Sie sicher, dass Sie

OpenAiApiKey in Azure -Funktionen haben. Für Azure OpenAI benötigen Sie OpenAiKey , OpenAiService und OpenAiEndPoint -Endpunkteinstellungen. Sie können auch diese Option für Chat/Frage/SQL NLP/Sprachanalyse und andere Funktionen (von der Seite Entwicklereinstellungen) auswählen. - 5/03/2023 - Kennwort für Upload und eingeführte Administratorseite beginnend mit Indexverwaltung

- 30.04.2023 - Erstversion der Funktion "Task Agent" hinzugefügt. Autonome Agenten sind Agenten, die langhafter sind. Sie geben ihnen ein oder mehrere langfristige Ziele und sie führen unabhängig von diesen Zielen aus. Die Anwendungen kombinieren die Werkzeugverwendung und den Langzeitspeicher. Die erste Funktion implementiert Baby AGI mit Ausführungstools

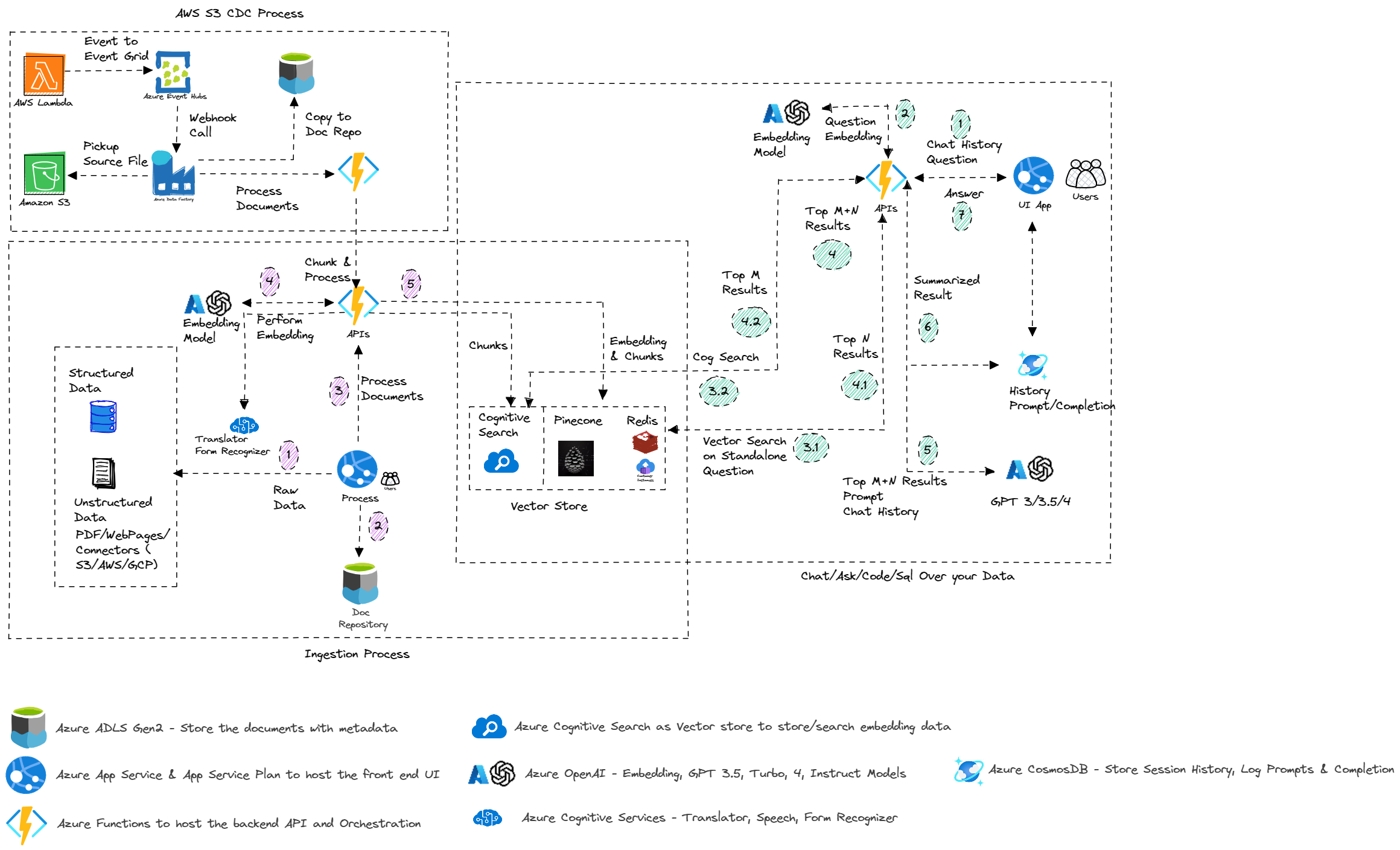

- 29.04.2023 - AWS S3 -Prozessintegration mit S3, AWS Lambda -Funktion und Azure -Datenfabrik (automatisierte Bereitstellung noch nicht verfügbar, Skripte sind im Ordner/Bereitstellung/AWS verfügbar)

- 28.04.2023 - Beheben Sie Fehler, Zitate und Folgefragen in der gesamten QA und Chat. Eingehend restriktiver, um die Reaktion aus dem Dokument einzuschränken.

- 25.04.2023 - Erstversion des Virtual Agents von Power

- 21.04.2023 - Fügen Sie SQL NLP SQL Query & SQL -Daten hinzu und beheben Sie Zitate und Folgefragen für Chat & Frag Features

- 17.04.2023 - Echtzeit -Sprachanalyse und Sprache zu Text und Text zu Sprache für Chat & Fragen. (Sie können Text zu Sprachfunktionen aus den Entwicklereinstellungen konfigurieren. Sie benötigen Azure -Sprachdienste.)

- 13.04.2023 - Fügen Sie eine neue Funktion hinzu, um zu unterstützen, um Fragen zu mehreren Dokumenten mit dem Vektor -QA -Agenten zu stellen

- 08.04.2023 - Fragen Sie Ihre SQL - mithilfe von SQL -Datenbankagenten oder mithilfe der SQL -Datenbankkette

- 29.03.2023 - Automatisches Bereitstellungsskript

- 23.03.2023 - Fügen Sie die kognitive Suche als Option zum Speichern von Dokumenten hinzu

- 19.03.2023 - Hinzufügen von GPT3 -Chat -Implementierung

- 18.03.2023 - API zur Erstellung einer Zusammenfassung zu Dokumenten & Beispiel -QS

- 17.03.2023

- Unterstützen Sie das Hochladen mehrerer Dokumente

- Fehlerbehebung - Redis VectorStore -Implementierung

- 16.01.2023 - Erstveröffentlichung, fragen Sie Ihre Daten und chatten Sie mit Ihren Daten

Testwebsite

Chat und fragen Sie Ihre Daten

Merkmale

Liste der Funktionen

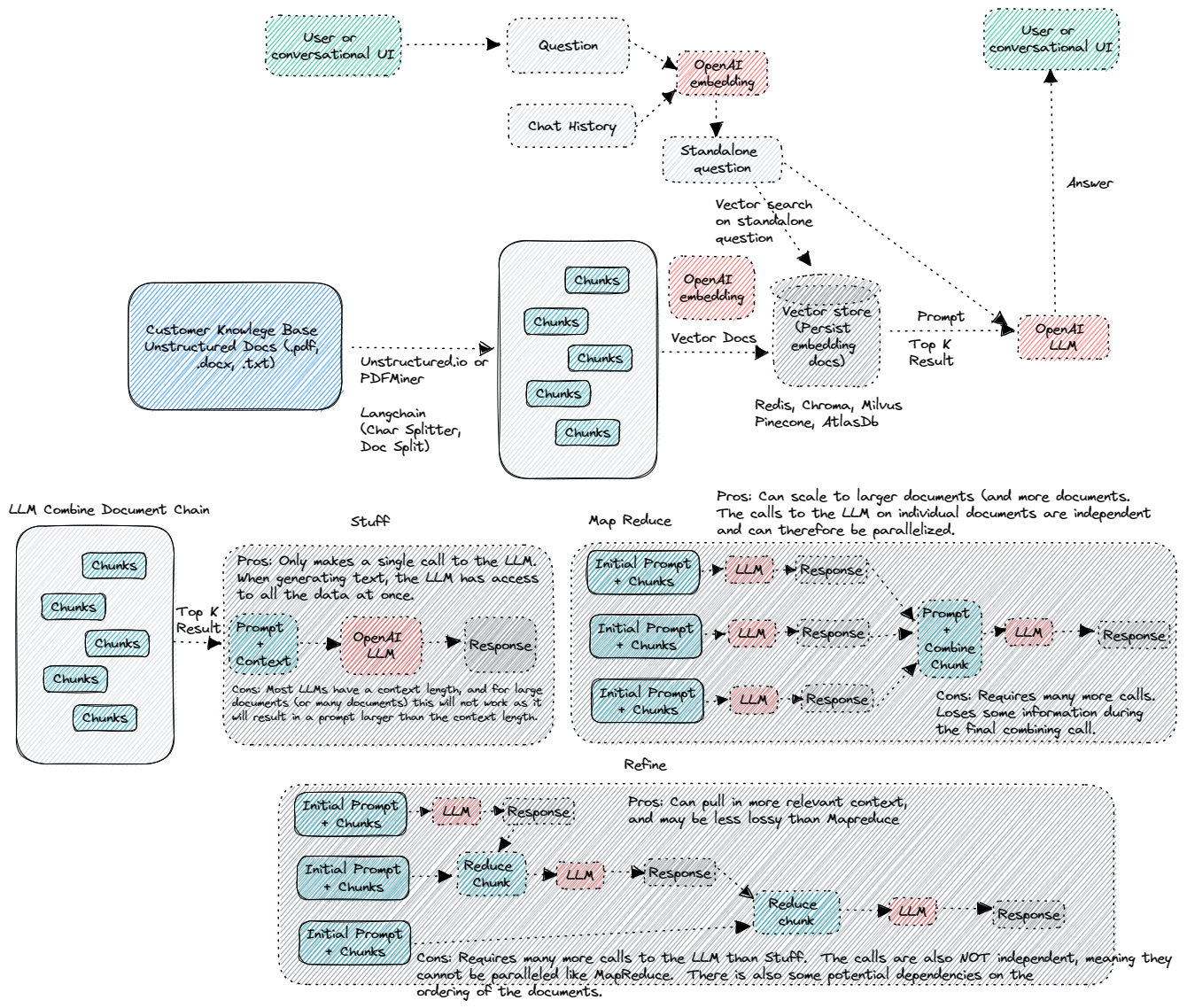

Architektur

Azure Architektur

QA über Ihre Daten mit Cache

QA LLM -Bewertung

Erste Schritte

Fangen an

Konfiguration

Anwendungs- und Funktions -App -Konfiguration

Ressourcen

- Revolutionieren

- Azure kognitive Suche

- Azure Openai Service

- Redis -Suche

- Tannenzapfen

- Kognitiver Suchvektor Store

Beiträge

Wir sind offen für Beiträge, unabhängig davon, ob es sich um neue Funktionen handelt, die vorhandene Funktionen oder eine bessere Dokumentation aktualisieren. Bitte erstellen Sie eine Pull -Anfrage und wir werden sie überprüfen und zusammenführen.

Notiz

Aus dem Repo in Openai-Cogsearch, Call Center Analytics, Auto Evaluator und Edgar Crawler adaptiert