【2024.06.13】 Support MiniCPM-Llama3-V-2_5 Modell, ändern Sie die Umgebungsvariable MODEL_NAME=minicpm-v PROMPT_NAME=minicpm-v DTYPE=bfloat16

[2024.06.12] Unterstützen Sie das GLM-4V -Modell, ändern Sie die Umgebungsvariablenmodell_Name PROMPT_NAME=glm-4v MODEL_NAME=glm-4v DTYPE=bfloat16

【2024.06.08】 Das QWEN2 -Modell wurde unterstützt, ändern Sie die Umgebungsvariable MODEL_NAME=qwen2 PROMPT_NAME=qwen2

【2024.06.05】 Unterstützen Sie das GLM4 -Modell und ändern Sie die Umgebungsvariable MODEL_NAME=chatglm4 PROMPT_NAME=chatglm4

【2024.04.18】 Support Code Qwen -Modell, SQL Q & A -Demo

【2024.04.16】 Support Rerank -Neuordnung Modell, Nutzungsmethode

【 QWEN1.5 】 Die Umgebungsvariable MODEL_NAME=qwen2 PROMPT_NAME=qwen2

Für weitere Neuigkeiten und Geschichte gehen Sie bitte hierher

Hauptinhalt dieses Projekts

Dieses Projekt implementiert eine einheitliche Backend -Schnittstelle für die Begründung von Open Source Large -Modellen, was mit der Reaktion von OpenAI übereinstimmt und die folgenden Eigenschaften aufweist:

Rufen Sie verschiedene Open -Source -Modelle in Form von OpenAI ChatGPT API an

? ️ unterstützt die Streaming -Reaktion, um Druckereffekte zu erreichen

Implementieren Sie ein Text -Einbettungsmodell, um die Q & A zu unterstützen

? ️ unterstützt verschiedene Funktionen von langchain , einem großflächigen Sprachmodellentwicklungswerkzeug,

? Sie müssen nur die Umgebungsvariablen chatgpt ändern

Unterstützt die Belastung selbst ausgestatteter lora Modelle

⚡ Unterstützung der VLLM -Inferenzbeschleunigung und Verarbeitung von gleichzeitigen Anfragen

| Kapitel | beschreiben |

|---|---|

| ? | Open -Source -Modelle, die von diesem Projekt und kurzen Informationen unterstützt werden |

| Startmethode | Umgebungskonfigurations- und Startbefehle für Startmodelle |

| ⚡VLLM Startup -Methode | Umgebungskonfigurations- und Startbefehle für Startmodelle mit vLLM |

| Anrufmethode | Wie rufe ich nach dem Start des Modells an |

| ❓faq | Antworten auf einige FAQs |

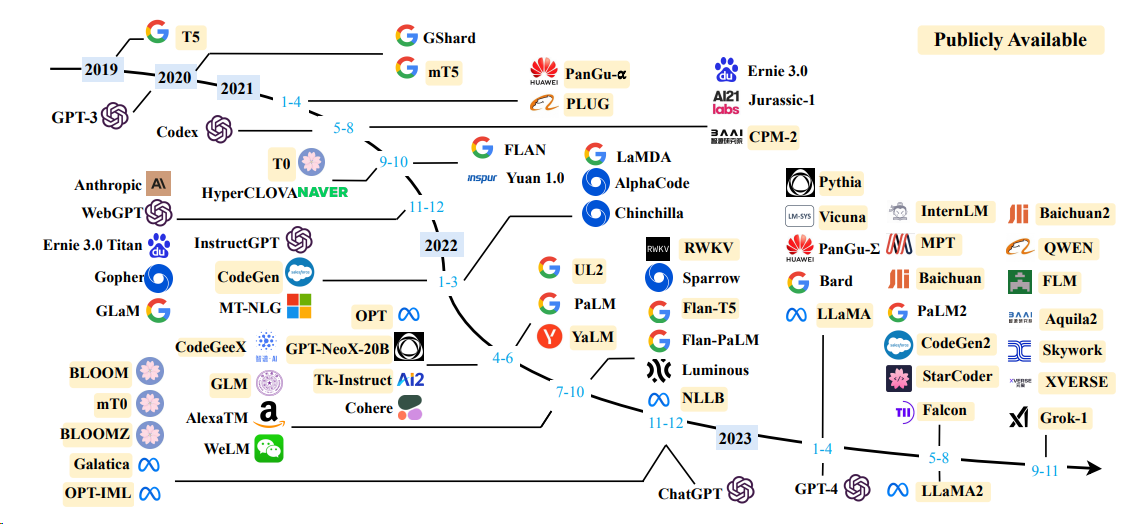

Sprachmodell

| Modell | Modellparametergröße |

|---|---|

| Baichuan | 7b/13b |

| Chatglm | 6b |

| Deepseek | 7b/16b/67b/236b |

| Internlm | 7b/20b |

| Lama | 7b/13b/33b/65b |

| LAMA-2 | 7b/13b/70b |

| Lama-3 | 8b/70b |

| Qwen | 1,8b/7b/14b/72b |

| Qwen1.5 | 0,5b/1,8b/4b/7b/14b/32b/72b/110b |

| Qwen2 | 0,5b/1,5b/7b/57b/72b |

| Yi (1/1,5) | 6b/9b/34b |

Weitere Informationen finden Sie in der VLLM -Startmethode und der Transformators Startup -Methode.

Einbettungsmodell

| Modell | Dimension | Gewichtsverbindung |

|---|---|---|

| bge-large-zh | 1024 | bge-large-zh |

| M3E-Large | 1024 | Moka-AI/M3E-Large |

| text2VEC-large-chinese | 1024 | text2VEC-large-chinese |

| BCE-Embedding-Base_v1 (empfohlen) | 768 | BCE-Embedding-Base_V1 |

OPENAI_API_KEY : Füllen Sie hier einfach eine Zeichenfolge aus

OPENAI_API_BASE : Die Schnittstellenadresse des Backend -Startups wie: http: //192.168.0.xx: 80/v1

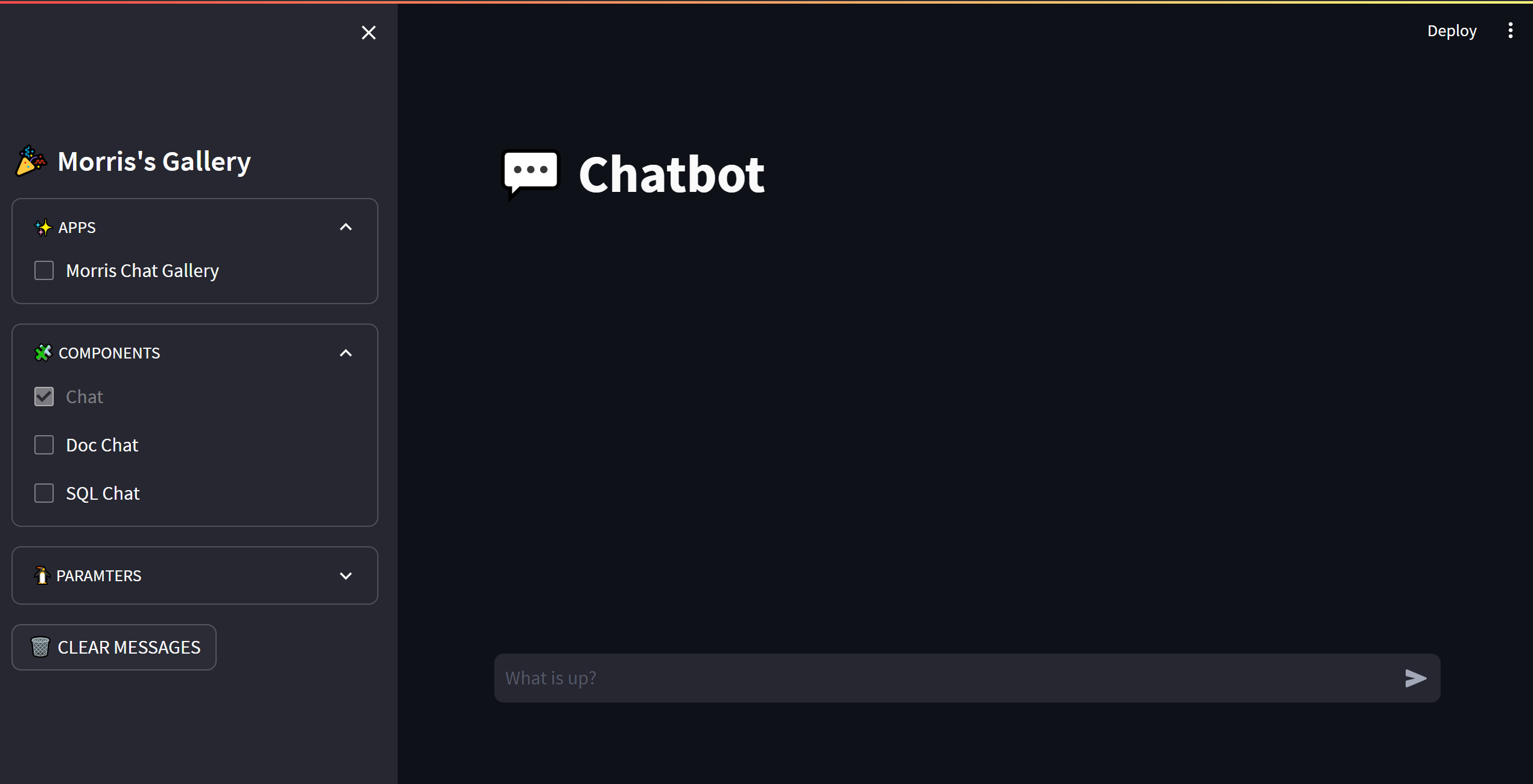

cd streamlit-demo

pip install -r requirements.txt

streamlit run streamlit_app.py

from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "你好" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion )

# 你好!我是人工智能助手 ChatGLM3-6B,很高兴见到你,欢迎问我任何问题。

# stream = client.chat.completions.create(

# messages=[

# {

# "role": "user",

# "content": "感冒了怎么办",

# }

# ],

# model="gpt-3.5-turbo",

# stream=True,

# )

# for part in stream:

# print(part.choices[0].delta.content or "", end="", flush=True) from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

completion = client . completions . create (

model = "gpt-3.5-turbo" ,

prompt = "你好" ,

)

print ( completion )

# 你好!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。 from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# compute the embedding of the text

embedding = client . embeddings . create (

input = "你好" ,

model = "text-embedding-ada-002"

)

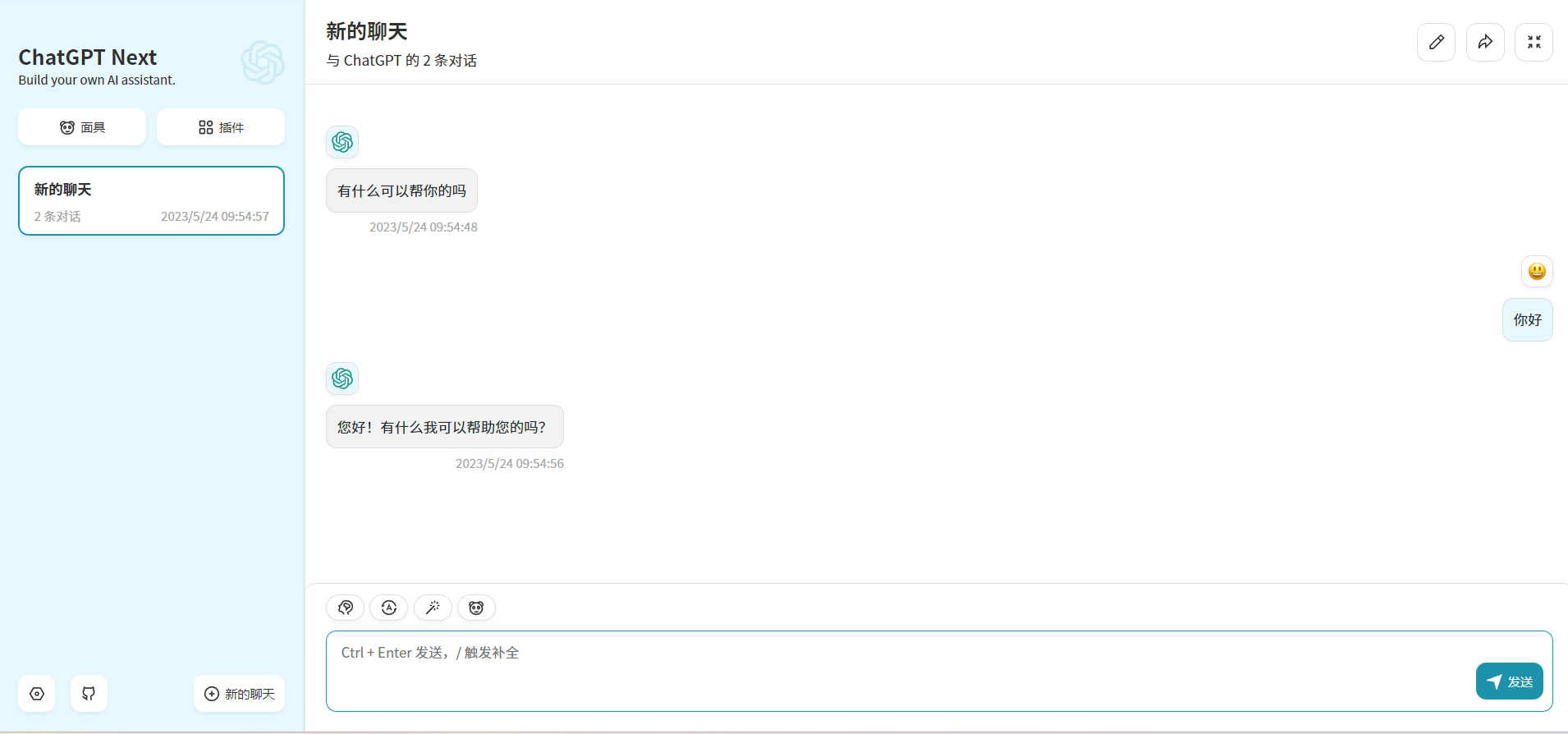

print ( embedding ) Durch Ändern OPENAI_API_BASE können die meisten chatgpt -Anwendungen und Front-End-Projekte nahtlos miteinander verbunden werden!

docker run -d -p 3000:3000

-e OPENAI_API_KEY= " sk-xxxx "

-e BASE_URL= " http://192.168.0.xx:80 "

yidadaa/chatgpt-next-web

# 在docker-compose.yml中的api和worker服务中添加以下环境变量

OPENAI_API_BASE: http://192.168.0.xx:80/v1

DISABLE_PROVIDER_CONFIG_VALIDATION: ' true '

Dieses Projekt ist unter der Lizenz Apache 2.0 lizenziert. Weitere Informationen finden Sie in der Lizenzdatei.

Chatglm: Ein offenes zweisprachiges Dialogsprachmodell

Blüte: Ein mehrsprachiges Sprachmodell mit 176B-Parameter Open-Access

LAMA: Offene und effiziente Foundation -Sprachmodelle

Effiziente und effektive Textkodierung für chinesisches Lama und Alpaka

Phoenix: Demokratisierung von Chatgpt über Sprachen hinweg

MOS

Fastchat: Eine offene Plattform zum Training, Servieren und Bewerten von großsprachigen modellbasierten Chatbots

Langchain: Bauen von Anwendungen mit LLMs durch Kompositionsfähigkeit

Chuanhuchatgpt