Generieren Sie Spiele und Programme mit OpenAI -Agenten. Aufbauten auf Microsoft Autogen.

Euen In Arbeit arbeiten

Der aktuelle Code funktioniert jedoch:

- Es gibt und wird es geben, um Änderungen zu brechen:

- Überprüfen Sie immer

env.sample.jsoncob Ihre versteckte.env.jsonc.- Aktualisieren Sie Ihre Abhängigkeiten immer über

poetry install.- Es muss viel optimiert werden, um die Nutzung der Token drastisch zu reduzieren: Caching, Schritte zu Schritt, Konversationsplassifizierung, bessere Aufforderungen.

- Der Code muss etwas aufräumen.

- Microsoft Autogen befindet sich noch im frühen Stadium und enthält einige Fehler.

- Viele hartcodierte Dinge können über Konfigurationsdateien anpassbar sein.

- Ich werde zunächst nur auf ein paar Programmiersprachen konzentrieren.

Es gibt einige erstaunliche Projekte, die ähnliche Dinge machen, aber ich hoffe, einen Weg zu finden, um ehrgeizige Programme zu erzeugen.

Sie benötigen entweder einen OpenAI -API -Schlüssel oder einen Azure OpenAI -API -Schlüssel.

Verlassen Sie sich nicht auf GPT-3.5 , ob turbo oder Standard, für mehr als nur "Beispiele" -Programme. Wenn Sie komplexere Anwendungen anstreben, ist GPT-4 ein Muss, vorzugsweise sogar GPT-4-32k .

Die Verwendung der OpenAI -API kann Ihre Token -Grenze schnell erschöpfen. Für umfangreichere Projekte wird die Azure OpenAI -API empfohlen.

Beachten Sie die Kosten , wenn Sie ehrgeizige Ziele haben! Überwachen Sie immer die Nutzung des Tokens und die, was Ihre Agenten tun. Während KI ein leistungsstarkes Werkzeug sein kann, ist es nicht unbedingt billiger als die Einstellung echter Entwickler -?

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc Bearbeiten Sie Ihren env.json , um Ihre API -Schlüssel hinzuzufügen, und passen Sie Ihre Installation an.

Nur:

make run OADS generiert den Programmquellcode automatisch in ./project Directory.

Sie können es über:

make cleanWichtig: Funktionen funktionieren nicht.

Nach dem, was ich getestet habe, scheint Autogen mit jeder Open -Source -LLM zu arbeiten, die von der Web -Benutzeroberfläche der Textgenerierung unterstützt wird.

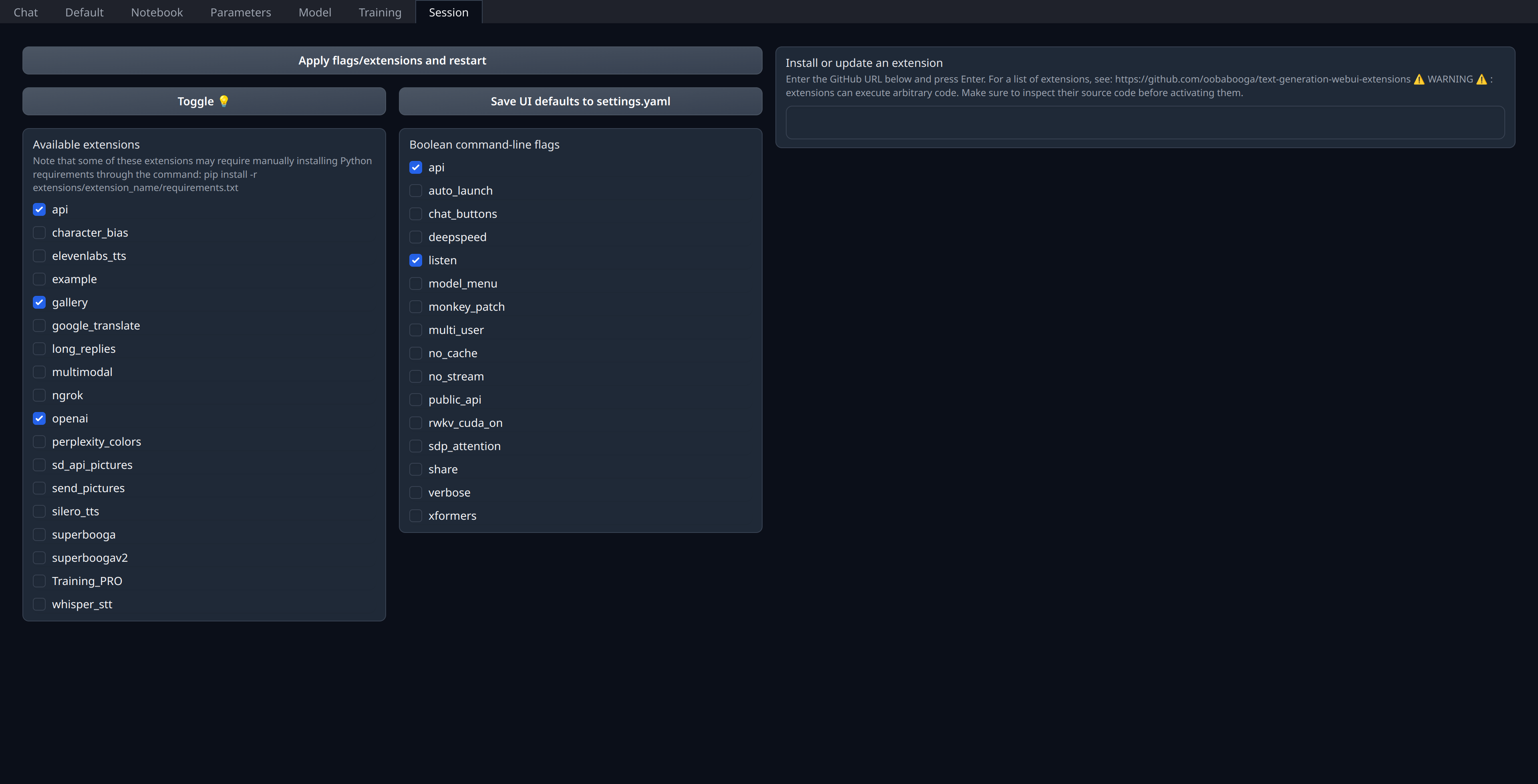

Sie müssen nur openai -Erweiterung auf der Registerkarte "Sitzung" der Web -Benutzeroberfläche aktivieren:

Achten Sie darauf, dass Ihr 5001 Port geöffnet oder gebunden ist, wenn es sich um einen Remote-Server handelt, da die OpenAI-ähnliche API freigelegt wird.

Ich persönlich bereitete meine aktuellen Modelle auf Runpod (nicht verbunden) und verwende thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest Image, obwohl ich denke, dass es in Bezug auf lama.cpp & co etwas veraltet zu sein scheint.

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,