In jüngster Zeit haben die Turbulenzen um die OpenAI- und Sora-Projekte die Außenwelt beunruhigt über die geschäftige KI-Videobranche.

Ende September trafen sich Mira Murati, Chief Technology Officer von OpenAI, und Barrett Zoff, Vizepräsident für Forschung, der eine wichtige Rolle bei der Entwicklung der Modelle o1, GPT-4o und GPT-4v spielte Forschungsbeauftragter Bob McGrew kündigte ebenfalls ihre Abgänge an.

Am 4. Oktober gab Sora-Projektleiter Tim Brooks offiziell seinen Rücktritt auf der sozialen Plattform X bekannt und trat Google DeepMind bei.

Wenn man es zusammen mit der Tatsache isst, dass es keinen definitiven Zeitplan für die offizielle Version von Sora gibt, wird es wie ein bekanntes Drama sein, in dem die Blase eines Starprojekts platzt und jeder im Spiel seine eigenen Pläne hat.

In letzter Zeit wird der KI-Videowettbewerb immer intensiver.

Laut Statistiken von SimilarWeb betrug die Gesamtzahl der Besuche auf der Luma AI-Website des weltweit führenden KI-Videogenerierungsunternehmens im September nur 11,81 Millionen Mal, was einem Rückgang von 38,49 % gegenüber dem Vormonat entspricht. Auch der Erfolgshit Pika verzeichnete im September einen Rückgang der Gesamtbesuche. Obwohl es in der neuen Version im Oktober mit einer Reihe neuer Template-Effekte wieder populär wurde, tauchte nach und nach die Frage auf, wie das Produkt weiterhin das Interesse der Benutzer wecken kann.

Einige, die Sora zunächst misstrauisch gegenüberstanden, werden jetzt neu bewertet, wie zum Beispiel der Filmemacher Patrick Cederberg, der im April sagte, dass er das Modell Hunderte von Kurzclips generieren lassen musste, bevor er einen verfügbaren Kurzclip finden konnte. Mit anderen Worten: Sora ist sehr schwierig zu verwenden.

Glücklicherweise hat sich Tim Brooks noch nicht von KI-Videos verabschiedet. Er wird sich höchstwahrscheinlich dem KI-Videogenerierungstool Veo von DeepMind anschließen. Der Aufstieg und Fall von Sora ist möglicherweise nicht der einzige Maßstab für die KI-Videobranche. Zumindest in Bezug auf die Fähigkeiten behaupten Herausforderer wie Meta Movie Gen, Sora getötet zu haben. Auch das inländische KI-Videoprodukt-Ökosystem hat neue Veränderungen erfahren.

Die Abkühlung der KI-Videospur ist mit anderen Worten auch die Entwicklungszeit, bevor die nächste Charge besserer Produkte herausgebracht wird. In letzter Zeit scheint ein ausreichend erstaunliches Produkt in den Fokus der Öffentlichkeit gerückt zu sein.

01

PixVerse V3 durchbricht wirklich die Dimensionsmauer

Ist PixVerse V3 wirklich besonders genug, da die KI-Videoprodukte auf dem Markt so zahlreich geworden sind, dass die Menschen beginnen, „visuelle Ermüdung“ zu verspüren?

Wenn Sie ähnliche Zweifel haben, reicht das Erscheinen dieses Pikachu aus, um die meisten davon zu zerstreuen.

Abgesehen von den Pressekonferenzdemonstrationen, die nicht reproduziert werden können, ist dies wahrscheinlich das erste Mal, dass zweidimensionale Bilder und die reale Welt bei der KI-Videogenerierung so harmonisch interagieren können.

Auf dem Bild ist das Bild dieses Pikachu genau das gleiche wie das, was wir aus dem Cartoon kennen, aber es erschien auf einer wirklich belebten Straße und sprang dann in die Arme seines kleinen Bruders.

Dies ist die Eingabeaufforderung, die für dieses Video benötigt wird:

Mittlere Frontkamera: Pikachu steht auf einer belebten Stadtstraße, neben einem Rucksacktouristen. Der Rucksacktourist geht an der Kamera vorbei und Pikachu rennt von hinten. Sprang dem Rucksacktouristen in die Arme. Pikachu umarmte glücklich seinen Hals und war ganz nah. Fußgänger beeilten sich und Rucksacktouristen trugen Pikachu vorwärts, dessen Wangen vor Aufregung funkelten und den Moment erhellten. Charmant und mühelos.

Im 1934 von MGM produzierten „Hollywood Party“ wurde Jimmy Durants Aktion, „Mickey Mouse“ mit den Fingern zu halten, zur ersten klassischen Szene in der Geschichte des Weltkinos, die Cartoons und reale Bilder kombinierte, diese Effekte sind voll Einfallsreichtum, aber äußerst umständlich in der Umsetzung, kann endlich durch KI erledigt werden.

Das Unverschämte ist, dass Pikachu von KI erschaffen wurde und die reale Welt, in der Pikachu lebt, ebenfalls von KI erschaffen wurde. Den Effekten nach zu urteilen, hat Pixverse V3 ein sehr reibungsloses Verständnis dafür, wie Animationen in die reale Welt gelangen.

Nicht nur Pikachu, Sie können auch die folgende Eingabeaufforderung verwenden, die zu viele Elemente zu enthalten scheint, um ein Video von Onkel Mario zu erstellen, der den Bahnhof betritt:

Das Video zeigt einen geschäftigen Bahnhof voller bunt gemischter Passagiere, die sehnsüchtig auf ihre Züge warten. Die Kamera fährt über die Szene und fängt die lebhafte Atmosphäre ein. Super Mario, ein kräftiger Italiener mit rundem Gesicht, setzt seinen ikonischen roten Hut auf Blauer Overall Die Kamera folgt Mario genau, als er selbstbewusst die Plattform betritt, sein Gesicht strahlt vor Aufregung. Das Video ist in einem realistischen Stil gehalten.

Im Video ist der Bahnhof voller Passagiere aller Art, die gespannt auf den Zug warten. Die Kamera schwenkt über die Szene und fängt die lebhafte Atmosphäre ein. Während sich der Zug langsam dem Bahnsteig nähert, folgt die Kamera dem großen, rundgesichtigen italienischen Charakter Super Mario, der seinen ikonischen roten Hut und blauen Overall trägt und selbstbewusst mit einem aufgeregten Lächeln im Gesicht auf den Bahnsteig geht. Der Stil des Videos ist sehr realistisch.

Es gibt einen eindeutigen Protagonisten, Mario, auf dem Bild. Jede der geschäftigen Menschenmengen hinter ihm hat unterschiedliche Details seiner Bewegungen. Während Mario an der Kamera entlanggeht, werden auch die Kanten, an denen sich die animierten Charaktere mit der realen Umgebung überschneiden, sehr deutlich dargestellt und sauber, gleichzeitig fuhr auch der Zug in den Bahnhof ein.

Wenn Zeichentrickfiguren Ihren Appetit nicht stillen können, werfen wir einen Blick auf die Leistung von PixVerse V3 bei großen Szenen.

——Schlüsselwörter: Der Drache schläft ein.

Die vollständige Eingabeaufforderung sieht folgendermaßen aus:

Steadycam-Kamerafahrt eines Drachen, der ins Wasser taucht, der Mönch hebt anerkennend die Arme.

Steadicam-Tracking: Ein Drache taucht ins Wasser und ein Mönch hebt anerkennend die Arme.

Obwohl dem Video immer noch einige der in Prompt erwähnten Details fehlen, sei es insgesamt die Konsistenz der Kamerabewegung, die Fähigkeit, düstere Töne zu verwenden, um die Spannung des Bildes subtil auszudrücken, und die Verwendung von Monstern in der Ferne und im Verlassenen Autos im Vordergrund Die Videogenerierungsfunktionen von PixVerse V3 nähern sich mittlerweile der Bildqualität auf Filmniveau an.

Neben Vincent-Videos zeigte PixVerse V3 dieses Mal auch hervorragende bildbasierte Videofunktionen.

Tushengs Video ist sehr einfallsreich. Sie können versuchen, ein hübsches amerikanisches Westernfilmplakat zu finden, eine Aufforderung hinzuzufügen und ihn einige „unverschämte“ Dinge tun zu lassen – beispielsweise die Begegnung mit einem Revolver von schlechter Qualität.

Die Eingabeaufforderung sieht folgendermaßen aus:

Die vollständige Eingabeaufforderung sieht folgendermaßen aus:

Die Pistole zündet nicht und es entsteht schwarzer Rauch, der das Gesicht des Mannes schmutzig macht.

Die Pistole feuerte nicht, schwarzer Rauch trat aus und verfärbte das Gesicht des Mannes.

Das deutlichste Gefühl von PixVerse V3 in Bezug auf seine Wensheng-Video- und Tusheng-Videofunktionen ist, dass es den Sehenswürdigkeiten im täglichen Leben der normalen Menschen extrem nahe kommt. Tatsächlich haben, abgesehen von professionellen Praktikern im Bereich der Videoerstellung, nicht viele Menschen das Bedürfnis, KI-Videosoftware zu verwenden, um eine perfekte Film- und Fernseharbeit zu erstellen. Im Gegenteil, immer mehr Menschen, die gerade die Funktion zur Videogenerierung genutzt haben, sind neugierig, ob diese Fähigkeit mit der realen Welt oder sogar mit sich selbst gespielt werden kann. Sie können beispielsweise Ihre Lieblingszeichentrickfiguren an den Orten vorstellen, an denen Sie jeden Tag ausgehen, oder sich sogar in Zeichentrickfiguren wie Iron Man verwandeln.

Viele der Schwierigkeiten, auf die KI-Videoprodukte derzeit stoßen, sind darauf zurückzuführen, dass sie in der Eigenwerbung technischer Fähigkeiten stecken bleiben und die Benutzer verschwunden sind. In diesem Stadium, in dem die Vincent-Videotechnologie gerade erst auf den Markt gekommen ist, mögen die meisten normalen Menschen ein KI-Videoprodukt, das nah genug bei ihnen und freundlich genug ist.

Aus dieser Perspektive ist das aktuelle PixVerse V3 möglicherweise das Produkt, das die Gedanken des Benutzers am genauesten errät.

Die Erstaunlichkeit von PixVerse V3 liegt nicht nur an den iterativen Fähigkeiten des großen KI-Videomodells hinter PixVerse V3, sondern auch an der Optimierung der Fähigkeiten zum schnellen Wortverständnis.

„Subjekt + Motivbeschreibung + Bewegung + Umgebung“ ist eine Eingabeaufforderungsformel, die die Effektivität der KI-Videogenerierung maximiert. Im Vergleich zu V2.5 können Sie PixVerse V3 jetzt eine Dimension „Aufnahmebeschreibung“ hinzufügen.

Natürlich muss Prompt nicht nur dieser Formel folgen, sondern auch die Aktionen des Charakters so detailliert wie möglich beschreiben und zu vereinfachte Beschreibungen vermeiden.

Gleichzeitig verfügt PixVerse V3 auch über eine größere Auswahl an Ausgabevideoformaten. PixVerse V3 unterstützt eine Vielzahl von Videoformaten, darunter 16:9, 9:16, 3:4, 4:3 und 1 :1. Die Stilisierungsfunktion wurde nach diesem Versionsupdate ebenfalls verbessert. Jetzt unterstützen die beiden Modi von Vincent Video und Tusheng Video vier Stiloptionen: Animation, Realität, Ton und 3D.

Mit einem Wort: PixVerse V3 ist dieses Mal nicht nur stärker, es möchte Ihnen sogar Produktbeschreibungen Zeile für Zeile in die Hand geben.

Auf der sozialen Plattform X haben viele Anhänger von KI-Produkten begonnen, PixVerse V3 zu verwenden, wie beispielsweise Pierrick Chevallier, der viele Fans hat. Er hat sogar einen eigenen Beitrag zusammengestellt, um die Videos vorzustellen, die er mit PixVerse V3 erstellt hat. Was neben seiner starken Fähigkeit zur Generierung auffällt, ist, dass er viele Videos mit sehr „Halloween-Einschlag“ zeigt.

02

Überlassen Sie dieses Halloween PixVerse V3 die „Effekte“

Um den Kreis eines ausreichend interessanten KI-Videoprodukts zu durchbrechen, bedarf es neben ausreichender technischer Unterstützung auch einer guten Gelegenheit. Apropos: Die Veröffentlichung von PixVerse V3 kommt zum richtigen Zeitpunkt.

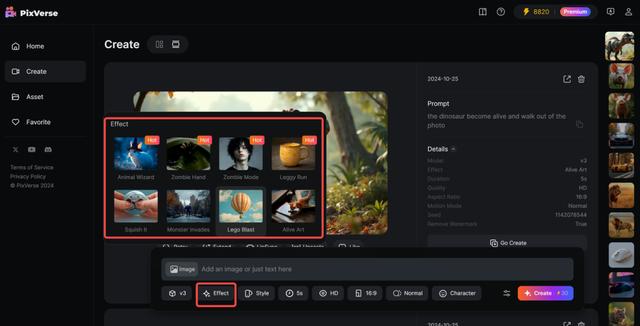

Der 1. November ist Halloween, und dieser Moment Ende Oktober ist für junge Menschen der jährliche Höhepunkt der Fantasie. In Verbindung mit dem Halloween-Thema hat PixVerse V3 eine Reihe von Halloween-Themen-Vorlagen veröffentlicht, die es Ihnen ermöglichen, mithilfe der KI alles um Sie herum zu „verzaubern“.

Dieses Mal werden in PixVerse V3 insgesamt 8 Halloween-Themenvorlagen veröffentlicht, von denen sich eine auf „Transformation in eine lebende Person“ konzentriert.

Beispielsweise taucht aus dem Nichts in der Stadt ein Monster auf.

Zusätzlich zu solch großen Szenen kann PixVerse V3 Elemente in einem Foto direkt „lebendig“ machen, wie zum Beispiel den Welpen in „Ich warte im Regen auf dich“ wirklich aus dem Foto laufen zu lassen:

Der Welpe hat sogar die natürliche Bewegung, den Kopf zu heben, bevor er aufsteht. Nachdem ich das Foto verlassen hatte, hinterließ das Originalfoto nur einen ruhigen Rasen, und der Gesamteffekt war ziemlich beeindruckend.

Diese Vorlage bietet auch einfallsreicheres Gameplay. Darf beispielsweise der vitruvianische Mensch in Leonardo da Vincis Werken aus dem Kreis heraustreten, der ihn umrahmt?

Etwas in der Art:

Die Möglichkeit, an Halloween eine solche Show zu veranstalten, reicht aus, um das Publikum in Erstaunen zu versetzen.

Diesmal geht der zweite Vorlagentyp, den PixVerse V3 für Halloween vorbereitet hat, den abstrakten Weg.

Lassen Sie zum Beispiel eine Eisenkiste aufstehen und davonlaufen:

Oder zerschmettere einen Porsche und verwandle ihn in einen Stapel Blöcke:

Natürlich verfügen die Vorlagen von PixVerse V3 dieses Mal auch über viele weitere Halloween-ähnliche Effekte, die gespielt werden können, wie zum Beispiel das Aufsetzen eines Zaubererhutes auf ein Charakterfoto und das anschließende Verschieben, wie folgt:

Diese Halloween-Vorlagen sind in der neuen Effektfunktion von PixVerse V3 enthalten. Es ist sehr einfach zu verwenden. Wählen Sie nach dem Hochladen des Bildes den gewünschten Effekt aus und klicken Sie, um ihn zu generieren. Es ist sehr benutzerfreundlich für Leute, die nur an Halloween denken.

Diesmal zeigt PixVerse V3 stärkere multimodale Generierungsfunktionen. Basierend auf seinem eigenen Wensheng-Video und Tusheng-Video kann PixVerse V3 jetzt dafür sorgen, dass das generierte Video den vom Benutzer gewünschten Toninhalt trägt, und wenn das Originalvideo nicht lang genug ist, kann PixVerse V3 jetzt verwendet werden hat die Möglichkeit, weitere Fortsetzungen des Originalvideos zu erstellen.

Diese Funktionen zur multimodalen Generierung sind neben Effect auch zu zwei neuen Funktionen geworden, die erstmals in PixVerse V3 eingeführt werden. Die erste Funktion ist Lipsync, eine Lippensynchronisationsfunktion, die synchronisierte Stimmen mehrsprachiger Charaktere für Videos erzeugen kann.

Mit der Lipsync-Funktion können Benutzer ihren eigenen Text eingeben oder Audiodateien basierend auf dem generierten Video hochladen. Anschließend passt PixVerse automatisch die Mundform der Charaktere im Video basierend auf dem Inhalt des Texts oder der Audiodatei an. Derzeit unterstützt Lipsync eine Videolänge von 30 Sekunden. Zu den Sprachen, die eine Lippensynchronisation ermöglichen, gehören Englisch, Chinesisch, Französisch und Japanisch.

Eine weitere Funktion besteht darin, das Video zu erweitern, oder es kann als Fortsetzung der Geschichte verstanden werden.

Als Reaktion auf das Problem, dass die Länge des aktuell generierten Videos zu kurz ist, können Benutzer in PixVerse V3 das generierte Video auswählen, auf die Schaltfläche „Erweitern“ klicken, Eingabeaufforderungen zur Weiterentwicklung des Videos eingeben und auf „Erstellen“ klicken ", und das Originalvideo wird sein. Die vorgeschlagene Regie erzielt einen Handlungsfortschritt und sorgt gleichzeitig für ein hohes Maß an Kohärenz zwischen den Charakteren und Aktionen.

Durch die Hinzufügung multimodaler Videogenerierungsfunktionen kann PixVerse V3 nun KI-Videos mit größeren Erzählungen und besseren audiovisuellen Effekten generieren, und die Grenzen der KI-Videoerstellung wurden weiter erweitert.

Erstellen Sie ein KI-Videoprodukt, das wirklich abspielbar ist

„Der Moment für ChatGPT wird sein, wenn normale Benutzer es nutzen können“, sagte Wang Changhu, Gründer und CEO von Aishi Technology, in einem Interview im April dieses Jahres.

In den letzten zwei Jahren wurde jeder neue Schimmer von Großmodelltechnik in neue große Erzählungen über Produktionsmethoden verwandelt, als ob das menschliche Leben in kurzer Zeit völlig untergraben würde. Doch bisher ist dies nicht geschehen.

Gleichzeitig haben die Begeisterung, die Sora mit sich brachte, und die allzu ehrgeizige technische Vorstellungskraft dazu geführt, dass der gesamte Bereich der KI-Videoprodukte nach und nach aus dem Fokus geriet und keinen Bezug mehr zum öffentlichen Leben fand. Daher sind einerseits KI-Videoprodukte wie Runway, die als professionelle Tools positioniert sind, aufgrund der hohen Einsatzschwelle nur schwer aus dem Kreis auszubrechen, andererseits Produkte, die eher allgemein positioniert sind Nachdem die Neuheit nachgelassen hat, ist die Öffentlichkeit in ein „Burn After Reading“-Dilemma geraten. Dem Produkt mangelt es an klaren und spezifischen Entwicklungsideen, sodass ihm keine andere Wahl bleibt die einfache Logik von „Filterung“ und „Spezialeffekten“.

Mit anderen Worten: Die enorme Offenheit der KI-Generierungsfähigkeiten lässt fast alle aktuellen Produkte im Bereich KI-Video wie eine Art Halbfertigprodukt aussehen. Die Zufälligkeit und Unkontrollierbarkeit der generierten Inhalte werden in ein neuartiges Erlebnis verpackt, was auch bedeutet dass es schwierig ist, es vor Ort in einem bestimmten und dauerhaften Szenario zu verwenden.

So wie die Außenwelt von Soras Fähigkeiten zur Ballonmann-Generierung erstaunt war, war Patrick Cederberg beunruhigt über die mangelnde Konsistenz bei der Inhaltsgenerierung von Sora. Er beklagte sich darüber, dass sich die Farbe der Ballons mit jeder Generation ändern würde, und das bedeuten Unvollkommenheiten Nachbearbeitungsarbeiten sind immer noch unvermeidbar. Es gibt viele ähnliche Probleme, weshalb Hollywood, obwohl es vor einem Jahr begann, auf die mögliche Störung der Filmindustrie durch große Models aufmerksam zu machen, ein Jahr später immer noch nicht wirklich in den Arbeitsablauf von Film und Fernsehen einsteigen kann.

Derzeit sind KI-Videoprodukte mehr oder weniger in einer ähnlichen Situation gefangen – obwohl die Möglichkeiten der KI-Videogenerierung schon lange alle begeistern, sind KI-Videogenerierungsprodukte immer noch eine schön aussehende „Verkäufershow“.

Angesichts der neuen technologischen Flut ist es für ein Produkt schwierig, „konkret“ zu bleiben. Was Aishi Technology jedoch von der ursprünglichen PixVerse-Webversion bis zur aktuellen PixVerse V3 geliefert hat, ist ein seltener klarer und geordneter Iterationspfad.

Im Januar dieses Jahres veröffentlichte Aishi Technology offiziell die Webversion von PixVerse, einem PixVerse-Videoprodukt. Aber zu dieser Zeit, einschließlich PixVerse, bestand das Problem bei fast allen Wensheng-Videoprodukten darin, dass die generierten Bilder unkontrollierbar waren, was bedeutete, dass Benutzer nicht kontinuierlich Videoinhalte rund um einen einheitlichen Charakter generieren konnten. Drei Monate später wurde die PixVerse-Webversion mit der C2V-Funktion (Character to Video) ausgestattet, die auf der Grundlage des selbst entwickelten großen Videomodells entwickelt wurde und zunächst das Konsistenzproblem bei der KI-Videoerstellung durch genaues Extrahieren von Charaktermerkmalen löste, um den Charakter zu sperren.

Nachdem die „Rolle“ im Video festgelegt wurde, konzentrierte sich PixVerse bei nachfolgenden Iterationen auf die „Steuerbarkeit“ des Verhaltens im generierten Inhalt. Im Juni dieses Jahres veröffentlichte Aishi Technology den Magic Brush-Bewegungspinsel. Benutzer können die Bewegung und Richtung jedes Elements präzise steuern, indem sie einfach über die Elemente auf dem Videobildschirm streichen. PixVerse V2 wurde Ende Juli auf den Markt gebracht. Zusätzlich zur ausreichenden Kontrolle über die generierten Inhalte wurde auch die Schwierigkeit der Eingabeaufforderungen deutlich reduziert. Gleichzeitig wurden die Möglichkeiten zur Feinabstimmung der generierten Effekte umfangreicher.

Dies ist eine weitere Iteration mit sehr klaren Absichten: „Die spezifische Produktform muss ausprobiert werden, aber am Ende hoffen wir immer noch, die Mehrheit der normalen Benutzer zu bedienen“, wie Wang Changhu in einem früheren Interview sagte.

Wenn die Funktionen zur Videogenerierung die Bedürfnisse normaler Benutzer nicht direkt erfüllen können, hat die Betreuung professioneller Ersteller und die Entwicklung von Tools der nächsten Generation auf der Grundlage neuer Paradigmen zur Inhaltsgenerierung eine höhere Priorität. „Wenn Produktionsfaktoren durch die Technologie einbezogen werden – zum Beispiel ersetzt KI Schauspieler, Szenen und Kameras während des Filmens – dann können KI-Funktionen zur Videogenerierung beginnen, von der Öffentlichkeit genutzt zu werden, und der Benutzerkreis wird sich schrittweise erweitern, was riesige Chancen schafft.“ "

Dieses Mal versuchte PixVerse 3V, mehr Gameplay mit Bezug zum Leben gewöhnlicher Menschen einzuführen, und versuchte, Prompt zum Einstellen des Objektivs zu verwenden. Letzteres kann als Versuch angesehen werden, die Kamera teilweise zu ersetzen. Unter diesem Gesichtspunkt war Aishi Technology bei der Weiterentwicklung seiner Produktausrichtung sehr entschlossen.

In der technologischen Welle der KI-Videogenerierung, in der Divergenz das Schöne ist, hat sich Aishi Technology dafür entschieden, gegen den Gesamttrend zu agieren, sich von großen Erzählungen fernzuhalten und einen möglichst konkreten Plan dafür zu liefern, wie KI-Videoprodukte abgespielt werden können.

Nur wenn die Leute es in ihren Händen halten und so viel wie möglich damit spielen können, kann die KI-Videoanwendung von einer von Sora geleiteten „Verkäufershow“ zu einer lebendigen „Käufershow“ werden.

Das atemberaubende Debüt von PixVerse V3 könnte der Beginn einer weiteren positiven Veränderung hinter dieser „Abkühlung“ von KI-Videos sein.