Meta Platforms hat eine neue, optimierte Version des Llama-Modells veröffentlicht, Llama 3.21B und 3B, die den stabilen Betrieb umfangreicher Sprachmodelle auf gewöhnlichen Smartphones und Tablets ermöglicht. Der Herausgeber von Downcodes wird diesen bahnbrechenden Fortschritt und seine Bedeutung im Detail erläutern.

Meta Platforms veröffentlichte heute eine neue, optimierte Version seines Llama-Modells, einschließlich der Produkte Llama3.21B und 3B, die erstmals den stabilen Betrieb umfangreicher Sprachmodelle auf gewöhnlichen Smartphones und Tablets ermöglichte. Durch die innovative Integration quantitativer Trainingstechnologie und Optimierungsalgorithmen reduziert die neue Version die Dateigröße um 56 %, reduziert den laufenden Speicherbedarf um 41 % und erhöht die Verarbeitungsgeschwindigkeit auf das Vierfache der Originalversion, während die ursprüngliche Verarbeitungsqualität erhalten bleibt Text mit 8.000 Zeichen.

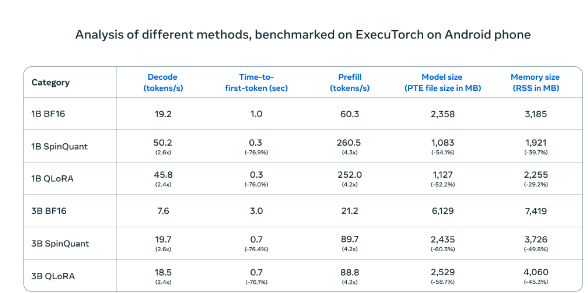

Beim Test auf Android-Telefonen waren die komprimierten KI-Modelle von Meta (SpinQuant und QLoRA) deutlich schneller und effizienter als die Standardversionen. Kleinere Modelle laufen viermal schneller und verbrauchen weniger Speicher

Im tatsächlichen Test des OnePlus12-Mobiltelefons zeigte diese komprimierte Version eine vergleichbare Leistung wie die Standardversion und verbesserte gleichzeitig die Betriebseffizienz erheblich, wodurch das langfristige Problem der unzureichenden Rechenleistung mobiler Geräte effektiv gelöst wurde. Meta hat sich für eine offene Marktkooperationsstrategie entschieden und arbeitet intensiv mit etablierten Mobilprozessorherstellern wie Qualcomm und MediaTek zusammen. Die neue Version wird gleichzeitig über die offizielle Website von Llama und die Hugging Face-Plattform veröffentlicht, um Entwicklern einen bequemen Zugriff zu ermöglichen Kanäle.

Diese Strategie steht im krassen Gegensatz zu anderen Giganten der Branche. Wenn Google und Apple beschließen, neue Technologien umfassend in ihre Betriebssysteme zu integrieren, bietet Metas offener Weg den Entwicklern mehr Raum für Innovationen. Diese Version markiert den Wandel der Datenverarbeitungsmodelle von zentralisierten Servern zu persönlichen Terminals. Lokale Verarbeitungslösungen können nicht nur die Privatsphäre der Benutzer besser schützen, sondern auch ein schnelleres Reaktionserlebnis bieten.

Dieser technologische Durchbruch kann große Veränderungen nach sich ziehen, die denen während der Popularisierung von Personalcomputern ähneln, obwohl er immer noch mit Herausforderungen wie den Anforderungen an die Geräteleistung und der Auswahl der Entwicklerplattform konfrontiert ist. Da sich die Leistung mobiler Geräte weiter verbessert, werden die Vorteile lokalisierter Verarbeitungslösungen nach und nach zum Vorschein kommen. Meta hofft, durch offene Zusammenarbeit die Entwicklung der gesamten Branche in eine effizientere und sicherere Richtung voranzutreiben und neue Wege für die zukünftige Anwendungsentwicklung mobiler Geräte zu eröffnen.

Die vereinfachte Version des Llama-Modells bringt neue Möglichkeiten für mobile KI-Anwendungen und auch seine offene Kooperationsstrategie ist es wert, von der Industrie gelernt zu werden. Da die Technologie in Zukunft immer ausgereifter und beliebter wird, wird die lokalisierte KI-Verarbeitung zu einem Mainstream-Trend werden.