Der Herausgeber von Downcodes erfuhr, dass Hugging Face heute SmolLM2 veröffentlicht hat, eine Reihe kompakter Sprachmodelle, die hinsichtlich der Leistung beeindruckend sind und weit weniger Rechenressourcen erfordern als große Modelle. Dies sind zweifellos gute Nachrichten für Entwickler, die KI-Anwendungen auf Geräten mit eingeschränkten Ressourcen bereitstellen möchten. SmolLM2 wird unter der Apache 2.0-Lizenz veröffentlicht und stellt drei Modelle mit unterschiedlichen Parametergrößen zur Verfügung, die flexibel an verschiedene Anwendungsszenarien angepasst werden können.

Hugging Face hat heute SmolLM2 veröffentlicht, einen neuen Satz kompakter Sprachmodelle, die eine beeindruckende Leistung erzielen und gleichzeitig weitaus weniger Rechenressourcen erfordern als größere Modelle. Das neue Modell wird unter der Apache 2.0-Lizenz veröffentlicht und ist in drei Größen erhältlich – 135 MB, 360 MB und 1,7 MB – und eignet sich für den Einsatz auf Smartphones und anderen Edge-Geräten mit begrenzter Verarbeitungsleistung und begrenztem Speicher.

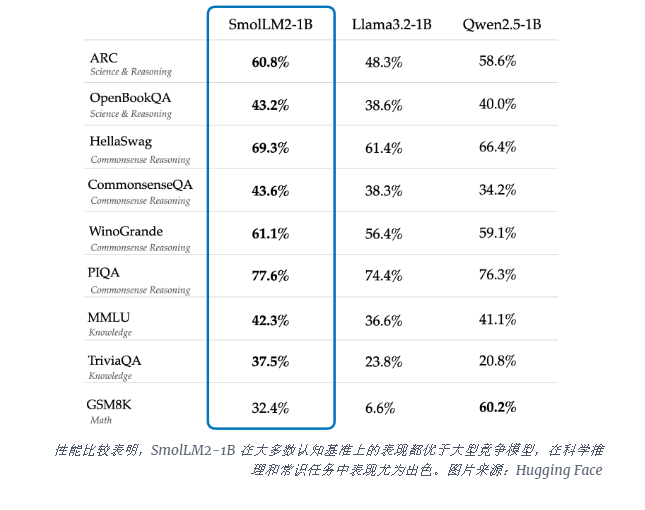

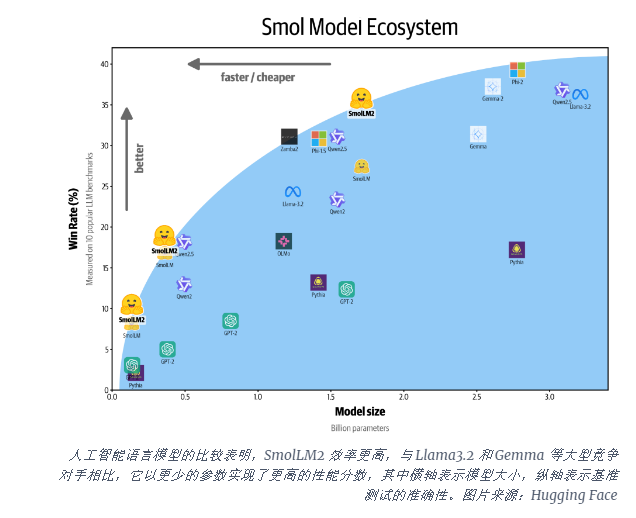

Das SmolLM2-1B-Modell übertrifft das Llama1B-Modell von Meta in mehreren wichtigen Benchmarks und schneidet insbesondere bei wissenschaftlichem Denken und Aufgaben des gesunden Menschenverstandes gut ab. Das Modell übertrifft große Konkurrenzmodelle bei den meisten kognitiven Benchmarks und verwendet eine vielfältige Kombination von Datensätzen, darunter FineWeb-Edu und spezielle Mathematik- und Codierungsdatensätze.

Die Veröffentlichung von SmolLM2 kommt zu einem kritischen Zeitpunkt, da sich die KI-Branche mit den Rechenanforderungen für die Ausführung großer Sprachmodelle (LLMs) auseinandersetzt. Während Unternehmen wie OpenAI und Anthropic weiterhin die Grenzen der Modellskala verschieben, wird zunehmend der Bedarf an effizienter, leichter KI erkannt, die nativ auf dem Gerät ausgeführt werden kann.

SmolLM2 bietet einen anderen Ansatz, um leistungsstarke KI-Funktionen direkt in persönliche Geräte zu bringen, und weist auf eine Zukunft hin, in der fortschrittliche KI-Tools mehr Benutzern und Unternehmen zur Verfügung stehen, nicht nur Technologiegiganten mit riesigen Rechenzentren. Diese Modelle unterstützen eine Reihe von Anwendungen, einschließlich Textumschreibung, Zusammenfassung und Funktionsaufruf, und eignen sich für den Einsatz in Szenarien, in denen Datenschutz-, Latenz- oder Konnektivitätsbeschränkungen Cloud-basierte KI-Lösungen unpraktisch machen.

Obwohl diese kleineren Modelle immer noch Einschränkungen aufweisen, stellen sie Teil eines umfassenderen Trends hin zu effizienteren KI-Modellen dar. Die Veröffentlichung von SmolLM2 zeigt, dass die Zukunft der künstlichen Intelligenz möglicherweise nicht nur immer größeren Modellen gehört, sondern auch effizienteren Architekturen, die mit weniger Ressourcen eine starke Leistung bieten können.

Das Aufkommen von SmolLM2 bietet neue Möglichkeiten für die Entwicklung leichter KI-Anwendungen und deutet auch darauf hin, dass die KI-Technologie beliebter wird und mehr Benutzern zugute kommt. Der Herausgeber von Downcodes glaubt, dass in Zukunft effizientere und ressourcenschonendere KI-Modelle auftauchen werden, um die Entwicklung der Technologie der künstlichen Intelligenz voranzutreiben.