Der Herausgeber von Downcodes erfuhr, dass das Team von Tongyi Qianwen kürzlich seine neueste Qwen2.5-Coder-Vollmodellserie als Open-Source-Version veröffentlicht hat, was einen weiteren Meilenstein im Bereich der Open-Source-Großmodelle darstellt. Die Modelle der Qwen2.5-Coder-Serie haben aufgrund ihrer leistungsstarken Codierungsfunktionen, vielfältigen Funktionen und praktischen Anwendbarkeit große Aufmerksamkeit erregt. Sie haben eine hervorragende Leistung bei der Codegenerierung, -reparatur und -begründung bewiesen und bieten Entwicklern leistungsstarke Tools, die die Weiterentwicklung von Open Code fördern LLMs. Die Open Source dieser Modellreihe wird die Anwendung und Innovation der Technologie der künstlichen Intelligenz im Bereich der Programmierung erheblich fördern.

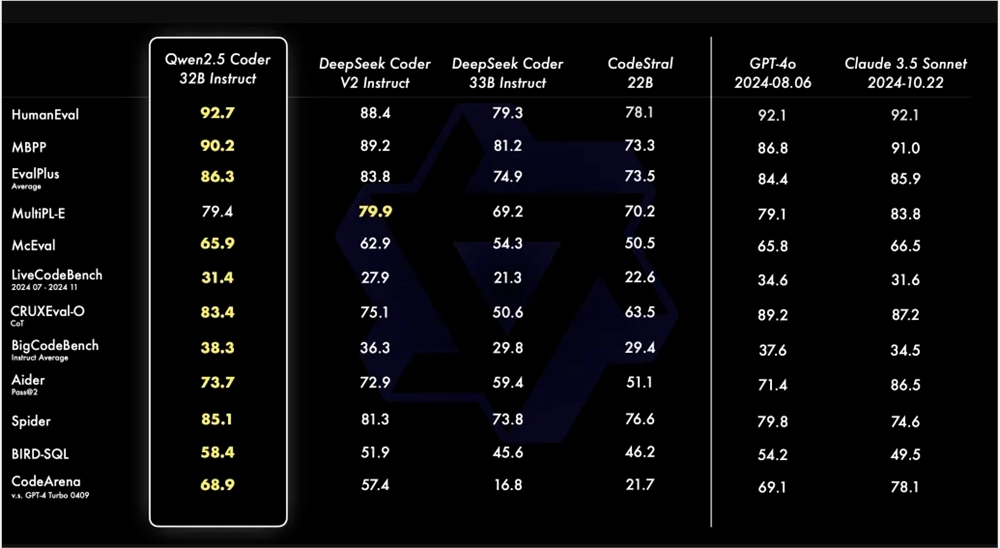

Das Team von Tongyi Qianwen gab kürzlich bekannt, dass es seine neueste Qwen2.5-Coder-Serie als Open Source veröffentlichen wird. Dieser Schritt zielt darauf ab, die Entwicklung von Open-Code-LLMs zu fördern. Qwen2.5-Coder hat aufgrund seiner Leistungsfähigkeit, Vielfalt und Praktikabilität Aufmerksamkeit erregt. Das Qwen2.5-Coder-32B-Instruct-Modell hat hinsichtlich der Codefähigkeiten das SOTA-Niveau erreicht, das GPT-4o entspricht und umfassende Fähigkeiten aufweist, einschließlich Codegenerierung, Codereparatur und Codebegründung. Es erreicht Spitzenleistungen bei mehreren Code-Generierungs-Benchmarks und erreicht beim Aider-Benchmark eine Punktzahl von 73,7, was mit GPT-4o vergleichbar ist.

Qwen2.5-Coder unterstützt mehr als 40 Programmiersprachen und erzielte bei McEval 65,9 Punkte, wobei Sprachen wie Haskell und Racket besonders gut abschneiden. Dies ist auf die einzigartige Datenbereinigung und den Datenabgleich in der Vortrainingsphase zurückzuführen. Darüber hinaus schneidet Qwen2.5-Coder-32B-Instruct auch bei den Codereparaturfunktionen in mehreren Programmiersprachen gut ab und erreicht im MdEval-Benchmark einen Wert von 75,2 und belegt damit den ersten Platz.

Um die Ausrichtungsleistung von Qwen2.5-Coder-32B-Instruct auf menschliche Präferenzen zu testen, wurde ein intern kommentierter Code-Präferenzbewertungs-Benchmark Code Arena erstellt. Die Ergebnisse zeigen, dass Qwen2.5-Coder-32B-Instruct Vorteile bei der bevorzugten Ausrichtung hat.

Die Qwen2.5-Coder-Serie verfügt dieses Mal über Open-Source-Modelle in vier Größen, darunter 0,5B/3B/14B/32B, die die sechs gängigen Modellgrößen abdecken, um den Anforderungen verschiedener Entwickler gerecht zu werden. Der Beamte stellt zwei Modelle zur Verfügung: Base und Instruct. Ersteres dient als Grundlage für die Feinabstimmung des Modells und Letzteres dient als offiziell abgestimmtes Chat-Modell. Es besteht ein positiver Zusammenhang zwischen Modellgröße und Leistung, und Qwen2.5-Coder erreicht SOTA-Leistung in allen Größen.

Das 0.5B/1.5B/7B/14B/32B-Modell von Qwen2.5-Coder übernimmt die Apache2.0-Lizenz, während das 3B-Modell eine Research Only-Lizenz hat. Das Team überprüfte die Wirksamkeit der Skalierung auf Code-LLMs, indem es die Leistung von Qwen2.5-Coder unterschiedlicher Größe für alle Datensätze bewertete.

Die Open Source von Qwen2.5-Coder bietet Entwicklern eine leistungsstarke, vielfältige und praktische Auswahl an Programmiermodellen und trägt so dazu bei, die Entwicklung und Anwendung von Programmiersprachenmodellen zu fördern.

Link zum Qwen2.5-Coder-Modell:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

Kurz gesagt, die Open Source von Qwen2.5-Coder bietet Entwicklern ein leistungsstarkes Tool, dessen hervorragende Leistung und breite Anwendbarkeit die Entwicklung im Bereich der Codegenerierung und -programmierung erheblich vorantreiben werden. Wir freuen uns darauf, dass Qwen2.5-Coder in Zukunft in weiteren Anwendungsszenarien eine Rolle spielen kann.