Der Herausgeber von Downcodes bringt Ihnen die neuesten Technologieinformationen! Das Seattler Startup Moondream hat mit „moondream2“ ein erstaunlich kompaktes visuelles Sprachmodell auf den Markt gebracht, das mit seiner geringen Größe und leistungsstarken Leistung in der Branche für Aufsehen sorgt. Dieses Open-Source-Modell schnitt in verschiedenen Benchmark-Tests gut ab und übertraf in einigen Aspekten sogar Konkurrenten mit größeren Parametern, was neue Möglichkeiten für die lokale Bilderkennung auf Smartphones eröffnete. Werfen wir einen genaueren Blick darauf, was Moondream2 einzigartig macht und welche technologische Innovation dahinter steckt.

Kürzlich hat Moondream, ein Startup aus Seattle, ein kompaktes visuelles Sprachmodell namens Moondream2 auf den Markt gebracht. Trotz seiner geringen Größe schnitt das Modell in verschiedenen Benchmark-Tests gut ab und erregte viel Aufmerksamkeit. Als Open-Source-Modell verspricht Moondream2, lokale Bilderkennungsfunktionen auf Smartphones zu ermöglichen.

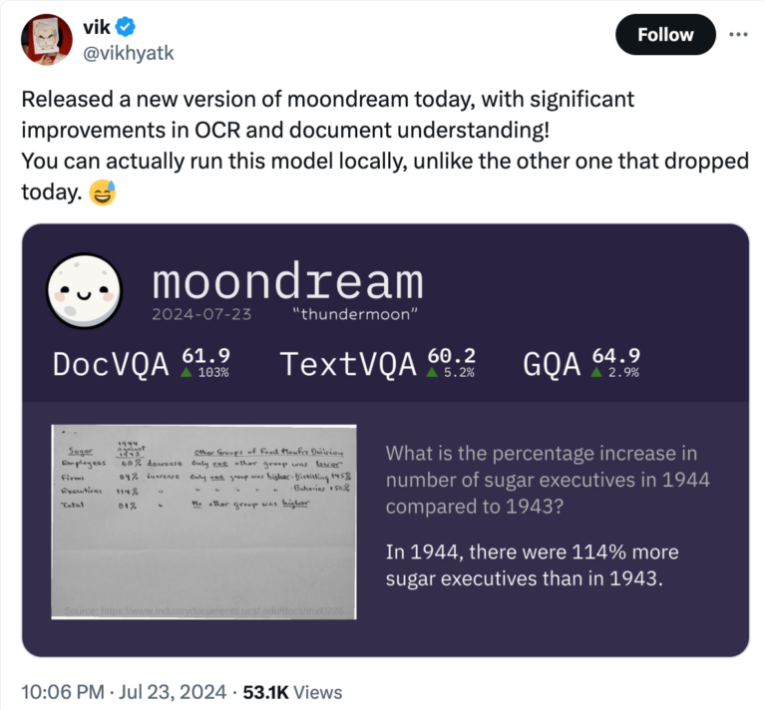

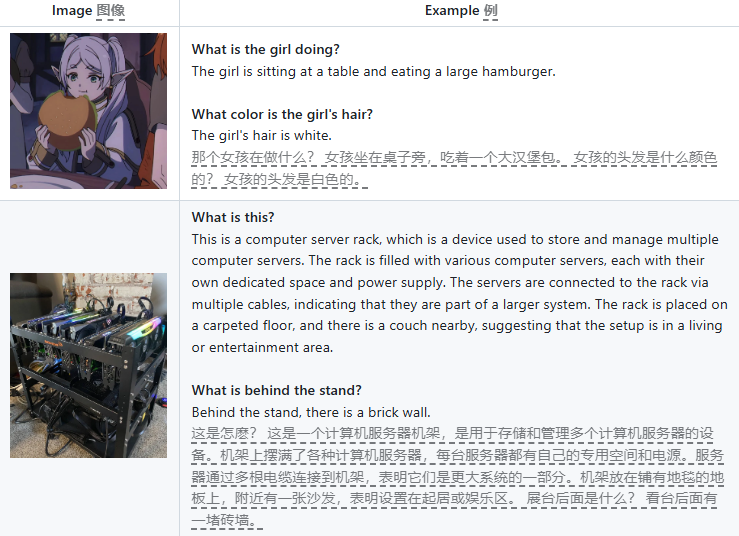

Moondream2 wurde im März offiziell veröffentlicht. Das Modell kann Text- und Bildeingaben verarbeiten und verfügt über die Funktionen zur Beantwortung von Fragen, Textextraktion (OCR), Objektzählung und Artikelklassifizierung. Seit seiner Veröffentlichung hat das Moondream-Team das Modell kontinuierlich aktualisiert und seine Grundleistung kontinuierlich verbessert. Die Juli-Veröffentlichung zeigt deutliche Verbesserungen bei OCR und Dokumentenverständnis, insbesondere bei der Analyse historischer Wirtschaftsdaten. Die Ergebnisse des Modells in DocVQA, TextVQA und GQA übersteigen alle 60 %, was seine starke Leistungsfähigkeit bei lokaler Ausführung zeigt.

Ein bemerkenswertes Merkmal von Moondream2 ist seine kompakte Größe: Es gibt nur 1,6 Milliarden Parameter, wodurch es nicht nur auf Cloud-Servern, sondern auch auf lokalen Computern und sogar einigen leistungsschwächeren Geräten wie Smartphones oder Einplatinencomputern ausgeführt werden kann.

Trotz seiner geringen Größe ist seine Leistung mit einigen Konkurrenzmodellen mit Milliarden von Parametern vergleichbar und übertrifft diese größeren Modelle bei einigen Benchmarks sogar.

In einem Vergleich visueller Sprachmodelle für mobile Geräte wiesen die Forscher darauf hin, dass Moondream2 zwar nur über 170 Millionen Parameter verfügt, seine Leistung jedoch der eines 700-Millionen-Parameter-Modells entspricht und seine Leistung dem SQA-Datensatz nur geringfügig unterlegen ist. Dies zeigt, dass kleine Modelle zwar gute Leistungen erbringen, sie jedoch immer noch vor Herausforderungen stehen, wenn es darum geht, bestimmte Kontexte zu verstehen.

Vikhyat Korrapati, der Entwickler des Modells, sagte, dass Moondream2 auf anderen Modellen wie SigLIP, Microsofts Phi-1.5 und LLaVA-Trainingsdatensätzen basiert. Das Open-Source-Modell steht jetzt zum kostenlosen Download auf GitHub zur Verfügung, eine Demoversion wird auf Hugging Face gezeigt. Auch auf der Codierungsplattform hat „moondream2“ große Aufmerksamkeit in der Entwickler-Community auf sich gezogen und über 5.000 Sternebewertungen erhalten.

Der Erfolg zog Investoren an: Moondream sammelte 4,5 Millionen US-Dollar in einer Seed-Runde unter der Leitung von Felicis Ventures, Microsofts M12GitHub-Fonds und Ascend. Der CEO des Unternehmens, Jay Allen, arbeitet seit vielen Jahren bei Amazon Web Services (AWS) und leitet das wachsende Startup.

Die Einführung von Moondream2 markiert die Geburtsstunde einer Reihe professionell optimierter Open-Source-Modelle, die weniger Ressourcen benötigen und gleichzeitig eine ähnliche Leistung wie größere, ältere Modelle bieten. Obwohl es einige kleine lokale Modelle auf dem Markt gibt, etwa den Smart Assistant von Apple und den Gemini Nano von Google, lagern diese beiden Hersteller immer noch komplexere Aufgaben in die Cloud aus.

Huggingface:https://huggingface.co/vikhyatk/moondream2

github:https://github.com/vikhyat/moondream

Das Aufkommen von Moondream2 läutet die energische Entwicklung leichter KI-Modelle ein und bietet neue Möglichkeiten für lokalisierte KI-Anwendungen. Sein Open-Source-Charakter fördert zudem die aktive Beteiligung der Entwickler-Community und verleiht der Entwicklung der KI-Technologie neue Dynamik. Wir freuen uns auf weitere ähnliche Innovationen in der Zukunft!