Die Interaktion mit KI in Echtzeit ist eine große Herausforderung im Bereich der künstlichen Intelligenz, insbesondere bei der Integration multimodaler Informationen und der Aufrechterhaltung der Gesprächsflüssigkeit. Viele bestehende KI-Systeme weisen immer noch Mängel in der Gesprächsflüssigkeit in Echtzeit, im kontextuellen Verständnis und im multimodalen Verständnis auf, was ihre praktischen Anwendungen einschränkt. Der Herausgeber von Downcodes stellt Ihnen Ultravox v0.4.1 vor, das von Fixie AI gestartet wurde, einer multimodalen Open-Source-Modellreihe, die zur Lösung dieser Probleme entwickelt wurde.

Bei der Anwendung künstlicher Intelligenz war es schon immer eine große Herausforderung für Entwickler und Forscher, eine Echtzeitinteraktion mit KI zu erreichen. Besonders komplex ist dabei die Integration multimodaler Informationen (wie Text, Bilder und Audio) zur Bildung eines kohärenten Dialogsystems.

Trotz einiger Fortschritte bei fortgeschrittenen groß angelegten Sprachmodellen wie GPT-4 haben viele KI-Systeme immer noch Schwierigkeiten, Konversationsflüssigkeit, Kontextbewusstsein und multimodales Verständnis in Echtzeit zu erreichen, was ihre Wirksamkeit in praktischen Anwendungen einschränkt. Darüber hinaus machen die Rechenanforderungen dieser Modelle die Bereitstellung in Echtzeit ohne umfassende Infrastrukturunterstützung äußerst schwierig.

Um diese Probleme zu lösen, hat Fixie AI Ultravox v0.4.1 auf den Markt gebracht, eine Reihe multimodaler Open-Source-Modelle, die einen Echtzeitdialog mit KI ermöglichen sollen.

Ultravox v0.4.1 ist in der Lage, mehrere Eingabeformate (wie Text, Bilder usw.) zu verarbeiten und soll eine Alternative zu Closed-Source-Modellen wie GPT-4 bieten. Diese Ausgabe konzentriert sich nicht nur auf Sprachkenntnisse, sondern auch auf die Ermöglichung flüssiger, kontextbewusster Gespräche über verschiedene Medientypen hinweg.

Als Open-Source-Projekt hofft Fixie AI, mit Ultravox Entwicklern und Forschern auf der ganzen Welt gleichberechtigten Zugang zu modernster Konversationstechnologie zu ermöglichen, die für eine Vielzahl von Anwendungen vom Kundensupport bis zur Unterhaltung geeignet ist.

Das Ultravox v0.4.1-Modell basiert auf einer optimierten Transformatorarchitektur und ist in der Lage, mehrere Datentypen parallel zu verarbeiten. Mithilfe einer Technik namens „Cross-Modal Attention“ können diese Modelle Informationen aus verschiedenen Quellen gleichzeitig integrieren und interpretieren.

Dies bedeutet, dass Benutzer einer KI ein Bild zeigen, relevante Fragen stellen und in Echtzeit fundierte Antworten erhalten können. Fixie AI hostet diese Open-Source-Modelle auf Hugging Face, um Entwicklern den Zugriff und das Experimentieren zu erleichtern, und stellt eine detaillierte API-Dokumentation bereit, um eine nahtlose Integration in praktische Anwendungen zu fördern.

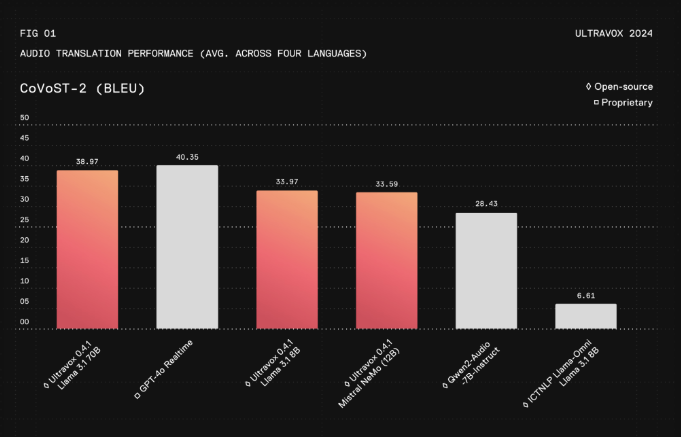

Basierend auf aktuellen Evaluierungsdaten erreicht Ultravox v0.4.1 eine deutliche Reduzierung der Reaktionslatenz und ist etwa 30 % schneller als führende kommerzielle Modelle, während gleichzeitig vergleichbare Genauigkeit und Kontextverständnis erhalten bleiben. Die modalübergreifenden Fähigkeiten dieses Modells eignen sich hervorragend für komplexe Anwendungsfälle, beispielsweise die Kombination von Bildern mit Text für eine umfassende Analyse im Gesundheitswesen oder die Bereitstellung umfangreicher interaktiver Inhalte im Bildungsbereich.

Die Offenheit von Ultravox ermöglicht eine von der Community vorangetriebene Entwicklung, erhöht die Flexibilität und fördert die Transparenz. Durch die Reduzierung des Rechenaufwands, der für die Bereitstellung dieses Modells erforderlich ist, macht Ultravox fortschrittliche Konversations-KI insbesondere für kleine Unternehmen und unabhängige Entwickler zugänglicher und beseitigt Barrieren, die zuvor durch Ressourcenbeschränkungen entstanden sind.

Projektseite: https://www.ultravox.ai/blog/ultravox-an-open-weight-alternative-to-gpt-4o-realtime

Modell: https://huggingface.co/fixie-ai

Alles in allem bietet Ultravox v0.4.1 Entwicklern ein leistungsstarkes und leicht zugängliches multimodales Dialog-KI-Modell in Echtzeit. Es wird erwartet, dass sein Open-Source-Charakter und seine effiziente Leistung die Entwicklung des Bereichs der künstlichen Intelligenz vorantreiben. Weitere Informationen finden Sie auf der Projektseite und bei Hugging Face.