Die rasante Entwicklung der generativen KI hat nicht nur Bequemlichkeit gebracht, sondern auch das Problem der Verbreitung falscher Informationen mit sich gebracht. Um dieses Problem zu beheben, hat Microsoft ein neues Tool namens Correction auf den Markt gebracht, das darauf ausgelegt ist, Fehlinformationen in KI-generierten Inhalten zu korrigieren. Der Herausgeber von Downcodes vermittelt Ihnen ein tiefgreifendes Verständnis der Prinzipien, Anwendungen und Herausforderungen dieses Tools.

Heute, mit der rasanten Entwicklung der künstlichen Intelligenz, hat die generative KI zwar viele Annehmlichkeiten mit sich gebracht, aber auch die von ihr generierten falschen Informationen sind zu einem Problem geworden, das nicht ignoriert werden kann. Als Reaktion auf diese Herausforderung hat der Technologieriese Microsoft kürzlich ein neues Tool namens Correction auf den Markt gebracht, das darauf ausgelegt ist, falsche Informationen in KI-generierten Inhalten zu korrigieren.

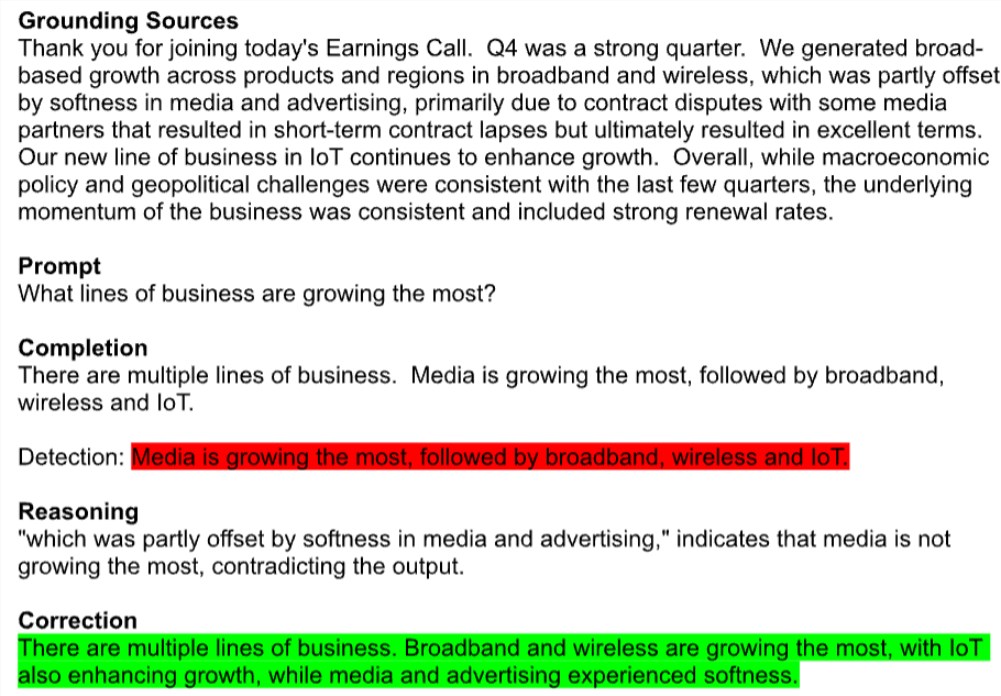

Die Korrektur befindet sich derzeit in der Vorschau als Teil der Azure AI Content Security API von Microsoft. Das Tool markiert automatisch potenziell fehlerhafte Texte, wie etwa falsch zitierte Zusammenfassungen der vierteljährlichen Gewinne von Unternehmen, und vergleicht sie mit glaubwürdigen Quellen, um diese Fehler zu korrigieren. Bemerkenswert ist, dass diese Technologie in allen KI-Modellen zur Textgenerierung funktioniert, einschließlich Metas Llama und OpenAIs GPT-4.

Ein Microsoft-Sprecher sagte, dass Correction durch die Kombination kleiner Sprachmodelle mit großen Sprachmodellen sicherstellt, dass der generierte Inhalt mit echten Dokumenten übereinstimmt. Sie hoffen, dass diese neue Funktion Entwicklern in Bereichen wie der Medizin dabei helfen wird, die Reaktionsgenauigkeit zu verbessern.

Experten sind jedoch vorsichtig. Os Keyes, ein Doktorand an der University of Washington, glaubt, dass der Versuch, die Illusion erzeugter KI zu beseitigen, dem Versuch gleicht, Wasserstoff aus Wasser zu entfernen, was ein grundlegender Teil der Funktionsweise der Technologie ist. Tatsächlich erzeugen Textgenerierungsmodelle falsche Informationen, weil sie eigentlich nichts wissen und nur Vermutungen auf der Grundlage des Trainingssatzes anstellen. Eine Studie ergab, dass ChatGPT von OpenAI bei der Beantwortung medizinischer Fragen eine Fehlerquote von bis zu 50 % aufwies.

Die Lösung von Microsoft besteht darin, diese falschen Informationen durch ein Paar referenzierter Bearbeitungsmetamodelle zu identifizieren und zu korrigieren. Ein Klassifizierungsmodell sucht nach möglichen Fehlern, fiktiven oder irrelevanten Textfragmenten, und wenn diese erkannt werden, wird ein zweites Sprachmodell eingeführt, um zu versuchen, sie basierend auf dem spezifischen zugrunde liegenden Dokument zu korrigieren.

Obwohl Microsoft behauptet, dass Correction die Zuverlässigkeit und Vertrauenswürdigkeit von KI-generierten Inhalten erheblich verbessern kann, haben Experten immer noch Zweifel. Mike Cook, ein Forscher an der Queen Mary University, wies darauf hin, dass die Korrektur, selbst wenn sie wie angekündigt funktioniert, die Vertrauens- und Erklärbarkeitsprobleme in der KI verschärfen könnte. Der Dienst kann Benutzer in falscher Sicherheit wiegen und sie glauben machen, dass das Modell genauer ist, als es tatsächlich ist.

Erwähnenswert ist, dass Microsoft bei der Einführung von Correction auch versteckte Geschäftskalkulationen vorgenommen hat. Während die Funktion selbst kostenlos ist, gibt es ein monatliches Nutzungslimit für die grundlegenden Dokumentenerkennungsfunktionen, die zur Erkennung von Desinformation erforderlich sind, und jede zusätzliche Nutzung wird in Rechnung gestellt.

Microsoft steht eindeutig unter Druck, den Wert seiner KI-Investitionen unter Beweis zu stellen. Das Unternehmen gab im zweiten Quartal dieses Jahres fast 19 Milliarden US-Dollar für KI-bezogene Investitionsausgaben und Ausrüstung aus, erzielte bisher jedoch bescheidene Einnahmen aus KI. Kürzlich senkten einige Wall-Street-Analysten die Bewertung der Microsoft-Aktie und stellten die Machbarkeit ihrer langfristigen KI-Strategie in Frage.

Das potenzielle Risiko von Genauigkeit und Desinformation ist zu einer der größten Sorgen für Unternehmen bei der Pilotierung von KI-Tools geworden. Cook kam zu dem Schluss, dass sich generative KI, wenn dies ein normaler Produktlebenszyklus wäre, noch in der akademischen Forschungs- und Entwicklungsphase befinden sollte, um ihre Stärken und Schwächen weiter zu verbessern und zu verstehen. Wir haben es jedoch in mehreren Branchen eingesetzt.

Das Korrekturtool von Microsoft ist zweifellos ein Versuch, das Problem der KI-Desinformation zu lösen, aber ob es die Vertrauenskrise in generative KI wirklich überwinden kann, bleibt abzuwarten. Während sich die KI-Technologie rasant weiterentwickelt, wird die Frage, wie Innovation und Risiko in Einklang gebracht werden können, zu einem wichtigen Thema für die gesamte Branche.

Alles in allem markiert das Aufkommen des Korrekturtools von Microsoft die zunehmende Aufmerksamkeit der Branche für das Problem der KI-Falschinformationen, löst aber auch ein tiefgreifendes Nachdenken über die Glaubwürdigkeit und das Geschäftsmodell der KI aus. In Zukunft wird es eine große Herausforderung für alle sein, die KI-Technologie besser zu nutzen und gleichzeitig ihre Risiken effektiv zu kontrollieren.