GPT-4V, dieses als „Bilder betrachten und sprechen“ bekannte Artefakt, wurde wegen seines mangelnden Verständnisses grafischer Schnittstellen kritisiert. Es ist wie bei einer „bildschirmblinden“ Person, die oft auf die falschen Schaltflächen klickt, was ärgerlich ist. Es wird jedoch erwartet, dass das von Microsoft veröffentlichte OmniParser-Modell dieses Problem vollständig löst! OmniParser ist wie ein „Bildschirmübersetzer“, der Screenshots in die leicht verständliche strukturierte Sprache von GPT-4V konvertiert und so die „Sicht“ von GPT-4V schärfer macht. Der Herausgeber von Downcodes führt Sie zu einem tiefgreifenden Verständnis dieses magischen Modells und zeigt Ihnen, wie es GPT-4V dabei hilft, den Defekt der „Augenblindheit“ zu überwinden, und welche erstaunliche Technologie dahinter steckt.

Erinnern Sie sich noch an den GPT-4V, ein Artefakt, das als „Bilder betrachten und sprechen“ bekannt ist? Es ist ein Segen für faule Menschen Schwäche: sein Sehvermögen ist nicht sehr gut !

Stellen Sie sich vor, Sie bitten GPT-4V, für Sie auf eine Schaltfläche zu klicken, aber es klickt überall wie bei einer „Bildschirmjalousie“. Ist das nicht verrückt?

Heute stelle ich Ihnen ein Artefakt vor, das GPT-4V besser aussehen lässt – OmniParser! Dies ist ein neues Modell von Microsoft, das darauf abzielt, das Problem der automatischen Interaktion grafischer Benutzeroberflächen (GUI) zu lösen.

Was macht OmniParser?

Einfach ausgedrückt ist OmniParser ein „Bildschirmübersetzer“, der Screenshots in eine „strukturierte Sprache“ umwandeln kann, die GPT-4V verstehen kann. OmniParser kombiniert das fein abgestimmte interaktive Symbolerkennungsmodell, das fein abgestimmte Symbolbeschreibungsmodell und die Ausgabe des OCR-Moduls.

Diese Kombination erzeugt eine strukturierte, DOM-ähnliche Darstellung der Benutzeroberfläche sowie Screenshots, die die Begrenzungsrahmen potenziell interagierbarer Elemente abdecken. Die Forscher erstellten zunächst einen interaktiven Datensatz zur Symbolerkennung unter Verwendung beliebter Webseiten und Symbolbeschreibungsdatensätze. Diese Datensätze werden zur Feinabstimmung spezialisierter Modelle verwendet: ein Erkennungsmodell zum Parsen interagierbarer Bereiche auf dem Bildschirm und ein Beschreibungsmodell zum Extrahieren der funktionalen Semantik erkannter Elemente.

Konkret wird OmniParser:

Identifizieren Sie alle interaktiven Symbole und Schaltflächen auf dem Bildschirm, markieren Sie sie mit Kästchen und geben Sie jedem Kästchen eine eindeutige ID.

Verwenden Sie Text, um die Funktion jedes Symbols zu beschreiben, z. B. „Einstellungen“ und „Minimieren“. Erkennen Sie Text auf dem Bildschirm und extrahieren Sie ihn.

Auf diese Weise kann GPT-4V klar erkennen, was auf dem Bildschirm angezeigt wird und was jedes Ding tut. Teilen Sie ihm einfach die ID der Schaltfläche mit, auf die Sie klicken möchten.

Wie großartig ist OmniParser?

Forscher verwendeten verschiedene Tests, um OmniParser zu testen, und fanden heraus, dass es GPT-4V wirklich „besser“ machen kann!

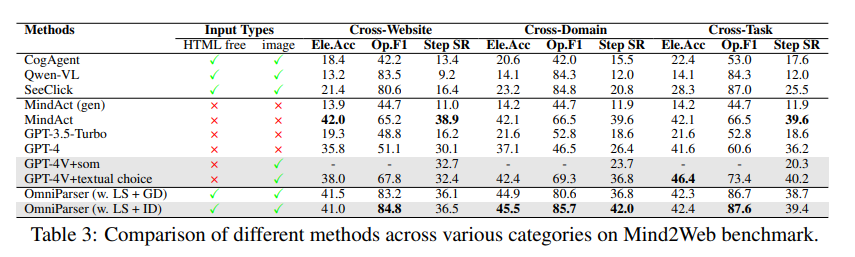

Im ScreenSpot-Test hat OmniParser die Genauigkeit von GPT-4V erheblich verbessert und sogar einige speziell für grafische Schnittstellen trainierte Modelle übertroffen. Beim ScreenSpot-Datensatz verbessert OmniParser beispielsweise die Genauigkeit um 73 % und übertrifft damit Modelle, die auf der zugrunde liegenden HTML-Analyse basieren. Insbesondere führte die Einbeziehung der lokalen Semantik von UI-Elementen zu einer deutlichen Verbesserung der Vorhersagegenauigkeit – die Symbole von GPT-4V wurden bei Verwendung der OmniParser-Ausgabe von 70,5 % auf 93,8 % korrekt beschriftet.

Im Mind2Web-Test verbesserte OmniParser die Leistung von GPT-4V bei Webbrowsing-Aufgaben und seine Genauigkeit übertraf sogar GPT-4V, das HTML-Informationsunterstützung verwendet.

Im AITW-Test hat OmniParser die Leistung von GPT-4V bei Navigationsaufgaben für Mobiltelefone deutlich verbessert.

Was sind die Mängel von OmniParser?

Obwohl OmniParser sehr leistungsfähig ist, weist es auch einige kleinere Mängel auf, wie zum Beispiel:

Wenn man auf wiederholte Symbole oder Texte stößt, kann man leicht verwirrt werden , und zur Unterscheidung sind detailliertere Beschreibungen erforderlich.

Manchmal wird der Rahmen nicht genau genug gezeichnet , was dazu führt, dass GPT-4V an der falschen Position klickt.

Die Interpretation von Symbolen ist gelegentlich fehlerhaft und erfordert für eine genauere Beschreibung den Kontext.

Forscher arbeiten jedoch hart daran, OmniParser zu verbessern und glauben, dass es immer leistungsfähiger wird und schließlich der beste Partner von GPT-4V wird!

Modellerfahrung: https://huggingface.co/microsoft/OmniParser

Papiereingang: https://arxiv.org/pdf/2408.00203

Offizielle Einführung: https://www.microsoft.com/en-us/research/articles/omniparser-for-pure-vision-based-gui-agent/

Highlight:

✨OmniParser kann GPT-4V dabei helfen, den Bildschirminhalt besser zu verstehen und Aufgaben genauer auszuführen.

OmniParser schnitt in verschiedenen Tests gut ab und stellte seine Wirksamkeit unter Beweis.

?️OmniParser hat noch einige Verbesserungsmöglichkeiten, aber es gibt Hoffnung für die Zukunft.

Alles in allem bringt OmniParser revolutionäre Verbesserungen bei der Interaktion von GPT-4V mit grafischen Benutzeroberflächen. Obwohl es immer noch einige Mängel gibt, ist sein Potenzial enorm und es lohnt sich, auf die zukünftige Entwicklung zu blicken. Der Herausgeber von Downcodes glaubt, dass OmniParser mit der kontinuierlichen Weiterentwicklung der Technologie zu einem leuchtenden Stern auf dem Gebiet der künstlichen Intelligenz werden wird!