Der Herausgeber von Downcodes berichtet: Das technische Team von Zhipu hat heute ein großes Open-Source-Videogenerierungsmodell CogVideoX v1.5 veröffentlicht, das ein weiteres wichtiges Upgrade der Serie seit August darstellt. Die neue Version hat einen bedeutenden Durchbruch bei den Videogenerierungsfunktionen erzielt, indem sie längere Videos, höhere Auflösungen und flüssigere Bildraten unterstützt und in Kombination mit dem neu eingeführten CogSound-Soundeffektmodell eine „neue klare Video“-Plattform geschaffen hat, um Benutzern bessere Premium-Videos bereitzustellen Schöpfungserfahrung. Dieses Update verbessert nicht nur die Videoqualität, sondern verbessert auch die Fähigkeit des Modells, komplexe Semantik zu verstehen, wodurch Entwickler leistungsfähigere Tools erhalten.

Es versteht sich, dass dieses Update die Videogenerierungsfunktionen erheblich verbessert hat, einschließlich der Unterstützung von Videolängen von 5 Sekunden und 10 Sekunden, einer 768P-Auflösung und 16-Frame-Generierungsfunktionen. Gleichzeitig unterstützt das I2V-Modell (Bild zu Video) auch jedes Größenverhältnis, was die Fähigkeit zum Verständnis komplexer Semantik weiter verbessert.

CogVideoX v1.5 enthält zwei Hauptmodelle: CogVideoX v1.5-5B und CogVideoX v1.5-5B-I2V, die Entwicklern leistungsfähigere Tools zur Videogenerierung bieten sollen.

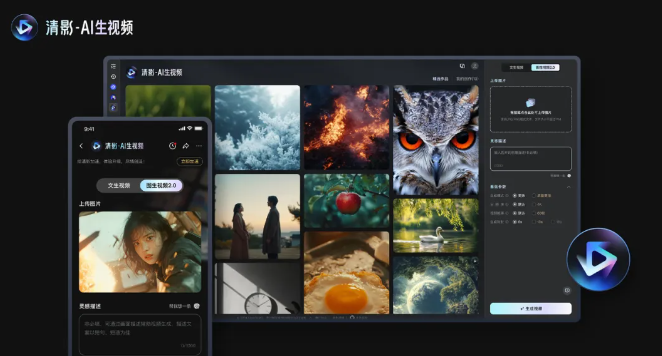

Noch bemerkenswerter ist, dass CogVideoX v1.5 gleichzeitig auf der Qingying-Plattform eingeführt und mit dem neu eingeführten CogSound-Soundeffektmodell zum „Neuen Qingying“ kombiniert wird. New Qingying wird eine Reihe besonderer Dienste bereitstellen, darunter erhebliche Verbesserungen der Videoqualität, der ästhetischen Leistung und der Bewegungsrationalität, und die Erstellung von 10-Sekunden-, 4K- und 60-Frame-Ultra-High-Definition-Videos unterstützen.

Die offizielle Einführung lautet wie folgt:

Qualitätsverbesserung: Die Fähigkeiten von Tusheng-Videos in Bezug auf Qualität, ästhetische Leistung, Rationalität der Bewegung und semantisches Verständnis komplexer Aufforderungswörter wurden erheblich verbessert.

Ultra-HD-Auflösung: Unterstützt die Erstellung von Ultra-High-Definition-Videos mit 10 Sekunden, 4K und 60 Bildern.

Variables Verhältnis: Unterstützt jedes Verhältnis zur Anpassung an verschiedene Wiedergabeszenarien.

Mehrkanalausgabe: Mit dem gleichen Befehl/Bild können 4 Videos gleichzeitig generiert werden.

KI-Video mit Soundeffekten: Xinqingying kann Soundeffekte erzeugen, die zum Bild passen.

Im Hinblick auf die Datenverarbeitung konzentriert sich das CogVideoX-Team auf die Verbesserung der Datenqualität, die Entwicklung eines automatisierten Filterrahmens zum Filtern fehlerhafter Videodaten und die Einführung des End-to-End-Videoverständnismodells CogVLM2-caption zur Generierung genauer Inhaltsbeschreibungen. Dieses Modell kann komplexe Anweisungen effektiv verarbeiten und sicherstellen, dass das generierte Video den Anforderungen des Benutzers entspricht.

Um die Kohärenz der Inhalte zu verbessern, verwendet CogVideoX die effiziente dreidimensionale Variations-Autoencoder-Technologie (3D VAE), die die Schulungskosten und -schwierigkeiten erheblich reduziert. Darüber hinaus entwickelte das Team eine Transformer-Architektur, die die drei Dimensionen Text, Zeit und Raum integriert. Durch die Entfernung des traditionellen Kreuzaufmerksamkeitsmoduls wird der interaktive Effekt von Text und Video verbessert und die Qualität der Videogenerierung verbessert.

In Zukunft wird das technische Team von Zhipu die Datenmenge und den Modellmaßstab weiter erweitern und eine effizientere Modellarchitektur erforschen, um ein besseres Videogenerierungserlebnis zu erreichen. Die Open Source von CogVideoX v1.5 stellt Entwicklern nicht nur leistungsstarke Tools zur Verfügung, sondern verleiht dem Bereich der Videoerstellung auch neue Dynamik.

Code: https://github.com/thudm/cogvideo

Modell: https://huggingface.co/THUDM/CogVideoX1.5-5B-SAT

Highlight:

Die neue Version von CogVideoX v1.5 ist Open Source und unterstützt 5/10 Sekunden Video, 768P-Auflösung und 16 Frame-Generierungsfunktionen.

Die neue Qingying-Plattform wird in Kombination mit dem CogSound-Soundeffektmodell eingeführt, um eine ultrahochauflösende 4K-Videoerzeugung zu ermöglichen.

Datenverarbeitung und Algorithmeninnovation gewährleisten die Qualität und Konsistenz der generierten Videos.

Alles in allem stellen die Open Source von CogVideoX v1.5 und die Einführung der neuen Qingying-Plattform einen wichtigen Schritt in der KI-Videogenerierungstechnologie dar und bieten Entwicklern und Erstellern leistungsstärkere Tools und einen größeren kreativen Raum. Wir freuen uns darauf, in Zukunft weitere spannende Anwendungen auf Basis von CogVideoX zu sehen.