Das in Tokio ansässige Startup Rhymes AI hat sein erstes Modell für künstliche Intelligenz veröffentlicht, Aria, ein Open-Source-Modell für multimodale Hybridexperten (MoE). Der Herausgeber von Downcodes erfuhr, dass Aria eine gute Leistung bei der Verarbeitung verschiedener Eingaben wie Text, Code, Bilder und Videos erbringt und dass seine Fähigkeiten sogar einige bekannte Geschäftsmodelle übertreffen. Aria nutzt eine einzigartige MoE-Architektur, um die Recheneffizienz durch mehrere spezialisierte Experten zu steigern, und verfügt über ein multimodales Kontextfenster mit bis zu 24,9 Milliarden Parametern und 64.000 Token, wodurch längere Eingabedaten verarbeitet werden können. Rhymes AI arbeitete außerdem mit AMD zusammen, um die Modellleistung zu optimieren, und brachte die auf AMD-Hardware basierende BeaGo-Suchanwendung auf den Markt.

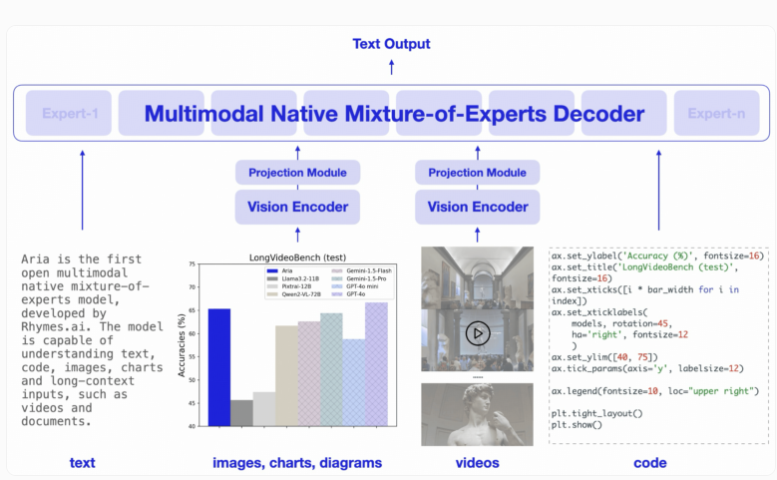

Aria wurde entwickelt, um hervorragende Verständnis- und Verarbeitungsfunktionen für eine Vielzahl von Eingabeformaten zu bieten, darunter Text, Code, Bilder und Videos. Im Gegensatz zum traditionellen Transformer-Modell ersetzt das MoE-Modell seine Feed-Forward-Schicht durch mehrere professionelle Experten. Bei der Verarbeitung jedes Eingabe-Tokens wählt ein Routing-Modul eine Teilmenge von Experten zur Aktivierung aus, wodurch die Recheneffizienz verbessert und die Anzahl der Aktivierungsparameter pro Token reduziert wird.

Der Decoder von Aria kann 3,5 Milliarden Parameter pro Text-Token aktivieren, und das gesamte Modell verfügt über 24,9 Milliarden Parameter. Um visuelle Eingaben zu verarbeiten, hat Aria außerdem einen leichten visuellen Encoder mit 438 Millionen Parametern entwickelt, der visuelle Eingaben verschiedener Längen, Größen und Seitenverhältnisse in visuelle Token umwandeln kann. Darüber hinaus erreicht das multimodale Kontextfenster von Aria 64.000 Token, was bedeutet, dass es längere Eingabedaten verarbeiten kann.

In Bezug auf das Training ist Rhymes AI in vier Phasen unterteilt. Es verwendet zunächst Textdaten für das Vortraining, führt dann multimodale Daten ein, gefolgt von einem Training mit langen Sequenzen und schließlich einer Feinabstimmung.

In diesem Prozess verwendete Aria insgesamt 6,4 Billionen Text-Tokens und 400 Milliarden multimodale Token für das Vortraining. Die Daten stammten aus bekannten Datensätzen wie Common Crawl und LAION, und es wurden einige synthetische Verbesserungen durchgeführt.

Relevanten Benchmark-Tests zufolge übertrifft Aria Modelle wie Pixtral-12B und Llama-3.2-11B bei mehreren multimodalen, sprachlichen und Programmieraufgaben und weist aufgrund weniger Aktivierungsparameter niedrigere Inferenzkosten auf.

Darüber hinaus schneidet Aria bei der Verarbeitung von Videos mit Untertiteln oder mehrseitigen Dokumenten gut ab und seine Fähigkeit, lange Videos und Dokumente zu verstehen, übertrifft andere Open-Source-Modelle wie GPT-4o mini und Gemini1.5Flash .

Zur Vereinfachung der Nutzung veröffentlicht Rhymes AI den Quellcode von Aria auf GitHub unter der Apache2.0-Lizenz und unterstützt so die akademische und kommerzielle Nutzung. Gleichzeitig stellen sie auch ein Trainings-Framework bereit, das Aria für mehrere Datenquellen und Formate auf einer einzigen GPU optimieren kann. Erwähnenswert ist, dass Rhymes AI eine Kooperation mit AMD zur Optimierung der Modellleistung geschlossen und eine Suchanwendung namens BeaGo vorgestellt hat, die auf AMD-Hardware ausgeführt werden kann, um Benutzern umfassendere Text- und Bild-KI-Suchergebnisse zu liefern.

Highlight:

Aria ist das weltweit erste Open-Source-KI-Modell für multimodale Hybrid-Experten.

Aria übertrifft viele vergleichbare Modelle bei der Verarbeitung verschiedener Eingaben wie Text, Bilder und Videos.

? Rhymes AI arbeitet mit AMD zusammen, um die Modellleistung zu optimieren und die BeaGo-Suchanwendung zu starten, die mehrere Funktionen unterstützt.

Alles in allem haben die Open Source und die hohe Leistung des Aria-Modells neue Durchbrüche auf dem Gebiet der künstlichen Intelligenz gebracht und leistungsstarke Werkzeuge für Entwickler und Forscher bereitgestellt. Seine multimodalen Fähigkeiten und seine hohe Recheneffizienz verleihen ihm großes Potenzial für zukünftige Anwendungen. Der Herausgeber von Downcodes freut sich auf die Anwendung und Entwicklung von Aria in weiteren Bereichen.