Die Argumentationsfähigkeit großer Sprachmodelle (LLMs) ist ein Forschungsschwerpunkt im Bereich der künstlichen Intelligenz. Das KI-Forschungsteam von Apple hat kürzlich einen Artikel veröffentlicht, der die Grenzen von LLMs beim mathematischen Denken aufzeigt. Der Herausgeber von Downcodes wird den Hauptinhalt des Papiers interpretieren und seine Auswirkungen auf die Entwicklung der KI-Technologie analysieren.

In der Welt der künstlichen Intelligenz standen die Argumentationsfähigkeiten von Modellen des maschinellen Lernens, insbesondere von Large Language Models (LLMs), schon immer im Fokus der Wissenschaftler.

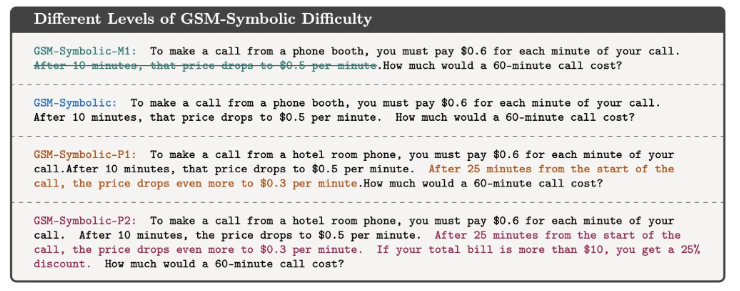

Kürzlich veröffentlichte das KI-Forschungsteam von Apple einen Artikel mit dem Titel „Understanding the Limitations of Large Language Models in Mathematical Reasoning“, der die Grenzen dieser Modelle bei der Bewältigung logischer Probleme aufzeigte.

In der Arbeit demonstrieren die Forscher dies anhand eines einfachen mathematischen Problems. Sie stellten zunächst eine Frage zum Kiwispflücken von Oliver:

Wie unten gezeigt:

Oliver hat am Freitag 44 Kiwis gepflückt. Am Samstag pflückte er weitere 58 Kiwis. Am Sonntag pflückte er doppelt so viele Kiwis wie am Freitag. Wie viele Kiwis hat Oliver insgesamt?

Offensichtlich lautet die Antwort 44+58+ (44*2) =190. Obwohl große Sprachmodelle mathematisch nicht wirklich perfekt sind, können sie Probleme wie dieses ziemlich zuverlässig lösen.

Wenn Sie jedoch einige irrelevante Informationen hinzufügen, um die Reaktion des Modells zu beobachten, wie zum Beispiel:

Oliver hat am Freitag 44 Kiwis gepflückt. Am Samstag wählte er weitere 58. Am Sonntag pflückte er doppelt so viele Kiwis wie am Freitag, aber fünf davon waren etwas kleiner als der Durchschnitt. Wie viele Kiwis hat Oliver?

Obwohl dies nichts an der mathematischen Natur des Problems ändert, geben selbst moderne LLMs unter dieser kleinen Störung falsche Antworten. Beispielsweise hat GPT-o1-mini fälschlicherweise 5 kleine Kiwis von der Gesamtzahl der am Sonntag gepflückten Kiwis abgezogen.

Dieses Experiment zeigt, dass LLMs zwar in manchen Fällen die richtige Antwort geben können, die Natur des Problems jedoch nicht wirklich verstehen.

Die Forscher glauben, dass die Fehlermuster dieser Modelle darauf hindeuten, dass sie kein echtes logisches Denken durchführen, sondern die Argumentationsschritte replizieren, die sie in den Trainingsdaten beobachtet haben. Es ist, als würde ein LLM zählen können, dass auf „Ich liebe dich“ normalerweise ein „Ich liebe dich auch“ folgt, aber das bedeutet nicht, dass er die Bedeutung von Liebe wirklich versteht.

Mehrdad Farajtabar, einer der Co-Autoren des Papiers, erläuterte die Ergebnisse in den sozialen Medien weiter. Er weist darauf hin, dass es zwar in einigen einfachen Fällen möglich ist, die Modellleistung durch besseres Hinweis-Engineering zu verbessern, das Modell jedoch bei komplexen Störungen möglicherweise mehr Kontextdaten benötigt, um korrekt zu verarbeiten, und dass diese Störungen für ein kleines Kind möglicherweise überhaupt nicht zu bewältigen sind . Kein Problem.

Diese Studie erinnert uns daran, dass LLMs zwar hervorragende Leistungen in der Sprachverarbeitung erbringen, ihre Fähigkeiten im logischen Denken jedoch immer noch begrenzt sind. Dies ist nicht nur eine akademische Frage. Da KI-Technologie immer mehr Teil unseres täglichen Lebens wird, werden die Antworten auf diese Fragen immer wichtiger.

Wir können nicht einfach davon ausgehen, dass KI komplexe Aufgaben verstehen und ausführen kann, sondern sollten ein tieferes Verständnis für ihre Funktionsweise und ihre Grenzen haben. Diese Forschung verschafft uns ein tieferes Verständnis der KI-Technologien und liefert gleichzeitig wertvolle Einblicke in die Art und Weise, wie wir diese Technologien nutzen und entwickeln.

Referenz: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

Alles in allem verdeutlicht die Forschung des Apple-Teams die Grenzen großer Sprachmodelle beim logischen Denken und erinnert uns daran, dass wir bei den Fähigkeiten der KI vorsichtig sein und weiterhin auf ihre Entwicklungsrichtung achten müssen, um eine übermäßige Abhängigkeit von ihren Fähigkeiten zu vermeiden. In Zukunft müssen wir tiefer untersuchen, wie wir die Denkfähigkeit von LLMs verbessern können, damit sie den Kern des Problems wirklich verstehen können, anstatt nur bestehende Muster zu imitieren.