Der Herausgeber von Downcodes bringt Ihnen große Neuigkeiten! Es gibt ein neues Mitglied im Bereich der künstlichen Intelligenz – Zyphra hat sein kleines Sprachmodell Zamba2-7B offiziell veröffentlicht! Dieses 7-Milliarden-Parameter-Modell hat einen Durchbruch in der Leistung erzielt, insbesondere in Bezug auf Effizienz und Anpassungsfähigkeit, und zeigt beeindruckende Vorteile. Es eignet sich nicht nur für Hochleistungs-Computing-Umgebungen, sondern, was noch wichtiger ist, Zamba2-7B kann auch auf GPUs der Verbraucherklasse ausgeführt werden, sodass mehr Benutzer den Charme fortschrittlicher KI-Technologie problemlos erleben können. Dieser Artikel befasst sich mit den Innovationen von Zamba2-7B und seinen Auswirkungen auf den Bereich der Verarbeitung natürlicher Sprache.

Vor kurzem hat Zyphra Zamba2-7B offiziell auf den Markt gebracht, ein kleines Sprachmodell mit beispielloser Leistung und einer Parameteranzahl von 7B.

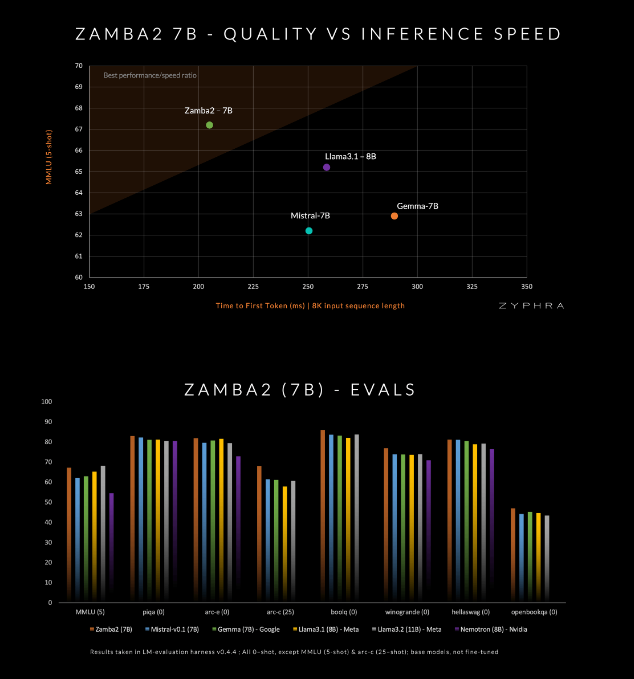

Dieses Modell soll die aktuellen Konkurrenten in Qualität und Geschwindigkeit übertreffen, darunter Mistral-7B, Googles Gemma-7B und Metas Llama3-8B.

Zamba2-7B wurde entwickelt, um die Anforderungen von Umgebungen zu erfüllen, die leistungsstarke Sprachverarbeitungsfunktionen erfordern, aber durch Hardwarebedingungen eingeschränkt sind, wie z. B. die Verarbeitung auf dem Gerät oder die Verwendung von GPUs der Verbraucherklasse. Durch die Verbesserung der Effizienz ohne Qualitätseinbußen möchte Zyphra einem breiteren Nutzerkreis – ob Unternehmen oder einzelnen Entwicklern – die Möglichkeit geben, den Komfort fortschrittlicher KI zu genießen.

Zamba2-7B hat viele Innovationen in seiner Architektur vorgenommen, um die Effizienz und Ausdrucksmöglichkeiten des Modells zu verbessern. Anders als das Modell Zamba1 der vorherigen Generation verwendet Zamba2-7B zwei gemeinsame Aufmerksamkeitsblöcke. Dieses Design kann die Abhängigkeiten zwischen Informationsfluss und Sequenzen besser bewältigen.

Der Mamba2-Block bildet den Kern der gesamten Architektur, wodurch die Parameterauslastung des Modells höher ist als bei herkömmlichen Konvertermodellen. Darüber hinaus verwendet Zyphra auch eine Low-Rank-Adaptation-Projektion (LoRA) auf gemeinsam genutzten MLP-Blöcken, was die Anpassungsfähigkeit jeder Schicht weiter verbessert und gleichzeitig die Kompaktheit des Modells beibehält. Dank dieser Innovationen konnte die erste Reaktionszeit von Zamba2-7B um 25 % verkürzt und die Anzahl der pro Sekunde verarbeiteten Token um 20 % erhöht werden.

Die Effizienz und Anpassungsfähigkeit von Zamba2-7B wurden durch strenge Tests bestätigt. Das Modell wird anhand eines riesigen Datensatzes vorab trainiert, der drei Billionen Token enthält, bei denen es sich um hochwertige und streng geprüfte offene Daten handelt.

Darüber hinaus führt Zyphra auch eine „Annealing“-Vortrainingsphase ein, die die Lernrate schnell reduziert, um hochwertige Token effizienter zu verarbeiten. Diese Strategie ermöglicht es Zamba2-7B, in Benchmarks eine gute Leistung zu erbringen, die Konkurrenz in Bezug auf Inferenzgeschwindigkeit und -qualität zu übertreffen und eignet sich für Aufgaben wie das Verstehen und Generieren natürlicher Sprache, ohne dass die enormen Rechenressourcen erforderlich sind, die für herkömmliche hochwertige Modelle erforderlich sind.

amba2-7B stellt einen großen Fortschritt bei kleinen Sprachmodellen dar, da es eine hohe Qualität und Leistung beibehält und gleichzeitig besonderes Augenmerk auf die Zugänglichkeit legt. Durch innovatives Architekturdesign und effiziente Trainingstechnologie ist es Zyphra gelungen, ein Modell zu schaffen, das nicht nur einfach zu verwenden ist, sondern auch verschiedene Anforderungen an die Verarbeitung natürlicher Sprache erfüllen kann. Die Open-Source-Veröffentlichung von Zamba2-7B lädt Forscher, Entwickler und Unternehmen ein, sein Potenzial zu erkunden, und soll die Entwicklung fortschrittlicher natürlicher Sprachverarbeitung innerhalb der breiteren Community vorantreiben.

Projekteingang: https://www.zyphra.com/post/zamba2-7b

https://github.com/Zyphra/transformers_zamba2

Die Open-Source-Veröffentlichung von Zamba2-7B hat dem Bereich der Verarbeitung natürlicher Sprache neue Dynamik verliehen und Entwicklern mehr Möglichkeiten geboten. Wir freuen uns darauf, dass Zamba2-7B in Zukunft häufiger eingesetzt wird und den weiteren Fortschritt der Technologie der künstlichen Intelligenz vorantreibt!