Das französische KI-Startup Les Ministraux hat zwei leichte KI-Modelle veröffentlicht, Ministral3B und Ministral8B, mit Parametern von 3 Milliarden bzw. 8 Milliarden, die für Edge-Geräte konzipiert sind. Diese beiden Modelle schnitten im Anweisungs-Benchmark-Test hervorragend ab und übertrafen insbesondere Modelle des gleichen Niveaus in Bezug auf Wissen, gesunden Menschenverstand, Argumentation und Effizienz. In einigen Aspekten übertrafen sie sogar Modelle mit größeren Parametern und setzten damit einen neuen Maßstab für niedrige Werte. Parametermodelle. Der Herausgeber von Downcodes wird die Leistung, Funktionen und Unternehmen hinter diesen beiden Modellen ausführlich erläutern.

Das französische KI-Startup Les Ministraux hat zwei neue Leichtbaumodelle auf den Markt gebracht, Ministral3B und Ministral8B, die speziell für Edge-Geräte entwickelt wurden und Parameter von 3 Milliarden bzw. 8 Milliarden haben. Die beiden Modelle schnitten im Anweisungs-Folge-Benchmark gut ab, wobei Ministral3B Llama38B und Mistral7B übertraf, während Ministral8B diese beiden Modelle in allen Aspekten außer den Code-Fähigkeiten übertraf.

Testergebnisse zeigen, dass die Leistung von Minitral3B und Minitral8B mit Open-Source-Modellen wie Gemma2 und Llama3.1 vergleichbar ist. Beide Modelle unterstützen bis zu 128.000 Kontexte und setzen neue Maßstäbe für Sub-10B-Parametermodelle in Bezug auf Wissen, gesunden Menschenverstand, Argumentation, Funktionsaufrufe und Effizienz. Ministral8B ist außerdem mit einem Schiebefenster-Aufmerksamkeitsmechanismus für schnellere und effizientere In-Memory-Inferenzen ausgestattet. Sie können auf eine Vielzahl von Anwendungsfällen abgestimmt werden, beispielsweise auf die Verwaltung komplexer KI-Agenten-Workflows oder die Erstellung spezialisierter Aufgabenassistenten.

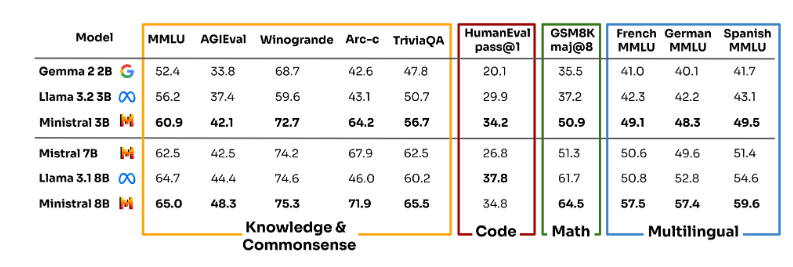

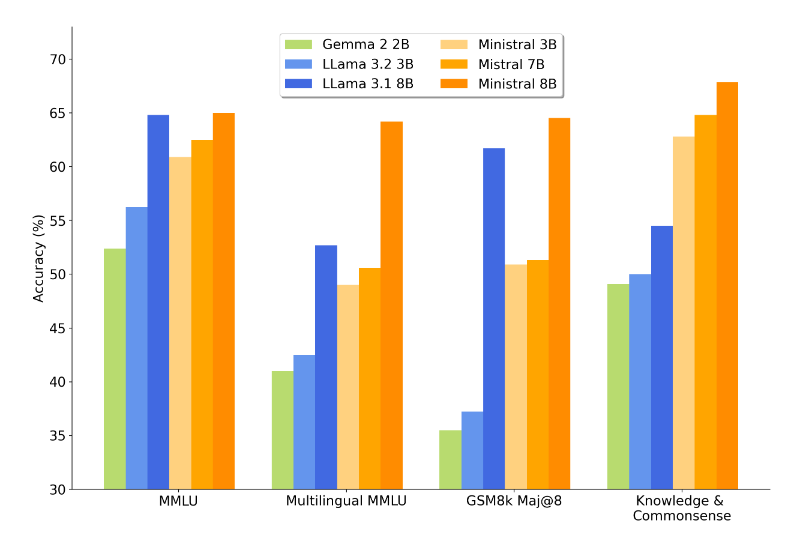

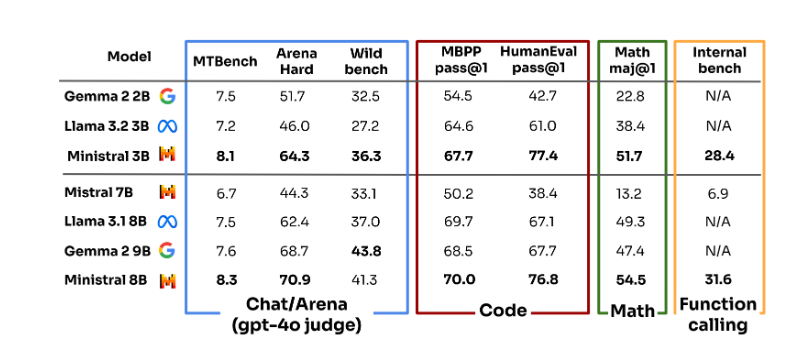

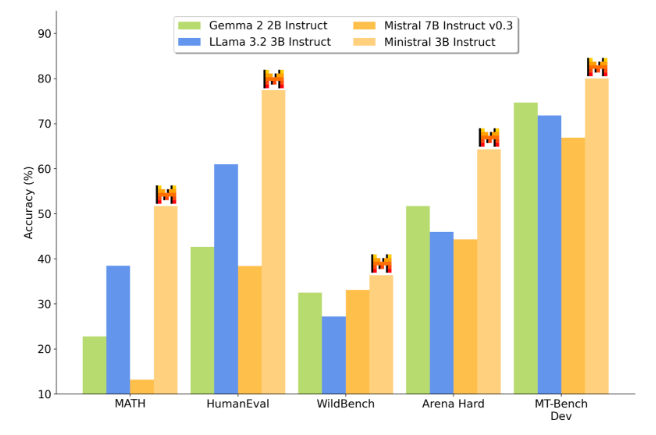

Die Forscher führten mehrere Benchmark-Tests zum Les Ministraux-Modell durch, die Aspekte wie Wissen und gesunder Menschenverstand, Kodierung, Mathematik und Mehrsprachigkeit abdeckten. In der Modellphase vor dem Training erzielte Minitral3B im Vergleich zu Gema22B und Llama3.23B die besten Ergebnisse. Im Vergleich zu Llama3.18B und Mistral7B schnitt Mistral8B in allen Aspekten mit Ausnahme der Codierungsfunktionen am besten ab. In der Unterrichtsmodellphase erzielte Minitral3B nach der Feinabstimmung in verschiedenen Benchmark-Tests die besten Ergebnisse, und Minitral8B war Gema29B auf dem Wild-Bench nur geringfügig unterlegen.

Die Einführung des Les Ministraux-Modells bietet Benutzern eine äußerst recheneffiziente Lösung mit geringer Latenz, die den Anforderungen einer zunehmenden Anzahl von Benutzern nach Local-First-Inferenz für kritische Anwendungen gerecht wird. Benutzer können diese Modelle auf Szenarien wie die Übersetzung auf dem Gerät, intelligente Assistenten, die keine Internetverbindung erfordern, und autonome Roboter anwenden. Der Ein- und Ausgabepreis von Ministral8B beträgt 0,1 US-Dollar pro Million Token und der von Ministral3B 0,04 US-Dollar pro Million Token.

Es ist erwähnenswert, dass Mistral zuvor mehrere Modelle über Magnetlinks als Open-Source-Modell bereitgestellt hat und von der KI-Community anerkannt wurde. Allerdings war das Unternehmen in diesem Jahr in Kontroversen verwickelt, da es nicht mehr so offen ist wie früher. Es gibt Neuigkeiten, dass Microsoft einen Teil der Anteile von Mistral erwerben und darin investieren wird, was bedeutet, dass die Modelle von Mistral auf Azure AI gehostet werden. Reddit-Internetnutzer entdeckten, dass Mistral sein Engagement für Open Source von seiner offiziellen Website entfernt hatte. Einige Modelle des Unternehmens haben ebenfalls mit dem Laden begonnen, darunter die Modelle Ministral3B und Ministral8B, die dieses Mal auf den Markt kamen.

Details: https://mistral.ai/news/ministraux/

Alles in allem bietet das Aufkommen von Minitral3B und Minitral8B eine gute Wahl für Edge-Computing-KI-Anwendungen, und ihre effiziente Leistung und ihr niedriger Preis verschaffen ihnen erhebliche Wettbewerbsvorteile. Der Strategiewechsel von Mistral hat aber auch dazu geführt, dass die Branche über die Balance zwischen Open-Source-Modellen und Kommerzialisierung nachdenkt. Auch in Zukunft werden wir der Anwendung und Weiterentwicklung des Les Ministraux-Modells große Aufmerksamkeit widmen.