Google hat kürzlich angekündigt, dass die Google Fotos-App ab nächster Woche KI-Bearbeitungslogos zu Fotos hinzufügen wird, die mit KI-Funktionen wie Magic Editor, Magic Eraser und Zoom Enhance bearbeitet wurden. Das Update sollte die Transparenz erhöhen, löste jedoch Kontroversen aus. Da das Logo nur in den Fotodetails und nicht im Foto selbst angezeigt wird, ist es für Benutzer schwierig, im täglichen Gebrauch KI-Bearbeitungsspuren intuitiv zu erkennen. Der Herausgeber von Downcodes wird dies im Detail interpretieren, seine Vor- und Nachteile analysieren und seine Auswirkungen auf die zukünftige Entwicklung der KI-Bildtechnologie diskutieren.

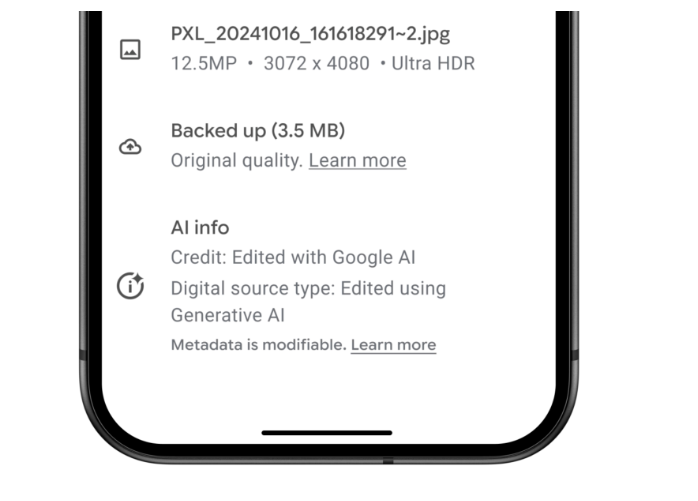

In einer Zeit, in der Bildgebungstechnologie mit künstlicher Intelligenz immer beliebter wird, kündigte Google an, ab nächster Woche eine neue KI-Logo-Bearbeitungsfunktion in die Google Fotos-Anwendung einzuführen. Bei allen Fotos, die mit KI-Funktionen wie Magic Editor, Magic Eraser und Zoom Enhance bearbeitet wurden, werden mit Google AI bearbeitete Anmerkungen unten im Abschnitt „Details“ der App angezeigt.

Dieses Update kommt mehr als zwei Monate, nachdem Google das Pixel 9-Telefon herausgebracht hat, das mit mehreren KI-Fotobearbeitungsfunktionen ausgestattet ist. Diese Kennzeichnungsmethode hat jedoch einige Kontroversen ausgelöst. Obwohl Google behauptet, dass dieser Schritt die Transparenz weiter verbessern soll, ist der tatsächliche Effekt fraglich: Das Foto selbst fügt kein visuelles Wasserzeichen hinzu, was bedeutet, dass Benutzer es beim Durchsuchen von Fotos in sozialen Medien, beim Instant Messaging oder im Alltag nicht intuitiv erkennen können Diese Fotos wurden von KI verarbeitet.

Bei Fotobearbeitungsfunktionen wie Best Take und Add Me, die keine generative KI verwenden, kommentiert Google Fotos die Bearbeitungsinformationen auch in den Metadaten, sie werden jedoch nicht auf der Registerkarte „Details“ angezeigt. Diese Funktionen werden hauptsächlich verwendet, um mehrere Fotos zu einem Gesamtbild zusammenzufügen.

Michael Marconi, Kommunikationsmanager für Google Fotos, sagte gegenüber TechCrunch: Die Arbeit ist noch nicht erledigt. Wir werden weiterhin Feedback einholen, Sicherheitsmaßnahmen stärken und verbessern und andere Lösungen evaluieren, um die Transparenz der generativen KI-Bearbeitung zu erhöhen. Das Unternehmen hat zwar nicht klargestellt, ob es in Zukunft ein visuelles Wasserzeichen hinzufügen wird, es hat die Möglichkeit jedoch nicht vollständig ausgeschlossen.

Es ist erwähnenswert, dass alle derzeit von Google AI bearbeiteten Fotos bereits AI-Bearbeitungsinformationen in den Metadaten enthalten. Die neue Funktion verschiebt diese Informationen einfach auf die Registerkarte „Details“, die leichter zu finden ist. Die tatsächliche Wirkung dieses Ansatzes ist jedoch besorgniserregend, da die meisten Benutzer beim Durchsuchen von Bildern im Internet nicht gezielt nach Metadaten oder detaillierten Informationen suchen.

Natürlich ist das Hinzufügen eines sichtbaren Wasserzeichens innerhalb eines Fotorahmens auch keine perfekte Lösung. Diese Wasserzeichen können leicht abgeschnitten oder bearbeitet werden, und das Problem bleibt bestehen. Da die KI-Bildgebungstools von Google immer beliebter werden, dürften synthetische Inhalte im Internet zunehmen, wodurch es für Nutzer immer schwieriger wird, echte von gefälschten Inhalten zu unterscheiden.

Die derzeit von Google verwendete Metadaten-Wasserzeichenmethode stützt sich stark auf die jeweilige Plattform, um KI-generierte Inhalte für Benutzer zu identifizieren. Meta hat diese Praxis auf Facebook und Instagram implementiert und Google plant, später in diesem Jahr KI-Bilder in Suchergebnissen zu identifizieren. Allerdings sind entsprechende Maßnahmen auf anderen Plattformen langsamer vorangekommen.

Diese Kontroverse wirft ein Schlaglicht auf ein wichtiges Thema bei der Entwicklung der KI-Technologie: Wie kann die Authentizität von Inhalten und das Recht der Benutzer auf Information sichergestellt und gleichzeitig technologische Innovation gefördert werden? Obwohl Google den ersten Schritt zur Verbesserung der Transparenz unternommen hat, ist es klar, dass weitere Anstrengungen und Verbesserungen erforderlich sind, um zu verhindern, dass synthetische Inhalte Nutzer irreführen.

Obwohl der Schritt von Google die Transparenz erhöhen soll, bleibt die Wirkung abzuwarten. Die Balance zwischen der Entwicklung der KI-Technologie und der Authentizität von Inhalten zu finden, ist ein schwieriges Problem, mit dem alle Technologieunternehmen konfrontiert sind. Um die Rechte und Interessen der Nutzer besser zu schützen, sind in Zukunft effektivere Methoden zur Identifizierung von KI-generierten Inhalten unerlässlich.