Der Herausgeber von Downcodes wird Sie über die neuesten Fortschritte physikalischer neuronaler Netze (PNNs) informieren! Diese neue Technologie nutzt die Eigenschaften physikalischer Systeme für Berechnungen und soll die Grenzen bestehender KI-Modelle durchbrechen. Es kann nicht nur größere KI-Modelle trainieren, sondern auch energiesparendes Edge-Computing erreichen und lokale Inferenzen auf Geräten wie Smartphones durchführen, was die Anwendungsszenarien der KI völlig verändern und beispiellose Möglichkeiten eröffnen wird.

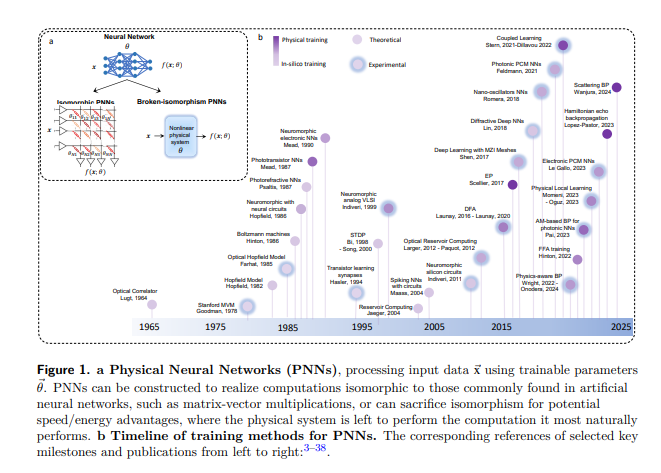

Kürzlich haben Wissenschaftler mehrerer Institutionen eine neue Technologie entdeckt: physikalische neuronale Netze (PNNs). Hierbei handelt es sich nicht um die digitalen Algorithmen, die wir von Computern kennen, sondern um eine völlig neue intelligente Rechenmethode, die auf physikalischen Systemen basiert.

PNNs sind, wie der Name schon sagt, neuronale Netze, die die Eigenschaften physikalischer Systeme nutzen, um Berechnungen durchzuführen. Obwohl sie derzeit ein Nischengebiet der Forschung sind, stellen sie möglicherweise eine der am meisten unterschätzten Möglichkeiten der modernen KI dar.

Das Potenzial von PNNs: große Modelle, geringer Energieverbrauch, Edge Computing

Stellen Sie sich vor, wir könnten KI-Modelle trainieren, die 1.000 Mal größer sind als heute, aber auch lokale, private Rückschlüsse auf Edge-Geräten wie Smartphones oder Sensoren ermöglichen könnten. Das klingt nach einem Science-Fiction-Szenario, aber Untersuchungen zeigen, dass es nicht unmöglich ist.

Um ein groß angelegtes Training von PNNs zu erreichen, erforschen Forscher Methoden, darunter solche, die auf Backpropagation basieren, und solche ohne Backpropagation. Jede dieser Methoden hat Vor- und Nachteile, und keine erreicht derzeit den gleichen Umfang und die gleiche Leistung wie der beim Deep Learning weit verbreitete Backpropagation-Algorithmus. Doch die Situation ändert sich schnell und das vielfältige Ökosystem an Trainingstechnologien liefert Anhaltspunkte für den Einsatz von PNNs.

Die Implementierung von PNNs umfasst mehrere Bereiche, darunter Optik, Elektronik und gehirninspirierte Datenverarbeitung. Sie können ähnlich strukturiert sein wie digitale neuronale Netze, um Berechnungen wie die Matrix-Vektor-Multiplikation durchzuführen, oder sie können diese strukturelle Ähnlichkeit für potenzielle Geschwindigkeits-/Energievorteile opfern und das physikalische System seine natürlichsten Berechnungen durchführen lassen.

Die Zukunft von PNNs: Jenseits der digitalen Hardwareleistung

Zukünftige Anwendungen von PNNs werden wahrscheinlich sehr breit gefächert sein und von großen generativen Modellen bis hin zu Klassifizierungsaufgaben in intelligenten Sensoren reichen. Sie müssen geschult werden, die Einschränkungen für die Schulung können jedoch je nach Anwendung variieren. Eine ideale Trainingsmethode sollte modellunabhängig, schnell und energieeffizient sowie robust gegenüber Hardwareschwankungen, Drift und Rauschen sein.

Obwohl die Entwicklung von PNNs voller Potenzial steckt, steht sie auch vor vielen Herausforderungen. Wie kann die Stabilität von PNNs während der Trainings- und Inferenzphasen sichergestellt werden? Wie können diese physischen Systeme in die bestehende digitale Hardware- und Software-Infrastruktur integriert werden?

Papieradresse: https://arxiv.org/pdf/2406.03372

Das Aufkommen physischer neuronaler Netze (PNNs) hat neue Hoffnungen und Herausforderungen für den Bereich der künstlichen Intelligenz mit sich gebracht. Da sich die Technologie weiterentwickelt und Probleme gelöst werden, wird erwartet, dass PNNs in Zukunft in verschiedenen Bereichen eine wichtige Rolle spielen und die künstliche Intelligenz auf ein neues Niveau bringen werden. Der Herausgeber von Downcodes wird weiterhin seine Aufmerksamkeit auf die neuesten Forschungsfortschritte zu PNNs richten, also bleiben Sie auf dem Laufenden!