Das Shanghai Artificial Intelligence Laboratory veröffentlichte am 4. Juli 2024 auf dem WAIC Science Frontier Main Forum die neueste Version des Modells der Scholar Puyu-Serie, InternLM2.5. Die Argumentationsfähigkeiten dieser Version in komplexen Szenarien wurden erheblich verbessert, sie unterstützt 1 Mio. ultralangen Kontext und kann unabhängig Internetsuchen und Informationsintegration durchführen, was einen großen Durchbruch darstellt. Der Herausgeber von Downcodes erläutert ausführlich die Funktionen und Open-Source-Informationen von InternLM2.5.

Das Shanghai Artificial Intelligence Laboratory stellte am 4. Juli 2024 auf dem WAIC Science Frontier Main Forum eine neue Version des Modells der Scholar Puyu-Serie, InternLM2.5, vor. Die Argumentationsfähigkeiten dieser Version in komplexen Szenarien wurden umfassend verbessert, sie unterstützt 1 Mio. ultralangen Kontext und kann selbstständig Internetsuchen durchführen und Informationen von Hunderten von Webseiten integrieren.

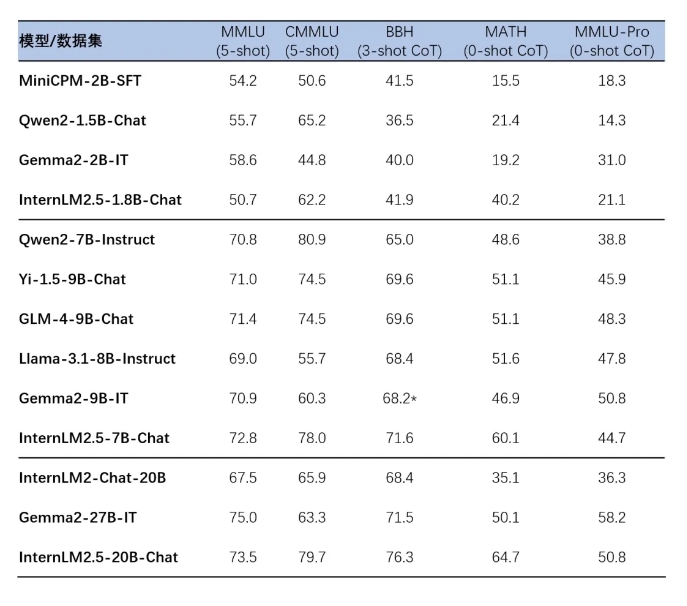

InternLM2.5 hat drei Parameterversionen des Modells veröffentlicht, nämlich 1.8B, 7B und 20B, um sich an unterschiedliche Anwendungsszenarien und Entwickleranforderungen anzupassen. Die 1.8B-Version ist ein ultraleichtes Modell, während die 20B-Version eine stärkere Gesamtleistung bietet und komplexere praktische Szenarien unterstützt. Alle diese Modelle sind Open Source und können auf der großen Modell-Homepage der Scholar·Puyu-Serie, der ModelScope-Homepage und der Hugging Face-Homepage gefunden werden.

InternLM2.5 iteriert auf mehreren Datensynthesetechnologien und verbessert so die Argumentationsfähigkeiten des Modells erheblich. Insbesondere erreichte die Genauigkeitsrate beim mathematischen Bewertungssatz MATH 64,7 %. Darüber hinaus verbessert das Modell die Fähigkeiten zur Verarbeitung von Kontextlängen durch effizientes Training in der Vortrainingsphase.

Die Modelle der InternLM2.5-Serie ermöglichen auch eine nahtlose Integration mit nachgelagerten Inferenz- und Feinabstimmungs-Frameworks, einschließlich des XTuner-Feinabstimmungs-Frameworks und des LMDeploy-Inferenz-Frameworks, die unabhängig vom Shanghai Artificial Intelligence Laboratory entwickelt wurden, sowie anderen Frameworks mit umfangreicher Benutzerbasis in der Community wie vLLM und Ollama und llama.cpp. Das von der Moda-Community eingeführte SWIFT-Tool unterstützt auch die Inferenz, Feinabstimmung und Bereitstellung von Modellen der InternLM2.5-Serie.

Die Anwendungserfahrung dieser Modelle umfasst mehrstufiges komplexes Denken, ein präzises Verständnis der Gesprächsabsichten in mehreren Runden, flexible Formatsteuerungsvorgänge und die Fähigkeit, komplexe Anweisungen zu befolgen. Detaillierte Installations- und Nutzungshandbücher werden bereitgestellt, um Entwicklern einen schnellen Einstieg zu erleichtern.

Homepage des großen Modells der Scholar·Puyu-Serie:

https://internlm.intern-ai.org.cn

ModelScope-Homepage:

https://www.modelscope.cn/organization/Shanghai_AI_Laboratory?tab=model

Hugging Face-Homepage:

https://huggingface.co/internlm

InternLM2.5 Open-Source-Link:

https://github.com/InternLM/InternLM

Die Open-Source-Veröffentlichung von InternLM2.5 eröffnet neue Möglichkeiten für Forschung und Anwendungen im Bereich der künstlichen Intelligenz. Man geht davon aus, dass seine leistungsstarke Leistung und Benutzerfreundlichkeit viele Entwickler zum Erkunden und Innovieren anregen wird. Der Herausgeber von Downcodes freut sich auf weitere hervorragende Anwendungen auf Basis von InternLM2.5!