Das israelische Startup für künstliche Intelligenz, aiOla, hat ein neues Open-Source-Spracherkennungsmodell Whisper-Medusa veröffentlicht, das gegenüber Whisper von OpenAI verbessert und 50 % schneller ist. Es ist Open Source und unterliegt der MIT-Lizenz für Hugging Face. Der Herausgeber von Downcodes wird Ihnen dieses auffällige neue Modell ausführlich erklären.

Das israelische Startup für künstliche Intelligenz aiOla hat kürzlich einen großen Schritt gemacht und die Einführung eines neuen Open-Source-Spracherkennungsmodells Whisper-Medusa angekündigt.

Dieses Modell ist nicht einfach. Es ist ganze 50 % schneller als OpenAIs berühmtes Whisper! Produkte. Darüber hinaus wurden der Code und die Gewichte auf Hugging Face unter einer MIT-Lizenz veröffentlicht, die Forschung und kommerzielle Nutzung ermöglicht.

Gill Hetz, Vizepräsident für Forschung bei aiOla, sagte, dass Open Source die Innovation und Zusammenarbeit der Community fördern und sie schneller und vollständiger machen könne. Diese Arbeit könnte den Weg für komplexe Systeme der künstlichen Intelligenz ebnen, die Benutzerfragen nahezu in Echtzeit verstehen und beantworten können.

In einer Zeit, in der Basismodelle vielfältige Inhalte produzieren können, ist eine fortschrittliche Spracherkennung immer noch sehr wichtig. Whisper kann beispielsweise komplexe Sprache in verschiedenen Sprachen und Akzenten verarbeiten. Es wird mehr als 5 Millionen Mal pro Monat heruntergeladen, unterstützt viele Anwendungen und ist zum Goldstandard für die Spracherkennung geworden.

Was ist das Besondere an aiOlas Whisper-Medusa?

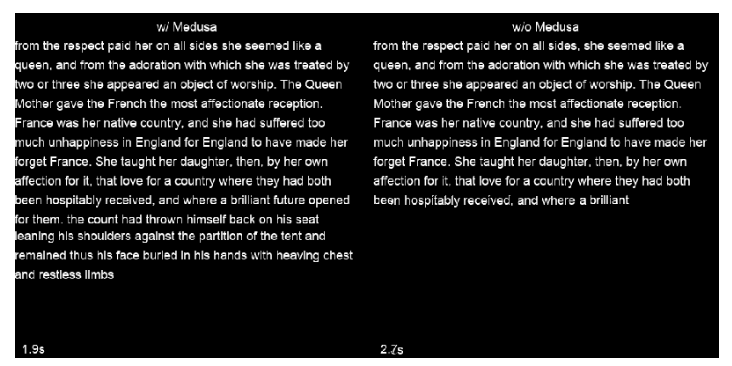

Das Unternehmen hat die Struktur von Whisper geändert und einen Mehrkopf-Aufmerksamkeitsmechanismus hinzugefügt, der 10 Token gleichzeitig vorhersagen und die Geschwindigkeit um 50 % erhöhen kann, ohne die Genauigkeit zu beeinträchtigen. Zum Trainieren dieses Modells wurde eine schwach überwachte Methode des maschinellen Lernens verwendet, und es wird in Zukunft leistungsfähigere Versionen geben. Darüber hinaus gehen die Geschwindigkeitsverbesserungen nicht zu Lasten der Leistung, da das Rückgrat von Whisper-Medusa auf Whisper basiert.

Beim Training von Whisper-Medusa nutzte aiOla eine maschinelle Lernmethode namens „Weak Supervision“. Als Teil davon wurden die Hauptkomponenten von Whisper eingefroren und ein zusätzliches Token-Vorhersagemodul trainiert, das die vom Modell generierten Audiotranskriptionen als Labels nutzte.

Auf die Frage, ob Unternehmen einen frühen Zugang zu Whisper-Medusa erhalten könnten, sagte Hetz, dass sie an realen Anwendungsfällen für Unternehmensdaten getestet wurden und in realen Szenarien präzise laufen können, wodurch Sprachanwendungen in Zukunft reaktionsfähiger werden. Letztendlich ist er davon überzeugt, dass höhere Erkennungs- und Transkriptionsgeschwindigkeiten schnellere Bearbeitungszeiten für Sprachanwendungen ermöglichen und den Weg für die Bereitstellung von Antworten in Echtzeit ebnen werden.

Highlight:

?50 % schneller: Whisper-Medusa von aiOla ist deutlich schneller als die Whisper-Spracherkennung von OpenAI.

?Kein Genauigkeitsverlust: Die Geschwindigkeit wird verbessert, während die gleiche Genauigkeit wie beim Originalmodell beibehalten wird.

Breite Anwendungsaussichten: Es wird erwartet, dass die Reaktion beschleunigt, die Effizienz verbessert und die Kosten bei Sprachanwendungen gesenkt werden.

Alles in allem dürfte das Whisper-Medusa-Modell von aiOla mit seinem Geschwindigkeitsvorteil und seinen Open-Source-Eigenschaften eine neue Welle im Bereich der Spracherkennung auslösen und erhebliche Leistungsverbesserungen für verschiedene Sprachanwendungen bringen. Der Herausgeber von Downcodes wird der weiteren Entwicklung und den Community-Beiträgen dieses Modells weiterhin Aufmerksamkeit schenken.