Jina AI hat Reader-LM veröffentlicht, ein leichtes Sprachmodell, das speziell für die Konvertierung von HTML in sauberes Markdown entwickelt wurde. Es kann überladene Inhalte wie Anzeigen und Skripte effizient von Webseiten entfernen, um klar strukturierte Markdown-Dateien ohne komplexe reguläre Ausdrücke oder manuelle Vorgänge zu generieren. Reader-LM ist in zwei Versionen erhältlich: Reader-LM-0.5B und Reader-LM-1.5B, die beide für den effizienten Betrieb auch in ressourcenbeschränkten Umgebungen optimiert sind und Kontexte mit bis zu 256.000 Token unterstützen.

Jina AI hat zwei kleine Sprachmodelle auf den Markt gebracht, die speziell für die Konvertierung von Original-HTML-Inhalten in ein sauberes und ordentliches Markdown-Format entwickelt wurden, sodass wir uns der mühsamen Verarbeitung von Webseitendaten entledigen können.

Das größte Highlight dieses Modells namens Reader-LM ist, dass es Webinhalte schnell und effizient in Markdown-Dateien konvertieren kann.

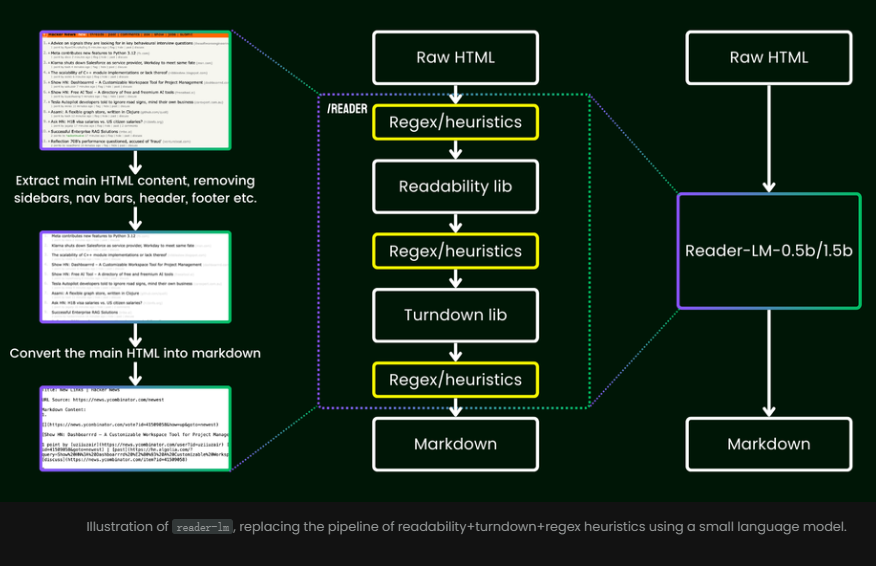

Der Vorteil besteht darin, dass Sie nicht mehr auf komplexe Regeln oder aufwändige reguläre Ausdrücke angewiesen sind. Diese Modelle entfernen intelligent und automatisch überladene Inhalte von Webseiten, wie z. B. Anzeigen, Skripte und Navigationsleisten, und präsentieren schließlich ein klares und organisiertes Markdown-Format.

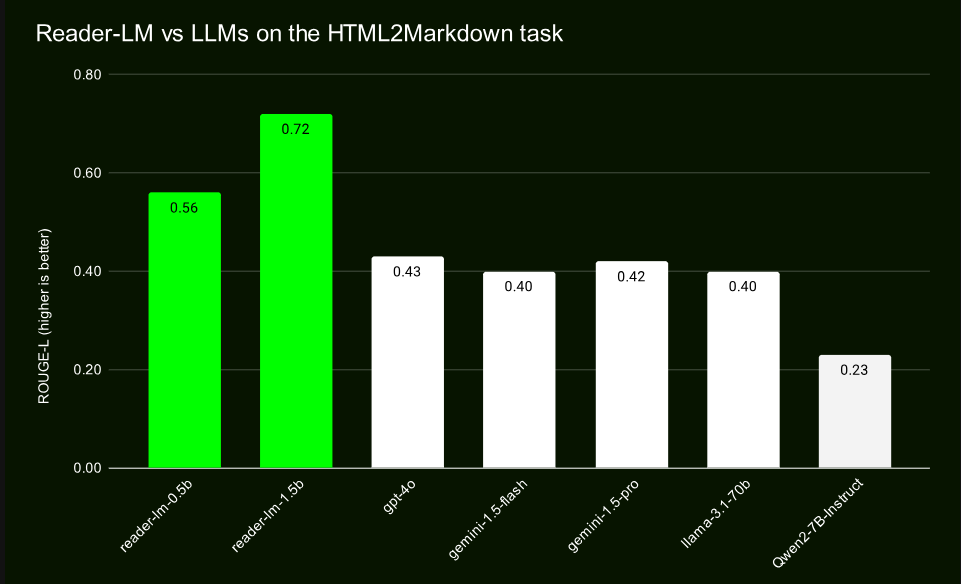

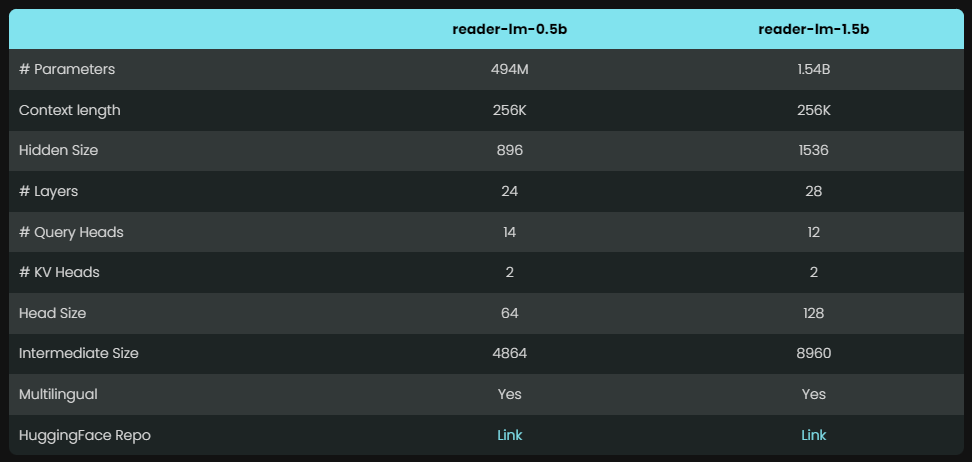

Reader-LM bietet zwei Modelle mit unterschiedlichen Parametern, nämlich Reader-LM-0.5B und Reader-LM-1.5B. Obwohl die Anzahl der Parameter dieser beiden Modelle nicht riesig ist, sind sie für die Aufgabe der Konvertierung von HTML in Markdown optimiert. Die Ergebnisse sind überraschend und ihre Leistung übertrifft viele große Sprachmodelle.

Dank ihres kompakten Designs können diese Modelle auch in ressourcenbeschränkten Umgebungen effizient eingesetzt werden. Noch lobenswerter ist, dass Reader-LM nicht nur mehrere Sprachen unterstützt, sondern auch Kontextdaten mit bis zu 256.000 Token verarbeiten kann, wodurch selbst komplexe HTML-Dateien problemlos verarbeitet werden können.

Im Gegensatz zu herkömmlichen Methoden, die auf regulären Ausdrücken oder manuellen Einstellungen basieren, bietet Reader-LM eine End-to-End-Lösung, die HTML-Daten automatisch bereinigt und wichtige Informationen extrahiert.

Durch Vergleichstests mit großen Modellen wie GPT-4 und Gemini hat Reader-LM eine hervorragende Leistung gezeigt, insbesondere im Hinblick auf die Strukturerhaltung und die Verwendung der Markdown-Syntax. Der Reader-LM-1.5B schneidet bei verschiedenen Indikatoren besonders gut ab, mit einem ROUGE-L-Score von 0,72 zeigt er seine hohe Genauigkeit bei der Generierung von Inhalten, zudem ist seine Fehlerquote deutlich niedriger als bei vergleichbaren Produkten.

Aufgrund des kompakten Designs von Reader-LM ist die Hardware-Ressourcennutzung geringer, insbesondere das 0,5-B-Modell, das in Umgebungen mit geringer Konfiguration wie Google Colab reibungslos läuft. Trotz seiner geringen Größe verfügt Reader-LM dennoch über leistungsstarke Funktionen zur Verarbeitung langer Kontexte und kann große und komplexe Webinhalte effizient verarbeiten, ohne die Leistung zu beeinträchtigen.

In Bezug auf die Schulung verwendet Reader-LM einen mehrstufigen Prozess und konzentriert sich auf die Extraktion von Markdown-Inhalten aus ursprünglichem und verrauschtem HTML.

Der Trainingsprozess umfasst die Paarung einer großen Anzahl realer Webseiten und synthetischer Daten, um die Effizienz und Genauigkeit des Modells sicherzustellen. Nach einer sorgfältig konzipierten zweistufigen Schulung verbesserte Reader-LM schrittweise seine Fähigkeit zur Verarbeitung komplexer HTML-Dateien und vermied effektiv das Problem der wiederholten Generierung.

Offizielle Einführung: https://jina.ai/news/reader-lm-small-lingual-models-for-cleaning-and-converting-html-to-markdown/

Alles in allem bietet Reader-LM eine effiziente, praktische und genaue Lösung für die Konvertierung von HTML in Markdown. Sein leichtes Design erleichtert die Ausführung in verschiedenen Umgebungen und macht es zu einer idealen Wahl für die Verarbeitung von Webseitendaten. Weitere Informationen finden Sie unter dem offiziellen Einführungslink.