Alibaba kündigte an, dass es sein visuelles Sprachmodell Qwen2-VL der zweiten Generation als Open Source veröffentlichen und API-Schnittstellen und Open-Source-Code bereitstellen wird, um die Nutzung durch Entwickler zu erleichtern. Das Modell hat erhebliche Fortschritte beim Bild- und Videoverständnis gemacht, unterstützt mehrere Sprachen und verfügt über starke visuelle Agentenfähigkeiten, die in der Lage sind, Mobiltelefone und Roboter autonom zu bedienen. Qwen2-VL bietet Modelle in drei Größen: 2B, 7B und 72B, um den Anforderungen verschiedener Anwendungsszenarien gerecht zu werden. Das 72B-Modell schneidet bei den meisten Indikatoren am besten ab, während das 2B-Modell für mobile Anwendungen geeignet ist.

Am 2. September kündigte Tongyi Qianwen die Open Source seines visuellen Sprachmodells Qwen2-VL der zweiten Generation an und startete APIs für die Größen 2B und 7B sowie sein quantifiziertes Versionsmodell auf der Alibaba Cloud Bailian-Plattform, damit Benutzer sie direkt aufrufen können.

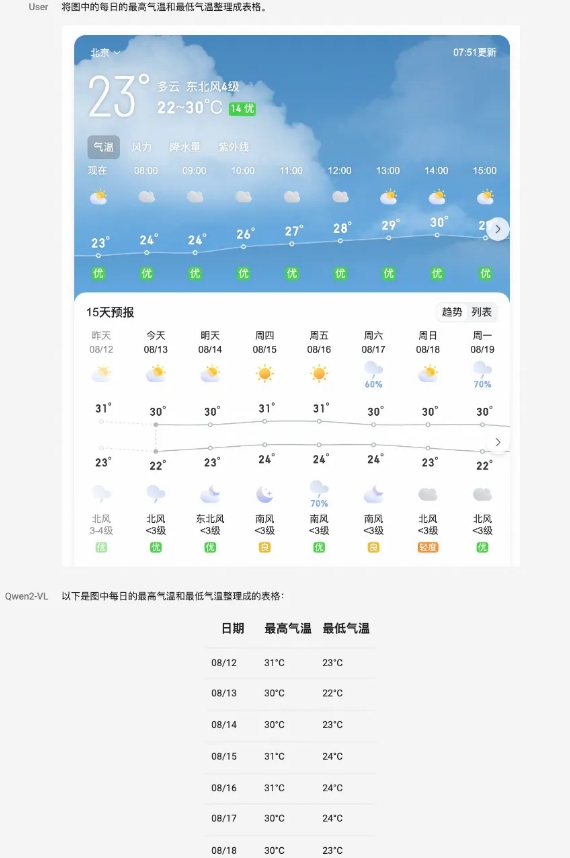

Das Qwen2-VL-Modell erzielt umfassende Leistungsverbesserungen in mehreren Aspekten. Es kann Bilder mit unterschiedlichen Auflösungen und Seitenverhältnissen verstehen und hat in Benchmark-Tests wie DocVQA, RealWorldQA und MTVQA weltweit führende Leistungen erzielt. Darüber hinaus kann das Modell auch lange Videos von mehr als 20 Minuten verstehen und videobasierte Q&A-, Dialog- und Content-Erstellungsanwendungen unterstützen. Qwen2-VL verfügt außerdem über leistungsstarke visuelle Intelligenzfunktionen und kann Mobiltelefone und Roboter autonom steuern, um komplexe Überlegungen und Entscheidungsprozesse durchzuführen.

Das Modell ist in der Lage, mehrsprachigen Text in Bildern und Videos zu verstehen, darunter Chinesisch, Englisch, die meisten europäischen Sprachen, Japanisch, Koreanisch, Arabisch, Vietnamesisch und mehr. Das Team von Tongyi Qianwen bewertete die Fähigkeiten des Modells anhand von sechs Aspekten, darunter umfassende College-Fragen, mathematische Fähigkeiten, Verständnis von Dokumenten, Tabellen, mehrsprachigem Text und Bildern, allgemeine Fragen und Antworten zu Szenen, Videoverständnis und Agentenfähigkeiten.

Als Flaggschiffmodell hat Qwen2-VL-72B in den meisten Indikatoren das optimale Niveau erreicht. Qwen2-VL-7B erreicht mit seiner wirtschaftlichen Parameterskala eine äußerst wettbewerbsfähige Leistung, während Qwen2-VL-2B umfangreiche mobile Anwendungen unterstützt und über vollständige Bild- und Video-Verständnisfunktionen für mehrere Sprachen verfügt.

In Bezug auf die Modellarchitektur setzt Qwen2-VL die Serienstruktur von ViT plus Qwen2 fort. Alle drei Modellgrößen verwenden 600M ViT und unterstützen die einheitliche Eingabe von Bildern und Videos. Um die Wahrnehmung visueller Informationen durch das Modell und die Videoverständnisfähigkeiten zu verbessern, hat das Team die Architektur aktualisiert, einschließlich der Implementierung vollständiger Unterstützung für native dynamische Auflösung und der Verwendung der Methode der multimodalen Rotationspositionseinbettung (M-ROPE).

Die Alibaba Cloud Bailian-Plattform bietet die Qwen2-VL-72B-API, die Benutzer direkt aufrufen können. Gleichzeitig wurde der Open-Source-Code von Qwen2-VL-2B und Qwen2-VL-7B in Hugging Face Transformers, vLLM und andere Frameworks von Drittanbietern integriert, und Entwickler können die Modelle über diese Plattformen herunterladen und verwenden.

Alibaba Cloud Bailian-Plattform:

https://help.aliyun.com/zh/model-studio/developer-reference/qwen-vl-api

GitHub:

https://github.com/QwenLM/Qwen2-VL

HuggingFace:

https://huggingface.co/collections/Qwen/qwen2-vl-66cee7455501d7126940800d

Magic ModelUmfang:

https://modelscope.cn/organization/qwen?tab=model

Modelerfahrung:

https://huggingface.co/spaces/Qwen/Qwen2-VL

Kurz gesagt, die Open Source des Qwen2-VL-Modells bietet Entwicklern leistungsstarke Tools, fördert die Entwicklung der Technologie für visuelle Sprachmodelle und bietet mehr Möglichkeiten für verschiedene Anwendungsszenarien. Entwickler können das Modell und den Code über den bereitgestellten Link erhalten, um mit der Entwicklung ihrer eigenen Anwendungen zu beginnen.