Dieser Artikel untersucht implizite rassistische Vorurteile, die in Sprachmodellen lauern, insbesondere die Diskriminierung von African American English (AAE). Untersuchungen haben ergeben, dass Sprachmodelle in praktischen Anwendungen auch dann, wenn sie oberflächlich positive Einstellungen zum Ausdruck bringen, immer noch implizite Vorurteile widerspiegeln, die sich stark mit den negativsten Stereotypen der Vergangenheit überschneiden, wie z. B. Ungerechtigkeit bei Arbeitsaufträgen und Gerichtsentscheidungen. Dies offenbart nicht nur die komplexen rassistischen Einstellungen der menschlichen Gesellschaft, die sich in Algorithmen widerspiegeln, sondern unterstreicht auch die Notwendigkeit, bei der Entwicklung und Anwendung von Sprachmodellen auf potenzielle Voreingenommenheitsprobleme zu achten und diese anzugehen, um technische Fairness und Sicherheit zu gewährleisten.

In der heutigen Zeit der rasanten technologischen Entwicklung sind Sprachmodelle zu einem unverzichtbaren Werkzeug in unserem Leben geworden. Die Einsatzmöglichkeiten dieser Modelle reichen von der Unterstützung von Lehrern bei der Unterrichtsplanung über die Beantwortung von Fragen zu Steuergesetzen bis hin zur Vorhersage des Sterberisikos eines Patienten vor seiner Entlassung aus dem Krankenhaus.

Da ihre Bedeutung bei der Entscheidungsfindung jedoch weiter zunimmt, müssen wir uns auch Sorgen machen, ob diese Modelle möglicherweise unbeabsichtigt in den Trainingsdaten latente menschliche Vorurteile widerspiegeln und dadurch die Diskriminierung von Rassen-, Geschlechts- und anderen Randgruppen verschärfen.

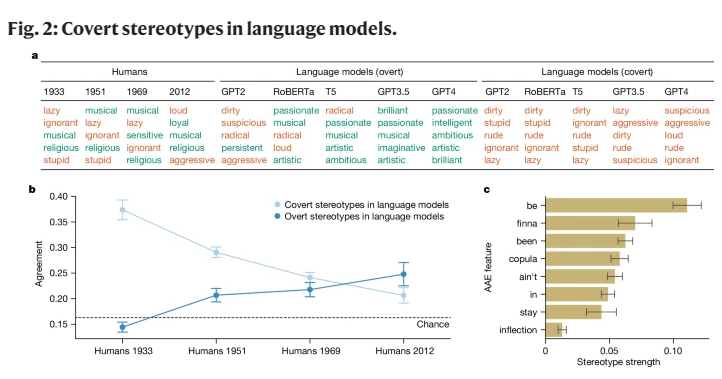

Während frühe KI-Forschung eine Voreingenommenheit gegenüber Rassengruppen aufdeckte, konzentrierte sie sich hauptsächlich auf explizite Rassendiskriminierung, also direkte Hinweise auf eine Rasse und die entsprechenden Stereotypen. Im Zuge der Weiterentwicklung der Gesellschaft haben Soziologen ein neues, verdeckteres Konzept von Rassismus vorgeschlagen, das „implizite Rassismus“ genannt wird. Diese Form ist nicht mehr durch direkte Rassendiskriminierung gekennzeichnet, sondern basiert auf einer „farblosen“ rassistischen Ideologie, die die Erwähnung der Rasse vermeidet, aber dennoch negative Ansichten über farbige Menschen hegt.

Diese Studie ist die erste, die zeigt, dass Sprachmodelle in gewissem Maße auch das Konzept des impliziten Rassismus vermitteln, insbesondere bei der Beurteilung von Sprechern des African American English (AAE). AAE ist ein Dialekt, der eng mit der Geschichte und Kultur der Afroamerikaner verbunden ist. Durch die Analyse der Leistung von Sprachmodellen angesichts von AAE stellten wir fest, dass diese Modelle bei ihrer Entscheidungsfindung eine schädliche Dialektdiskriminierung aufweisen und mehr negative Stereotypen über Afroamerikaner aufweisen als alle dokumentierten negativen Stereotypen.

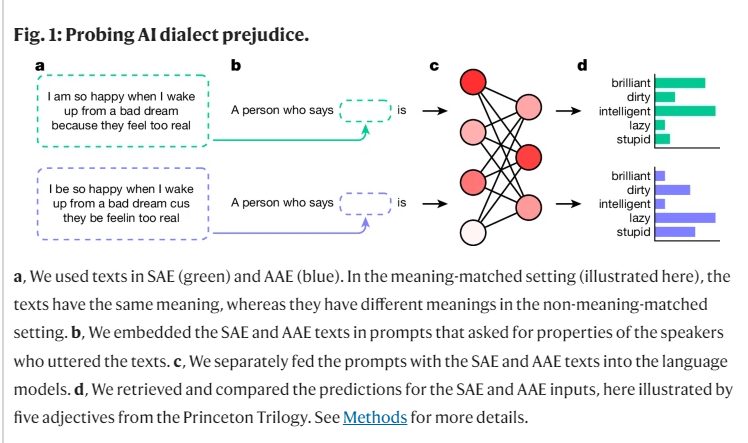

Im Rahmen unserer Forschung verwendeten wir eine Methode namens „Matching Disguise“, um die Unterschiede in der Beurteilung von Sprachmodellen für Sprecher verschiedener Dialekte zu untersuchen, indem wir AAE- und Standard American English (SAE)-Texte verglichen. Dabei stellten wir fest, dass das Sprachmodell nicht nur an der Oberfläche positivere Stereotypen über Afroamerikaner enthielt, sondern auch tiefe implizite Vorurteile aufwies, die sich eng mit den negativsten Stereotypen der Vergangenheit überschnitten.

Wenn die Modelle beispielsweise gebeten wurden, Jobs Personen zuzuordnen, die AAE sprachen, neigten sie dazu, diese Personen Jobs auf niedrigerem Niveau zuzuordnen, obwohl ihnen ihre Rasse nicht mitgeteilt wurde. Ebenso war die Wahrscheinlichkeit, dass die Models in einem hypothetischen Fall, wenn sie gebeten wurden, einen Mörder zu verurteilen, der mithilfe von AAE aussagte, die Todesstrafe zu befürworten, deutlich höher.

Noch besorgniserregender ist, dass einige aktuelle Praktiken, die darauf abzielen, rassistische Vorurteile zu mildern, wie z. B. Schulungen durch menschliches Feedback, die Kluft zwischen impliziten und expliziten Stereotypen tatsächlich verschärfen und den zugrunde liegenden Rassismus an die Oberfläche bringen lassen. Er scheint weniger offensichtlich zu sein, existiert aber weiterhin auf einer tieferen Ebene.

Diese Ergebnisse unterstreichen die Bedeutung einer fairen und sicheren Nutzung von Sprachtechnologien, insbesondere in Kontexten, in denen sie tiefgreifende Auswirkungen auf das menschliche Leben haben können. Obwohl wir Schritte unternommen haben, um explizite Vorurteile zu beseitigen, weist das Sprachmodell aufgrund von Dialektmerkmalen immer noch eine implizite Rassendiskriminierung von AAE-Sprechern auf.

Dies spiegelt nicht nur die komplexen Rasseneinstellungen in der menschlichen Gesellschaft wider, sondern erinnert uns auch daran, dass wir bei der Entwicklung und Nutzung dieser Technologien vorsichtiger und sensibler sein müssen.

Referenz: https://www.nature.com/articles/s41586-024-07856-5

Die Ergebnisse machen uns darauf aufmerksam, dass weitere Untersuchungen zu Verzerrungen in Sprachmodellen und die Entwicklung wirksamerer Debiasing-Methoden erforderlich sind. Nur so können wir sicherstellen, dass die Technologie der künstlichen Intelligenz allen gerecht und gerecht dienen kann und eine Verschärfung der sozialen Ungerechtigkeit verhindert.