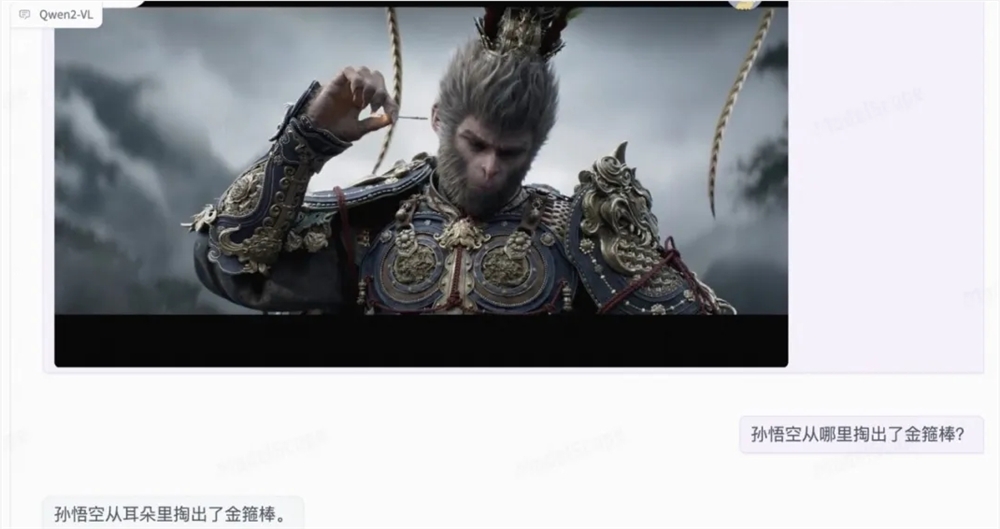

Das Alibaba Barmama Institute veröffentlichte am 30. August 2024 sein Hauptaktualisierung von Qwen2-VL, seinem multimodalen groß angelegten Sprachmodell. Dieses Update hat erhebliche Fortschritte bei der Bildverständnis, Videoverarbeitung und Multi -Language -Unterstützung erzielt und neue Leistungsbenchmarks eingerichtet. Das QWEN2-VL-Modell verbessert nicht nur die Fähigkeit, visuelle Informationen zu verstehen, sondern verfügt auch über eine hochrangige Fähigkeit zur Videoverständnis und die integrierte Funktion zur Visualisierungsagenten, sodass es komplexeres Denken und Entscheidungsfindung verursachen kann. Darüber hinaus erleichtert die erweiterte Support mit mehreren Sprachen die globale Verwendung.

Das QWEN2-VL-Modell hat eine signifikante Verbesserung des Bildverständnisses, der Videoverarbeitung und des Supports mit mehreren Sprachen erzielt und neue Benchmarks für wichtige Leistungsindikatoren festgelegt. Die neuen Funktionen des QWEN2-VL-Modells umfassen verbesserte Bildverständnisfunktionen, die visuelle Informationen genauer verstehen und erklären können. In der Lage sein, in der Lage zu sein, in der Lage zu sein, in der Lage zu sein, in der Lage zu sein, den starken Agenten des komplexen Denkens und der Entscheidung zu machen -und die erweiterte Multi -Langer -Unterstützung erleichtert den Zugriff und die effektive In -Sprachumgebung.

In Bezug auf die technische Architektur realisiert QWEN2-VL die dynamische Auflösung, die Bilder willkürlich auflösen kann, und es besteht keine Notwendigkeit, sie in Blöcke zu unterteilen, um die Konsistenz zwischen der Modelleingabe und den inhärenten Informationen des Bildes zu gewährleisten. Darüber hinaus ermöglicht die Innovation der multimodalen Rotationsposition (M-ROPE) das Modell, um 1D-Text-, 2D-Vision- und 3D-Video-Standortinformationen gleichzeitig zu erfassen und zu integrieren.

Das QWEN2-VL-7B-Modell hat erfolgreich Unterstützung für Bilder, Mehrwerte und Videoeingaben unter der Skala von 7b beibehalten und hat sich gut im Dokumentverständnis von Aufgaben und Image-Multisprachlustern-Verständnis erbracht.

Gleichzeitig startete das Team auch ein 2B -Modell für die mobile Bereitstellungsoptimierung.

Modelllink:

Qwen2-vl-2b-instrus: https: //www.modelscope.cn/models/qwen/qwen2-vl-2b-instruct

Qwen2-vl-7b-instrus: https: //www.modelscope.cn/models/qwen/qwen2-vl-instruct

Das Update des QWEN2-VL-Modells markiert einen neuen Durchbruch in der multimodalen großflächigen Sprachmodell-Technologie. Der Start der beiden Versionen von 7B und 2B bietet auch flexiblere Auswahlmöglichkeiten für verschiedene Anwendungsszenarien.