Anthropic hat kürzlich ein neues Merkmal der Claude -Serie großer Sprachmodelle auf den Markt gebracht, um die Kosten für die Verwendung von KI zu senken und die Leistung zu verbessern. Dieser Schritt gilt als einzigartige Strategie des Anthropic im Wettbewerb mit Riesen wie OpenAI, Google und Microsoft, um sich aus der Steigerung der Effizienz und der Reduzierung der Kostenperspektiven zu entscheiden. Diese Funktion wird derzeit öffentlich auf der API von Claude3.5 Sonett und Claude3 Haiku -Modell getestet, was verspricht, die Kosten von bis zu 90%zu senken und die Reaktionsgeschwindigkeit einiger Anwendungsszenarien zu erhöhen. Der tatsächliche Effekt muss jedoch noch Marktinspektion benötigen.

Am 14. August kündigte Anthropic an, dass ein neues Feature namens The Claude Series Large Language Model auf den Markt gebracht wurde und behauptete, dass es die Kosten für die Verwendung von KI erheblich senken und die Leistung verbessern kann. Aber ob diese Funktion so magisch sein kann, wie das Unternehmen sagte und auf dem Markt getestet werden muss.

Die Cache -Funktion wird öffentlich auf der API des Claude3.5sonnet- und Claude3Haiku -Modells getestet. Mit dieser Funktion können Benutzer bestimmte Kontextinformationen, einschließlich komplexer Anweisungen und Daten, ohne zusätzliche Kosten oder erhöhte Verzögerungen speichern und wiederverwenden. Der Unternehmenssprecher sagte, dass dies eines der vielen Schnitteigenschaften ist, die sie entwickelt haben, um die Claude -Fähigkeiten zu verbessern.

Gegenwärtig haben technologische Giganten wie OpenAI, Google und Microsoft heftige Wettbewerbe auf dem Gebiet großer Sprachmodelle auf den Markt gebracht, und jedes Unternehmen versucht, die Leistung und die Marktwettbewerbsfähigkeit seiner Produkte zu verbessern. In diesem Wettbewerb entschied sich Anthropic, sich aus der Sicht der Verbesserung der Nutzungseffizienz und der Reduzierung der Kosten zu senken und seine einzigartige Marktstrategie zu zeigen.

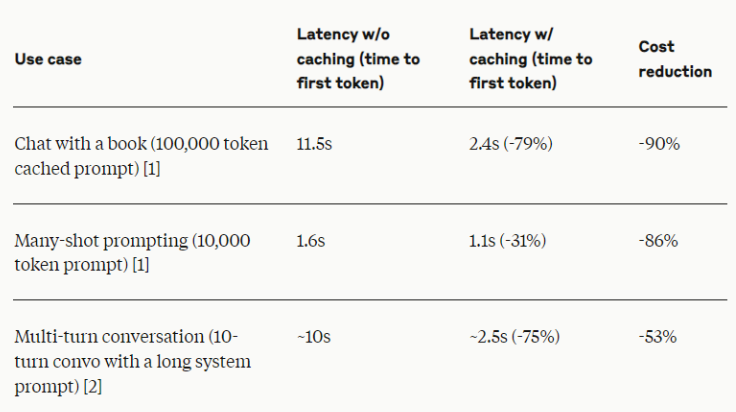

Laut Anthropic kann diese neue Funktion bis zu 90%der Kosten und die Reaktionsgeschwindigkeit in einigen Anwendungsszenarien verdoppeln. Diese Zahlen sind zweifellos beeindruckend, Branchenexperten erinnern jedoch, dass der tatsächliche Effekt aufgrund der spezifischen Anwendungsszenarien und der Implementierung unterschiedlich sein kann.

Anthropic sagte, dass die Cache -Funktion besonders für Szenen geeignet ist, die im Kontext in mehreren Abfragen oder Sitzungen konsistent sein müssen, wie z. B. Langzeitdialog, Dokumentenverarbeitung, Codeunterstützung und komplexe Tools. Es wird erwartet, dass diese Methode die Verbesserung der Effizienz für verschiedene kommerzielle KI -Anwendungen bringt.

Branchenkenner wiesen darauf hin, dass andere KI -Unternehmen zwar auch die Methode zur Verbesserung der Modelleffizienz und die Reduzierung der Nutzungskosten aktiv untersuchen, obwohl die neuen Funktionen von Anthropic intelligent zu sein scheinen. Zum Beispiel bietet OpenAI unterschiedliche Möglichkeiten für Funktionen und Preise, während Google sich für die Entwicklung von Modellen einsetzt, die effizient auf normaler Hardware arbeiten können.

Für die tatsächliche Wirkung dieses neuen Features ist der Markt immer noch vorsichtig. Wie jede neue Technologie, insbesondere im sich schnell entwickelnden KI -Bereich, muss die Leistung der Cache -Funktion in der realen Welt noch beobachtet werden. Anthropic sagte, dass es eng mit den Kunden zusammenarbeiten wird, um relevante Daten und Feedback zu sammeln, was der besten Praxis in der Branche entspricht, die den Einfluss neuer KI -Technologie bewertet.

Die Initiative von Anthropic kann einen großen Einfluss auf die KI -Branche haben, insbesondere auf die Bereitstellung fortschrittlicher KI -Fähigkeiten für KMU. Wenn diese Funktion wirklich so effektiv ist wie förderend, kann sie den Schwellenwert für Unternehmen verringern, komplexe KI -Lösungen einzusetzen, wodurch die Anwendung der AI -Technologie in einem breiteren Geschäftsbereich fördert.

Mit der Entwicklung öffentlicher Tests haben Unternehmen und Entwickler die Möglichkeit, die tatsächliche Leistung der Cache -Funktion persönlich zu bewerten und wie sie sich an ihre jeweiligen KI -Strategien anpasst. In den nächsten Monaten wird erwartet, dass wir die Leistung dieser Management -KI -Eingabeaufforderung und den Kontext in praktischen Anwendungen erkennen.

Die schnelle Cache -Funktion von Anthropic stellt einen interessanten Versuch der KI -Industrie in Bezug auf Effizienz und Kostenoptimierung dar. Unabhängig davon, ob es jedoch die Veränderung der Branche wirklich führen kann, erfordert es auch eine weitere Inspektion des Marktes. In jedem Fall spiegelt diese Innovation die kontinuierliche Erforschung neuer Richtungen in KI -Unternehmen im heftigen Wettbewerb wider und weist auch darauf hin, dass die KI -Technologie eine neue Runde effizienter Revolution einleiten kann.

Insgesamt ist der Schlüssel zum Erfolg der anthropischen Eingabeaufforderung -Cache -Funktion der tatsächliche Anwendungseffekt. Die anschließende Marktleistung wird zum ultimativen Standard für das Testen dieser Technologie und werden auch die gesamte KI -Branche neue Offenbarung bringen.