Der von Anthropic verwendete Webcrawler ClaudeBot besuchte die iFixit-Website über einen Zeitraum von 24 Stunden häufig und verstieß offenbar gegen die Nutzungsbedingungen des Unternehmens.

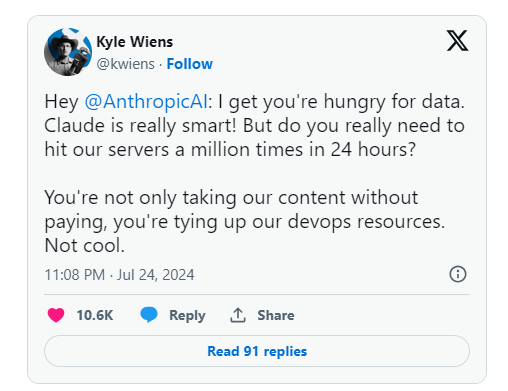

Kyle Wiens, CEO von iFixit, sagte, dass es sich nicht nur um eine unbefugte Nutzung von Inhalten handelte, sondern auch um die Inanspruchnahme von Entwicklungsressourcen. Als Reaktion darauf hat Fixit robots.txt eine Crawl-Delay-Erweiterung hinzugefügt, um den Crawler-Zugriff einzuschränken.

Neben iFixit berichteten auch Eric Holscher, Mitbegründer von Read the Docs, und Matt Barrie, CEO von Freelancer.com, dass ihre Websites vom Anthropic-Crawler angegriffen wurden.

In den vergangenen Monaten berichteten Reddit-Beiträge über einen starken Anstieg der Web-Scraping-Aktivitäten von Anthropic. Im April dieses Jahres wurde ein Website-Ausfall im Linux Mint-Webforum ebenfalls auf die Crawling-Aktivitäten von ClaudeBot zurückgeführt.

Viele KI-Unternehmen wie OpenAI verweigern den Crawler-Zugriff über robots.txt-Dateien, allerdings haben Website-Besitzer dadurch nicht die Möglichkeit, flexibel zu definieren, welche Crawling-Inhalte erlaubt und welche verboten sind. Es wurde festgestellt, dass ein anderes KI-Unternehmen, Perplexity, die Ausschlussregeln von robots.txt vollständig ignoriert.

Dennoch ist es für viele Unternehmen eine der wenigen Möglichkeiten, Daten vor der Verwendung für KI-Schulungsmaterial zu schützen, und Reddit ist kürzlich auch gegen Webcrawler vorgegangen.