Was würde passieren, wenn die KI anhand der von ihr generierten Bilder neu trainiert würde? Kürzlich führten Forscher der Stanford University und der University of California in Berkeley ein solches Experiment durch, und die Ergebnisse waren überraschend.

Die Forscher fanden heraus, dass die Modelle stark verzerrte Bilder erzeugten, wenn KI-Bilderzeugungsmodelle auf die Verwendung von selbst generierten Bildern umgeschult wurden. Schlimmer noch, diese Verzerrung beschränkt sich nicht auf die für das Neutraining verwendeten Texthinweise. Sobald das Modell „kontaminiert“ ist, ist es für das Modell schwierig, es vollständig wiederherzustellen, selbst wenn es später nur mit echten Bildern neu trainiert wird.

Ausgangspunkt für das Experiment ist ein Open-Source-Modell namens Stable Diffusion (SD). Die Forscher wählten zunächst 70.000 hochwertige Gesichtsbilder aus dem FFHQ-Gesichtsdatensatz aus und klassifizierten sie automatisch. Anschließend nutzten sie diese realen Bilder als Eingabe, um mithilfe des Stable Diffusion-Modells 900 Bilder zu generieren, die den Merkmalen einer bestimmten Personengruppe entsprechen.

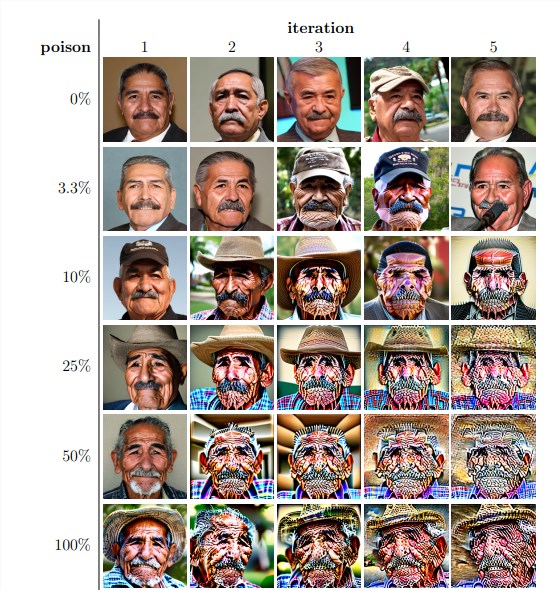

Als nächstes nutzten die Forscher diese generierten Bilder für ein iteratives Neutraining des Modells. Sie fanden heraus, dass das Modell unabhängig vom Anteil der selbst generierten Bilder im Umschulungsdatensatz schließlich zusammenbrach und die Qualität der generierten Bilder dramatisch abnahm. Selbst wenn die Umschulungsdaten nur 3 % selbst generierte Bilder enthalten, besteht immer noch das Phänomen des Modellkollapses.

Experimentelle Ergebnisse zeigen, dass die Basisversion des Stable Diffusion-Modells Bilder generiert, die mit Texthinweisen übereinstimmen und eine hohe visuelle Qualität aufweisen. Als das Modell jedoch iterativ neu trainiert wurde, zeigten die generierten Bilder semantische Inkonsistenzen und visuelle Verzerrungen. Die Forscher fanden außerdem heraus, dass der Zusammenbruch des Modells nicht nur die Bildqualität beeinträchtigte, sondern auch zu einem Mangel an Diversität in den erzeugten Bildern führte.

Um dies zu überprüfen, führten die Forscher auch kontrollierte Experimente durch, um die Auswirkungen des Modellkollapses abzumildern, indem sie das Farbhistogramm der generierten Bilder anpassten und Bilder mit geringer Qualität entfernten. Die Ergebnisse zeigen jedoch, dass diese Maßnahmen den Modellkollaps nicht wirksam verhindern können.

Die Forscher untersuchten auch, ob es einem Modell möglich sei, sich nach einer „Kontamination“ durch erneutes Training zu erholen. Sie stellten fest, dass die Qualität der resultierenden Bilder zwar in einigen Fällen nach mehreren Iterationen der Umschulung wiederhergestellt wurde, Anzeichen eines Modellkollapses jedoch bestehen blieben. Dies zeigt, dass die Auswirkungen einer „Kontamination“ eines Modells langfristig oder sogar irreversibel sein können.

Diese Studie deckt ein wichtiges Problem auf: Derzeit gängige diffusionsbasierte KI-Systeme zur Text-zu-Bild-Generierung reagieren sehr empfindlich auf Datenkontamination. Diese „Kontamination“ kann unbeabsichtigt auftreten, beispielsweise durch wahlloses Scrapen von Bildern aus Online-Quellen. Es könnte sich auch um einen gezielten Angriff handeln, beispielsweise um das absichtliche Platzieren „verfälschter“ Daten auf einer Website.

Angesichts dieser Herausforderungen haben Forscher einige mögliche Lösungen vorgeschlagen, z. B. die Verwendung von Bildauthentizitätsdetektoren zum Ausschluss von KI-generierten Bildern oder das Hinzufügen von Wasserzeichen zu generierten Bildern. Diese Methoden sind zwar unvollkommen, können aber in Kombination das Risiko einer Datenkontamination erheblich verringern.

Diese Studie erinnert uns daran, dass die Entwicklung der KI-Technologie nicht ohne Risiken ist. Wir müssen mit KI-generierten Inhalten vorsichtiger umgehen, um sicherzustellen, dass sie keine langfristigen negativen Auswirkungen auf unsere Modelle und Datensätze haben. Zukünftige Forschung muss weiter untersuchen, wie KI-Systeme widerstandsfähiger gegen diese Art von Datenkontamination gemacht werden können, oder Techniken entwickelt werden, die die Modellheilung beschleunigen können.