Nachdem Meta Llama 3.1 veröffentlicht hatte, brachte Mistral AI sein Flaggschiffmodell Mistral Large 2 auf den Markt, mit einem Parametervolumen von 123 Milliarden, einem Kontextfenster von erstaunlichen 128.000 und einer Leistung, die mit Llama 3.1 vergleichbar ist. Das Modell unterstützt mehrere Sprachen und Programmiersprachen, ist für die Einzelknoteninferenz konzipiert, effizient und kostengünstig. In diesem Artikel werden die verschiedenen Leistungsindikatoren, Nutzungsmethoden und die hervorragende Leistung von Mistral Large 2 bei der Verarbeitung mehrerer Sprachen, beim Code-Verstehen und beim Befolgen von Anweisungen eingehend untersucht und sein Potenzial in kommerziellen Anwendungen und Forschungsbereichen analysiert.

Nach der gestrigen Ankündigung von Meta über die Veröffentlichung des stärksten Open-Source-Modells Llama3.1 hat Mistral AI heute früh sein Flaggschiffmodell Mistral Large2 auf den Markt gebracht. Dieses neue Produkt verfügt über 123 Milliarden Parameter und ein großes 128.000-Kontextfenster vergleichbar mit Llama3.1.

Details zum Modell Mistral Large2

Mistral Large2 verfügt über ein 128k-Kontextfenster und unterstützt Dutzende Sprachen, darunter Französisch, Deutsch, Spanisch, Italienisch, Portugiesisch, Arabisch, Hindi, Russisch, Chinesisch, Japanisch und Koreanisch sowie Python, Java, C, C++ und mehr 80 Programmiersprachen, darunter JavaScript und Bash.

Mistral Large2 ist für die Einzelknoteninferenz konzipiert und zielt auf Anwendungen mit langem Kontext ab – seine Parametergröße von 123 Milliarden ermöglicht die Ausführung mit hohem Durchsatz auf einem einzelnen Knoten. Mistral Large2 wird unter der Mistral Research-Lizenz veröffentlicht und ist für Forschungs- und nichtkommerzielle Zwecke bestimmt. Bei kommerziellem Bedarf müssen Benutzer Kontakt aufnehmen, um eine kommerzielle Lizenz zu erhalten.

Gesamtleistung:

In Bezug auf die Leistung hat Mistral Large2 einen neuen Maßstab für Bewertungsindikatoren gesetzt und insbesondere eine Genauigkeit von 84,0 % im MMLU-Benchmark-Test erreicht, was ein starkes Gleichgewicht zwischen Leistung und Servicekosten demonstriert.

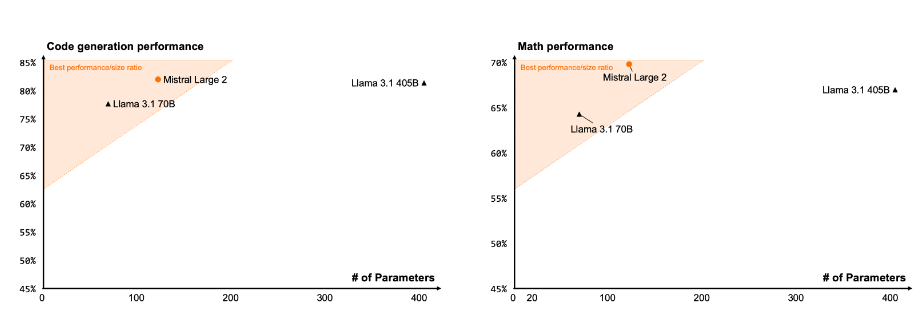

Code und Argumentation

Durch die Trainingserfahrung von Codestral22B und Codestral Mamba schneidet Mistral Large2 bei der Codeverarbeitung gut ab und ist sogar mit Spitzenmodellen wie GPT-4o, Claude3Opus und Llama3405B vergleichbar.

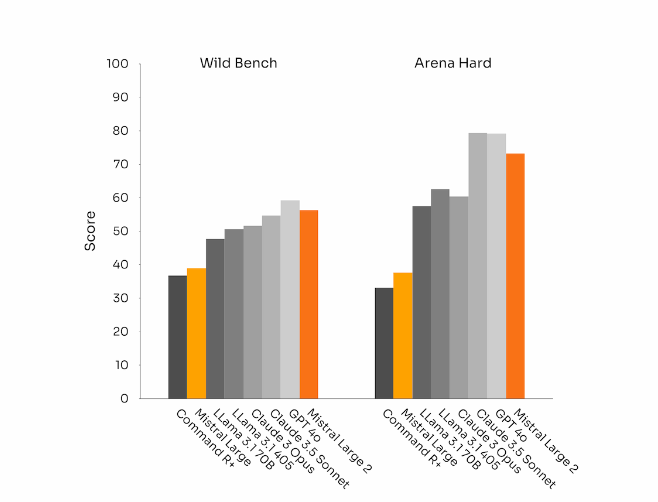

Einhaltung und Ausrichtung von Anweisungen

Mistral Large 2 hat auch erhebliche Fortschritte bei der Befehlsverfolgung und den Dialogfähigkeiten gemacht, insbesondere bei der flexibleren Handhabung komplexer Dialoge mit mehreren Runden. In einigen Benchmarks führt die Generierung längerer Antworten tendenziell zu besseren Ergebnissen. In vielen kommerziellen Anwendungen ist jedoch Einfachheit von entscheidender Bedeutung – eine kürzere Modellgenerierung ermöglicht schnellere Interaktionen und macht Inferenzen kostengünstiger.

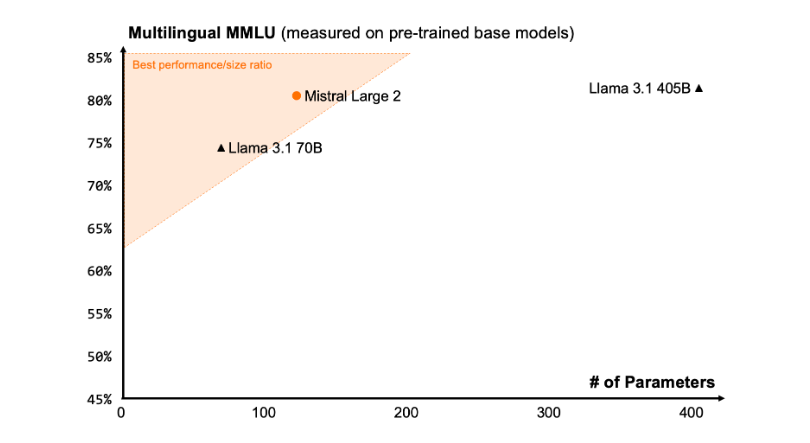

sprachliche Vielfalt

Der neue Mistral Large2 ist auf große Mengen mehrsprachiger Daten trainiert, insbesondere in Englisch, Französisch, Deutsch, Spanisch, Italienisch, Portugiesisch, Niederländisch, Russisch, Chinesisch, Japanisch, Koreanisch, Arabisch und Hindi. Hervorragende Leistung. Nachfolgend finden Sie die Leistungsergebnisse von Mistral Large2 im mehrsprachigen MMLU-Benchmark im Vergleich zu früheren Mistral Large-, Llama3.1-Modellen und Coheres Command R+.

Werkzeugnutzung und Funktionsaufrufe

Mistral Large2 verfügt über erweiterte Fähigkeiten zum Aufrufen und Abrufen von Funktionen und ist für die fachmännische Ausführung paralleler und sequenzieller Funktionsaufrufe geschult, sodass es als Kraftpaket für komplexe Geschäftsanwendungen dienen kann.

Anwendung:

Derzeit können Benutzer Mistral Large2 unter dem Namen mistral-large-2407 a la Plateforme (https://console.mistral.ai/) verwenden und im Chat testen. Es ist in Version 24.07 (dem JJ.MM-Versionskontrollsystem, das wir auf alle Modelle anwenden) und unter dem API-Namen mistral-large-2407 verfügbar. Die Gewichte für das Instruct-Modell sind verfügbar und werden auch auf HuggingFace (https://huggingface.co/mistralai/Mistral-Large-Instruct-2407) gehostet.

Zu den Produkten auf La Plateforme gehören zwei Universalmodelle, Mistral Nemo und Mistral Large, sowie zwei Profimodelle, Codestral und Embed. Da wir ältere Modelle auf La Plateforme auslaufen lassen, können alle Apache-Modelle (Mistral7B, Mixtral8x7B und 8x22B, Codestral Mamba, Mathstral) weiterhin bereitgestellt und mit den SDKs mistral-inference und mistral-finetune optimiert werden.

Ab heute wird das Produkt die Feinabstimmungsfunktionen a la Plateforme erweitern: Diese Funktionen sind jetzt für Mistral Large, Mistral Nemo und Codestral verfügbar.

Mistral AI hat außerdem mit mehreren führenden Cloud-Dienstanbietern zusammengearbeitet, um Mistral Large2 weltweit verfügbar zu machen, insbesondere in Vertex AI auf der Google Cloud Platform.

** Highlights: **

Mistral Large2 verfügt über 128.000 Kontextfenster und unterstützt bis zu zehn Sprachen und mehr als 80 Programmiersprachen.

Erreichen einer Genauigkeit von 84,0 % im MMLU-Benchmark-Test bei hervorragender Leistung und Kosten.

„Benutzer können über La Plateforme auf neue Modelle zugreifen, die auf Cloud-Service-Plattformen weit verbreitet sind.“

Alles in allem hat Mistral Large 2 mit seiner leistungsstarken Leistung, umfangreichen Sprachunterstützung und komfortablen Nutzung eine starke Wettbewerbsfähigkeit im Bereich großer Sprachmodelle bewiesen und neue Möglichkeiten für Forschung und kommerzielle Anwendungen eröffnet. Sein Open-Source-Charakter fördert zudem die innovative Entwicklung im Bereich KI zusätzlich.