Das Team von Alibaba Qwen hat einen neuen Benchmark namens „PROCESSBENCH“ veröffentlicht, der darauf abzielt, die Fähigkeit von Sprachmodellen zum mathematischen Denken umfassender zu bewerten, wobei ein besonderer Schwerpunkt auf der Fähigkeit des Modells liegt, Prozessfehler zu identifizieren. Bestehende Benchmarks weisen Einschränkungen auf, z. B. weil sie für High-Level-Modelle zu einfach sind oder nur binäre Korrektheitsbewertungen liefern und es an einer detaillierten Analyse der Fehlerschritte mangelt. Das Aufkommen von „PROCESSBENCH“ füllt diese Lücke und bietet ein neues Werkzeug für ein tieferes Verständnis und eine Verbesserung des Argumentationsmechanismus von Sprachmodellen.

Kürzlich haben Forscher des Qwen-Teams von Alibaba einen neuen Benchmark namens „PROCESSBENCH“ eingeführt, der die Fähigkeit von Sprachmodellen messen soll, Prozessfehler im mathematischen Denken zu identifizieren. Da Sprachmodelle bei komplexen Denkaufgaben erhebliche Fortschritte gemacht haben, haben Forscher auf diesem Gebiet herausgefunden, dass sie trotz ihrer hervorragenden Leistung immer noch vor Herausforderungen bei der Bewältigung bestimmter schwieriger Probleme stehen. Daher ist es besonders wichtig, eine wirksame Supervisionsmethode zu entwickeln.

Aktuelle Bewertungsbenchmarks für Sprachmodelle weisen einige Mängel auf. Einerseits werden einige Problemstellungen für fortgeschrittene Modelle zu einfach, andererseits liefern bestehende Bewertungsmethoden häufig nur binäre Korrektheitsbewertungen ohne detaillierte Fehleranmerkungen. Dieses Phänomen unterstreicht die dringende Notwendigkeit umfassenderer Bewertungsrahmen, um die Inferenzmechanismen komplexer Sprachmodelle eingehender zu untersuchen.

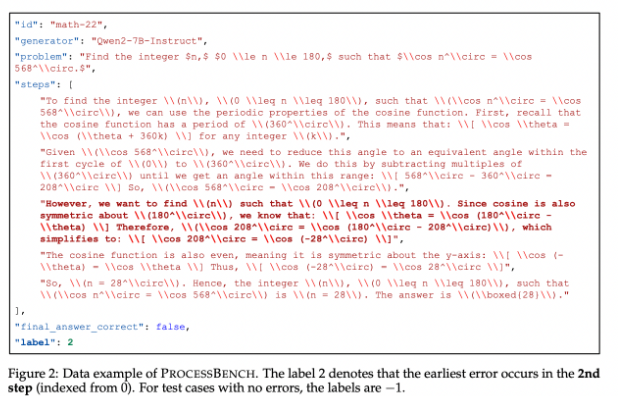

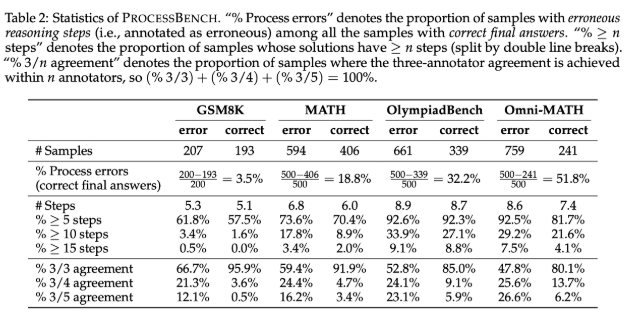

Um diese Lücke zu schließen, entwickelten die Forscher „PROCESSBENCH“, einen Benchmark, der sich auf die Identifizierung fehlerhafter Schritte im mathematischen Denken konzentriert. Zu seinen Gestaltungsprinzipien gehören Problemschwierigkeit, Lösungsvielfalt und umfassende Bewertung. Der Benchmark zielt auf mathematische Probleme auf Wettbewerbs- und Olympia-Niveau ab und nutzt mehrere Open-Source-Sprachmodelle, um Lösungen zu generieren, die unterschiedliche Ansätze zur Lösung der Probleme demonstrieren. PROCESSBENCH enthält insgesamt 3.400 Testfälle, die von mehreren menschlichen Experten sorgfältig kommentiert wurden, um die Datenqualität und Auswertungszuverlässigkeit sicherzustellen.

Während der Entwicklung sammelte das Forschungsteam mathematische Probleme aus vier bekannten Datensätzen (GSM8K, MATH, OlympiadBench und Omni-MATH) und stellte so sicher, dass ein breites Spektrum an Schwierigkeitsgraden von der Grundschule bis zum Wettbewerbsniveau abgedeckt wurde. Sie nutzten Open-Source-Modelle, um bis zu 12 verschiedene Lösungen zu generieren und so die Lösungsvielfalt zu erhöhen. Um das Format der Lösungsschritte zu vereinheitlichen, hat das Team außerdem eine Neuformatierungsmethode eingeführt, um eine logisch vollständige Schritt-für-Schritt-Begründung sicherzustellen.

Forschungsergebnisse zeigen, dass bestehende Prozessbelohnungsmodelle bei der Bearbeitung schwieriger Probleme schlecht abschneiden, insbesondere bei einfacheren Problemstellungen, und dass das prompt-gesteuerte Beurteilungsmodell eine bessere Leistung erbringt. Die Forschung zeigt die Grenzen bestehender Modelle bei der Bewertung mathematischer Argumente auf, insbesondere wenn das Modell durch falsche Zwischenschritte zur richtigen Antwort gelangt, was eine genaue Beurteilung erschwert.

Als bahnbrechender Maßstab für die Bewertung der Fähigkeit von Sprachmodellen, mathematische Denkfehler zu identifizieren, bietet PROCESSBENCH einen wichtigen Rahmen für zukünftige Forschung und fördert das Verständnis und die Verbesserung von KI im Denkprozess.

Papiereingang: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Code: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Alles in allem stellt die Einführung des PROCESSBENCH-Benchmarks ein umfassenderes und tiefergehendes Tool zur Bewertung der mathematischen Denkfähigkeit von Sprachmodellen dar, was dazu beiträgt, die Forschungsentwicklung in diesem Bereich voranzutreiben und letztendlich die Leistung von Sprachmodellen bei komplexen Denkaufgaben zu verbessern.