Angesichts der explosionsartigen Zunahme von durch künstliche Intelligenz generierten Inhalten stehen Social-Media-Plattformen vor einer beispiellosen Herausforderung: Wie kann sichergestellt werden, dass Benutzer zwischen wahren und falschen Informationen unterscheiden können? Instagram-Chef Adam Mosseri veröffentlichte kürzlich eine Reihe von Beiträgen auf Threads, in denen er seine Besorgnis über KI-generierte Inhalte zum Ausdruck brachte und die Strategien von Instagram und Meta für den Umgang mit dieser Herausforderung darlegte. Er betonte, dass Nutzer wachsamer sein und lernen müssten, KI-generierte Inhalte zu erkennen, und forderte die Plattformen auf, die Inhaltsüberwachung zu stärken und die Transparenz und Glaubwürdigkeit von Informationen zu verbessern.

In einer aktuellen Reihe von Threads-Beiträgen betonte Instagram-Chef Adam Mosseri, dass Social-Media-Nutzer angesichts der wachsenden Mengen an KI-generierten Inhalten wachsamer sein müssen.

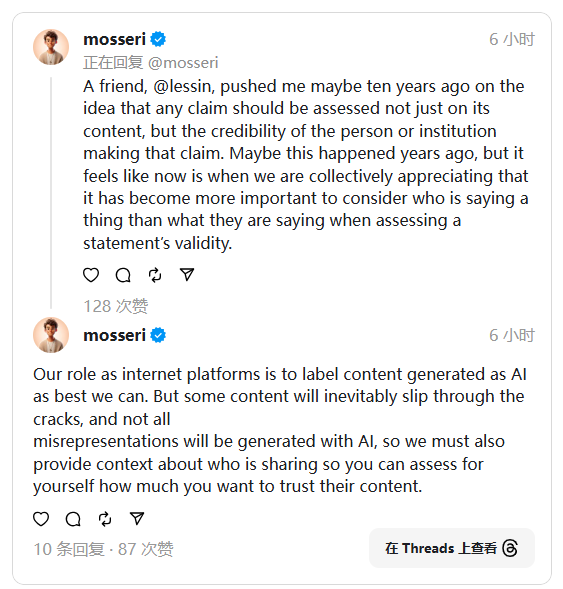

Er wies darauf hin, dass die Bilder und Informationen, die Benutzer online sehen, möglicherweise nicht real sind, da KI-Technologie bereits Inhalte generieren kann, die der Realität sehr ähnlich sind. Um Benutzern zu helfen, die Authentizität von Informationen besser beurteilen zu können, erwähnte Mosseri, dass Benutzer die Quelle des Inhalts berücksichtigen sollten und dass auch soziale Plattformen dafür verantwortlich seien, dies zu unterstützen.

Mosseri sagte, dass die Rolle von Social-Media-Plattformen darin bestehe, die generierten KI-Inhalte so weit wie möglich zu kennzeichnen, um Benutzern die Identifizierung zu erleichtern. Er räumte jedoch auch ein, dass einige Inhalte möglicherweise übersehen werden und nicht rechtzeitig markiert werden können. Zu diesem Zweck betonte er, dass Plattformen den Nutzern auch Hintergrundinformationen zu geteilten Inhalten bereitstellen müssen, damit Nutzer besser entscheiden können, wie sehr sie den Inhalten vertrauen. Seine Ansichten spiegeln tiefe Bedenken hinsichtlich der Glaubwürdigkeit von Social-Media-Nachrichten wider.

Zum jetzigen Zeitpunkt hat Meta (die Muttergesellschaft von Instagram) nicht genügend Kontextinformationen bereitgestellt, um Benutzern bei der Beurteilung der Authentizität des Inhalts zu helfen. Dennoch hat das Unternehmen kürzlich angedeutet, dass es möglicherweise erhebliche Änderungen an seinen Inhaltsregeln vornimmt. Diese Änderung soll das Vertrauen der Nutzer in Informationen stärken und ihnen helfen, die Herausforderungen der KI-Technologie besser zu bewältigen.

Mosseri erwähnte, dass Benutzer überprüfen sollten, ob die vom Chatbot bereitgestellten Informationen zuverlässig sind, bevor sie einer KI-gesteuerten Suchmaschine vertrauen. Dies ähnelt der Überprüfung der Quelle einer Veröffentlichung oder eines Bildes. Nur Informationen, die von seriösen Konten stammen, sind vertrauenswürdiger.

Der von Mosseri beschriebene Ansatz zur Inhaltsmoderation ähnelt eher benutzergesteuerten Moderationssystemen wie Community-Notizen auf Twitter und den Inhaltsfiltern von YouTube. Obwohl unklar ist, ob Meta ähnliche Funktionen einführen wird, lohnt es sich angesichts der bisherigen Erfahrungen des Unternehmens mit Anleihen bei anderen Plattformen, zukünftige Richtlinien zur Inhaltsmoderation im Auge zu behalten.

Alles in allem suchen Instagram und Meta angesichts der Herausforderungen, die KI-generierte Inhalte mit sich bringen, aktiv nach Lösungen, was nicht nur die Anstrengungen der Plattform selbst erfordert, sondern auch von den Nutzern verlangt, ihre eigenen Urteilsfähigkeiten zu verbessern und diese gemeinsam aufrechtzuerhalten Glaubwürdigkeit und Sicherheit von Online-Informationen. Wie sich das zukünftige Content-Supervision-Modell weiterentwickeln wird, verdient unsere anhaltende Aufmerksamkeit.