In den letzten Jahren haben große Sprachmodelle (LLMs) erhebliche Fortschritte im Bereich der Verarbeitung natürlicher Sprache gemacht, ihre Verarbeitungsmethoden auf Token-Ebene weisen jedoch Einschränkungen beim Kontextverständnis sowie bei mehrsprachigen und multimodalen Anwendungen auf. Meta AI schlägt zu diesem Zweck eine völlig neue Methode vor – Large Concept Models (LCMs), die darauf abzielt, die Mängel bestehender LLMs zu beheben. Durch die Modellierung im hochdimensionalen Einbettungsraum SONAR unterstützen LCMs mehrere Sprachen und Modalitäten und übernehmen eine hierarchische Architektur, um die Konsistenz und lokale Bearbeitungsmöglichkeiten von Inhalten in Langform zu verbessern, wodurch die Effizienz und Generalisierungsfähigkeiten des Modells erheblich verbessert werden.

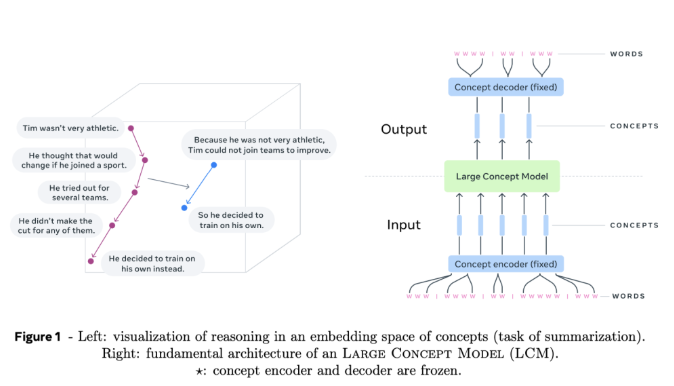

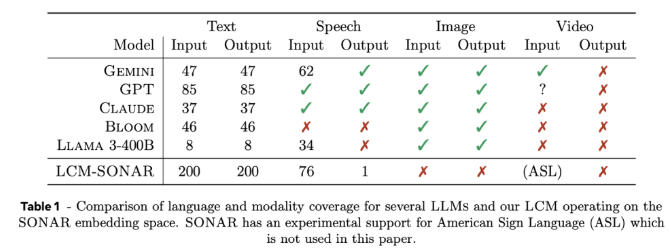

Große Konzeptmodelle (LCMs) stellen eine wichtige Abkehr von der traditionellen LLM-Architektur dar. Sie führen zwei wichtige Neuerungen ein: Erstens modellieren LCMs in einem hochdimensionalen Einbettungsraum, anstatt sich auf diskrete Token zu verlassen. Dieser Einbettungsraum namens SONAR ist für die Unterstützung von mehr als 200 Sprachen und mehreren Modalitäten, einschließlich Text und Sprache, konzipiert und bietet sprach- und modalitätsunabhängige Verarbeitungsmöglichkeiten. Zweitens ermöglicht das Design von LCMs einen nahtlosen Übergang auf semantischer Ebene und ermöglicht so starke Zero-Shot-Generalisierungsfähigkeiten über verschiedene Sprachen und Modalitäten hinweg.

Das Herzstück von LCMs sind Konzept-Encoder und -Decoder. Hierbei handelt es sich um Komponenten, die Eingabesätze dem Einbettungsraum von SONAR zuordnen und die Einbettungen zurück in natürliche Sprache oder andere Modalitäten dekodieren. Das eingefrorene Design dieser Komponenten gewährleistet Modularität und erleichtert die Erweiterung neuer Sprachen oder Modalitäten, ohne das gesamte Modell neu trainieren zu müssen.

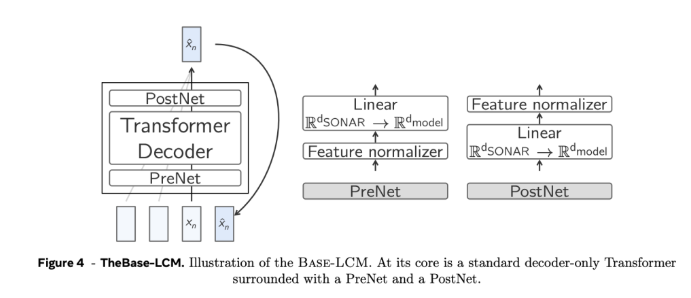

Was die technischen Details anbelangt, verwenden LCMs eine hierarchische Architektur, die den menschlichen Denkprozess nachahmt, wodurch die Konsistenz langer Inhalte verbessert und gleichzeitig eine lokale Bearbeitung ermöglicht wird, ohne den Gesamtkontext zu stören. LCMs zeichnen sich im Generierungsprozess dadurch aus, dass sie Diffusionsmodelle verwenden, die die nächste SONAR-Einbettung basierend auf der vorherigen Einbettung vorhersagen. Im Experiment wurden zwei Architekturen verwendet, eine Single-Tower-Architektur und eine Dual-Tower-Architektur. Die Dual-Tower-Architektur verarbeitete die Kontextkodierung und Rauschunterdrückung getrennt, was die Effizienz verbesserte.

Experimentelle Ergebnisse zeigen, dass diffusionsbasierte LCMs mit zwei Türmen bei mehreren Aufgaben wettbewerbsfähig sind. Beispielsweise übertreffen LCMs bei der Aufgabe der mehrsprachigen Zusammenfassung die Basismodelle im Zero-Shot-Fall und demonstrieren so ihre Anpassungsfähigkeit. Gleichzeitig zeigen LCMs auch bei der Verarbeitung kürzerer Sequenzen eine hohe Effizienz und Genauigkeit, was durch die deutliche Verbesserung der zugehörigen Metriken bestätigt wird.

Das große Konzeptmodell von Meta AI bietet eine vielversprechende Alternative zu herkömmlichen Sprachmodellen auf Token-Ebene und löst einige der wichtigsten Einschränkungen bestehender Methoden durch hochdimensionale Konzepteinbettung und modalitätsunabhängige Verarbeitung. Mit der Vertiefung der Forschung zu dieser Architektur wird erwartet, dass LCMs die Fähigkeiten von Sprachmodellen neu definieren und einen skalierbareren und anpassungsfähigeren Ansatz für die KI-gesteuerte Kommunikation bieten.

Projekteingang: https://github.com/facebookresearch/large_concept_model

Alles in allem bietet das von Meta AI vorgeschlagene LCM-Modell eine innovative Lösung zur Lösung der Einschränkungen des traditionellen LLM. Seine Vorteile in der mehrsprachigen, multimodalen Verarbeitung und dem effizienten Architekturdesign machen es zu einer großen Zukunft im Bereich der natürlichen Sprache Die Verarbeitung birgt ein enormes Potenzial und verdient kontinuierliche Aufmerksamkeit und eingehende Forschung.