Google hat die TPU der sechsten Generation, Trillium, offiziell veröffentlicht und für Google Cloud-Kunden geöffnet. Trillium ist Googles bislang leistungsstärkstes TPU und wird zum Trainieren von Gemini 2.0, seinem leistungsstärksten KI-Modell, verwendet. Es verbessert die Trainingsleistung, den Inferenzdurchsatz und die Energieeffizienz erheblich und sorgt gleichzeitig für geringere Kosten. Dieser Artikel wirft einen detaillierten Blick auf die Leistungsverbesserungen, Hauptfunktionen und herausragende Leistung von Trillium TPU bei verschiedenen KI-Workloads und demonstriert seine praktischen Anwendungsfälle bei Kunden wie AI21Labs.

Anfang des Jahres veröffentlichte Google Trillium, seine sechste Generation und bislang leistungsstärkste TPU. Heute ist Trillium offiziell für Google Cloud-Kunden verfügbar.

Google nutzte Trillium TPU, um das neueste Gemini2.0 zu trainieren, das bislang leistungsstärkste KI-Modell von Google. Jetzt können Unternehmen und Start-ups gleichermaßen auf die gleiche robuste, effiziente und nachhaltige Infrastruktur zurückgreifen.

Der Kern des KI-Supercomputers: Trillium TPU

Trillium TPU ist eine Schlüsselkomponente des Google Cloud AI Hypercomputers. AI Hypercomputer ist eine bahnbrechende Supercomputer-Architektur, die leistungsoptimierte Hardware, offene Software, führende ML-Frameworks und flexible Systeme zur Integration von Verbrauchsmodellen nutzt. Mit der offiziellen Einführung von Trillium TPU hat Google auch wichtige Verbesserungen an der offenen Softwareschicht des KI-Hypercomputers vorgenommen, einschließlich der Optimierung des XLA-Compilers und beliebter Frameworks wie JAX, PyTorch und TensorFlow, um ein führendes Preis-Leistungs-Verhältnis beim KI-Training zu erzielen , Tuning und Dienstleistungen .

Darüber hinaus sorgen Funktionen wie Host-Offload mithilfe von massivem Host-DRAM (Supplemental High-Bandwidth Memory oder HBM) für eine höhere Effizienz. Mit AI Hypercomputer können Sie den maximalen Nutzen aus einer beispiellosen Bereitstellung von mehr als 100.000 Trillium-Chips pro Jupiter-Netzwerkarchitektur mit 13 Petabits/Sekunde bidirektionaler Bandbreite und der Möglichkeit ziehen, einen einzelnen verteilten Trainingsauftrag auf Hunderttausende Beschleuniger zu skalieren.

Kunden wie AI21Labs nutzen Trillium bereits, um ihren Kunden schneller sinnvolle KI-Lösungen bereitzustellen:

Barak Lenz, CTO von AI21Labs, sagte: „Bei AI21 arbeiten wir ständig daran, die Leistung und Effizienz der Mamba- und Jamba-Sprachmodelle zu verbessern. Als langjährige Benutzer von TPU v4 sind wir von den Fähigkeiten von Trillium von Google Cloud beeindruckt. In Bezug auf Umfang, Geschwindigkeit und Kosten sind die Effizienzsteigerungen erheblich. Wir glauben, dass Trillium eine entscheidende Rolle bei der Beschleunigung der Entwicklung unserer nächsten Generation komplexer Sprachmodelle spielen wird, sodass wir unseren Kunden leistungsfähigere und zugänglichere KI-Lösungen liefern können.“

Die Leistung von Trillium wurde erheblich verbessert und viele Indikatoren haben neue Rekorde aufgestellt.

Im Vergleich zur Vorgängergeneration hat Trillium erhebliche Verbesserungen erzielt in:

Die Trainingsleistung verbesserte sich um mehr als das Vierfache

3-fache Verbesserung des Inferenzdurchsatzes

Energieeffizienz um 67 % gesteigert

4,7-fache Verbesserung der Spitzenrechenleistung pro Chip

High-Bandwidth-Speicher (HBM) verdoppelt die Kapazität

Inter-Chip Interconnect (ICI) verdoppelt die Bandbreite

Eine einzelne Jupiter-Netzwerkarchitektur enthält 100.000 Trillium-Chips

2,5-fache Verbesserung der Trainingsleistung pro Dollar und 1,4-fache Verbesserung der Inferenzleistung pro Dollar

Diese Verbesserungen ermöglichen Trillium eine gute Leistung bei einer Vielzahl von KI-Workloads, darunter:

Skalierung der KI-Trainingsarbeitslasten

Trainieren Sie LLMs, einschließlich dichter Modelle und Mixed Expert (MoE)-Modelle

Inferenzleistung und kollektive Planung

Einbetten dichter Modelle

Bieten Sie kostengünstige Schulungen und Schlussfolgerungen

Wie funktioniert Trillium bei verschiedenen Arbeitslasten?

Skalierung der KI-Trainingsarbeitslasten

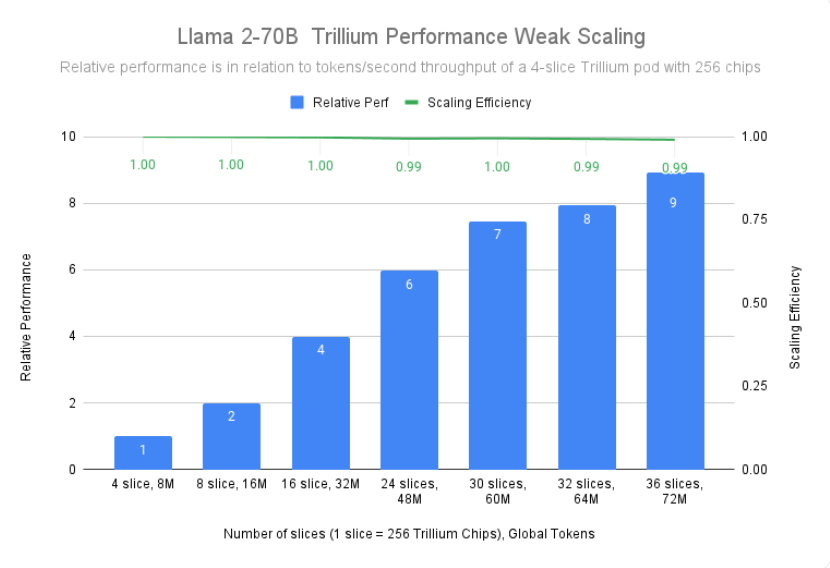

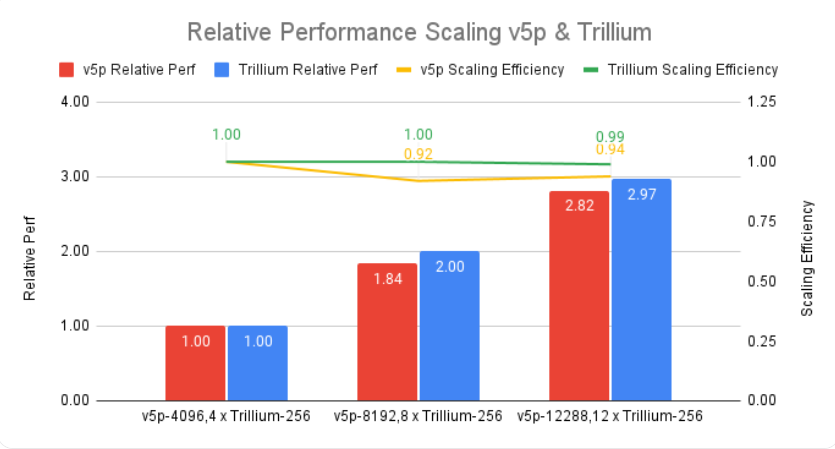

Das Training eines großen Modells wie Gemini2.0 erfordert viele Daten und Berechnungen. Dank der nahezu linearen Skalierbarkeit von Trillium können diese Modelle deutlich schneller trainiert werden, indem Arbeitslasten effektiv und effizient auf mehrere Trillium-Hosts verteilt werden, die über Hochgeschwindigkeits-Chip-zu-Chip-Verbindungen in 256-Chip-Pods und unsere hochmodernen in verbunden sind das Jupiter-Rechenzentrumsnetzwerk. Dies wird durch die TPU-Multi-Chip-Full-Stack-Technologie für groß angelegte Schulungen erreicht und durch Titanium, ein dynamisches Offload-System auf Rechenzentrumsebene, das von Host-Adaptern bis hin zur Netzwerkarchitektur reicht, weiter optimiert.

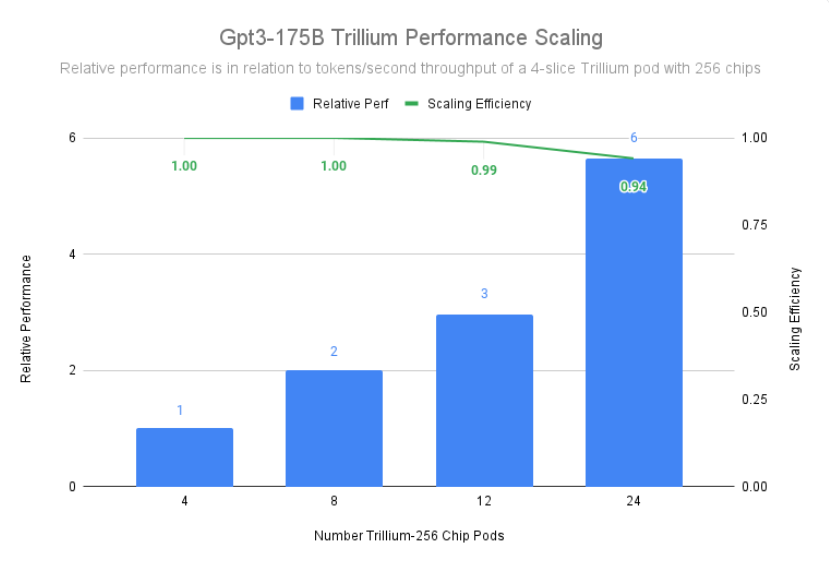

Trillium erreichte eine Skalierungseffizienz von 99 % bei einer Bereitstellung von 12 Pods mit 3072 Chips und zeigte eine Skalierungseffizienz von 94 % bei 24 Pods mit 6144 Chips, um gpt3-175b vorab zu trainieren, selbst in 2016. Das Gleiche gilt, wenn es über Rechenzentrumsnetzwerke läuft.

Trainieren Sie LLMs, einschließlich dichter Modelle und Mixed Expert (MoE)-Modelle

LLMs wie Gemini sind von Natur aus leistungsstark und komplex und verfügen über Milliarden von Parametern. Das Training eines derart intensiven LLM erfordert enorme Rechenleistung sowie eine mitgestaltete Softwareoptimierung. Trillium ist beim Training intensiver LLMs wie Llama-2-70b und gpt3-175b viermal schneller als die Cloud TPU v5e der vorherigen Generation.

Neben intensivem LLM besteht ein immer beliebter werdender Ansatz darin, LLM mithilfe einer Mixed-Expert-Architektur (MoE) zu trainieren, die mehrere neuronale „Experten“-Netzwerke kombiniert, die jeweils auf unterschiedliche Aspekte der KI-Aufgabe spezialisiert sind. Die Verwaltung und Koordination dieser Experten während des Trainings erhöht die Komplexität im Vergleich zum Training eines einzelnen monolithischen Modells. Trillium ist beim Training von MoE-Modellen 3,8-mal schneller als die Cloud TPU v5e der vorherigen Generation.

Darüber hinaus bietet Trillium TPU im Vergleich zu Cloud TPU v5e den dreifachen dynamischen Direktzugriffsspeicher (DRAM) des Hosts. Dadurch wird ein Teil der Rechenleistung auf den Host verlagert, was dazu beiträgt, die Leistung im großen Maßstab und einen guten Durchsatz zu maximieren. Die Host-Offloading-Funktion von Trillium bietet eine Leistungsverbesserung von über 50 % bei der Modell-FLOP-Auslastung (MFU) beim Training des Llama-3.1-405B-Modells.

Inferenzleistung und kollektive Planung

Die zunehmende Bedeutung mehrstufiger Inferenz erfordert Beschleuniger, die den erhöhten Rechenaufwand effizient bewältigen können. Trillium bietet erhebliche Fortschritte bei Inferenz-Workloads und ermöglicht eine schnellere und effizientere Bereitstellung von KI-Modellen. Tatsächlich liefert Trillium unsere beste TPU-Inferenzleistung für Bilddiffusion und dichtes LLM. Unsere Tests zeigen, dass Stable Diffusion XL im Vergleich zu Cloud TPU v5e einen mehr als dreimal höheren relativen Inferenzdurchsatz (Bilder pro Sekunde) aufweist, während Llama2-70B fast doppelt so hoch ist.

Trillium ist unsere leistungsstärkste TPU für Offline- und Server-Inferenz-Anwendungsfälle. Die folgende Abbildung zeigt, dass der relative Durchsatz (Bilder pro Sekunde) von Stable Diffusion XL für Offline-Inferenz im Vergleich zu Cloud TPU v5e 3,1-mal höher ist und der relative Durchsatz für Server-Inferenz 2,9-mal höher ist.

Neben einer besseren Leistung führt Trillium auch neue kollektive Planungsfunktionen ein. Mit dieser Funktion kann das Planungssystem von Google intelligente Jobplanungsentscheidungen treffen, um die Gesamtverfügbarkeit und Effizienz von Inferenzarbeitslasten zu verbessern, wenn mehrere Replikate in der Sammlung vorhanden sind. Es bietet eine Möglichkeit, mehrere TPU-Slices zu verwalten, auf denen Inferenz-Workloads mit einem oder mehreren Hosts ausgeführt werden, auch über Google Kubernetes Engine (GKE). Durch die Gruppierung dieser Stücke in einer Sammlung lässt sich die Anzahl der Replikate leicht an die Nachfrage anpassen.

Einbetten dichter Modelle

Durch das Hinzufügen von SparseCore der dritten Generation verbessert Trillium die Leistung einbettungsintensiver Modelle um das Zweifache und DLRM DCNv2 um das Fünffache.

SparseCore ist ein Datenflussprozessor, der eine anpassungsfähigere Architekturgrundlage für eingebettete intensive Workloads bietet. Trilliums SparseCore der dritten Generation zeichnet sich durch die Beschleunigung dynamischer und datenbezogener Vorgänge wie Streuungssammlung, Sparse-Segmentsummen und Partitionierung aus.

Bieten Sie kostengünstige Schulungen und Schlussfolgerungen

Neben der reinen Leistung und Skalierbarkeit, die zum Trainieren einiger der größten KI-Workloads der Welt erforderlich sind, ist Trillium darauf ausgelegt, die Leistung pro Dollar zu optimieren. Bisher hat Trillium beim Training intensiver LLMs wie Llama2-70b und Llama3.1-405b eine 2,1-mal bessere Leistung pro Dollar als Cloud TPU v5e und eine 2,5-mal bessere Leistung als Cloud TPU v5p erzielt.

Trillium zeichnet sich durch die kostengünstige parallele Verarbeitung großer Modelle aus. Es soll Forschern und Entwicklern die Bereitstellung leistungsstarker und effizienter Bildmodelle zu deutlich geringeren Kosten als bisher ermöglichen. Die Kosten für die Generierung von tausend Bildern auf Trillium sind 27 % niedriger als bei Cloud TPU v5e für Offline-Inferenz und 22 % niedriger als bei Cloud TPU v5e für Server-Inferenz auf SDXL.

KI-Innovation auf die nächste Stufe heben

Trillium stellt einen großen Fortschritt in der KI-Infrastruktur von Google Cloud dar und bietet unglaubliche Leistung, Skalierbarkeit und Effizienz für eine Vielzahl von KI-Arbeitslasten. Mit seiner Fähigkeit, mithilfe erstklassiger Co-Design-Software auf Hunderttausende Chips zu skalieren, ermöglicht Trillium Ihnen, schnellere Durchbrüche zu erzielen und überlegene KI-Lösungen bereitzustellen. Darüber hinaus ist Trillium aufgrund seines außergewöhnlichen Preis-Leistungs-Verhältnisses eine kostengünstige Wahl für Unternehmen, die den Wert ihrer KI-Investitionen maximieren möchten. Während sich die KI-Landschaft ständig weiterentwickelt, demonstriert Trillium das Engagement von Google Cloud für die Bereitstellung modernster Infrastruktur, um Unternehmen dabei zu helfen, das volle Potenzial der KI auszuschöpfen.

Offizielle Einführung: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

Alles in allem stellt das Aufkommen von Trillium TPU eine deutliche Verbesserung der Cloud-KI-Computing-Fähigkeiten dar. Seine leistungsstarke Leistung, Skalierbarkeit und wirtschaftlichen Vorteile werden eine schnellere Entwicklung im KI-Bereich fördern und leistungsfähigere KI-Lösungen für Unternehmen und Forschungseinrichtungen bereitstellen.