Die Open Source großer Sprachmodelle (LLM) fördert die Entwicklung der KI-Technologie, bringt aber auch Herausforderungen beim Schutz des geistigen Eigentums mit sich. Das Aufkommen von „Shell“-Modellen macht die Identifizierung der Modellquelle zu einem dringenden Problem, das gelöst werden muss. In diesem Artikel werden die Mängel bestehender Modell-Fingerabdruck-Identifizierungsmethoden erörtert und eine neue, robustere Modell-Fingerabdruck-Identifizierungsmethode – REEF – vorgestellt, wie sie das „Beschuss“-Problem effektiv lösen und das geistige Eigentum von LLM schützen kann.

Im KI-Zeitalter sind große Sprachmodelle (LLM) wie Kampfkunstgeheimnisse. Der Trainingsprozess verbraucht enorme Rechenleistung und Daten, genau wie ein Kampfkunstmeister, der viele Jahre lang in Abgeschiedenheit praktiziert. Die Veröffentlichung des Open-Source-Modells ist wie ein Meister, der seine Geheimnisse öffentlich macht, wird jedoch mit einigen Lizenzen (wie der Apache2.0- und LLaMA2-Community-Lizenz) zum Schutz seines geistigen Eigentums (IP) verbunden sein.

Allerdings ist die Welt tückisch und es kommt immer wieder zu „Beschuss“-Vorfällen. Einige Entwickler behaupten, neue LLMs trainiert zu haben, aber in Wirklichkeit handelt es sich dabei um Wrapper oder Feinabstimmungen für andere Basismodelle (wie Llama-2 und MiniCPM-V). Das ist so, als würde man heimlich die Kampfkünste anderer Leute erlernen, aber behaupten, man sei die eigene Schöpfung. Um dies zu verhindern, benötigen Modellbesitzer und Dritte eine Möglichkeit, „geschälte“ Modelle zu identifizieren.

Es gibt zwei Haupttypen bestehender Methoden zur Identifizierung von Fingerabdrücken von Modellen:

Injektionsfingerabdruck: Dies ist wie das heimliche Markieren des Geheimbuchs, beispielsweise mit der Wasserzeichenmethode. Diese Methode fügt während des Modelltrainings oder des Feinabstimmungsprozesses künstlich einige „Trigger“ hinzu, sodass das Modell unter bestimmten Bedingungen bestimmte Inhalte generieren und so die Quelle des Modells identifizieren kann. Dieser Ansatz erhöht jedoch die Schulungskosten, beeinträchtigt die Modellleistung und wird möglicherweise sogar entfernt. Darüber hinaus kann diese Methode nicht auf bereits veröffentlichte Modelle angewendet werden.

Intrinsic Fingerprinting: Das ist so, als würde man die Quelle eines Cheats anhand seines Inhalts und Stils beurteilen. Diese Methode nutzt die Eigenschaften des Modells selbst zur Identifizierung, einschließlich Modellgewichten und Merkmalsdarstellungen. Unter diesen führt die gewichtsbasierte Fingerabdruckmethode eine Identifizierung durch, indem sie die Ähnlichkeit der Modellgewichte berechnet. Diese Methode ist jedoch anfällig für Gewichtsänderungen, wie z. B. Gewichtspermutationen, Beschneidung und Feinabstimmung. Die auf semantischer Analyse basierende Methode führt die Erkennung anhand des vom statistischen Analysemodell generierten Textes durch. Allerdings weisen beide Methoden eine unzureichende Robustheit auf.

Gibt es also eine Methode, die „Shell“-Modelle effektiv identifizieren kann, ohne die Modellleistung zu beeinträchtigen und verschiedenen „ausgefallenen“ Modifikationen zu widerstehen?

Forscher des Shanghai Artificial Intelligence Laboratory und anderer Institutionen haben eine neue Modellmethode zur Identifizierung von Fingerabdrücken vorgeschlagen – REEF.

Das Funktionsprinzip von REEF ist:

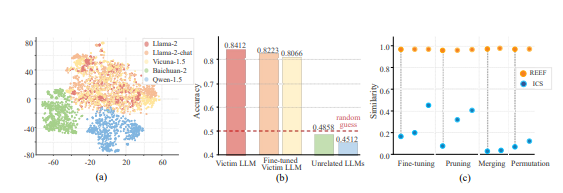

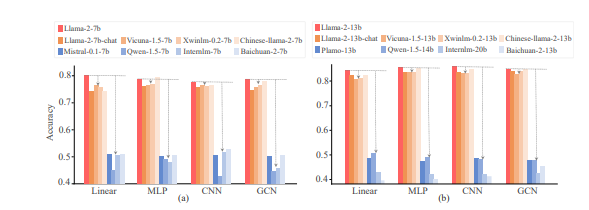

REEF ist eine Methode zur Identifizierung von Fingerabdrücken, die auf der Darstellung von Merkmalen basiert. Es basiert nicht auf der Darstellung einer bestimmten Schicht, sondern nutzt die leistungsstarken Darstellungsmodellierungsfunktionen von LLM, um Merkmale aus verschiedenen Schichten zur Erkennung zu extrahieren.

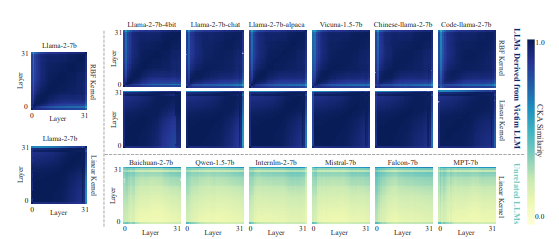

Es vergleicht die Ähnlichkeit der Center-Kernel-Alignment (CKA) von Merkmalsdarstellungen zweier Modelle in derselben Stichprobe. CKA ist ein Ähnlichkeitsindex, der auf dem Hilbert-Schmidt-Unabhängigkeitskriterium (HSIC) basiert und die Unabhängigkeit zwischen zwei Sätzen von Zufallsvariablen messen kann.

Wenn die Ähnlichkeit hoch ist, bedeutet dies, dass das verdächtige Modell wahrscheinlich vom Opfermodell abgeleitet ist, andernfalls ist dies unwahrscheinlich.

Was sind die Vorteile von REEF?

Keine Schulung erforderlich: Dies bedeutet, dass die Leistung des Modells nicht beeinträchtigt wird und keine zusätzlichen Schulungskosten anfallen.

Starke Robustheit: Es ist robust gegenüber verschiedenen Folgeentwicklungen wie Modellbereinigung, Feinabstimmung, Zusammenführung, Anordnung und Skalierungstransformationen. Selbst wenn das verdächtige Modell einer umfangreichen Feinabstimmung unterzogen wird (bis zu 700 Milliarden Datentokens), kann REEF immer noch effektiv erkennen, ob es vom Opfermodell stammt.

Theoretische Garantie: Forscher haben theoretisch bewiesen, dass CKA gegenüber Spaltenanordnung und Skalierungstransformationen invariant ist.

Experimentelle Ergebnisse zeigen, dass REEF bei der Identifizierung von „Shell“-Modellen gut abschneidet und bestehende Methoden, die auf Gewichtungen und semantischer Analyse basieren, übertrifft.

Das Aufkommen von REEF bietet ein neues Instrument zum Schutz des geistigen Eigentums von LLM und hilft bei der Bekämpfung unethischer oder illegaler Verhaltensweisen wie der unbefugten Nutzung oder des Kopierens von Modellen.

Papieradresse: https://arxiv.org/pdf/2410.14273

Alles in allem bietet die REEF-Methode eine effektive, robuste und effiziente Lösung für das Problem des Schutzes geistigen Eigentums des LLM-Open-Source-Modells und trägt zum Aufbau einer gesünderen ökologischen KI-Umgebung bei.