OpenAI gab bekannt, dass der erweiterte Sprachmodus von ChatGPT visualisiert wurde. Benutzer, die Plus, Team oder Pro abonniert haben, können über die Kameras ihres Mobiltelefons in Echtzeit mit ChatGPT interagieren und verfügen über Funktionen zur Bildschirmfreigabe. Diese Funktion wurde bereits mehrfach verzögert und nach einer langen Testphase endlich offiziell eingeführt. Allerdings können nicht alle Benutzer sie sofort nutzen. Einige Regionen und Benutzertypen müssen bis Januar nächsten Jahres oder sogar länger warten.

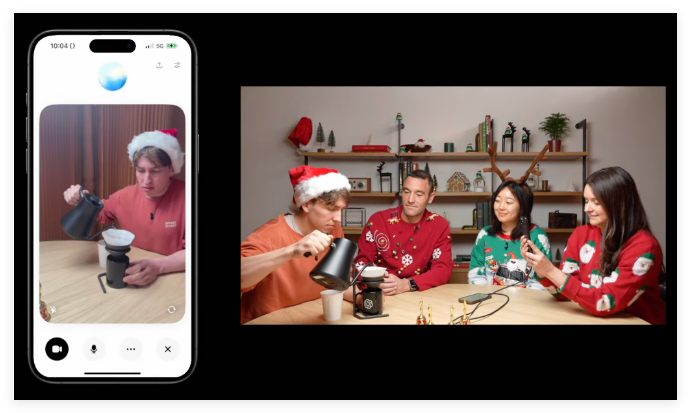

OpenAI gab am Donnerstag bekannt, dass seine für ChatGPT entwickelte menschenähnliche Konversationsfunktion „Advanced Speech Mode“ visualisiert wurde. Benutzer, die ChatGPT Plus, Team oder Pro abonniert haben, können jetzt ihre Telefonkamera auf ein Objekt richten und ChatGPT reagiert nahezu in Echtzeit.

Dieser erweiterte Sprachmodus mit Vision verfügt auch über Bildschirmfreigabefunktionen, die Inhalte auf dem Gerätebildschirm analysieren. Es kann beispielsweise verschiedene Einstellungsmenüs erklären und Ratschläge zu mathematischen Problemen geben.

Die Verwendung ist sehr einfach: Klicken Sie auf das Sprachsymbol neben der ChatGPT-Chatleiste und dann auf das Videosymbol in der unteren linken Ecke, um das Video zu starten. Wenn Sie Ihren Bildschirm teilen möchten, können Sie auf das Dreipunktmenü klicken und „Bildschirm teilen“ auswählen.

In Bezug auf die Einführung der Funktion sagte OpenAI, dass der erweiterte Sprachmodus mit Vision ab diesem Donnerstag und bis nächste Woche eingeführt wird. Es ist wichtig zu beachten, dass dies nicht sofort für alle Benutzer verfügbar ist. Benutzer von ChatGPT Enterprise und Edu müssen bis Januar nächsten Jahres warten, während Benutzer in der EU, der Schweiz, Island, Norwegen und Liechtenstein noch keinen konkreten Zeitplan bekannt gegeben haben.

Bei einem kürzlichen Auftritt in der CNN-Sendung „60 Minutes“ demonstrierte OpenAI-Präsident Greg Brockman Anderson Cooper fortschrittliche visuelle Analysefunktionen für Sprachmuster. Als Cooper menschliche Körperteile an die Tafel zeichnete, konnte ChatGPT seine Zeichnungen verstehen und kommentieren. Darin heißt es zum Beispiel, dass das Gehirn genau positioniert ist, und legt nahe, dass die Gehirnform eher einer Ellipse ähnelt.

Während der Demonstration zeigte dieser erweiterte Sprachmodus jedoch auch einige Ungenauigkeiten in Bezug auf geometrische Probleme, was das potenzielle Risiko von „Halluzinationen“ verdeutlichte.

Es ist erwähnenswert, dass dieser erweiterte Sprachmodus mit visuellen Funktionen mehrfach verzögert wurde. Im April versprach OpenAI, dass es „innerhalb von Wochen“ starten würde, sagte aber später, dass es mehr Zeit brauchen würde. Diese Funktion stand einigen ChatGPT-Benutzern erst Anfang Herbst zur Verfügung, und die visuelle Analysefunktion war zu diesem Zeitpunkt noch nicht verfügbar.

Angesichts des wachsenden Wettbewerbs im Bereich der künstlichen Intelligenz entwickeln auch Konkurrenten wie Google und Meta ähnliche Fähigkeiten. Diese Woche hat Google sein Echtzeit-Videoanalyse-Konversationsprojekt für künstliche Intelligenz Project Astra für einige Android-Tester geöffnet.

Zusätzlich zu den visuellen Funktionen hat OpenAI am Donnerstag auch einen festlichen „Santa Mode“ eingeführt, der es Benutzern ermöglicht, die Stimme des Weihnachtsmanns über das Schneeflockensymbol neben der Benachrichtigungsleiste in der ChatGPT-App zu aktivieren.

Dieses visuelle Update des erweiterten Sprachmodus von ChatGPT stellt eine Verbesserung der Fähigkeit der KI zur Interaktion mit der realen Welt dar, zeigt aber auch Herausforderungen und Einschränkungen bei der Technologieentwicklung auf. In Zukunft lohnt es sich, auf die Verbesserung und Popularisierung ähnlicher Funktionen zu blicken. Die Weiterentwicklung der KI-Technologie wird sich weiterhin auf unseren Lebensstil auswirken.