Die neueste Modellreihe Tülu3, die vom Allen Institute for Artificial Intelligence (AI2) veröffentlicht wurde, hat beeindruckende Durchbrüche auf dem Gebiet der Open-Source-Sprachmodelle gebracht. Tülu3 ist nicht nur in der Leistung mit Closed-Source-Modellen wie GPT-4o-mini vergleichbar, sondern, was noch wichtiger ist, es ist vollständig Open Source und bietet umfassende Trainingsdaten, Code, Trainingsrezepte und Bewertungsrahmen, was für die Förderung von Open Source von entscheidender Bedeutung ist Die Entwicklung von Trainingstechnologien ist von entscheidender Bedeutung. Es löst viele Probleme, die bei der praktischen Anwendung traditioneller Pre-Training-Modelle bestehen, wie z. B. die Generierung schädlicher Informationen und Schwierigkeiten bei der Befolgung von Anweisungen usw., und eröffnet neue Möglichkeiten für die Forschung und Anwendung im Bereich der künstlichen Intelligenz.

Im Bereich der künstlichen Intelligenz wird die Post-Training-Technologie allmählich zu einem wichtigen Mittel zur Verbesserung der Modellleistung. Kürzlich hat das Allen Institute for Artificial Intelligence (AI2) die Modellreihe Tülu3 veröffentlicht, bei der es sich um ein vollständig Open-Source-Sprachmodell für fortgeschrittene Sprachen handelt, dessen Leistung mit Closed-Source-Modellen wie GPT-4o-mini vergleichbar ist. Tülu3 enthält nicht nur Modelldaten, Code und Trainingsrezepte, sondern bietet auch einen Bewertungsrahmen, der darauf abzielt, die Entwicklung von Open-Source-Modell-Post-Training-Technologie zu fördern.

Herkömmlicherweise erfüllen vorab trainierte Modelle allein oft nicht die Anforderungen der praktischen Anwendung, können giftige oder gefährliche Informationen erzeugen und es ist schwierig, menschlichen Anweisungen zu folgen. Daher sind Phasen nach dem Training wie die Feinabstimmung der Anweisungen und das Lernen durch menschliches Feedback besonders wichtig. Die Optimierung des Post-Training-Prozesses stellt jedoch immer noch ein technisches Problem dar, insbesondere wenn eine Fähigkeit des Modells verbessert wird, kann dies Auswirkungen auf andere Fähigkeiten haben.

Um dieses Problem zu lösen, haben große Unternehmen die Komplexität der Post-Training-Methoden erhöht, indem sie mehrere Trainingsrunden ausprobiert und künstliche und synthetische Daten kombiniert haben, aber die meisten Methoden sind immer noch Closed-Source-Methoden. Im Gegensatz dazu hat die Veröffentlichung der Tülu3-Serie die Leistungslücke zwischen Open-Source-Modellen und Closed-Source-Modellen durchbrochen und neue Trainingsideen gebracht.

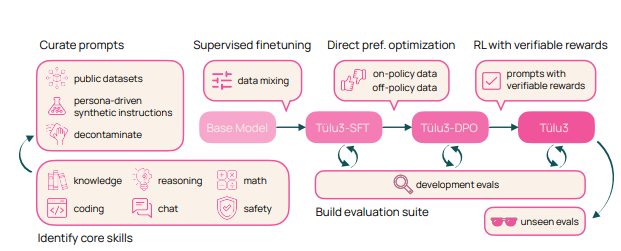

Der Trainingsprozess von Tülu3 ist in vier Phasen unterteilt: Datenkonstruktion, überwachte Feinabstimmung, Präferenzanpassung und verstärkendes Lernen mit überprüfbaren Belohnungen.

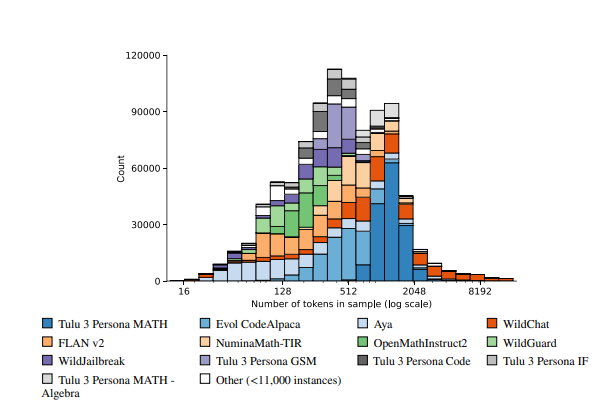

Zunächst konzentrieren sich die Forscher auf die Kernkompetenzen des Modells und erstellen Trainingsdaten, indem sie künstliche Daten mit synthetischen Daten kombinieren.

Zweitens wird eine überwachte Feinabstimmung durchgeführt, um sicherzustellen, dass das Modell bei bestimmten Fähigkeiten genauso gut funktioniert wie andere hochmoderne Modelle.

Drittens wird die Methode der direkten Präferenzoptimierung verwendet, um die Gesamtleistung des Modells weiter zu verbessern. Abschließend wird die innovative Methode des überprüfbaren Belohnungsverstärkungslernens eingeführt, um dem Modell dabei zu helfen, Aufgaben besser mit überprüfbaren Ergebnissen zu erledigen.

Das Tülu3-Modell basiert auf Llama3.1 und bietet hervorragende Leistungen in Bereichen wie logisches Denken, Mathematik, Programmierung und Befolgen von Anweisungen. Im Vergleich zu anderen Open-Source- und Closed-Source-Modellen schneiden die umfassenden Funktionen von Tülu3 in mehreren Benchmarks gut ab und stellen einen großen Fortschritt in der Post-Open-Source-Trainingstechnologie dar.

Link zum Papier: https://allenai.org/papers/tulu-3-report.pdf

Demo:https://playground.allenai.org/

Höhepunkte:

?Tülu3 ist ein von AI2 eingeführtes Open-Source-Sprachmodell, dessen Leistung mit Closed-Source-Modellen wie GPT-4o-mini vergleichbar ist.

? Post-Training-Technologie ist von entscheidender Bedeutung und kann die Leistung des Modells in praktischen Anwendungen effektiv verbessern.

?Der innovative Trainingsprozess von Tülu3 ist in vier Phasen unterteilt: Datenkonstruktion, überwachte Feinabstimmung, Präferenzanpassung und überprüfbares Belohnungsverstärkungslernen.

Der Open-Source-Charakter von Tülu3 ermöglicht es Forschern, seine Trainingsmethoden eingehend zu untersuchen und auf dieser Grundlage Verbesserungen und Innovationen vorzunehmen, was die Entwicklung von Open-Source-Sprachmodellen erheblich vorantreiben wird. Die hervorragende Leistung in vielen Bereichen deutet auch darauf hin, dass das Open-Source-Modell in Zukunft eine wichtigere Rolle spielen wird. Es wird erwartet, dass Tülu3 die Popularisierung und Anwendung der Technologie der künstlichen Intelligenz weiter vorantreiben kann.