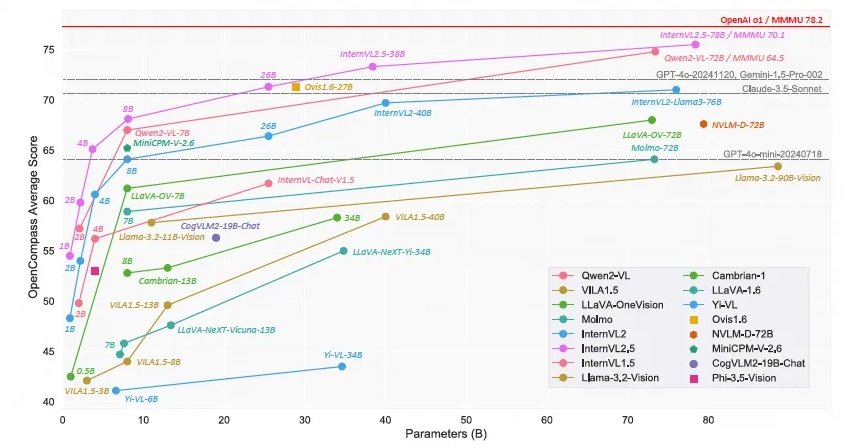

Das Shanghai AI Laboratory hat das multimodale Open-Source-Sprachmodell Scholar·Wanxiang InternVL2.5 auf den Markt gebracht. Seine Leistung hat eine Genauigkeit von mehr als 70 % beim Multimodal Understanding Benchmark (MMMU) erreicht, was vergleichbar ist mit GPT-4o und Claude-Commercial-Modelle wie 3.5-Sonnet haben eine vergleichbare Leistung. Das InternVL2.5-Modell nutzt Chain-Thinking-Argumentation-Technologie, um in mehreren Benchmark-Tests eine starke Leistung zu demonstrieren, insbesondere in den Bereichen multidisziplinäres Denken, Dokumentenverständnis und multimodale Halluzinationserkennung. Der Open-Source-Charakter dieses Modells wird die Entwicklung und Innovation multimodaler KI-Technologie erheblich fördern.

Kürzlich gab das Shanghai AI Laboratory die Einführung des Scholar·Wanxiang InternVL2.5-Modells bekannt. Mit seiner herausragenden Leistung ist dieses multimodale Open-Source-Sprachmodell im großen Maßstab das erste Open-Source-Modell, das beim Multi-modal Understanding Benchmark (MMMU) eine Genauigkeit von über 70 % erreicht und damit mit kommerziellen Modellen wie GPT-4o und Claude konkurriert -3,5-Sonnet Vergleichbare Leistung.

Das InternVL2.5-Modell erzielte durch die Chain of Thinking (CoT) Reasoning-Technologie eine Verbesserung um 3,7 Prozentpunkte und demonstrierte ein starkes Skalierbarkeitspotenzial für die Testzeit. Das Modell wird auf der Grundlage von InternVL2.0 weiterentwickelt, wodurch die Leistung durch verbesserte Trainings- und Teststrategien und eine Verbesserung der Datenqualität weiter verbessert wird. Es werden eingehende Untersuchungen zu visuellen Encodern, Sprachmodellen, Datensatzgrößen und Testzeitkonfigurationen durchgeführt, um die Beziehung zwischen Modellgröße und Leistung zu untersuchen.

InternVL2.5 zeigt wettbewerbsfähige Leistung in mehreren Benchmarks, insbesondere in den Bereichen multidisziplinäres Denken, Dokumentenverständnis, Verständnis mehrerer Bilder/Videos, Verständnis der realen Welt, multimodale Halluzinationserkennung, visuelle Erdung, mehrsprachige Fähigkeiten und reine Sprachverarbeitung und anderen Bereichen. Diese Errungenschaft stellt nicht nur einen neuen Standard für die Entwicklung und Anwendung multimodaler KI-Systeme für die Open-Source-Community dar, sondern eröffnet auch neue Möglichkeiten für Forschung und Anwendungen im Bereich der künstlichen Intelligenz.

InternVL2.5 behält die gleiche Modellarchitektur seiner Vorgänger InternVL1.5 und InternVL2.0 bei, folgt dem „ViT-MLP-LLM“-Paradigma und implementiert die Integration des neuen inkrementellen vorab trainierten InternViT-6B oder InternViT-300M mit verschiedenen Vorab trainierte LLMs unterschiedlicher Größe und Art werden mithilfe zufällig initialisierter zweischichtiger MLP-Projektoren miteinander integriert. Um die Skalierbarkeit der hochauflösenden Verarbeitung zu verbessern, wandte das Forschungsteam eine Pixel-Shuffle-Operation an, um die Anzahl der visuellen Token auf die Hälfte der ursprünglichen Anzahl zu reduzieren.

Der Open-Source-Charakter des Modells bedeutet, dass Forscher und Entwickler frei auf InternVL2.5 zugreifen und es nutzen können, was die Entwicklung und Innovation der multimodalen KI-Technologie erheblich fördern wird.

Modelllink:

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

Die Open-Source-Veröffentlichung von InternVL2.5 stellt wertvolle Ressourcen für die multimodale KI-Forschung bereit. Es wird erwartet, dass ihre hervorragende Leistung und Skalierbarkeit weitere Durchbrüche in diesem Bereich und die Entstehung innovativerer Anwendungen fördern werden. Ich freue mich darauf, in Zukunft weitere überraschende Ergebnisse auf Basis von InternVL2.5 zu sehen.